Предоставляет 3 основных функция:

git clone https://github.com/microsoft/DeepSpeed.git

cd deepspeed

rm -rf build

TORCH_CUDA_ARCH_LIST= " 7.0 " DS_BUILD_OPS=1 pip install -e . --global-option= " build_ext " --global-option= " -j8 " --no-cache -v --disable-pip-version-check 2>&1 | tee build.log Если вы хотите создать двоичное колесо, которое удобно для установки на других машинах, вы можете использовать следующую команду, которая будет генерировать аналогичный установлен файл deepspeed-0.3.13+8cd046f-cp38-cp38-linux_x86_64.whl в dist каталоге.

git clone https://github.com/microsoft/DeepSpeed.git

cd deepspeed

rm -rf build

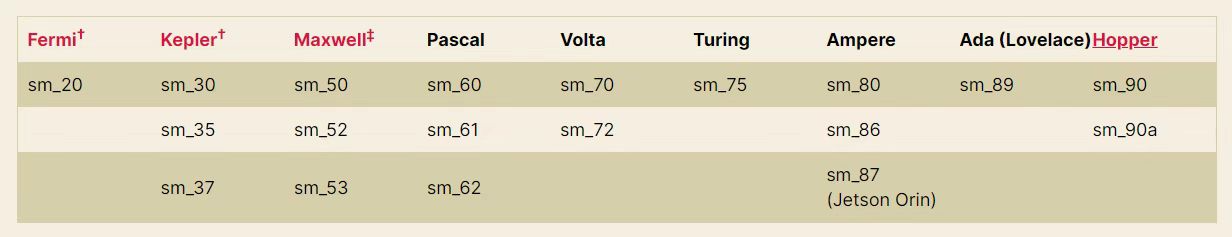

TORCH_CUDA_ARCH_LIST= " 7.0 " DS_BUILD_OPS=1 python setup.py build_ext -j8 bdist_wheel 2>&1 | tee build.log PS : Согласно рисунку ниже, TORCH_CUDA_ARCH_LIST="7.0" необходимо скорректировать на соответствующую архитектуру GPU NVIDIA.

Или запустить torch.cuda.get_device_capability() чтобы получить собственную архитектуру GPU

При использовании модели класса Pangy ее формат Special_token составляет <sep> , <pad> и т. Д., А функция tokenize() в tokenization_gptpangu.py будет использовать jieba для сегментации слов. Но непосредственно pip install jieba будет напрямую отделять < и > по умолчанию. Использование jieba.add_word("<sep>") не имеет никакого эффекта, потому что jieba непосредственно жесткие токены хард -кодов, которые будут автоматически разделены, включая < и > .

Следовательно, необходимо выполнить:

git clone https://github.com/fxsjy/jieba.git

cd jieba Клонайте код локально и измените значение re_han_default в jieba/__init__.py Конкретные изменения следующие:

re_han_default = re . compile ( "([ u4E00 - u9FD5 a-zA-Z0-9+#&._%-]+)" , re . U ) re_han_default = re . compile ( "([ u4E00 - u9FD5 a-zA-Z0-9+#&._%-<>]+)" , re . U ) После завершения модификации используйте pip install . для локального компиляции и установки, и замените оригинальную jieba . После завершения установки добавьте jieba.add_word("<sep>") в код (код был добавлен tokenization_gptpangu.py), чтобы решить проблему разделения специальных токенов <sep> на несколько идентификаторов.

git clone https://github.com/NVIDIA/apex

cd apex

pip install --global-option= " --cpp_ext " --global-option= " --cuda_ext " --no-cache -v --disable-pip-version-check . 2>&1 | tee build.log Если вы хотите создать двоичное колесо, которое удобно для установки на других машинах, вы можете использовать следующую команду, которая будет генерировать аналогичную установленную файл apex-0.0.1+7150e20-cp38-cp38-linux_x86_64.whl в dist каталоге.

git clone https://github.com/NVIDIA/apex

cd apex

python setup.py --cpp_ext --cuda_ext bdist_wheel 2>&1 | tee build.log| Модель | размер | Адрес объятия | Адрес сетевого диска Baidu | Извлечь код |

|---|---|---|---|---|

| Пангу-350м | 659 МБ | Sunzeyeah/Pangu-350M | Пангу-350м | C5JJ |

| Пангу-2,6b | 9,8 ГБ | sunzeyeah/pangu-2_6b | Пангу-2,6b | 2rad |

| Pangu-13b | 23,6 ГБ | Sunzeyeah/Pangu-13b | Pangu-13b | U3DX |

| GLM-350M-Chinese | 679 МБ | Sunzeyeah/GLM-350M-Chinese | GLM-350M-Chinese | II8E |

| GLM-10B-Chinese | 18.4g | Sunzeyeah/GLM-10B-Chinese | GLM-10B-Chinese | Fynj |

| Чатглм-6B | 25,6 г | Sunzeyeah/Chatglm-6b | Чатглм-6B | UQ1K |

PS : предварительно обученная модель, предоставленная этим репо, загружается.

| Набор данных | размер | Адрес объятия | Адрес сетевого диска Baidu | Извлечь код |

|---|---|---|---|---|

| Подсказка | 500 МБ | Подсказка | M6GT | |

| Данные SFT и вознаграждение | 5 ГБ | sunzeyeah/cilina_chatgpt_corpus | Данные SFT и вознаграждение | ecyc |

| Энциклопедия | 652 МБ | baike_qa_2019 | 7Jad | |

| Знать вопросы и ответы | 847 МБ | Жидао | Недс | |

| куплет | 221 МБ | куплеты | 54ey | |

| Древний текст | 125 МБ | Классический и современный | A4CR | |

| Древняя поэзия | 87 МБ | Китайская поэзия | 5 | |

| Комментарии новостей Weibo | 522 МБ | Вейбо Сводные комментарии | W0G1 |

PS : данные SFT & Reward основаны на энциклопедии, ноу-хау, куплетах, древних текстах, древних стихах и данных о комментариях Weibo, и могут быть непосредственно использованы для обучения SFT и наград. См. Data_prepare.py для получения подробной информации

Впредно предварительно обучен для LLM с открытым исходным кодом, на основе реализации DeepSpeed. В настоящее время поддерживает 2-х класса модельные архитектуры:

cd examples

bash pretrain.shОтзывы о открытых коленях китайских LLM для ZeroShot, OneShot или MareShot. См. Eval_pretrain.py и Data.py для получения подробной информации.

В настоящее время поддерживаемые задачи оценки:

В настоящее время поддерживаются модели с открытым исходным кодом:

cd examples

bash eval_pretrain.shОбучение SFT с использованием данных с открытым исходным кодом + SFT & вознаграждения

cd examples

bash train_sft.shОбучение модели вознаграждения с использованием данных SFT + SFT & вознаграждения

cd examples

bash train_reward.shИспользуя алгоритм PPO и модель вознаграждения, модель SFT дополнительно обновлена. Реализовано на основе фреймворта с открытым исходным кодом DeepSpeedChat

cd examples

bash train_rlhf.shИспользуя алгоритм DPO для замены трубопровода вознаграждения+RLHF, исключая обучение моделей вознаграждения и достижение влияния обучения RL, этот метод может значительно снизить использование памяти. Реализовано на основе Framework с открытым исходным кодом TRL

cd examples

bash train_dpo.sh| Модель | Ав | Avg (жесткий) | КОРЕНЬ | Социальная наука | Гуманитарные науки | Другой |

| Baichuan2-13b-Chat | 56.30 | 34.20 | 48.20 | 70.00 | 60.50 | 54,20 |

| xverse-13b | 55,30 | 32,50 | 45,90 | 66.70 | 59,50 | 57.60 |

| Qwen-7b-чат | 54,70 | 35,40 | 47,90 | 68.30 | 58,70 | 50.00 |

| Baichuan-13b-баз | 53,70 | 35,60 | 46.80 | 65,80 | 58.00 | 50,80 |

| Baichuan2-7b-чат | 52,50 | 33,80 | 45,70 | 64,20 | 56.60 | 50.20 |

| Chatglm2-6b | 51.20 | 33,40 | 46.90 | 63,00 | 51.60 | 47.70 |

| Baichuan-13b-чат | 47,90 | 31.50 | 41.40 | 56.80 | 53,00 | 46.50 |

| Baichuan-7b | 44,20 | 31.70 | 39,20 | 53,30 | 47.30 | 41.90 |

| Ziya-Llama-13b-V1.1 | 40.10 | 30.30 | 35,80 | 47.30 | 42,80 | 38.50 |

| Chatglm1.1-6b | 38.10 | 28.60 | 33,60 | 46.70 | 40,90 | 35,70 |

| AtomGPT-13B-56K | 37.60 | 25.30 | 32.00 | 44,70 | 42,80 | 36.10 |

| Llama2-13b-чат | 37.10 | 29.30 | 34,60 | 43,60 | 35,90 | 37.00 |

| Чатглм-6B | 36.30 | 27.20 | 32,90 | 42,80 | 38.10 | 34,90 |

| Лама-30б | 35,90 | 29,90 | 34,40 | 42,40 | 33,30 | 35,60 |

| Llama2-7B-Chat | 33,50 | 27.30 | 31.60 | 38.10 | 33,80 | 32,70 |

| Ziya-Llama-13b-Pretrain-V1 | 31.10 | 22.20 | 27.40 | 36.50 | 33,80 | 30.40 |

| Лама-13b | 29,8 | 24.20 | 28.40 | 33,70 | 29,60 | 29.00 |

| Лама-7B | 26.80 | 26.70 | 26.20 | 27,60 | 25,70 | 28.10 |

| Модель | Ав | КОРЕНЬ | Социальная наука | Гуманитарные науки | Другой |

| Baichuan2-13b-Chat | 56.90 | 47.28 | 66.23 | 52,90 | 63,50 |

| Лама-30б | 56.33 | 44,68 | 65,64 | 54,60 | 61.57 |

| xverse-13b | 55,24 | 45,60 | 64,51 | 50.32 | 63,27 |

| Qwen-7b-чат | 54.13 | 41.76 | 63,43 | 50,81 | 62,50 |

| Llama2-13b-чат | 53,98 | 44,52 | 63,40 | 49,37 | 61.21 |

| Baichuan-13b-баз | 53,46 | 43,86 | 63.14 | 49,73 | 59,28 |

| Baichuan2-7b-чат | 53,11 | 43,51 | 62,26 | 49,58 | 59,12 |

| Baichuan-13b-чат | 51.12 | 41.61 | 59.11 | 47.52 | 58.31 |

| Ziya-Llama-13b-V1.1 | 51.06 | 41.89 | 57.71 | 49,22 | 56.54 |

| Llama2-7B-Chat | 48.10 | 39,64 | 56.28 | 43,61 | 55,39 |

| Лама-13b | 46.51 | 37.23 | 52,71 | 44,35 | 53,04 |

| Chatglm2-6b | 45,83 | 38,75 | 52,06 | 43,20 | 50,82 |

| AtomGPT-13B-56K | 42,75 | 36.02 | 49,04 | 38,80 | 49,30 |

| Baichuan-7b | 41.96 | 36.63 | 47.77 | 37.55 | 48.31 |

| Ziya-Llama-13b-Pretrain-V1 | 41.61 | 33,61 | 46.01 | 39,85 | 48.05 |

| Chatglm1.1-6b | 40.07 | 32,95 | 44,55 | 39,23 | 44.12 |

| Чатглм-6B | 37.87 | 32,41 | 43,80 | 35,60 | 41.00 |

| Лама-7B | 28.53 | 26.10 | 28.76 | 28.52 | 24.81 |

| Набор данных | Метод | Метрики | Тип задачи | Нулевой выстрел | Несколько выстрелов | ||||||||

| GLM-350M-Chinese | Пангу-350м | Пангу-2,6b | GLM-10B-Chinese | Pangu-13b | GLM-350M-Chinese | Пангу-350м | Пангу-2,6b | GLM-10B-Chinese | Pangu-13b | ||||

| Ocnli | Ппл | акк | Нли | 0,3074 | 0,3369 | 0,3061 | 0,3288 | 0,3301 | 0,3298 | 0,3352 | 0,3216 | ||

| Cmnli | Ппл | акк | Нли | 0,3279 | 0,3302 | 0,3310 | 0,3338 | 0,3358 | 0,3356 | 0,3328 | 0,3300 | ||

| Чид | Ппл | акк | Cloze (мульти-выбор) | 0,0734 | 0,0916 | 0,0670 | 0,1016 | 0,1018 | 0,0979 | 0,1007 | 0,0996 | ||

| CMRC2018 | Поколение | F1 | МРК | 0,093 | 0,0979 | 0,1007 | 0,1392 | 0,021 | 0,09345 | 0,097 | 0,1007 | ||

| ClueWSC2020 | Ппл | акк | WSC | 0,4934 | 0,5328 | 0,5592 | 0,5131 | 0,4671 | 0,5526 | 0,4473 | 0,4671 | ||

| C3 | Ппл | акк | Здравый смысл рассуждения | 0,2360 | 0,2426 | 0,2418 | 0,2573 | 0,2567 | 0,2476 | 0,2559 | 0,2515 | ||

| AFQMC | Ппл | акк | Текстовая классификация | 0,6306 | 0,4582 | 0,4914 | 0,4960 | 0,5000 | 0,4872 | 0,4993 | 0,5018 | ||

| CSL | Ппл | акк | Текстовая классификация | 0,4943 | 0,4913 | 0,4666 | 0,5126 | 0,4996 | 0,5140 | 0,5036 | 0,4973 | ||

| Iflytek | Ппл | акк | Текстовая классификация | 0,1292 | 0,3058 | 0,265 | 0,2620 | 0,2408 | 0,2539 | 0,2535 | 0,2524 | ||

| Tnews | Ппл | акк | Текстовая классификация | 0,1582 | 0,2022 | 0,2449 | 0,2489 | 0,2527 | 0,2555 | 0,2466 | 0,2494 | ||

Параметры обучения модели:

| Модель | Параметр обучения количество | Объем данных | Размер партии | Длина последовательности | аппаратное обеспечение | Использование видео памяти | скорость | Часы за эпоху |

|---|---|---|---|---|---|---|---|---|

| GLM-350M-Chinese | 355M | 5,4 м | 4 | 512 | V100 16G | 13G | 3,7 с/итера | 88H |

| Пангу-350м | 345 м | 5,4 м | 48 | 512 | A100 80G | 78 г | 1,91 с/итер | 27,5H |

| Пангу-2,6b | 2.6b | 5,4 м | 8 | 512 | A100 80G | 79,4 г | 9,61 с/итер | 116H |

Скачать модель SFT:

| Предварительно обученная модель | Набор данных SFT | размер | Адрес объятия | Адрес сетевого диска Baidu | Извлечь код |

|---|---|---|---|---|---|

| Пангу-350м | Данные SFT и вознаграждение | 1,3 ГБ | Sunzeyeah/Pangu-350M-Sft | Pangu-350M-SFT | 0f8j |

| Пангу-2,6b | Данные SFT и вознаграждение | 9,8 ГБ | sunzeyeah/pangu-2_6b-sft | Pangu-2.6b-sft | R13W |

# 生成参数

max_length = 512

max_length_generation = 100

top_k = 10

temperature = 0.8

do_sample=True

[Input] 我不能确定对方是不是喜欢我,我却想分分秒秒跟他在一起,有谁能告诉我如何能想他少一点<sep>回答:

[Generated] 你爱他就多关心他,少在他面前表现出你的脆弱。这样他才更会爱你。

[Input] 一次次买彩,一次次倾听那比分,一次次兴奋,一次次失落,一次次无归而返!最终还是任8~~~~<sep>回答:

[Generated] 我也是这样,买彩的时间也不长,但是每次都是这样。。。。。。。

[Input] 现代文:太祖很高兴地说:凭着这样的部下去作战,还担心不能取胜么?<sep>古文:

[Generated] 太祖悦曰:此自是以去,何忧不胜?

[Input] 现代文:十一年秋,丞相伯颜与阿术会师襄阳,遣阿剌罕率诸翼军攻郢、复诸州,十月夺取郢州之南门堡。<sep>古文:

[Generated] 十一年秋,丞相伯颜与阿术会师襄阳,遣阿剌罕率诸翼军攻郢、复诸州,十月夺郢州之南门堡。

[Input] 以孔⁇的风格,写一篇经书,题为中庸<sep>

[Generated] 我闻昔者夫子之言也,曰:吾道一以贯之。其或行之或不行,吾未知之。是故君子慎其独也。吾未见好德如好色者也。好德如好色者,未之有也。好德如好色者,既已之有也。君子不以言举人,不以人废言。好德如好色者,其如命何!吾

[Input] 以陆游的风格,写一首七言诗,题为晨起<sep>

[Generated] 秋光满纸清⁇明,睡醒一江万马奔。自笑身如枯木鹤,何妨食饱作闲人。

[Input] 上联:霜风几笔雕残画<sep>下联:

[Generated] 云海千山叠翠峰

[Input] 新闻内容:据悉,这名14岁的女生在Facebook上发布了戏谑考试的博文,其中使用了胡志明1946年反对法国殖民者的讲话,随后被越南当局停课一年。越南官员称,该学生歪曲了历史事件,侮辱了老师的情感。多数网友虽对越南当局做法不满,但都表示,至少他们还能上Facebook.<sep>摘要:越南女生Facebook上模仿胡志明讲话被停课<sep>评论:

[Generated] 这女的,还真有勇气,我喜欢你!

[Input] 新闻内容:习近平天津考察时勉励大学生志存高远、脚踏实地,转变择业观念,坚持从实际出发,勇于到基层一线和艰苦地方去,把人生的路一步步走稳走实,善于在平凡岗位上创造不平凡的业绩<sep>摘要:习近平勉励大学生转变择业观念勇于到基层和艰苦地方去<sep>评论:

[Generated] 现在的社会,很多年轻人都是在父母的安排下,去了不同的单位,在不同的地方工作,在不同的城市生活,这就导致了年轻人的思维方式,价值观都不一样,这也导致了年轻人的成长道路,也有很多的不安全感,这也是很正常的事情,年轻人需要正确的引导,正确的引导,也需要正确的引导!

[Input] 问题:劳动仲裁申请法院强制执行,法院强制执行需要多长时间<sep>回答:

[Generated] 一般申请法院强制执行需要3-6个月时间,具体需要看法院的执行措施。

[Input] 问题:银行贷款50万,30年!年利率是4.41怎么算一个月还多少钱<sep>回答:

[Generated] 若申请的是招行贷款,要计算贷款利息或者每月还款金额,需要知道贷款本金,贷款期限,还款方式,贷款年利率。若上述信息都确认到,可以通过我行贷款计算器尝试计算,登录招行官网右下方找到“理财计算器”--“个人贷款计算器”可以计算。

Параметры обучения модели:

| Модель | Параметр обучения количество | Объем данных | Размер партии | Длина последовательности | аппаратное обеспечение | Использование видео памяти | скорость | Часы за эпоху |

|---|---|---|---|---|---|---|---|---|

| Пангу-350м | 131m | 12 м | 32 | 512 | A100 80G | 72,6 г | 1,91 с/итер | 105H |

| Пангу-2,6b | 815M | 12 м | 8 | 512 | A100 80G | 80,7 г | 423H |

Загрузка модели вознаграждения:

| Предварительно обученная модель | Набор данных SFT | размер | Адрес объятия | Адрес сетевого диска Baidu | Извлечь код |

|---|---|---|---|---|---|

| Пангу-350м | Данные SFT и вознаграждение | 1,3 ГБ | Sunzeyeah/Pangu-350M-Reward | Pangu-350M-Reward | 4GJU |

Быть обновленным

Чтобы проверить, может ли эффективность обучения использования DeepSpeed в различных предварительно обученных моделях достичь официально заявленных эффектов (ускорение, сохранение графических процессоров и т. Д.)

max_sequence_length=512| Модель | данные | Общая трудоемкая/эпоха | Много времени для одного образца | Использование памяти | Использование видео памяти | Модель и количество графического процессора | FP16 | BF16 | Стадия Deepspeed | Оптимизатор разгрузки | Пятниковая память | разгрузить парамет | Перекрывать коммун | Аллггейтер Бакет Размер | Stage3 Max Live Параметры | Размер партии | Градиентные шаги накопления | Градиент контрольно -пропускной пункт | модель половина |

| T5-Large | WMT16-en-ro, в общей сложности 610 000 образцов | 43H | 0,5 с/это | 7,1 г | 1*14529 МБ | 1*V100 16G | истинный | - | - | - | - | - | - | - | - | 2 | 8 | ЛОЖЬ | ЛОЖЬ |

| 152H | 1,78 с/это | 38.26G | 1*11663MB | 1*V100 16G | истинный | - | 2 | истинный | истинный | - | ЛОЖЬ | 2E8 | - | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| 250h | 2,95 с/это | 38.74G | 1*7255MB | 1*V100 16G | истинный | - | 2 | истинный | истинный | - | ЛОЖЬ | 1e5 | - | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| 62 часа | 5,8 с/это | 86.81g | 8*7811MB | 8*V100 16G | истинный | - | 2 | истинный | истинный | - | ЛОЖЬ | 1e5 | - | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| - | - | - | Непрерывно | 1*V100 16G | истинный | - | 2 | истинный | истинный | - | ЛОЖЬ | 2E8 | - | 16 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| - | - | - | Непрерывно | 1*V100 16G | истинный | - | 2 | истинный | истинный | - | ЛОЖЬ | 1e5 | - | 16 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| 290h | 3.48 с/это | 46.53g | 1*6655MB | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 2E8 | 2E8 | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| 380h | 4,5 с/это | 43,48 г | 1*5263MB | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e5 | 1e5 | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| 215H | 4,9 с/это | 47.31g | 2*5019 МБ | 2*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e5 | 1e5 | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| 1370h | 64S/это | 57.55G | 4*4701MB | 4*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e5 | 1e5 | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| 948H | 90 -е/это | 72,54 г | 8*4585MB | 8*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e5 | 1e5 | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| Пангу-2,6b | Набор проверки данных SFT & Reward Data, в общей сложности 10 000 образцов | 2H | 5,76 с/это | 67.86g | 1*15631 МБ | 1*V100 16G | истинный | - | 2 | истинный | истинный | - | ЛОЖЬ | 2E8 | - | 2 | 8 | ЛОЖЬ | ЛОЖЬ |

| 2.1H | 6,15 с/это | 67.88g | 1*15705MB | 1*V100 16G | истинный | - | 2 | истинный | истинный | - | ЛОЖЬ | 1e5 | - | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| 4,5H | 13.3s/it | 81.02g | 1*15449MB | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 2E8 | 2E8 | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| 11,5H | 8.2S/это | 75,89 г | 1*15299 МБ | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e5 | 1e5 | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| 5,5 ч | 7,8 с/это | 81.16G | 2*14851MB | 2*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e5 | 1e5 | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| 6,2H | 18,3 с/это | 97.31g | 4*14389MB | 4*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e5 | 1e5 | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| 6,6 ч | 38 с/это | 118.82G | 8*14335MB | 8*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e5 | 1e5 | 2 | 8 | ЛОЖЬ | ЛОЖЬ | ||

| Чатглм-6B | Набор проверки данных SFT & Reward Data, в общей сложности 10 000 образцов | - | - | 120.45G | Непрерывно | 1*V100 16G | истинный | - | 2 | истинный | истинный | - | ЛОЖЬ | 1e5 | - | 1 | 8 | истинный | истинный |

| - | - | 120.48G | Непрерывно | 1*V100 16G | истинный | - | 2 | истинный | истинный | - | ЛОЖЬ | 1e3 | - | 1 | 8 | ЛОЖЬ | истинный | ||

| - | - | 153,02G | Непрерывно | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e2 | 1e2 | 1 | 8 | ЛОЖЬ | истинный | ||

| - | - | 154G | Непрерывно | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 2E8 | 2E8 | 1 | 8 | истинный | истинный | ||

| 21.2H | 60S/это | 154G | 1*10443MB | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 2E8 | авто | 1 | 8 | истинный | истинный | ||

| 21,5H | 60S/это | 152,81G | 1*10409MB | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e5 | 1e5 | 1 | 8 | истинный | истинный | ||

| 23.5H | 65 с/это | 153,36 г | 1*9229MB | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e3 | 1e3 | 1 | 8 | истинный | истинный | ||

| 14 часов | 80 -е/это | 158.21G | 2*8631MB | 2*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e3 | 1e3 | 1 | 8 | истинный | истинный | ||

| 7,8 ч | 90 -е/это | 168.38G | 4*6743MB | 4*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e3 | 1e3 | 1 | 8 | истинный | истинный | ||

| 4 часа | 90 -е/это | 189.34G | 8*6729 МБ | 8*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e3 | 1e3 | 1 | 8 | истинный | истинный | ||

| 1H | 100 -е годы/это | 189.38G | 8*10047MB | 8*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e3 | 1e3 | 4 | 8 | истинный | истинный | ||

| 50 минут | 40 -е/это | 189,39 г | 8*14763MB | 8*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e3 | 1e3 | 8 | 2 | истинный | истинный | ||

| 35 минут | 113s/it | 189,39 г | 8*14763MB | 8*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e3 | 1e3 | 8 | 8 | истинный | истинный | ||

| - | - | 189.34G | Непрерывно | 8*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e3 | 1e3 | 10 | 8 | истинный | истинный | ||

| GLM-10B-Chinese | Набор проверки данных SFT & Reward Data, в общей сложности 10 000 образцов | - | - | - | Непрерывно | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 2E8 | 2E8 | 1 | 8 | истинный | ЛОЖЬ |

| - | - | - | Непрерывно | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 2E8 | авто | 1 | 8 | истинный | ЛОЖЬ | ||

| - | - | - | Непрерывно | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e5 | 1e5 | 1 | 8 | истинный | ЛОЖЬ | ||

| - | - | - | Непрерывно | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e3 | 1e3 | 1 | 8 | истинный | ЛОЖЬ | ||

| - | - | - | Непрерывно | 1*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e2 | 1e2 | 1 | 8 | истинный | ЛОЖЬ | ||

| - | - | - | Непрерывно | 2*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e2 | 1e2 | 1 | 8 | истинный | ЛОЖЬ | ||

| - | - | - | Непрерывно | 4*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e2 | 1e2 | 1 | 8 | истинный | ЛОЖЬ | ||

| - | - | Непрерывно | - | 8*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e2 | 1e2 | 1 | 8 | истинный | ЛОЖЬ | ||

| - | - | - | Непрерывно | 4*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e2 | 1e2 | 1 | 8 | истинный | истинный | ||

| - | - | - | Непрерывно | 6*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e2 | 1e2 | 1 | 8 | истинный | истинный | ||

| - | - | Непрерывно | - | 8*V100 16G | истинный | - | 3 | истинный | истинный | истинный | ЛОЖЬ | 1e2 | 1e2 | 1 | 8 | истинный | истинный |

PS : конфигурация DeepSpeed для параметров и настройки.

Чтобы проверить повышение эффективности обучения Лоры, был проведен бенгар

max_sequence_length=512, lora_alpha=1, lora_train_bias='none'| Модель | Лора звание | Параметр обучения количество | глубокая скорость | Размер партии | Модель и количество графического процессора | Использование видео памяти | Много времени для одного образца | Общая трудоемкая/эпоха |

| Пангу-2,6b | - | 2.6b | - | 8 | 1*A100 80G | 1*79421MB | 9.66s/it | 12,5 мин |

| 1000 | 1,5B | - | 8 | 1*A100 80G | 1*76129MB | 11.61s/it | 15 минут | |

| 500 | 758 МБ | - | 12 | 1*A100 80G | 1*77179MB | 16.2s/it | 14 мин | |

| 100 | 151 МБ | - | 16 | 1*A100 80G | 1*81103MB | 18.6s/it | 12 минут | |

| 50 | 75 МБ | - | 16 | 1*A100 80G | 1*80809MB | 17,8 с/это | 11,5 мин | |

| 10 | 15 МБ | - | 16 | 1*A100 80G | 1*78735MB | 17.6s/it | 11,5 мин | |

| 100 | 151 МБ | Стадия = 2, W разгрузка | двадцать четыре | 1*A100 80G | 1*76933MB | 25,5 с/это | 11 минут | |

| 100 | 151 МБ | Стадия = 3, W разгрузка | двадцать четыре | 1*A100 80G | 1*77259MB | 46,5 с/это | 20 минут | |

| Чатглм-6B | - | 6.2b | - | 3 | 1*A100 80G | 1*79206MB | 6,7 с/это | 23,5 мин |

| 1000 | 1,9B | - | 6 | 1*A100 80G | 1*78840MB | 12,8 с/это | 22,5 мин | |

| 500 | 994MB | - | 6 | 1*A100 80G | 1*68832MB | 12.4s/it | 21,5 мин |