Fournit 3 fonctions majeures:

git clone https://github.com/microsoft/DeepSpeed.git

cd deepspeed

rm -rf build

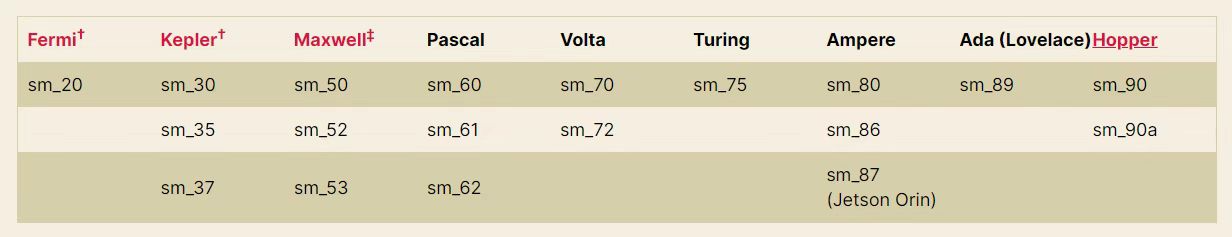

TORCH_CUDA_ARCH_LIST= " 7.0 " DS_BUILD_OPS=1 pip install -e . --global-option= " build_ext " --global-option= " -j8 " --no-cache -v --disable-pip-version-check 2>&1 | tee build.log Si vous souhaitez créer une roue binaire qui est pratique pour l'installation sur d'autres machines, vous pouvez utiliser la commande suivante, qui générera un fichier instalable similaire deepspeed-0.3.13+8cd046f-cp38-cp38-linux_x86_64.whl dans dist .

git clone https://github.com/microsoft/DeepSpeed.git

cd deepspeed

rm -rf build

TORCH_CUDA_ARCH_LIST= " 7.0 " DS_BUILD_OPS=1 python setup.py build_ext -j8 bdist_wheel 2>&1 | tee build.log PS : Selon la figure ci-dessous, TORCH_CUDA_ARCH_LIST="7.0" doit être ajusté à son architecture NVIDIA GPU correspondante.

Ou exécutez torch.cuda.get_device_capability() pour obtenir votre propre architecture GPU

Lorsque vous utilisez le modèle de classe Pangu, son format spécial_token est <sep> , <pad> , etc., et la fonction tokenize() dans tokenisation_gptpangu.py utilisera jieba pour la segmentation des mots. Mais directement, l'installation > pip install jieba séparera directement < par défaut. L'utilisation jieba.add_word("<sep>") n'a aucun effet, car les jetons jieba en hard codent directement qui se diviseront automatiquement, y compris < >

Par conséquent, il est nécessaire d'exécuter:

git clone https://github.com/fxsjy/jieba.git

cd jieba Clonatez le code localement et modifiez la valeur de re_han_default dans jieba/__init__.py Les changements spécifiques sont les suivants:

re_han_default = re . compile ( "([ u4E00 - u9FD5 a-zA-Z0-9+#&._%-]+)" , re . U ) re_han_default = re . compile ( "([ u4E00 - u9FD5 a-zA-Z0-9+#&._%-<>]+)" , re . U ) Une fois la modification terminée, utilisez pip install . Pour la compilation et l'installation locales, et remplacez le jieba d'origine. Une fois l'installation terminée, ajoutez jieba.add_word("<sep>") au code (le code a été ajouté Tokenisation_gptpangu.py) pour résoudre le problème de la division de jetons spéciaux de <sep> en ID multiples.

git clone https://github.com/NVIDIA/apex

cd apex

pip install --global-option= " --cpp_ext " --global-option= " --cuda_ext " --no-cache -v --disable-pip-version-check . 2>&1 | tee build.log Si vous souhaitez créer une roue binaire pratique pour l'installation sur d'autres machines, vous pouvez utiliser la commande suivante, qui générera un fichier instalable similaire apex-0.0.1+7150e20-cp38-cp38-linux_x86_64.whl dans dist .

git clone https://github.com/NVIDIA/apex

cd apex

python setup.py --cpp_ext --cuda_ext bdist_wheel 2>&1 | tee build.log| Modèle | taille | Adresse de câlins | Adresse du disque du réseau Baidu | Extraire du code |

|---|---|---|---|---|

| Pangu-350m | 659 Mo | Sunzeyeah / Pangu-350m | Pangu-350m | C5JJ |

| Pangu-2.6b | 9,8 Go | sunzeyeah / pangu-2_6b | Pangu-2.6b | 2rad |

| Pangu-13b | 23,6 Go | Sunzeyeah / Pangu-13b | Pangu-13b | u3dx |

| GLM-350M-Chinois | 679 Mo | Sunzeyeah / GLM-350M-Chinese | GLM-350M-Chinois | ii8e |

| GLM-10B-Chinois | 18,4g | Sunzeyeah / GLM-10b-chinois | GLM-10B-Chinois | fynj |

| Chatglm-6b | 25,6g | sunzeyeah / chatglm-6b | Chatglm-6b | uq1k |

PS : Le modèle pré-formé fourni par ce repo est le téléchargement.

| Ensemble de données | taille | Adresse de câlins | Adresse du disque du réseau Baidu | Extraire du code |

|---|---|---|---|---|

| Indice de référence | 500 Mo | Indice de référence | m6gt | |

| Données SFT et récompenses | 5 Go | sunzeyeah / chinois_chatgpt_corpus | Données SFT et récompenses | écyc |

| Encyclopédie | 652 Mo | baike_qa_2019 | 7jad | |

| Connaissez les questions et réponses | 847 Mo | zhidao | ned | |

| distique | 221 Mo | bacles | 54ey | |

| Texte ancien | 125 Mo | Classique et moderne | a4cr | |

| Poésie ancienne | 87 Mo | poésie chinoise | 5ZZJ | |

| Commentaires de Weibo News | 522 Mo | Commentaires de résumé de Weibo | W0G1 |

PS : Les données SFT & REWARD sont basées sur l'encyclopédie, le savoir-faire, les couplets, les textes anciens, les poèmes anciens et les données de commentaires de Weibo News, et peuvent être directement utilisés pour la formation en scène SFT et récompense. Voir data_prepare.py pour plus de détails

Pré-formation progressivement pour Open Source LLM, basée sur la mise en œuvre de profondeurs. Prend en charge les architectures de modèle à 2 classes:

cd examples

bash pretrain.shRevues des LLM chinoises open source pour le zéroshot, l'oneshot ou quelques-uns. Voir ev_pretrain.py et data.py pour plus de détails.

Tâches d'évaluation actuellement prises en charge:

Modèles open source actuellement pris en charge:

cd examples

bash eval_pretrain.shFormation SFT à l'aide de données Open Source LLM + SFT & REWARD

cd examples

bash train_sft.shFormation du modèle de récompense à l'aide des données SFT Model + SFT & REWARD

cd examples

bash train_reward.shEn utilisant l'algorithme PPO et le modèle de récompense, le modèle SFT est encore mis à jour. Implémenté en fonction du cadre open source DeeppeedChat

cd examples

bash train_rlhf.shEn utilisant l'algorithme DPO pour remplacer le pipeline de récompense + RLHF, en éliminant la formation des modèles de récompense et en réalisant l'effet de la formation RL, cette méthode peut réduire considérablement l'utilisation de la mémoire. Implémenté en fonction de l'open source framework trl

cd examples

bash train_dpo.sh| Modèle | AVG | AVG (dur) | TIGE | Sciences sociales | Sciences humaines | Autre |

| Baichuan2-13b-chat | 56.30 | 34.20 | 48.20 | 70,00 | 60,50 | 54.20 |

| xverse-13b | 55.30 | 32.50 | 45,90 | 66.70 | 59.50 | 57,60 |

| QWEN-7B | 54.70 | 35.40 | 47,90 | 68.30 | 58,70 | 50h00 |

| Baichuan-13b-base | 53,70 | 35.60 | 46.80 | 65.80 | 58.00 | 50.80 |

| Baichuan2-7b-chat | 52.50 | 33.80 | 45,70 | 64.20 | 56,60 | 50.20 |

| Chatglm2-6b | 51.20 | 33.40 | 46.90 | 63,00 | 51,60 | 47.70 |

| Baichuan-13b-chat | 47,90 | 31.50 | 41.40 | 56.80 | 53,00 | 46.50 |

| Baichuan-7b | 44.20 | 31.70 | 39.20 | 53.30 | 47h30 | 41.90 |

| Ziya-lelama-13b-v1.1 | 40.10 | 30h30 | 35.80 | 47h30 | 42.80 | 38.50 |

| Chatglm1.1-6b | 38.10 | 28.60 | 33.60 | 46.70 | 40.90 | 35,70 |

| Atomgpt-13b-56k | 37,60 | 25h30 | 32.00 | 44.70 | 42.80 | 36.10 |

| LLAMA2-13B-CHAT | 37.10 | 29.30 | 34.60 | 43.60 | 35,90 | 37.00 |

| Chatglm-6b | 36.30 | 27.20 | 32.90 | 42.80 | 38.10 | 34.90 |

| Lama-30b | 35,90 | 29.90 | 34.40 | 42.40 | 33.30 | 35.60 |

| LLAMA2-7B-CHAT | 33.50 | 27h30 | 31.60 | 38.10 | 33.80 | 32,70 |

| Ziya-lelama-13b-prétraigne-v1 | 31.10 | 22.20 | 27.40 | 36.50 | 33.80 | 30.40 |

| Lama-13b | 29.8 | 24.20 | 28.40 | 33,70 | 29.60 | 29.00 |

| Lama-7b | 26.80 | 26.70 | 26.20 | 27.60 | 25.70 | 28.10 |

| Modèle | AVG | TIGE | Sciences sociales | Sciences humaines | Autre |

| Baichuan2-13b-chat | 56.90 | 47.28 | 66.23 | 52.90 | 63.50 |

| Lama-30b | 56.33 | 44,68 | 65.64 | 54.60 | 61.57 |

| xverse-13b | 55.24 | 45.60 | 64.51 | 50,32 | 63.27 |

| QWEN-7B | 54.13 | 41.76 | 63.43 | 50.81 | 62.50 |

| LLAMA2-13B-CHAT | 53,98 | 44,52 | 63.40 | 49.37 | 61.21 |

| Baichuan-13b-base | 53.46 | 43.86 | 63.14 | 49,73 | 59.28 |

| Baichuan2-7b-chat | 53.11 | 43.51 | 62.26 | 49,58 | 59.12 |

| Baichuan-13b-chat | 51.12 | 41.61 | 59.11 | 47,52 | 58.31 |

| Ziya-lelama-13b-v1.1 | 51.06 | 41.89 | 57.71 | 49.22 | 56,54 |

| LLAMA2-7B-CHAT | 48.10 | 39.64 | 56.28 | 43.61 | 55,39 |

| Lama-13b | 46.51 | 37.23 | 52.71 | 44.35 | 53.04 |

| Chatglm2-6b | 45.83 | 38.75 | 52.06 | 43.20 | 50,82 |

| Atomgpt-13b-56k | 42.75 | 36.02 | 49.04 | 38.80 | 49.30 |

| Baichuan-7b | 41.96 | 36.63 | 47.77 | 37,55 | 48.31 |

| Ziya-lelama-13b-prétraigne-v1 | 41.61 | 33.61 | 46.01 | 39.85 | 48.05 |

| Chatglm1.1-6b | 40.07 | 32.95 | 44.55 | 39.23 | 44.12 |

| Chatglm-6b | 37.87 | 32.41 | 43.80 | 35.60 | 41.00 |

| Lama-7b | 28.53 | 26.10 | 28.76 | 28.52 | 24.81 |

| Ensemble de données | Méthode | Métrique | Type de tâche | Zéro | À quelques coups | ||||||||

| GLM-350M-Chinois | Pangu-350m | Pangu-2.6b | GLM-10B-Chinois | Pangu-13b | GLM-350M-Chinois | Pangu-350m | Pangu-2.6b | GLM-10B-Chinois | Pangu-13b | ||||

| Ocnli | Ppl | accrocheur | NLI | 0,3074 | 0,3369 | 0,3061 | 0,3288 | 0,3301 | 0,3298 | 0,3352 | 0,3216 | ||

| Cmnli | Ppl | accrocheur | NLI | 0,3279 | 0,3302 | 0,3310 | 0,3338 | 0,3358 | 0,3356 | 0,3328 | 0,3300 | ||

| Se déshabiller | Ppl | accrocheur | Cloze (multi-choix) | 0,0734 | 0,0916 | 0,0670 | 0.1016 | 0.1018 | 0,0979 | 0.1007 | 0,0996 | ||

| CMRC2018 | Génération | F1 | MRC | 0,093 | 0,0979 | 0.1007 | 0.1392 | 0,021 | 0,09345 | 0,097 | 0.1007 | ||

| Cluewsc2020 | Ppl | accrocheur | WSC | 0.4934 | 0,5328 | 0,5592 | 0,5131 | 0,4671 | 0,5526 | 0,4473 | 0,4671 | ||

| C3 | Ppl | accrocheur | Raisonnement de bon sens | 0,2360 | 0,2426 | 0,2418 | 0,2573 | 0,2567 | 0,2476 | 0,2559 | 0,2515 | ||

| Afqmc | Ppl | accrocheur | Classification de texte | 0,6306 | 0,4582 | 0.4914 | 0.4960 | 0,5000 | 0,4872 | 0.4993 | 0,5018 | ||

| CSL | Ppl | accrocheur | Classification de texte | 0.4943 | 0.4913 | 0,4666 | 0,5126 | 0.4996 | 0,5140 | 0,5036 | 0,4973 | ||

| Iflytek | Ppl | accrocheur | Classification de texte | 0.1292 | 0,3058 | 0,265 | 0,2620 | 0,2408 | 0,2539 | 0,2535 | 0,2524 | ||

| Tnews | Ppl | accrocheur | Classification de texte | 0,1582 | 0.2022 | 0,2449 | 0,2489 | 0,2527 | 0,2555 | 0,2466 | 0,2494 | ||

Paramètres de formation du modèle:

| Modèle | Quantité de paramètre de formation | Volume de données | taille de lot | longueur de séquence | matériel | Utilisation de la mémoire vidéo | vitesse | Heures par époque |

|---|---|---|---|---|---|---|---|---|

| GLM-350M-Chinois | 355m | 5,4 m | 4 | 512 | V100 16G | 13G | 3.7 S / ITER | 88h |

| Pangu-350m | 345m | 5,4 m | 48 | 512 | A100 80G | 78g | 1,91 s / iter | 27.5h |

| Pangu-2.6b | 2.6b | 5,4 m | 8 | 512 | A100 80G | 79.4g | 9.61 s / iter | 116h |

Téléchargement du modèle SFT:

| Modèle pré-formé | Ensemble de données SFT | taille | Adresse de câlins | Adresse du disque du réseau Baidu | Extraire du code |

|---|---|---|---|---|---|

| Pangu-350m | Données SFT et récompenses | 1,3 Go | Sunzeyeah / Pangu-350m-sft | Pangu-350m-sft | 0f8j |

| Pangu-2.6b | Données SFT et récompenses | 9,8 Go | sunzeyeah / pangu-2_6b-sft | Pangu-2.6b-sft | R13W |

# 生成参数

max_length = 512

max_length_generation = 100

top_k = 10

temperature = 0.8

do_sample=True

[Input] 我不能确定对方是不是喜欢我,我却想分分秒秒跟他在一起,有谁能告诉我如何能想他少一点<sep>回答:

[Generated] 你爱他就多关心他,少在他面前表现出你的脆弱。这样他才更会爱你。

[Input] 一次次买彩,一次次倾听那比分,一次次兴奋,一次次失落,一次次无归而返!最终还是任8~~~~<sep>回答:

[Generated] 我也是这样,买彩的时间也不长,但是每次都是这样。。。。。。。

[Input] 现代文:太祖很高兴地说:凭着这样的部下去作战,还担心不能取胜么?<sep>古文:

[Generated] 太祖悦曰:此自是以去,何忧不胜?

[Input] 现代文:十一年秋,丞相伯颜与阿术会师襄阳,遣阿剌罕率诸翼军攻郢、复诸州,十月夺取郢州之南门堡。<sep>古文:

[Generated] 十一年秋,丞相伯颜与阿术会师襄阳,遣阿剌罕率诸翼军攻郢、复诸州,十月夺郢州之南门堡。

[Input] 以孔⁇的风格,写一篇经书,题为中庸<sep>

[Generated] 我闻昔者夫子之言也,曰:吾道一以贯之。其或行之或不行,吾未知之。是故君子慎其独也。吾未见好德如好色者也。好德如好色者,未之有也。好德如好色者,既已之有也。君子不以言举人,不以人废言。好德如好色者,其如命何!吾

[Input] 以陆游的风格,写一首七言诗,题为晨起<sep>

[Generated] 秋光满纸清⁇明,睡醒一江万马奔。自笑身如枯木鹤,何妨食饱作闲人。

[Input] 上联:霜风几笔雕残画<sep>下联:

[Generated] 云海千山叠翠峰

[Input] 新闻内容:据悉,这名14岁的女生在Facebook上发布了戏谑考试的博文,其中使用了胡志明1946年反对法国殖民者的讲话,随后被越南当局停课一年。越南官员称,该学生歪曲了历史事件,侮辱了老师的情感。多数网友虽对越南当局做法不满,但都表示,至少他们还能上Facebook.<sep>摘要:越南女生Facebook上模仿胡志明讲话被停课<sep>评论:

[Generated] 这女的,还真有勇气,我喜欢你!

[Input] 新闻内容:习近平天津考察时勉励大学生志存高远、脚踏实地,转变择业观念,坚持从实际出发,勇于到基层一线和艰苦地方去,把人生的路一步步走稳走实,善于在平凡岗位上创造不平凡的业绩<sep>摘要:习近平勉励大学生转变择业观念勇于到基层和艰苦地方去<sep>评论:

[Generated] 现在的社会,很多年轻人都是在父母的安排下,去了不同的单位,在不同的地方工作,在不同的城市生活,这就导致了年轻人的思维方式,价值观都不一样,这也导致了年轻人的成长道路,也有很多的不安全感,这也是很正常的事情,年轻人需要正确的引导,正确的引导,也需要正确的引导!

[Input] 问题:劳动仲裁申请法院强制执行,法院强制执行需要多长时间<sep>回答:

[Generated] 一般申请法院强制执行需要3-6个月时间,具体需要看法院的执行措施。

[Input] 问题:银行贷款50万,30年!年利率是4.41怎么算一个月还多少钱<sep>回答:

[Generated] 若申请的是招行贷款,要计算贷款利息或者每月还款金额,需要知道贷款本金,贷款期限,还款方式,贷款年利率。若上述信息都确认到,可以通过我行贷款计算器尝试计算,登录招行官网右下方找到“理财计算器”--“个人贷款计算器”可以计算。

Paramètres de formation du modèle:

| Modèle | Quantité de paramètre de formation | Volume de données | taille de lot | longueur de séquence | matériel | Utilisation de la mémoire vidéo | vitesse | Heures par époque |

|---|---|---|---|---|---|---|---|---|

| Pangu-350m | 131m | 12m | 32 | 512 | A100 80G | 72,6g | 1,91 s / iter | 105h |

| Pangu-2.6b | 815m | 12m | 8 | 512 | A100 80G | 80,7 g | 423h |

Téléchargement du modèle de récompense:

| Modèle pré-formé | Ensemble de données SFT | taille | Adresse de câlins | Adresse du disque du réseau Baidu | Extraire du code |

|---|---|---|---|---|---|

| Pangu-350m | Données SFT et récompenses | 1,3 Go | Sunzeyeah / Pangu-350M-REWARD | Pangu-350m-récompense | 4gju |

À mettre à jour

Afin de vérifier si l'efficacité de formation de l'utilisation de la vitesse profonde dans différents modèles pré-formés peut réaliser les effets officiellement revendiqués (accélération, économie de GPU, etc.), l'analyse comparative a été réalisée

max_sequence_length=512| Modèle | données | Dans l'ensemble, le temps qui prend du temps | Qui prend du temps pour un seul échantillon | Utilisation de la mémoire | Utilisation de la mémoire vidéo | Modèle et quantité GPU | FP16 | BF16 | Étape de profondeur | Optimiseur de déchargement | Mémoire d'épingle | déchargement de déchargement | chevauchement | Taille du seau Allgather | Paramètres en direct Max Stage3 | taille de lot | Étapes d'accumulation de gradient | Poignage de contrôle du gradient | Modèle de la moitié |

| T5 | WMT16-EN-RO, un total de 610 000 échantillons | 43h | 0,5 s / it | 7.1g | 1 * 14529MB | 1 * V100 16G | vrai | - | - | - | - | - | - | - | - | 2 | 8 | FAUX | FAUX |

| 152h | 1,78s / it | 38.26g | 1 * 11663MB | 1 * V100 16G | vrai | - | 2 | vrai | vrai | - | FAUX | 2e8 | - | 2 | 8 | FAUX | FAUX | ||

| 250h | 2,95s / it | 38,74g | 1 * 7255 Mo | 1 * V100 16G | réel | - | 2 | vrai | vrai | - | FAUX | 1E5 | - | 2 | 8 | FAUX | FAUX | ||

| 62h | 5.8s / it | 86.81g | 8 * 7811 Mo | 8 * V100 16G | vrai | - | 2 | vrai | vrai | - | FAUX | 1E5 | - | 2 | 8 | FAUX | FAUX | ||

| - | - | - | Oom | 1 * V100 16G | vrai | - | 2 | vrai | vrai | - | FAUX | 2e8 | - | 16 | 8 | FAUX | FAUX | ||

| - | - | - | Oom | 1 * V100 16G | vrai | - | 2 | vrai | vrai | - | FAUX | 1E5 | - | 16 | 8 | FAUX | FAUX | ||

| 290h | 3.48S / IT | 46,53g | 1 * 6655mb | 1 * V100 16G | vrai | - | 3 | vrai | réel | vrai | FAUX | 2e8 | 2e8 | 2 | 8 | FAUX | FAUX | ||

| 380h | 4.5s / it | 43.48g | 1 * 5263MB | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E5 | 1E5 | 2 | 8 | FAUX | FAUX | ||

| 215h | 4.9s / it | 47.31g | 2 * 5019mb | 2 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E5 | 1E5 | 2 | 8 | FAUX | FAUX | ||

| 1370h | 64S / IT | 57,55g | 4 * 4701MB | 4 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E5 | 1E5 | 2 | 8 | FAUX | FAUX | ||

| 948h | 90s / it | 72,54g | 8 * 4585 Mo | 8 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E5 | 1E5 | 2 | 8 | FAUX | FAUX | ||

| Pangu-2.6b | Ensemble de vérification de SFT & REWARD DATA, avec un total de 10 000 échantillons | 2h | 5.76s / it | 67,86g | 1 * 15631MB | 1 * V100 16G | vrai | - | 2 | vrai | vrai | - | FAUX | 2e8 | - | 2 | 8 | FAUX | FAUX |

| 2.1h | 6.15s / it | 67,88g | 1 * 15705MB | 1 * V100 16G | vrai | - | 2 | vrai | vrai | - | FAUX | 1E5 | - | 2 | 8 | FAUX | FAUX | ||

| 4.5h | 13.3s / it | 81.02G | 1 * 15449MB | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 2e8 | 2e8 | 2 | 8 | FAUX | FAUX | ||

| 11.5h | 8.2s / it | 75.89g | 1 * 15299MB | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | faux | 1E5 | 1E5 | 2 | 8 | FAUX | FAUX | ||

| 5.5h | 7.8s / it | 81.16G | 2 * 14851MB | 2 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E5 | 1E5 | 2 | 8 | FAUX | FAUX | ||

| 6.2h | 18.3s / it | 97.31G | 4 * 14389mb | 4 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E5 | 1E5 | 2 | 8 | FAUX | FAUX | ||

| 6.6h | 38S / IT | 118.82g | 8 * 14335 Mo | 8 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E5 | 1E5 | 2 | 8 | FAUX | FAUX | ||

| Chatglm-6b | Ensemble de vérification de SFT & REWARD DATA, avec un total de 10 000 échantillons | - | - | 120,45g | Oom | 1 * V100 16G | vrai | - | 2 | vrai | vrai | - | FAUX | 1E5 | - | 1 | 8 | vrai | vrai |

| - | - | 120,48g | Oom | 1 * V100 16G | vrai | - | 2 | vrai | vrai | - | faux | 1E3 | - | 1 | 8 | FAUX | vrai | ||

| - | - | 153.02g | Oom | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E2 | 1E2 | 1 | 8 | FAUX | vrai | ||

| - | - | 154g | Oom | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 2e8 | 2e8 | 1 | 8 | vrai | vrai | ||

| 21.2h | 60s / it | 154g | 1 * 10443MB | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 2e8 | auto | 1 | 8 | vrai | vrai | ||

| 21,5h | 60s / it | 152.81g | 1 * 10409MB | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E5 | 1E5 | 1 | 8 | vrai | réel | ||

| 23,5h | 65s / it | 153,36g | 1 * 9229MB | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E3 | 1E3 | 1 | 8 | vrai | vrai | ||

| 14h | 80s / it | 158.21G | 2 * 8631MB | 2 * V100 16G | vrai | - | 3 | vrai | réel | vrai | FAUX | 1E3 | 1E3 | 1 | 8 | vrai | vrai | ||

| 7,8h | 90s / it | 168.38g | 4 * 6743MB | 4 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E3 | 1E3 | 1 | 8 | vrai | vrai | ||

| 4h | 90s / it | 189.34g | 8 * 6729MB | 8 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E3 | 1E3 | 1 | 8 | vrai | vrai | ||

| 1h | 100s / it | 189.38g | 8 * 10047mb | 8 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E3 | 1E3 | 4 | 8 | vrai | vrai | ||

| 50 minutes | 40s / it | 189.39g | 8 * 14763 Mo | 8 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | faux | 1E3 | 1E3 | 8 | 2 | vrai | vrai | ||

| 35 minutes | 113s / it | 189.39g | 8 * 14763 Mo | 8 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E3 | 1E3 | 8 | 8 | vrai | vrai | ||

| - | - | 189.34g | Oom | 8 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E3 | 1E3 | 10 | 8 | vrai | vrai | ||

| GLM-10B-Chinois | Ensemble de vérification de SFT & REWARD DATA, avec un total de 10 000 échantillons | - | - | - | Oom | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 2e8 | 2e8 | 1 | 8 | vrai | FAUX |

| - | - | - | Oom | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 2e8 | auto | 1 | 8 | vrai | FAUX | ||

| - | - | - | Oom | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E5 | 1E5 | 1 | 8 | vrai | FAUX | ||

| - | - | - | Oom | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E3 | 1E3 | 1 | 8 | vrai | FAUX | ||

| - | - | - | Oom | 1 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E2 | 1E2 | 1 | 8 | vrai | FAUX | ||

| - | - | - | Oom | 2 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E2 | 1E2 | 1 | 8 | vrai | FAUX | ||

| - | - | - | Oom | 4 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E2 | 1E2 | 1 | 8 | vrai | FAUX | ||

| - | - | Oom | - | 8 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E2 | 1E2 | 1 | 8 | vrai | FAUX | ||

| - | - | - | Oom | 4 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E2 | 1E2 | 1 | 8 | vrai | vrai | ||

| - | - | - | Oom | 6 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E2 | 1E2 | 1 | 8 | vrai | vrai | ||

| - | - | Oom | - | 8 * V100 16G | vrai | - | 3 | vrai | vrai | vrai | FAUX | 1E2 | 1E2 | 1 | 8 | vrai | vrai |

PS : Configuration Deeppeed pour les paramètres et l'expérience de réglage.

Afin de vérifier l'amélioration de l'efficacité de la formation de Lora, l'analyse comparative a été réalisée

max_sequence_length=512, lora_alpha=1, lora_train_bias='none'| Modèle | Rang lora | Quantité de paramètre de formation | vitesse profonde | taille de lot | Modèle et quantité GPU | Utilisation de la mémoire vidéo | Qui prend du temps pour un seul échantillon | Dans l'ensemble, le temps qui prend du temps |

| Pangu-2.6b | - | 2.6b | - | 8 | 1 * A100 80G | 1 * 79421MB | 9.66s / it | 12,5 minutes |

| 1000 | 1.5b | - | 8 | 1 * A100 80G | 1 * 76129MB | 11.61s / it | 15 minutes | |

| 500 | 758 Mo | - | 12 | 1 * A100 80G | 1 * 77179MB | 16.2s / it | 14 minutes | |

| 100 | 151 Mo | - | 16 | 1 * A100 80G | 1 * 81103MB | 18.6s / it | 12 minutes | |

| 50 | 75 Mo | - | 16 | 1 * A100 80G | 1 * 80809MB | 17.8s / it | 11,5 minutes | |

| 10 | 15 Mo | - | 16 | 1 * A100 80G | 1 * 78735mb | 17.6s / it | 11,5 minutes | |

| 100 | 151 Mo | étage = 2, déchargement W | vingt-quatre | 1 * A100 80G | 1 * 76933MB | 25,5s / it | 11 minutes | |

| 100 | 151 Mo | étage = 3, déchargement W | vingt-quatre | 1 * A100 80G | 1 * 77259MB | 46.5s / it | 20 minutes | |

| Chatglm-6b | - | 6.2b | - | 3 | 1 * A100 80G | 1 * 79206MB | 6.7s / it | 23,5 minutes |

| 1000 | 1.9b | - | 6 | 1 * A100 80G | 1 * 78840MB | 12.8s / it | 22,5 minutes | |

| 500 | 994 Mo | - | 6 | 1 * A100 80G | 1 * 68832MB | 12.4s / it | 21,5 minutes |