Proporciona 3 funciones principales:

git clone https://github.com/microsoft/DeepSpeed.git

cd deepspeed

rm -rf build

TORCH_CUDA_ARCH_LIST= " 7.0 " DS_BUILD_OPS=1 pip install -e . --global-option= " build_ext " --global-option= " -j8 " --no-cache -v --disable-pip-version-check 2>&1 | tee build.log Si desea crear una rueda binaria que sea conveniente para la instalación en otras máquinas, puede usar el siguiente comando, que generará un archivo instalable similar deepspeed-0.3.13+8cd046f-cp38-cp38-linux_x86_64.whl en dist .

git clone https://github.com/microsoft/DeepSpeed.git

cd deepspeed

rm -rf build

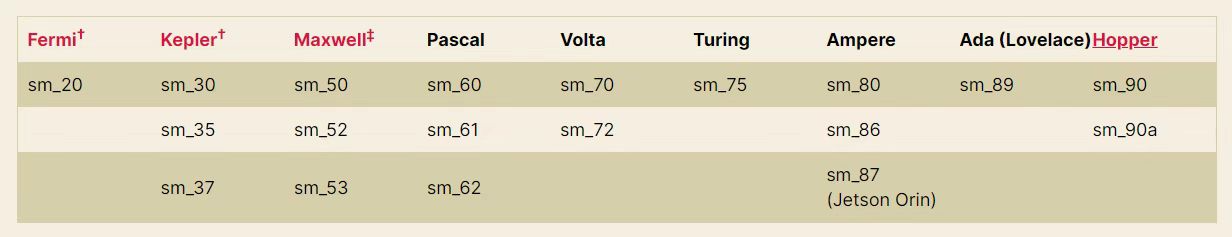

TORCH_CUDA_ARCH_LIST= " 7.0 " DS_BUILD_OPS=1 python setup.py build_ext -j8 bdist_wheel 2>&1 | tee build.log PS : Según la figura a continuación, TORCH_CUDA_ARCH_LIST="7.0" debe ajustarse a su arquitectura de GPU NVIDIA correspondiente.

O ejecute torch.cuda.get_device_capability() para obtener su propia arquitectura de GPU

Al usar el modelo de clase Pangu, su formato especial_token es <sep> , <pad> , etc., y la función tokenize() en tokenization_gptpangu.py usará jieba para la segmentación de palabras. Pero directamente pip install jieba separará directamente < de > predeterminada. Usar jieba.add_word("<sep>") no tiene ningún efecto, porque jieba directamente codifica tokens que se dividirá automáticamente, incluidos < >

Por lo tanto, es necesario ejecutar:

git clone https://github.com/fxsjy/jieba.git

cd jieba Clonate el código localmente y modifique el valor de re_han_default en jieba/__init__.py Los cambios específicos son los siguientes:

re_han_default = re . compile ( "([ u4E00 - u9FD5 a-zA-Z0-9+#&._%-]+)" , re . U ) re_han_default = re . compile ( "([ u4E00 - u9FD5 a-zA-Z0-9+#&._%-<>]+)" , re . U ) Después de completar la modificación, use pip install . para compilación e instalación local, y reemplace el jieba original. Después de completar la instalación, agregue jieba.add_word("<sep>") al código (el código se ha agregado tokenization_gptpangu.py) para resolver el problema de dividir tokens especiales de <sep> en múltiples ID.

git clone https://github.com/NVIDIA/apex

cd apex

pip install --global-option= " --cpp_ext " --global-option= " --cuda_ext " --no-cache -v --disable-pip-version-check . 2>&1 | tee build.log Si desea crear una rueda binaria que sea conveniente para la instalación en otras máquinas, puede usar el siguiente comando, que generará un archivo instalable similar apex-0.0.1+7150e20-cp38-cp38-linux_x86_64.whl en dist .

git clone https://github.com/NVIDIA/apex

cd apex

python setup.py --cpp_ext --cuda_ext bdist_wheel 2>&1 | tee build.log| Modelo | tamaño | dirección de la cara de abrazo | Dirección de disco de red de Baidu | Extraer código |

|---|---|---|---|---|

| Pangu-350m | 659mb | Sunzeyeah/Pangu-350m | Pangu-350m | C5JJ |

| Pangu-2.6b | 9.8GB | Sunzeyeah/Pangu-2_6b | Pangu-2.6b | 2RAD |

| Pangu-13b | 23.6GB | Sunzeyeah/Pangu-13b | Pangu-13b | U3DX |

| GLM-350M-CHINESES | 679mb | Sunzeyeah/GLM-350M-Chines | GLM-350M-CHINESES | ii8e |

| Glm-10b-china | 18.4g | Sunzeyeah/GLM-10B-Chinese | Glm-10b-china | fynj |

| Chatglm-6b | 25.6g | sunzeyeah/chatglm-6b | Chatglm-6b | uq1k |

PD : El modelo previamente capacitado proporcionado por este repositorio está descargando.

| Conjunto de datos | tamaño | dirección de la cara de abrazo | Dirección de disco de red de Baidu | Extraer código |

|---|---|---|---|---|

| Punto de referencia | 500MB | Punto de referencia | m6gt | |

| Datos de SFT y recompensas | 5 GB | sunzeyeah/chino_chatgpt_corpus | Datos de SFT y recompensas | ECYC |

| Enciclopedia | 652MB | baike_qa_2019 | 7jad | |

| Conocer las preguntas y respuestas | 847mb | zhidao | neds | |

| copla | 221 MB | parejas | 54ey | |

| Texto antiguo | 125 MB | Clásico y moderno | A4CR | |

| Poesía antigua | 87MB | poesía china | 5ZZJ | |

| Comentarios de Weibo News | 522mb | Comentarios resumidos de Weibo | W0G1 |

PD : Los datos de SFT y recompensas se basan en enciclopedia, conocimientos, pareos, textos antiguos, poemas antiguos y datos de comentarios de Weibo News, y pueden usarse directamente para el entrenamiento SFT y la etapa de recompensa. Consulte Data_Prepare.py para más detalles

Pre-capacitado incrementalmente para LLM de código abierto, basado en la implementación de la velocidad profunda. Actualmente admite arquitecturas de modelos de 2 clases:

cd examples

bash pretrain.shRevisiones de LLM chinos de código abierto para Zeroshot, OneShot o PewShot. Consulte eval_pretrain.py y data.py para más detalles.

Tareas de evaluación actualmente compatibles:

Modelos de código abierto compatibles actualmente:

cd examples

bash eval_pretrain.shEntrenamiento SFT usando Open Source LLM + SFT y datos de recompensas

cd examples

bash train_sft.shCapacitación de modelo de recompensa utilizando el modelo SFT + SFT y datos de recompensa

cd examples

bash train_reward.shUsando el algoritmo PPO y el modelo de recompensa, el modelo SFT se actualiza aún más. Implementado basado en el marco de código abierto DeepSpeedChat

cd examples

bash train_rlhf.shUsando el algoritmo DPO para reemplazar la tubería de recompensa+RLHF, eliminando el entrenamiento de los modelos de recompensa y logrando el efecto de la capacitación RL, este método puede reducir significativamente el uso de la memoria. Implementado basado en el marco de código abierto TRL

cd examples

bash train_dpo.sh| Modelo | Aviso | AVG (duro) | PROVENIR | Ciencia social | Humanidades | Otro |

| Baichuan2-13b-chat | 56.30 | 34.20 | 48.20 | 70.00 | 60.50 | 54.20 |

| xverse-13b | 55.30 | 32.50 | 45.90 | 66.70 | 59.50 | 57.60 |

| Qwen-7b-chat | 54.70 | 35.40 | 47.90 | 68.30 | 58.70 | 50.00 |

| Baichuan-13b-base | 53.70 | 35.60 | 46.80 | 65.80 | 58.00 | 50.80 |

| Baichuan2-7b-chat | 52.50 | 33.80 | 45.70 | 64.20 | 56.60 | 50.20 |

| Chatglm2-6b | 51.20 | 33.40 | 46.90 | 63.00 | 51.60 | 47.70 |

| Baichuan-13b-chat | 47.90 | 31.50 | 41.40 | 56.80 | 53.00 | 46.50 |

| Baichuan-7b | 44.20 | 31.70 | 39.20 | 53.30 | 47.30 | 41.90 |

| Ziya-llama-13b-V1.1 | 40.10 | 30.30 | 35.80 | 47.30 | 42.80 | 38.50 |

| Chatglm1.1-6b | 38.10 | 28.60 | 33.60 | 46.70 | 40.90 | 35.70 |

| AtomGPT-13B-56K | 37.60 | 25.30 | 32.00 | 44.70 | 42.80 | 36.10 |

| Llama2-13b-chat | 37.10 | 29.30 | 34.60 | 43.60 | 35.90 | 37.00 |

| Chatglm-6b | 36.30 | 27.20 | 32.90 | 42.80 | 38.10 | 34.90 |

| LLAMA-30B | 35.90 | 29.90 | 34.40 | 42.40 | 33.30 | 35.60 |

| Llama2-7b-chat | 33.50 | 27.30 | 31.60 | 38.10 | 33.80 | 32.70 |

| Ziya-llama-13b pretrain-v1 | 31.10 | 22.20 | 27.40 | 36.50 | 33.80 | 30.40 |

| Llama-13b | 29.8 | 24.20 | 28.40 | 33.70 | 29.60 | 29.00 |

| Llama-7b | 26.80 | 26.70 | 26.20 | 27.60 | 25.70 | 28.10 |

| Modelo | Aviso | PROVENIR | Ciencia social | Humanidades | Otro |

| Baichuan2-13b-chat | 56.90 | 47.28 | 66.23 | 52.90 | 63.50 |

| LLAMA-30B | 56.33 | 44.68 | 65.64 | 54.60 | 61.57 |

| xverse-13b | 55.24 | 45.60 | 64.51 | 50.32 | 63.27 |

| Qwen-7b-chat | 54.13 | 41.76 | 63.43 | 50.81 | 62.50 |

| Llama2-13b-chat | 53.98 | 44.52 | 63.40 | 49.37 | 61.21 |

| Baichuan-13b-base | 53.46 | 43.86 | 63.14 | 49.73 | 59.28 |

| Baichuan2-7b-chat | 53.11 | 43.51 | 62.26 | 49.58 | 59.12 |

| Baichuan-13b-chat | 51.12 | 41.61 | 59.11 | 47.52 | 58.31 |

| Ziya-llama-13b-V1.1 | 51.06 | 41.89 | 57.71 | 49.22 | 56.54 |

| Llama2-7b-chat | 48.10 | 39.64 | 56.28 | 43.61 | 55.39 |

| Llama-13b | 46.51 | 37.23 | 52.71 | 44.35 | 53.04 |

| Chatglm2-6b | 45.83 | 38.75 | 52.06 | 43.20 | 50.82 |

| AtomGPT-13B-56K | 42.75 | 36.02 | 49.04 | 38.80 | 49.30 |

| Baichuan-7b | 41.96 | 36.63 | 47.77 | 37.55 | 48.31 |

| Ziya-llama-13b pretrain-v1 | 41.61 | 33.61 | 46.01 | 39.85 | 48.05 |

| Chatglm1.1-6b | 40.07 | 32.95 | 44.55 | 39.23 | 44.12 |

| Chatglm-6b | 37.87 | 32.41 | 43.80 | 35.60 | 41.00 |

| Llama-7b | 28.53 | 26.10 | 28.76 | 28.52 | 24.81 |

| Conjunto de datos | Método | Métrica | Tipo de tarea | Cero | Pocos disparos | ||||||||

| GLM-350M-CHINESES | Pangu-350m | Pangu-2.6b | Glm-10b-china | Pangu-13b | GLM-350M-CHINESES | Pangu-350m | Pangu-2.6b | Glm-10b-china | Pangu-13b | ||||

| Ocnli | Ppl | accidentista | NLI | 0.3074 | 0.3369 | 0.3061 | 0.3288 | 0.3301 | 0.3298 | 0.3352 | 0.3216 | ||

| Cmnli | Ppl | accidentista | NLI | 0.3279 | 0.3302 | 0.3310 | 0.3338 | 0.3358 | 0.3356 | 0.3328 | 0.3300 | ||

| Chid | Ppl | accidentista | Cloze (múltiples elecciones) | 0.0734 | 0.0916 | 0.0670 | 0.1016 | 0.1018 | 0.0979 | 0.1007 | 0.0996 | ||

| CMRC2018 | Generación | F1 | MRC | 0.093 | 0.0979 | 0.1007 | 0.1392 | 0.021 | 0.09345 | 0.097 | 0.1007 | ||

| CLUEWSC2020 | Ppl | accidentista | WSC | 0.4934 | 0.5328 | 0.5592 | 0.5131 | 0.4671 | 0.5526 | 0.4473 | 0.4671 | ||

| C3 | Ppl | accidentista | Razonamiento de sentido común | 0.2360 | 0.2426 | 0.2418 | 0.2573 | 0.2567 | 0.2476 | 0.2559 | 0.2515 | ||

| AFQMC | Ppl | accidentista | Clasificación de texto | 0.6306 | 0.4582 | 0.4914 | 0.4960 | 0.5000 | 0.4872 | 0.4993 | 0.5018 | ||

| CSL | Ppl | accidentista | Clasificación de texto | 0.4943 | 0.4913 | 0.4666 | 0.5126 | 0.4996 | 0.5140 | 0.5036 | 0.4973 | ||

| Iflytek | Ppl | accidentista | Clasificación de texto | 0.1292 | 0.3058 | 0.265 | 0.2620 | 0.2408 | 0.2539 | 0.2535 | 0.2524 | ||

| TNEWS | Ppl | accidentista | Clasificación de texto | 0.1582 | 0.2022 | 0.2449 | 0.2489 | 0.2527 | 0.2555 | 0.2466 | 0.2494 | ||

Parámetros de entrenamiento de modelos:

| Modelo | Cantidad del parámetro de entrenamiento | Volumen de datos | tamaño por lotes | longitud de secuencia | hardware | Uso de la memoria de video | velocidad | Horas por época |

|---|---|---|---|---|---|---|---|---|

| GLM-350M-CHINESES | 355m | 5.4m | 4 | 512 | V100 16G | 13G | 3.7 s/iter | 88h |

| Pangu-350m | 345m | 5.4m | 48 | 512 | A100 80g | 78g | 1.91 s/iter | 27.5h |

| Pangu-2.6b | 2.6b | 5.4m | 8 | 512 | A100 80g | 79.4g | 9.61 s/iter | 116h |

Descarga del modelo SFT:

| Modelo previamente capacitado | Conjunto de datos SFT | tamaño | dirección de la cara de abrazo | Dirección de disco de red de Baidu | Extraer código |

|---|---|---|---|---|---|

| Pangu-350m | Datos de SFT y recompensas | 1.3GB | sunzeyeah/pangu-350m-sft | Pangu-350m-sft | 0f8j |

| Pangu-2.6b | Datos de SFT y recompensas | 9.8GB | sunzeyeah/pangu-2_6b-sft | Pangu-2.6b-sft | R13W |

# 生成参数

max_length = 512

max_length_generation = 100

top_k = 10

temperature = 0.8

do_sample=True

[Input] 我不能确定对方是不是喜欢我,我却想分分秒秒跟他在一起,有谁能告诉我如何能想他少一点<sep>回答:

[Generated] 你爱他就多关心他,少在他面前表现出你的脆弱。这样他才更会爱你。

[Input] 一次次买彩,一次次倾听那比分,一次次兴奋,一次次失落,一次次无归而返!最终还是任8~~~~<sep>回答:

[Generated] 我也是这样,买彩的时间也不长,但是每次都是这样。。。。。。。

[Input] 现代文:太祖很高兴地说:凭着这样的部下去作战,还担心不能取胜么?<sep>古文:

[Generated] 太祖悦曰:此自是以去,何忧不胜?

[Input] 现代文:十一年秋,丞相伯颜与阿术会师襄阳,遣阿剌罕率诸翼军攻郢、复诸州,十月夺取郢州之南门堡。<sep>古文:

[Generated] 十一年秋,丞相伯颜与阿术会师襄阳,遣阿剌罕率诸翼军攻郢、复诸州,十月夺郢州之南门堡。

[Input] 以孔⁇的风格,写一篇经书,题为中庸<sep>

[Generated] 我闻昔者夫子之言也,曰:吾道一以贯之。其或行之或不行,吾未知之。是故君子慎其独也。吾未见好德如好色者也。好德如好色者,未之有也。好德如好色者,既已之有也。君子不以言举人,不以人废言。好德如好色者,其如命何!吾

[Input] 以陆游的风格,写一首七言诗,题为晨起<sep>

[Generated] 秋光满纸清⁇明,睡醒一江万马奔。自笑身如枯木鹤,何妨食饱作闲人。

[Input] 上联:霜风几笔雕残画<sep>下联:

[Generated] 云海千山叠翠峰

[Input] 新闻内容:据悉,这名14岁的女生在Facebook上发布了戏谑考试的博文,其中使用了胡志明1946年反对法国殖民者的讲话,随后被越南当局停课一年。越南官员称,该学生歪曲了历史事件,侮辱了老师的情感。多数网友虽对越南当局做法不满,但都表示,至少他们还能上Facebook.<sep>摘要:越南女生Facebook上模仿胡志明讲话被停课<sep>评论:

[Generated] 这女的,还真有勇气,我喜欢你!

[Input] 新闻内容:习近平天津考察时勉励大学生志存高远、脚踏实地,转变择业观念,坚持从实际出发,勇于到基层一线和艰苦地方去,把人生的路一步步走稳走实,善于在平凡岗位上创造不平凡的业绩<sep>摘要:习近平勉励大学生转变择业观念勇于到基层和艰苦地方去<sep>评论:

[Generated] 现在的社会,很多年轻人都是在父母的安排下,去了不同的单位,在不同的地方工作,在不同的城市生活,这就导致了年轻人的思维方式,价值观都不一样,这也导致了年轻人的成长道路,也有很多的不安全感,这也是很正常的事情,年轻人需要正确的引导,正确的引导,也需要正确的引导!

[Input] 问题:劳动仲裁申请法院强制执行,法院强制执行需要多长时间<sep>回答:

[Generated] 一般申请法院强制执行需要3-6个月时间,具体需要看法院的执行措施。

[Input] 问题:银行贷款50万,30年!年利率是4.41怎么算一个月还多少钱<sep>回答:

[Generated] 若申请的是招行贷款,要计算贷款利息或者每月还款金额,需要知道贷款本金,贷款期限,还款方式,贷款年利率。若上述信息都确认到,可以通过我行贷款计算器尝试计算,登录招行官网右下方找到“理财计算器”--“个人贷款计算器”可以计算。

Parámetros de entrenamiento de modelos:

| Modelo | Cantidad del parámetro de entrenamiento | Volumen de datos | tamaño por lotes | longitud de secuencia | hardware | Uso de la memoria de video | velocidad | Horas por época |

|---|---|---|---|---|---|---|---|---|

| Pangu-350m | 131m | 12m | 32 | 512 | A100 80g | 72.6g | 1.91 s/iter | 105h |

| Pangu-2.6b | 815m | 12m | 8 | 512 | A100 80g | 80.7g | 423h |

Descarga del modelo de recompensa:

| Modelo previamente capacitado | Conjunto de datos SFT | tamaño | dirección de la cara de abrazo | Dirección de disco de red de Baidu | Extraer código |

|---|---|---|---|---|---|

| Pangu-350m | Datos de SFT y recompensas | 1.3GB | Sunzeyeah/Pangu-350m-Reward | Pangu-350m-recompensa | 4gju |

Para ser actualizado

Para verificar si la eficiencia de capacitación del uso de la velocidad profunda en diferentes modelos previamente capacitados puede lograr los efectos oficialmente reclamados (aceleración, ahorro de GPU, etc.), se llevó a cabo la evaluación comparativa

max_sequence_length=512| Modelo | datos | En general, lento/época | Lento para una sola muestra | Uso de memoria | Uso de la memoria de video | Modelo y cantidad de GPU | FP16 | BF16 | etapa de velocidad profunda | optimizador de descarga | memoria de pin | descarga de parámetro descarga | superposición de comunicación | Tamaño del cubo de AllGather | Stage3 Max Live Parámetros | tamaño por lotes | Pasos de acumulación de gradiente | Punta de control de gradiente | mitad modelo |

| T5-grande | WMT16-EN-RO, un total de 610,000 muestras | 43h | 0.5s/ | 7.1G | 1*14529mb | 1*v100 16g | verdadero | - | - | - | - | - | - | - | - | 2 | 8 | FALSO | FALSO |

| 152h | 1.78s/ | 38.26g | 1*11663MB | 1*v100 16g | verdadero | - | 2 | verdadero | verdadero | - | FALSO | 2E8 | - | 2 | 8 | FALSO | FALSO | ||

| 250h | 2.95s/ | 38.74g | 1*7255mb | 1*v100 16g | verdadero | - | 2 | verdadero | verdadero | - | FALSO | 1e5 | - | 2 | 8 | FALSO | FALSO | ||

| 62h | 5.8s/ | 86.81G | 8*7811MB | 8*v100 16g | verdadero | - | 2 | verdadero | verdadero | - | FALSO | 1e5 | - | 2 | 8 | FALSO | FALSO | ||

| - | - | - | Oom | 1*v100 16g | verdadero | - | 2 | verdadero | verdadero | - | FALSO | 2E8 | - | 16 | 8 | FALSO | FALSO | ||

| - | - | - | Oom | 1*v100 16g | verdadero | - | 2 | verdadero | verdadero | - | FALSO | 1e5 | - | 16 | 8 | FALSO | FALSO | ||

| 290h | 3.48s/ | 46.53g | 1*6655mb | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 2E8 | 2E8 | 2 | 8 | FALSO | FALSO | ||

| 380h | 4.5s/ | 43.48g | 1*5263mb | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e5 | 1e5 | 2 | 8 | FALSO | FALSO | ||

| 215h | 4.9s/ | 47.31G | 2*5019mb | 2*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e5 | 1e5 | 2 | 8 | FALSO | FALSO | ||

| 1370h | 64s/ | 57.55G | 4*4701MB | 4*V100 16G | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e5 | 1e5 | 2 | 8 | FALSO | FALSO | ||

| 948h | 90s/ | 72.54g | 8*4585mb | 8*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e5 | 1e5 | 2 | 8 | FALSO | FALSO | ||

| Pangu-2.6b | Conjunto de verificación de datos de SFT y recompensa, con un total de 10,000 muestras | 2h | 5.76s/ | 67.86g | 1*15631MB | 1*v100 16g | verdadero | - | 2 | verdadero | verdadero | - | FALSO | 2E8 | - | 2 | 8 | FALSO | FALSO |

| 2.1h | 6.15s/ | 67.88g | 1*15705MB | 1*v100 16g | verdadero | - | 2 | verdadero | verdadero | - | FALSO | 1e5 | - | 2 | 8 | FALSO | FALSO | ||

| 4.5h | 13.3s/ | 81.02G | 1*15449mb | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 2E8 | 2E8 | 2 | 8 | FALSO | FALSO | ||

| 11.5h | 8.2s/ | 75.89g | 1*15299mb | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e5 | 1e5 | 2 | 8 | FALSO | FALSO | ||

| 5.5h | 7.8s/ | 81.16g | 2*14851MB | 2*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e5 | 1e5 | 2 | 8 | FALSO | FALSO | ||

| 6.2h | 18.3s/ | 97.31G | 4*14389mb | 4*V100 16G | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e5 | 1e5 | 2 | 8 | FALSO | FALSO | ||

| 6.6h | 38s/ | 118.82G | 8*14335MB | 8*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e5 | 1e5 | 2 | 8 | FALSO | FALSO | ||

| Chatglm-6b | Conjunto de verificación de datos de SFT y recompensa, con un total de 10,000 muestras | - | - | 120.45G | Oom | 1*v100 16g | verdadero | - | 2 | verdadero | verdadero | - | FALSO | 1e5 | - | 1 | 8 | verdadero | verdadero |

| - | - | 120.48g | Oom | 1*v100 16g | verdadero | - | 2 | verdadero | verdadero | - | FALSO | 1e3 | - | 1 | 8 | FALSO | verdadero | ||

| - | - | 153.02G | Oom | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e2 | 1e2 | 1 | 8 | FALSO | verdadero | ||

| - | - | 154g | Oom | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 2E8 | 2E8 | 1 | 8 | verdadero | verdadero | ||

| 21.2h | 60s/ | 154g | 1*10443mb | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 2E8 | auto | 1 | 8 | verdadero | verdadero | ||

| 21.5h | 60s/ | 152.81g | 1*10409mb | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e5 | 1e5 | 1 | 8 | verdadero | verdadero | ||

| 23.5h | 65s/ | 153.36g | 1*9229mb | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e3 | 1e3 | 1 | 8 | verdadero | verdadero | ||

| 14h | 80s/ | 158.21G | 2*8631MB | 2*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e3 | 1e3 | 1 | 8 | verdadero | verdadero | ||

| 7.8h | 90s/ | 168.38g | 4*6743mb | 4*V100 16G | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e3 | 1e3 | 1 | 8 | verdadero | verdadero | ||

| 4h | 90s/ | 189.34g | 8*6729mb | 8*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e3 | 1e3 | 1 | 8 | verdadero | verdadero | ||

| 1h | 100s/ | 189.38g | 8*10047mb | 8*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e3 | 1e3 | 4 | 8 | verdadero | verdadero | ||

| 50 minutos | 40s/ | 189.39g | 8*14763MB | 8*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e3 | 1e3 | 8 | 2 | verdadero | verdadero | ||

| 35min | 113s/ | 189.39g | 8*14763MB | 8*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e3 | 1e3 | 8 | 8 | verdadero | verdadero | ||

| - | - | 189.34g | Oom | 8*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e3 | 1e3 | 10 | 8 | verdadero | verdadero | ||

| Glm-10b-china | Conjunto de verificación de datos de SFT y recompensa, con un total de 10,000 muestras | - | - | - | Oom | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 2E8 | 2E8 | 1 | 8 | verdadero | FALSO |

| - | - | - | Oom | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 2E8 | auto | 1 | 8 | verdadero | FALSO | ||

| - | - | - | Oom | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e5 | 1e5 | 1 | 8 | verdadero | FALSO | ||

| - | - | - | Oom | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e3 | 1e3 | 1 | 8 | verdadero | FALSO | ||

| - | - | - | Oom | 1*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e2 | 1e2 | 1 | 8 | verdadero | FALSO | ||

| - | - | - | Oom | 2*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e2 | 1e2 | 1 | 8 | verdadero | FALSO | ||

| - | - | - | Oom | 4*V100 16G | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e2 | 1e2 | 1 | 8 | verdadero | FALSO | ||

| - | - | Oom | - | 8*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e2 | 1e2 | 1 | 8 | verdadero | FALSO | ||

| - | - | - | Oom | 4*V100 16G | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e2 | 1e2 | 1 | 8 | verdadero | verdadero | ||

| - | - | - | Oom | 6*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e2 | 1e2 | 1 | 8 | verdadero | verdadero | ||

| - | - | Oom | - | 8*v100 16g | verdadero | - | 3 | verdadero | verdadero | verdadero | FALSO | 1e2 | 1e2 | 1 | 8 | verdadero | verdadero |

PS : Configuración de la velocidad profunda para parámetros y experiencia de ajuste.

Para verificar la mejora de la eficiencia de entrenamiento de Lora, se realizó la evaluación comparativa

max_sequence_length=512, lora_alpha=1, lora_train_bias='none'| Modelo | Rango de lora | Cantidad del parámetro de entrenamiento | velocidad profunda | tamaño por lotes | Modelo y cantidad de GPU | Uso de la memoria de video | Lento para una sola muestra | En general, lento/época |

| Pangu-2.6b | - | 2.6b | - | 8 | 1*A100 80g | 1*79421MB | 9.66s/ | 12.5min |

| 1000 | 1.5b | - | 8 | 1*A100 80g | 1*76129mb | 11.61s/ | 15 minutos | |

| 500 | 758mb | - | 12 | 1*A100 80g | 1*77179mb | 16.2s/ | 14 minutos | |

| 100 | 151 MB | - | 16 | 1*A100 80g | 1*81103MB | 18.6s/ | 12 minutos | |

| 50 | 75 MB | - | 16 | 1*A100 80g | 1*80809MB | 17.8s/ | 11.5min | |

| 10 | 15 MB | - | 16 | 1*A100 80g | 1*78735MB | 17.6s/ | 11.5min | |

| 100 | 151 MB | etapa = 2, W de descarga | veinticuatro | 1*A100 80g | 1*76933mb | 25.5s/ | 11 minutos | |

| 100 | 151 MB | etapa = 3, W de descarga | veinticuatro | 1*A100 80g | 1*77259mb | 46.5s/ | 20 minutos | |

| Chatglm-6b | - | 6.2b | - | 3 | 1*A100 80g | 1*79206MB | 6.7s/ | 23.5min |

| 1000 | 1.9b | - | 6 | 1*A100 80g | 1*78840MB | 12.8s/ | 22.5min | |

| 500 | 994 MB | - | 6 | 1*A100 80g | 1*68832MB | 12.4s/ | 21.5min |