Этот проект мы рассмотрим несколько сегментов сбора данных из Instagram

Установите Python 3.6.0

Установите пакет PIP, введите командную строку:

python get-pip.py

Установите запросы PIP (это установит рамы Django и Selenium)

cd * PATH * / Project

pip install -r requirements.txt

Установите клиент Firefox (вы можете скачать знаменитый браузер Mozilla Firefox)

Завершенный

Если вы хотите использовать веб -платформу, вам необходимо развернуть всю систему Django в базе данных. Мы делаем это со следующим кодом:

cd * PATH * / Project / web. / manage.py makemigrations

Это выполнит миграции из модели. /manage.py Migrate преобразование миграции из модели на базу

Доступ пользователя/администратора по умолчанию:

Чтобы создать супер администратора, у которого есть все привилегии, тип:

./manage.py createsuperuser

Введите поля, которые требуются.

Чтобы включить сервер, запустите следующую команду и активируйте веб -приложение Django в порту 8000

./manage.py runserver 8000

Использование скрипта для сбора данных слишком просто, вот полный API, с которым вы можете обслуживать.

Предупреждение! Прежде чем начнете использовать какую -либо услугу от Crawler, вы должны настроить пользователя Authentication Instagram, который будет использоваться для ползания данных, которые видны только для аутентифицированных пользователей

Перейдите в Project / Script / settings.py

Измените информацию об аутентификации

По умолчанию: username = "kiril_cvetkov" password = " * "

Введите свое имя пользователя и пароль, через которые входит в систему браузер.

Как только мы настроили наш Sniffer, ниже приведен полный API, а также пример, чтобы дать полное представление о том, как можно использовать сценарий

crawl.py [-db EXPORT_DB] [-DIR DIRECTORY] [-page PAGE_NAME] [-more MORE_DETAILS] [-num POST_NUMBER]

* [-db EXPORT_DB] Whether to save data in a database or only in a file system

* [-DIR DIRECTORY]: Directory where the data will be stored

* [-page PAGE_NAME]: Profile / crawling page

* [-more MORE_DETAILS]: Retrieve more details, such as a number of likes, description of pictures within a single photo

Сначала перейдите в каталог, где находится сценарий

cd * PATH * / Project / script

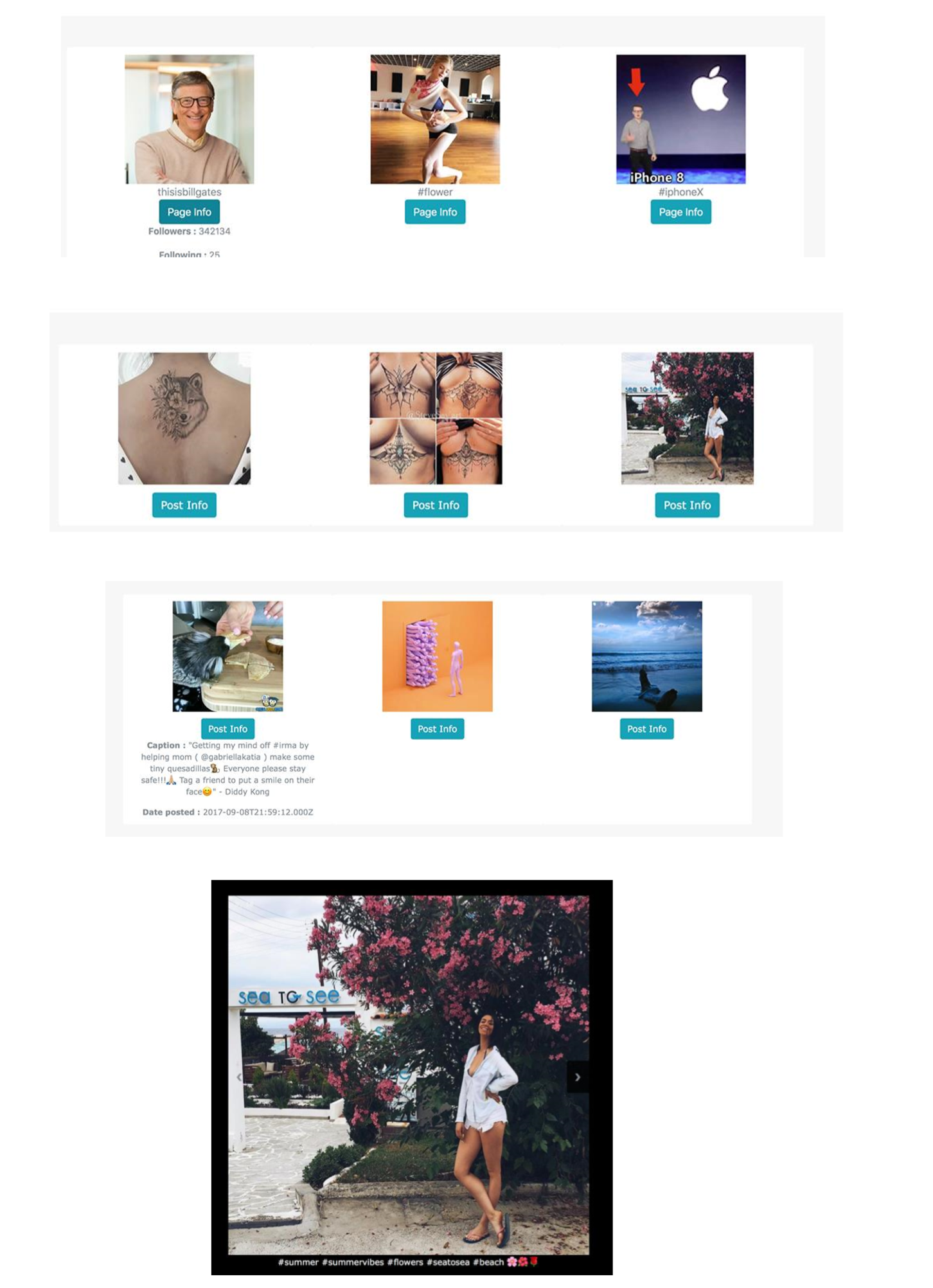

Чтобы запустить сценарий и заполнить данные со страницы Билла Гейтса :), пожалуйста, введите:

python crawl.py -num = 30 -page = thisisbillgates -more -db

Вы можете увидеть все страницы, которые индексируются нашим поисковиком

Вы можете отфильтровать изображения, которые содержат ключевое слово на имени страницы, или вы можете искать по ключевым словам, содержащимся в их описании

Вы можете нажать на конкретное изображение и перечислить его в галерее

Вы можете изменить данные через панель администрирования, чтобы получить доступ к разделу администратора, введите следующий URL -адрес

Localhost: 8000/Admin

Самое большое использование такой определенной и реализованной архитектуры заключается в том, что поиск данных может принести нам огромную силу сегодня, особенно в области больших данных , глубокого обучения и других алгоритмов машинного обучения . Если мы ищем изображения с определенными хэштегами, то система дает нам изображения, которые логически содержат тот же хэштег. Мы можем только представить, как Instagram использует хэштеги для обучения системы для распознавания различных событий, объектов, событий, статей, моделей в режиме реального времени. Но с использованием этого сценария вся информация доступна для нас, если мы знаем, как их взять. Веб -браузеры и веб -поиск - это мощная способность, которую должны иметь каждый разработчик и бизнес -аналитик.