Treinador

Este treinador foi desenvolvido pela equipe Eden , você pode experimentar nossa versão hospedada do treinador em nosso aplicativo . É um treinador altamente otimizado que pode ser usado para os módulos completos de Finetuning e Treining Lora, além da difusão estável. Ele usa um único script de treinamento e módulo de perda que funciona para SDV15 e SDXL !

As saídas deste treinador são totalmente compatíveis com a Comfyui e o Auto111, consulte a documentação aqui. Um guia completo sobre treinamento pode ser encontrado em nossos documentos .

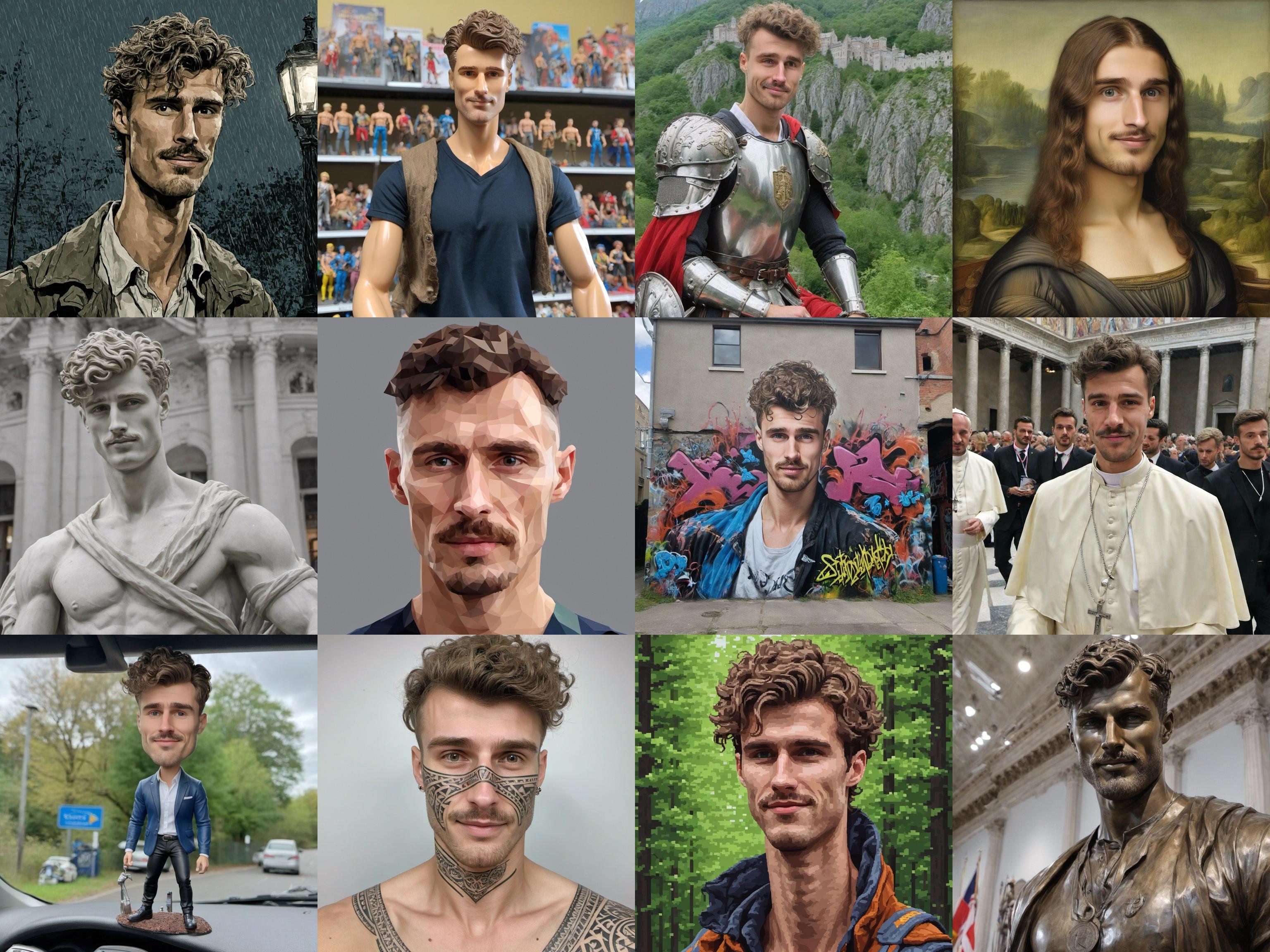

Imagens de treinamento:

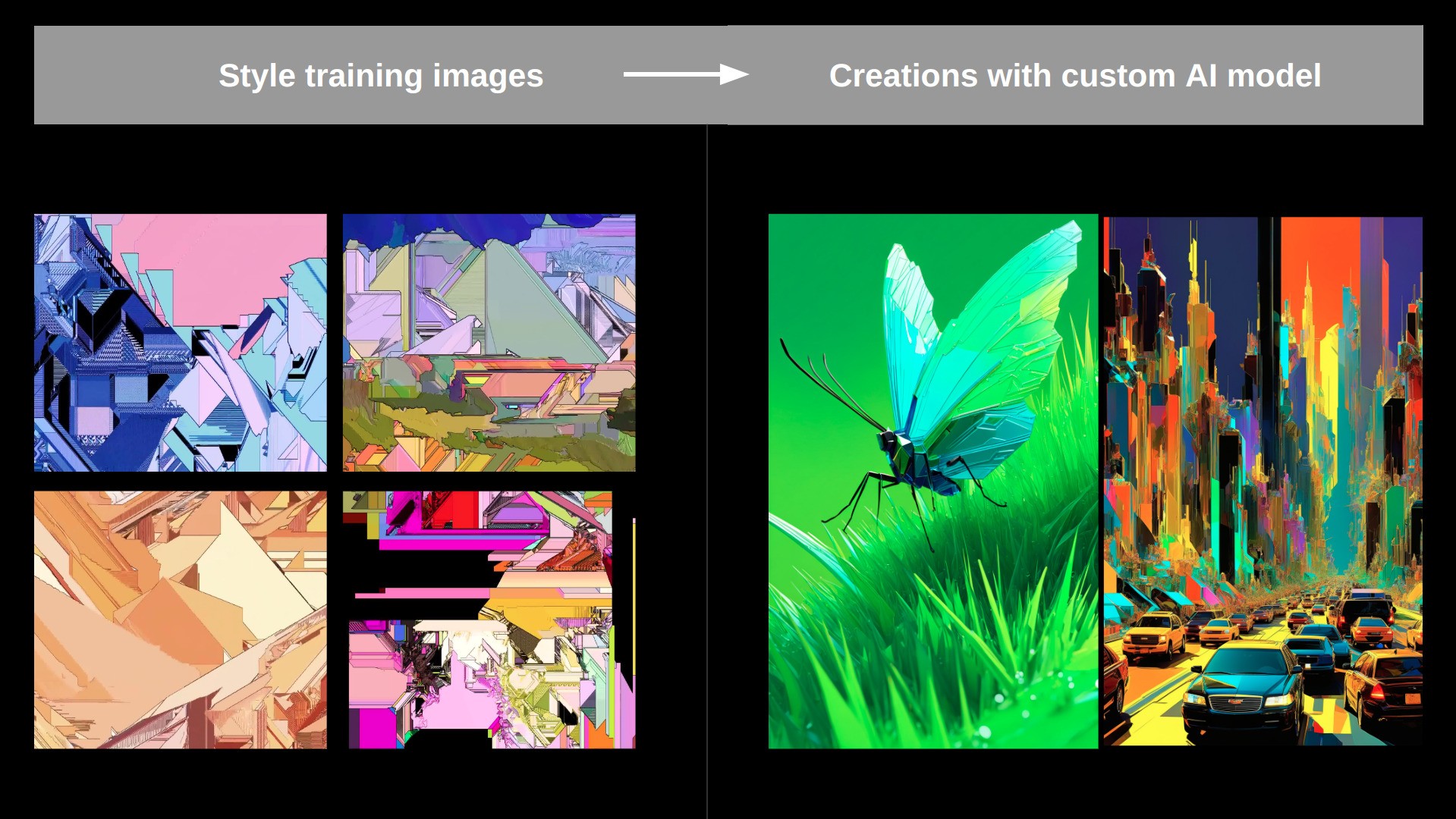

IMGs gerados com Lora treinada:

O treinador pode ser executado de 4 maneiras diferentes:

- Como um serviço hospedado em nosso site

- Como um serviço hospedado através de replicação

- Como um nó conformado

- Como um script python independente

Usando em conformyui:

- Exemplo de fluxos de trabalho sobre como executar o treinador e fazer inferência com ele pode ser encontrado em

/ComfyUI_workflows - É importante ressaltar que este treinador usa uma chamada de chatgpt para limpar os avisos gerados automaticamente e injetar o token treinável, isso só funcionará se você tiver um arquivo .env contendo sua tecla OpenAI na raiz do repo diretor que contém uma única linha:

OPENAI_API_KEY=your_key_string tudo o que funcionará, mas os resultados serão melhores se você definirá este.

O treinador suporta 3 modos padrão:

- Estilo : usado para aprender o estilo estético de uma coleção de imagens.

- Face : Usado para aprender um rosto específico (pode ser humano, caráter, ...).

- Objeto : aprenderá um objeto ou coisa específica apresentada nas imagens de treinamento.

Exemplo de treinamento de estilo:

Configurar

Instale todas as dependências usando

pip install -r requirements.txt

Então você pode simplesmente correr:

python main.py train_configs/training_args.json para iniciar um trabalho de treinamento.

Ajuste os argumentos dentro de training_args.json para configurar um trabalho de treinamento personalizado.

Você também pode executar isso através de replicar usando o Cog (~ Docker Image):

- Instale replicar 'COG':

sudo curl -o /usr/local/bin/cog -L "https://github.com/replicate/cog/releases/latest/download/cog_$(uname -s)_$(uname -m)"

sudo chmod +x /usr/local/bin/cog

- Construa a imagem com

cog build - Execute uma corrida de treinamento com

sh cog_test_train.sh - Você também pode entrar no contêiner com

cog run /bin/bash

Finetuning completo

Ao executar este treinador em Python nativo, você também pode executar o Finetuning UNET completo usando algo como (Ajuste suas necessidades) python main.py train_configs/full_finetuning_example.json

TODO

Bugs:

- A inversão textual pura para SD15 não parece funcionar bem ... (mas funciona incrivelmente bem para sdxl ...) ---> Se alguém puder descobrir isso, ficaria eternamente grato!

- Descubra por que o treinamento é 3x mais lento através do nó conformado versus apenas executando o main.py como um trabalho python ..?

- Corrija Bucketing de Aspect_ratio no Dataloader (consulte https://github.com/kohya-ss/sd-scripts)

Melhorias maiores:

- integrar o fluxo / sd3

- Adicione treinamento com vários conceitos (várias coisas representadas por vários tokens, treinados em uma única Lora)

- Adicione a regularização do token mais forte (por exemplo, a base de spanning de celebridades)

- Implementar idéias de perfusão (travamento -chave com superclass): https://research.nvidia.com/labs/par/perfusion/

- implementar prompt-aligned: https://prompt-aligned.github.io/