Entrenador

Este entrenador fue desarrollado por el equipo de Eden , puede probar nuestra versión alojada del entrenador en nuestra aplicación . Es un entrenador altamente optimizado que puede usarse tanto para los módulos Lora de Fineting Full Finetery en la parte superior de la difusión estable. ¡Utiliza un solo script de entrenamiento y un módulo de pérdida que funciona tanto para SDV15 como para SDXL !

Las salidas de este entrenador son totalmente compatibles con COMFYUI y Auto111, vea la documentación aquí. Se puede encontrar una guía completa sobre la capacitación en nuestros documentos .

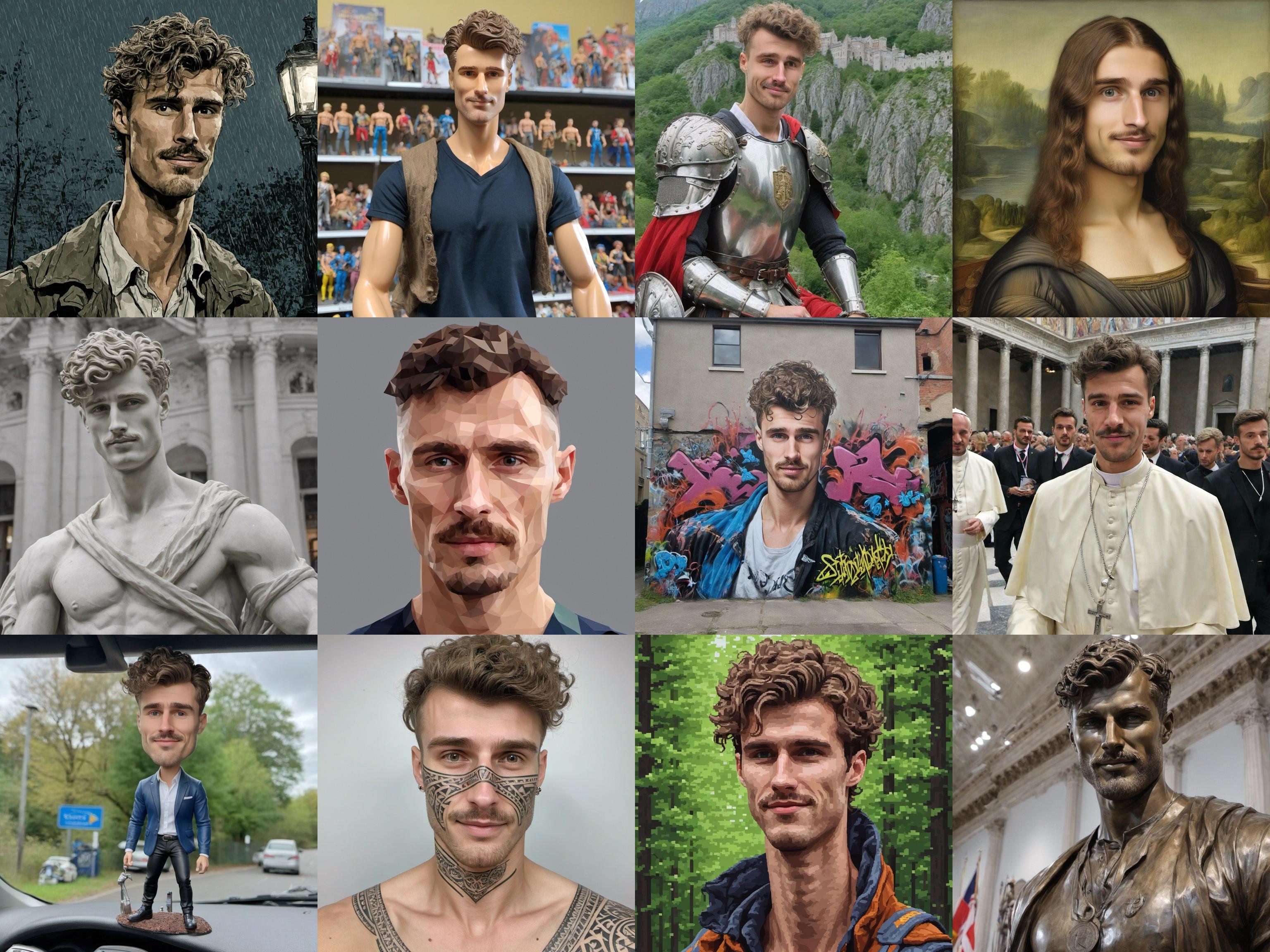

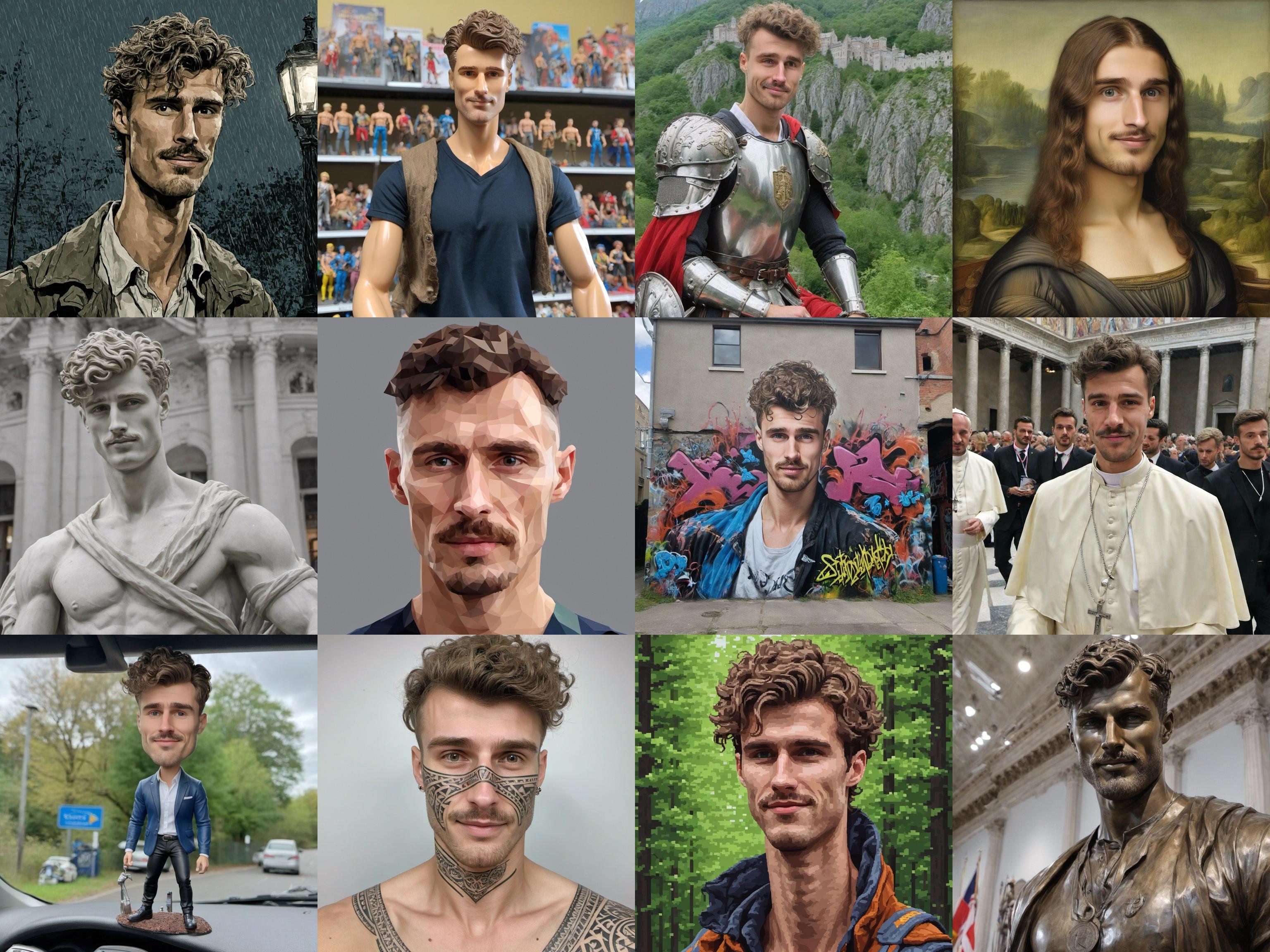

Imágenes de entrenamiento:

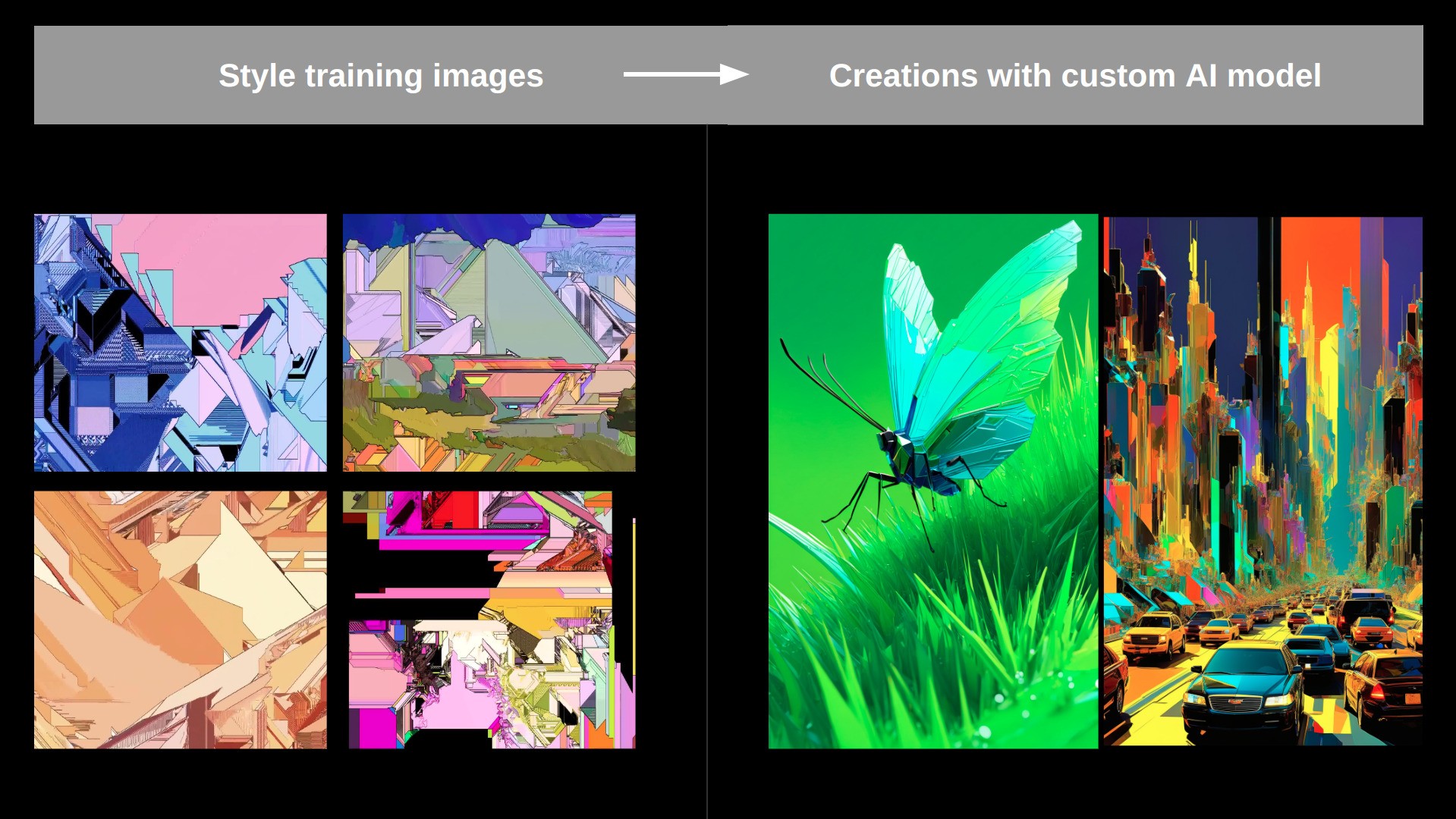

IMG generados con Lora entrenada:

El entrenador se puede ejecutar de 4 maneras diferentes:

- Como servicio alojado en nuestro sitio web

- Como servicio alojado a través de replicar

- como un nodo cómico

- Como un guión independiente de Python

Usando en Comfyui:

- Los flujos de trabajo de ejemplo para cómo ejecutar el entrenador y hacer inferencia se pueden encontrar en

/ComfyUI_workflows - Es importante destacar que este entrenador usa una llamada CHATGPT para limpiar las indicaciones automáticas generadas e inyectar el token capacitable, esto solo funcionará si tiene un archivo .env que contiene su tecla OpenAI en la raíz de la Repo Dir que contiene una sola línea:

OPENAI_API_KEY=your_key_string todo funcionará sin esto, pero los resultados serán mejores si establece esto, especialmente para 'Face' y 'Object' Mods 'Object' Object 'Object.

El entrenador admite 3 modos predeterminados:

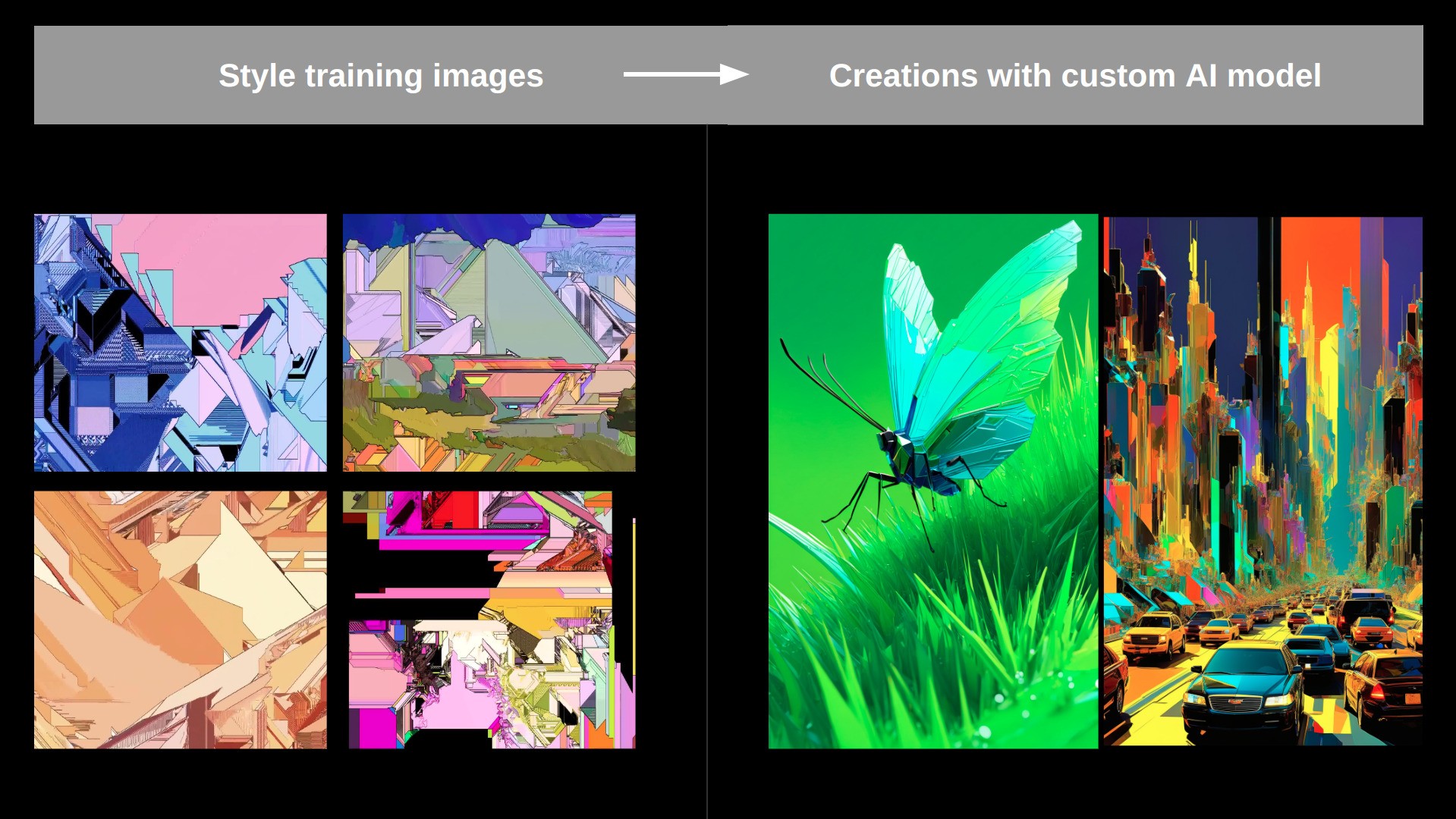

- Estilo : utilizado para aprender el estilo estético de una colección de imágenes.

- cara : se usa para aprender una cara específica (puede ser humano, carácter, ...).

- Objeto : Aprenderá un objeto o cosa específica presentada en las imágenes de capacitación.

Ejemplo de entrenamiento de estilo:

Configuración

Instale todas las dependencias utilizando

pip install -r requirements.txt

Entonces simplemente puedes ejecutar:

python main.py train_configs/training_args.json para comenzar un trabajo de capacitación.

Ajuste los argumentos dentro de training_args.json para configurar un trabajo de capacitación personalizado.

También puede ejecutar esto a través de replicidad usando COG (~ Imagen Docker):

- Instale replicar 'COG':

sudo curl -o /usr/local/bin/cog -L "https://github.com/replicate/cog/releases/latest/download/cog_$(uname -s)_$(uname -m)"

sudo chmod +x /usr/local/bin/cog

- Construya la imagen con

cog build - Ejecute una ejecución de entrenamiento con

sh cog_test_train.sh - También puede entrar en el contenedor con

cog run /bin/bash

Finetuning completo de unlo

Al ejecutar este entrenador en Native Python, también puede realizar un fino de unlo completo usando algo como (ajuste a sus necesidades) python main.py train_configs/full_finetuning_example.json

TODO's

Insectos:

- La inversión textual pura para SD15 no parece funcionar bien ... (pero funciona increíblemente bien para SDXL ...) ---> ¡Si alguien puede resolver este, estaría siempre agradecido!

- Averigüe por qué el entrenamiento es 3x más lento a través del nodo Comfyui versus solo ejecutar main.py como un trabajo de Python ...?

- FIJO DESPECT_RATIO BUSTET en el DataLoader (ver https://github.com/kohya-ss/sd-scripts)

Mejoras mayores:

- Integrar Flux / SD3

- Agregue el entrenamiento de concepto múltiple (múltiples cosas representadas por múltiples tokens, entrenados en una sola lora)

- Agregue una regularización de token más fuerte (por ejemplo, base de celebraciones de celebridades)

- Implementar ideas de perfusión (bloqueo clave con superclase): https://research.nvidia.com/labs/par/perfusion/

- Implementar el indicador: alineado: https://prompt-aligned.github.io/