Trainer

Dieser Trainer wurde vom Eden -Team entwickelt. Sie können unsere gehostete Version des Trainers in unserer App ausprobieren. Es ist ein hochoptimierter Trainer, der sowohl für die vollständige Finetuning- als auch für das Training von Lora -Modulen auf der stabilen Diffusion verwendet werden kann. Es verwendet ein einzelnes Trainingsskript und ein Verlustmodul, das sowohl für SDV15 als auch für SDXL funktioniert!

Die Ausgänge dieses Trainers sind vollständig mit Comfyui und Auto111 kompatibel, siehe Dokumentation HIER. In unseren Dokumenten finden Sie eine vollständige Anleitung zum Training.

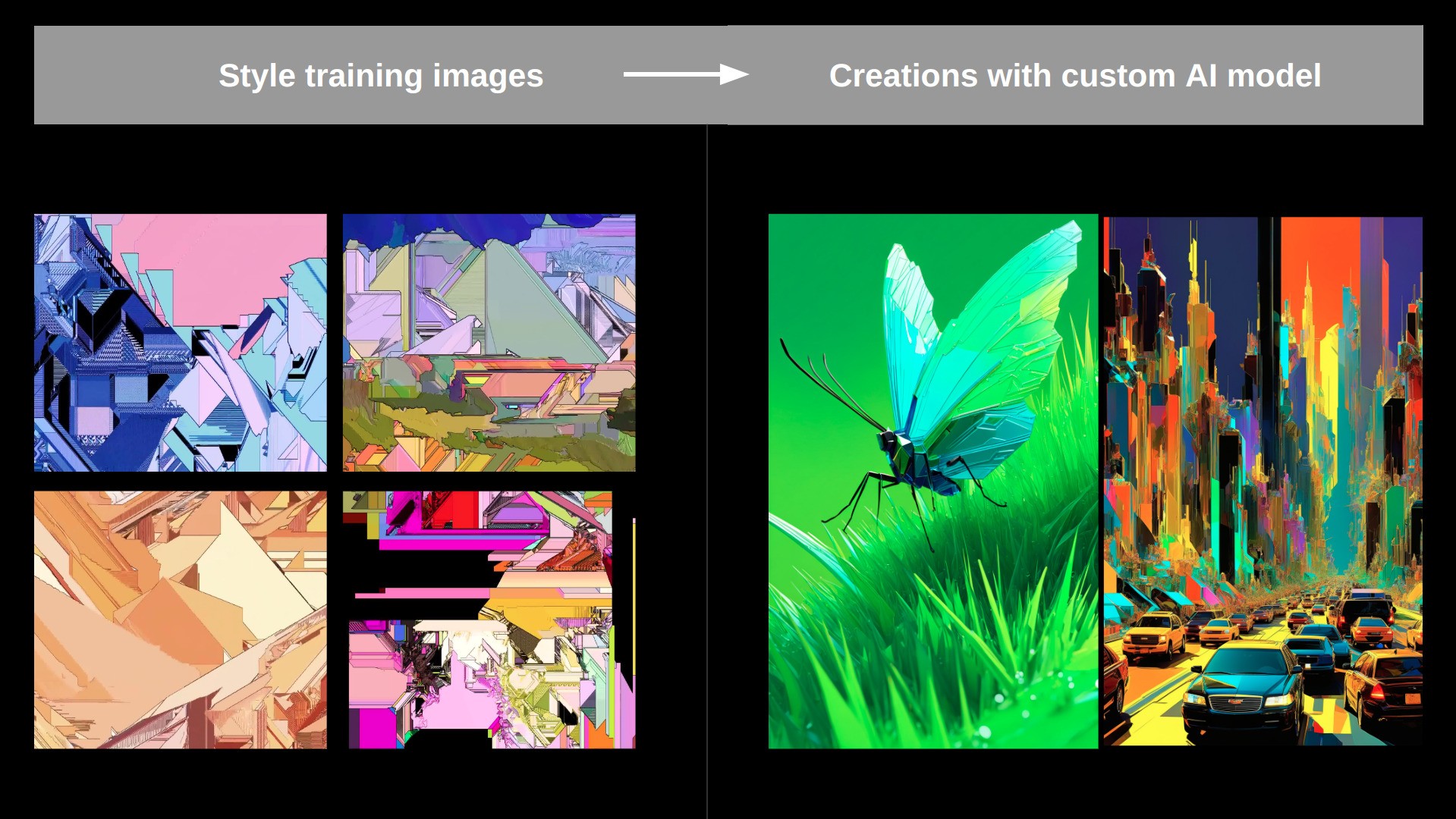

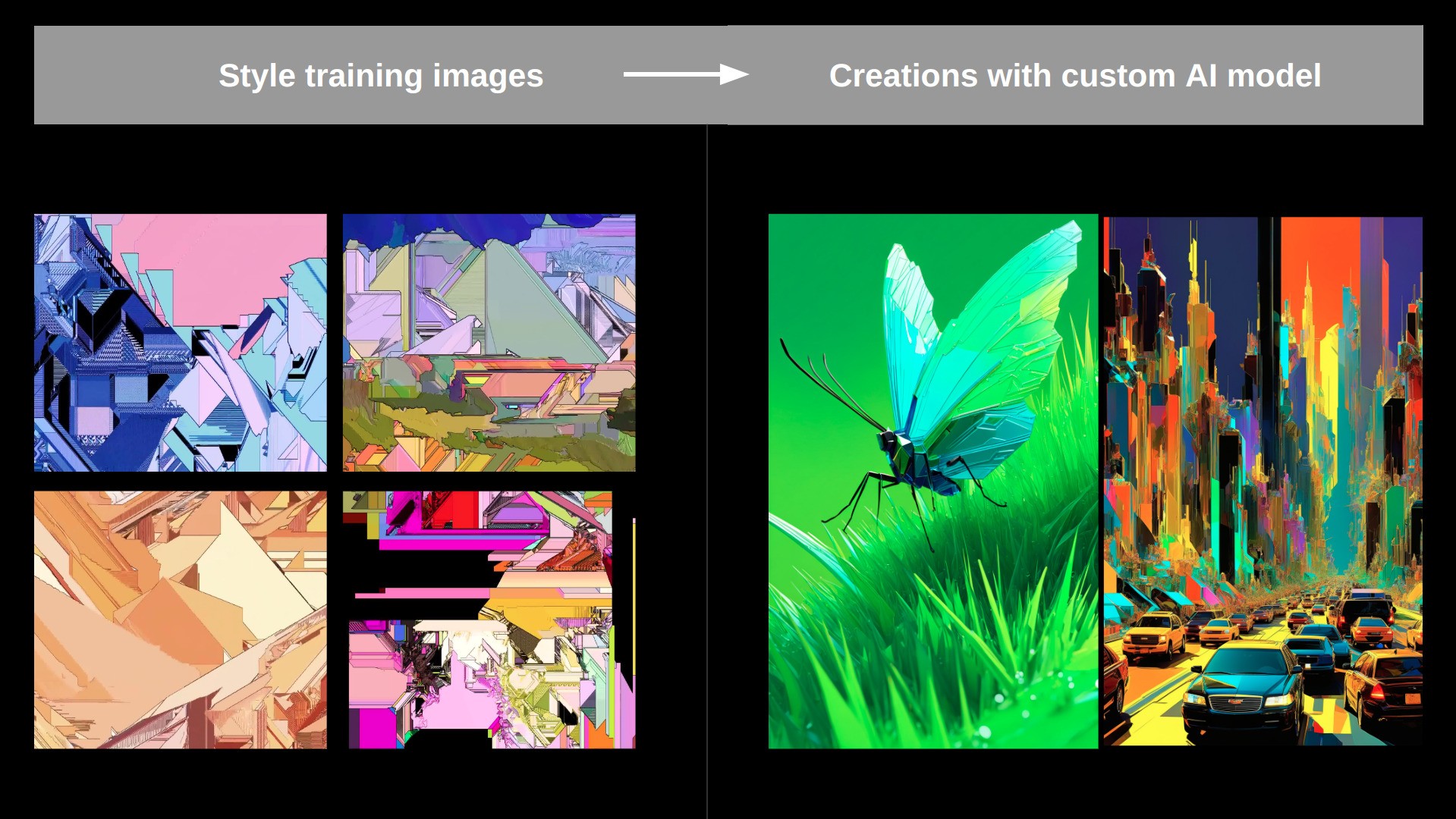

Trainingsbilder:

Erzeugt IMGs mit ausgebildeter Lora:

Der Trainer kann auf 4 verschiedene Arten betrieben werden:

- Als gehosteter Service auf unserer Website

- als gehostete Dienst durch Replikat

- Als bequemer Knoten

- Als eigenständiges Python -Skript

Verwenden in bequemer:

- Beispiel -Workflows für den Betrieb des Trainers und die Schlussfolgerung mit ihm finden Sie in

/ComfyUI_workflows - Wichtig ist, dass dieser Trainer einen Chatgpt-Anruf verwendet, um die automatisch generierten Eingabeaufforderungen zu bereinigen und das trainierbare Token zu injizieren. Dies funktioniert nur, wenn Sie eine .EnV-Datei haben. Die Datei im OpenAI-Taste in der Stammwinkel des Repo-Dire, das eine einzelne Zeile enthält:

OPENAI_API_KEY=your_key_string funktioniert ohne diese.

Der Trainer unterstützt 3 Standardmodi:

- Stil : Wird zum Erlernen des ästhetischen Stils einer Sammlung von Bildern verwendet.

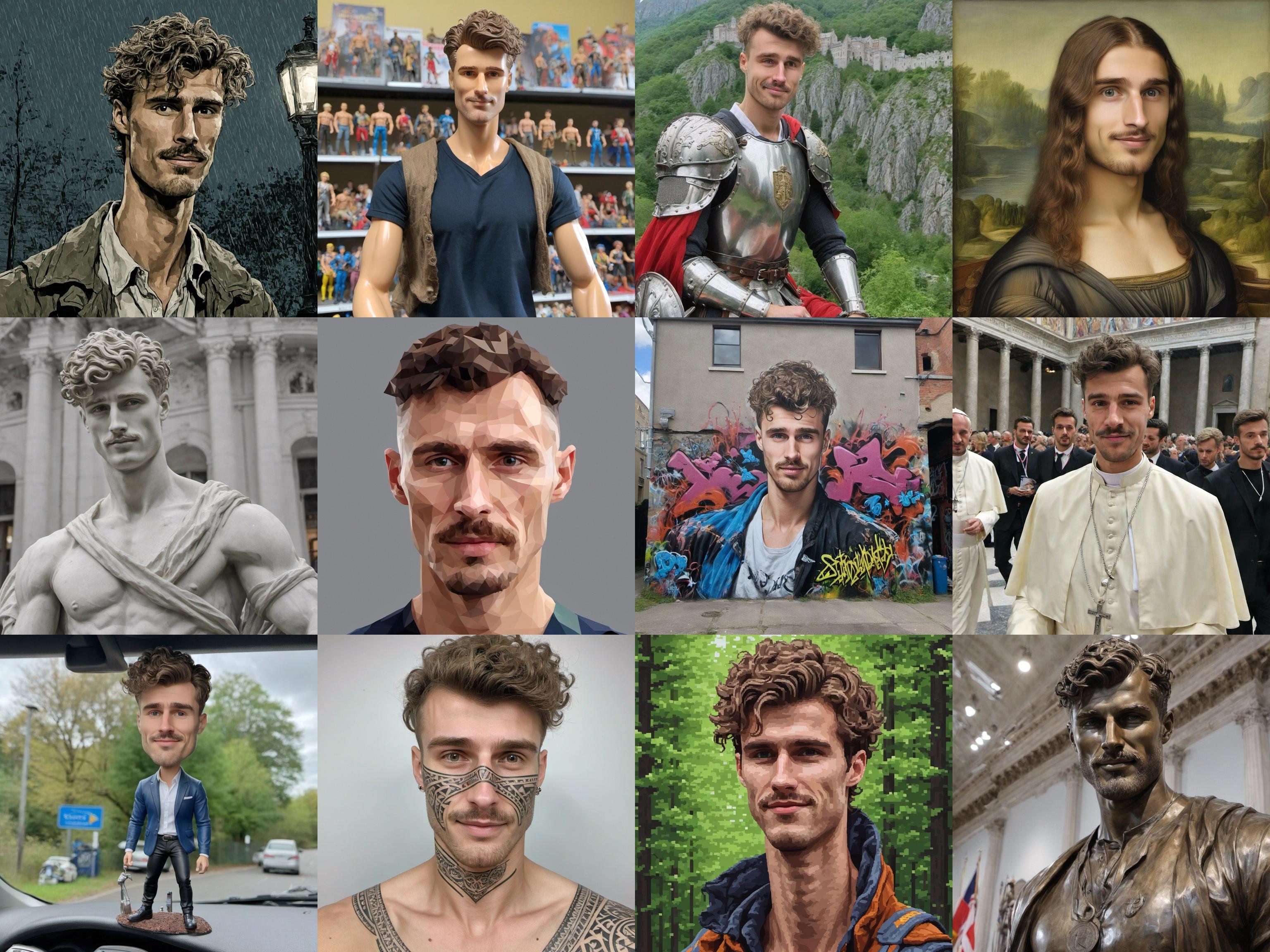

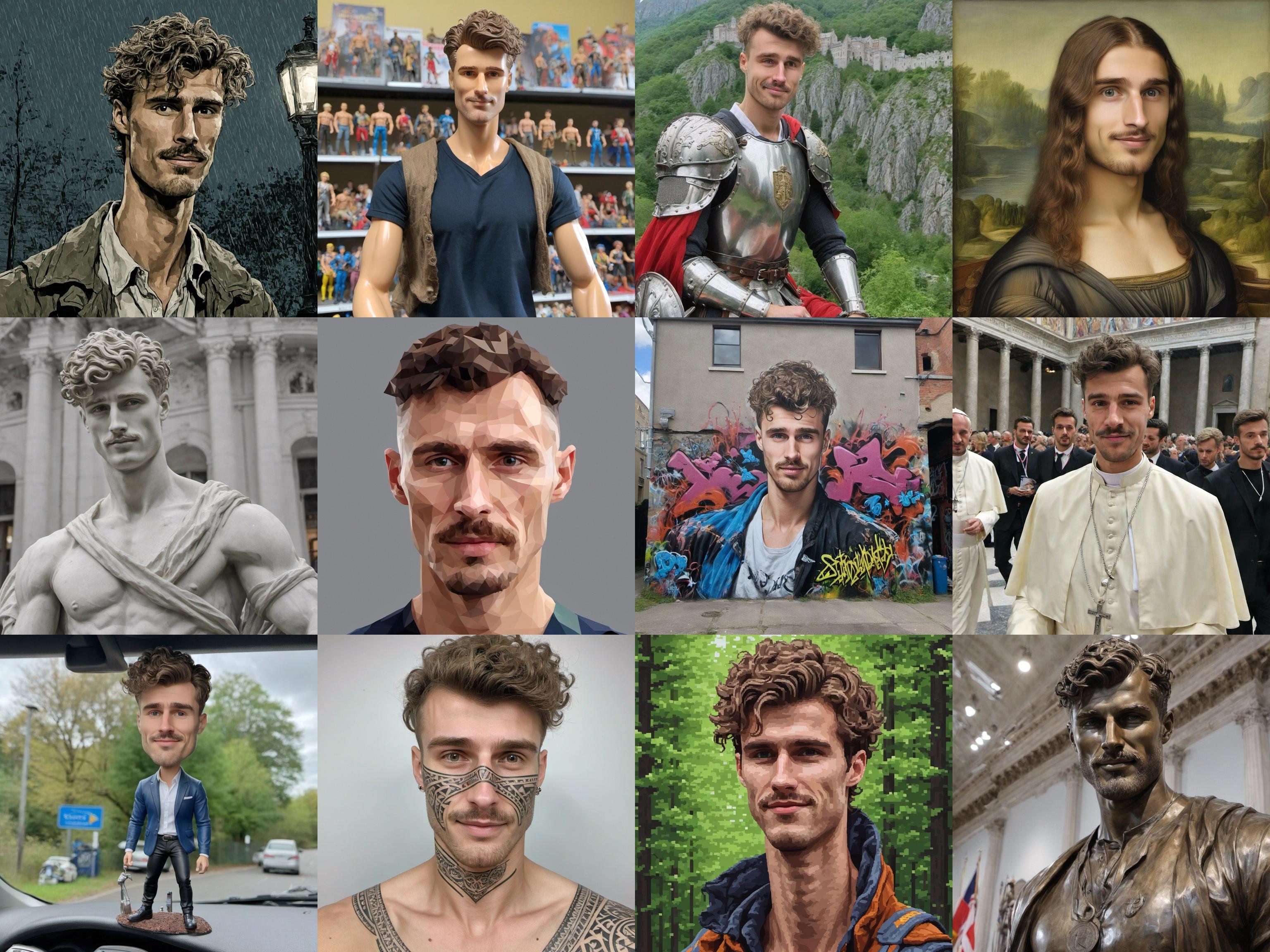

- Gesicht : verwendet zum Lernen eines bestimmten Gesichts (kann menschlich sein, Charakter, ...).

- Objekt : Lernt ein bestimmtes Objekt oder eine Sache, die in den Trainingsbildern vorgestellt wird.

Beispiel für Stiltrainings: Beispiel:

Aufstellen

Installieren Sie alle Abhängigkeiten mithilfe

pip install -r requirements.txt

Dann können Sie einfach rennen:

python main.py train_configs/training_args.json um einen Trainingsjob zu beginnen.

Passen Sie die Argumente in training_args.json an, um einen benutzerdefinierten Schulungsjob einzurichten.

Sie können dies auch über Replikat mit COG (~ Docker -Bild) ausführen:

- Replikat 'COG' installieren:

sudo curl -o /usr/local/bin/cog -L "https://github.com/replicate/cog/releases/latest/download/cog_$(uname -s)_$(uname -m)"

sudo chmod +x /usr/local/bin/cog

- Erstellen Sie das Bild mit

cog build - Führen Sie einen Trainingslauf mit

sh cog_test_train.sh aus - Sie können auch mit

cog run /bin/bash in den Behälter gehen

Vollständige Unet -Finetuning

Wenn Sie diesen Trainer in nativem Python laufen lassen, können Sie auch die vollständige Unet -Finetuning mit etwas wie (Anpassung an Ihre Anforderungen) python main.py train_configs/full_finetuning_example.json durchführen

Todo's

Fehler:

- Reine Textinversion für SD15 scheint nicht gut zu funktionieren ... (aber es funktioniert erstaunlich gut für SDXL ...) ---> Wenn jemand diesen herausfinden kann, wäre ich für immer dankbar!

- Finden Sie heraus, warum das Training 3x langsamer durch den bequemen Knoten ist und einfach Main.Py als Python -Job ausführt.

- Fix Aspekt_ratio Bucketing im Dataloader (siehe https://github.com/kohya-sss/sd-scripts)

Größere Verbesserungen:

- Flux / SD3 integrieren

- Fügen Sie ein Multi-Konzept-Training hinzu (mehrere Dinge, die durch mehrere Token dargestellt werden, in einer einzigen Lora ausgebildet)

- Fügen Sie eine stärkere Token -Regularisierung hinzu (zB Celebbasis Spanning Basis)

- Perfusionsideen implementieren (Schlüsselsperrung mit SuperClass): https://research.nvidia.com/labs/par/perfusion/

- Implementieren