Entraîneur

Cet entraîneur a été développé par l'équipe Eden , vous pouvez essayer notre version hébergée du formateur dans notre application . Il s'agit d'un entraîneur hautement optimisé qui peut être utilisé pour les modules de Finetuning et d'entraînement complets LORA en plus de diffusion stable. Il utilise un seul script d'entraînement et un module de perte qui fonctionne à la fois pour SDV15 et SDXL !

Les sorties de cet entraîneur sont entièrement compatibles avec Comfyui et Auto111, voir la documentation ici. Un guide complet sur la formation peut être trouvé dans nos documents .

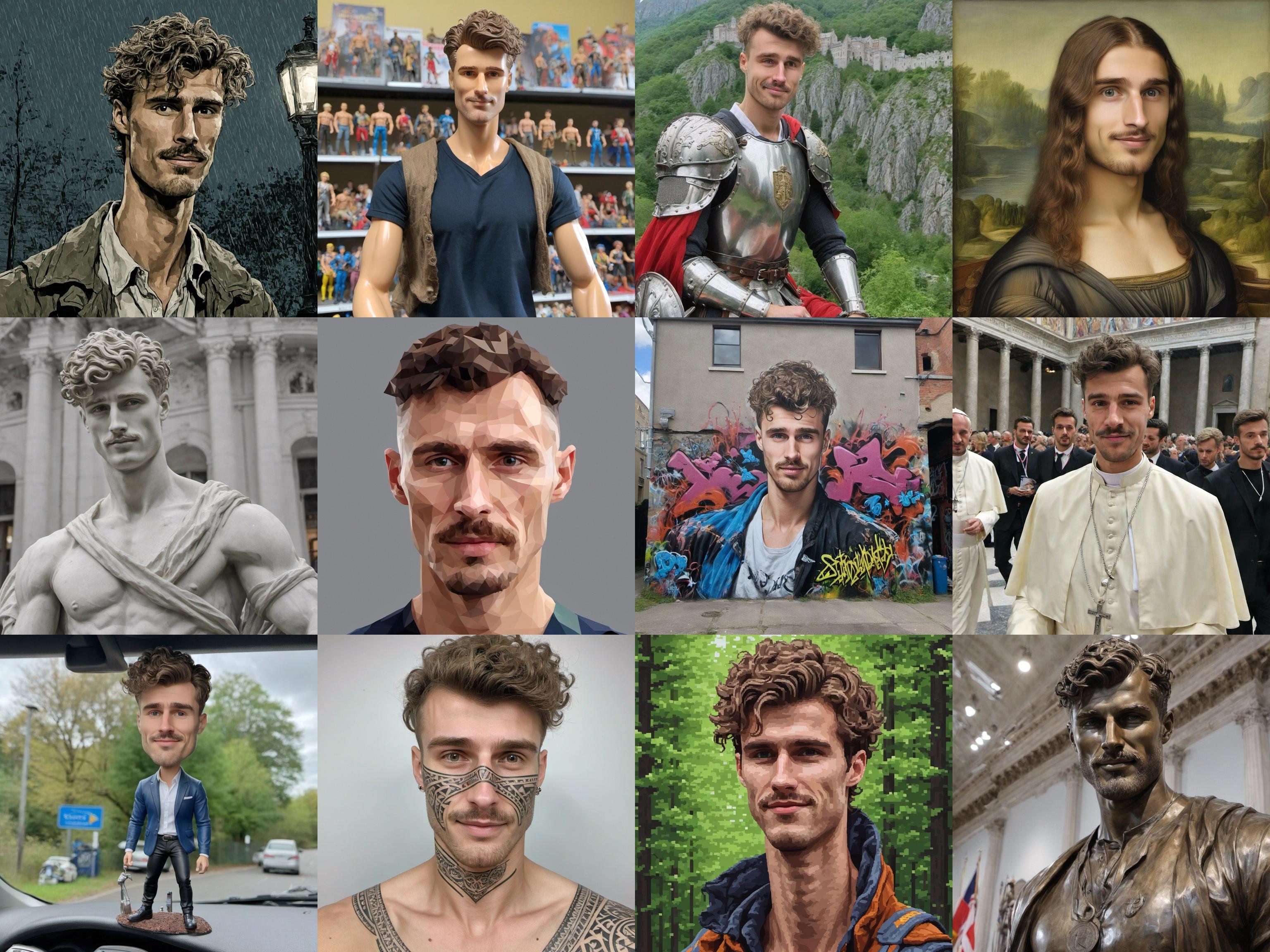

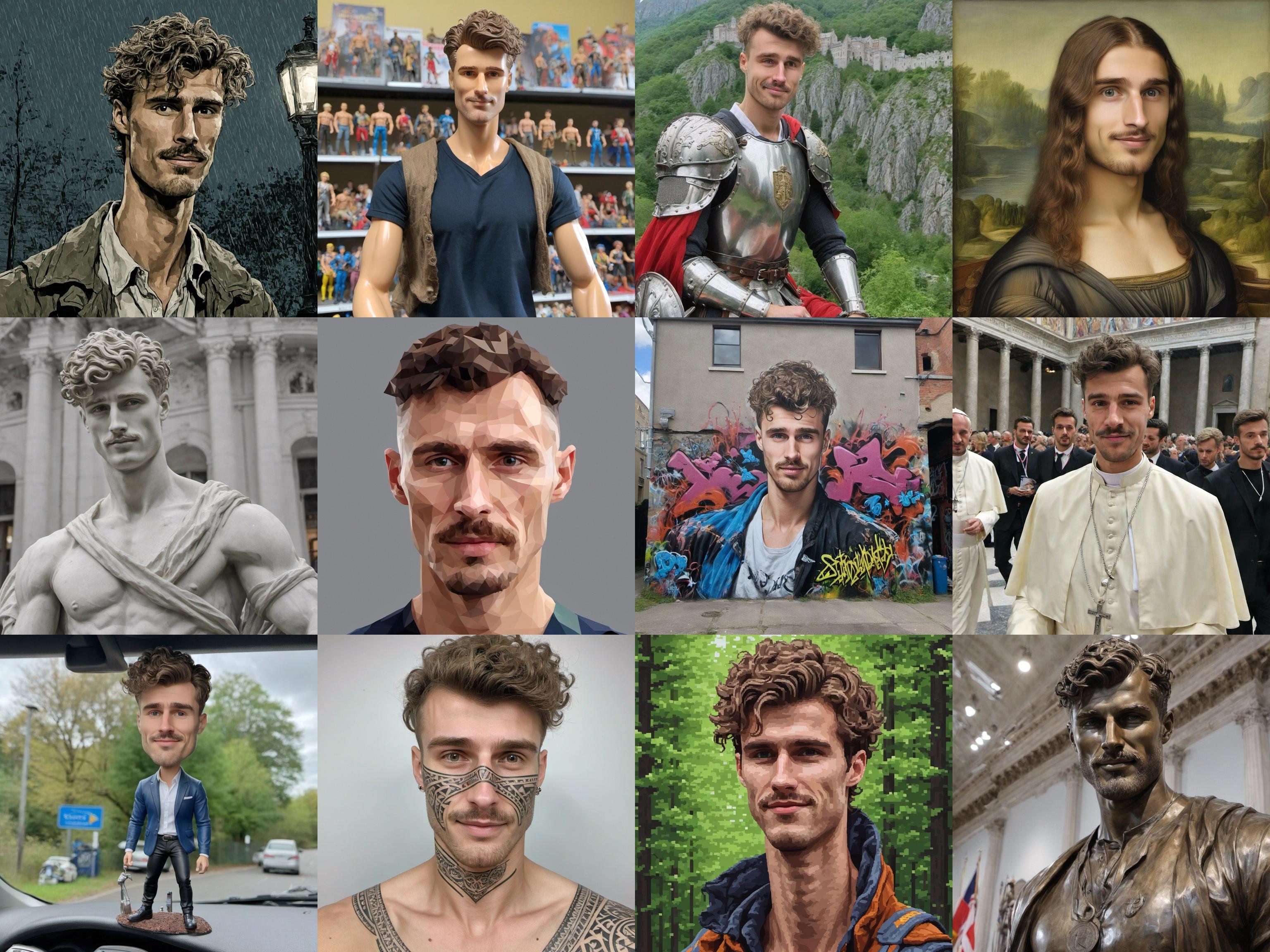

Images de formation:

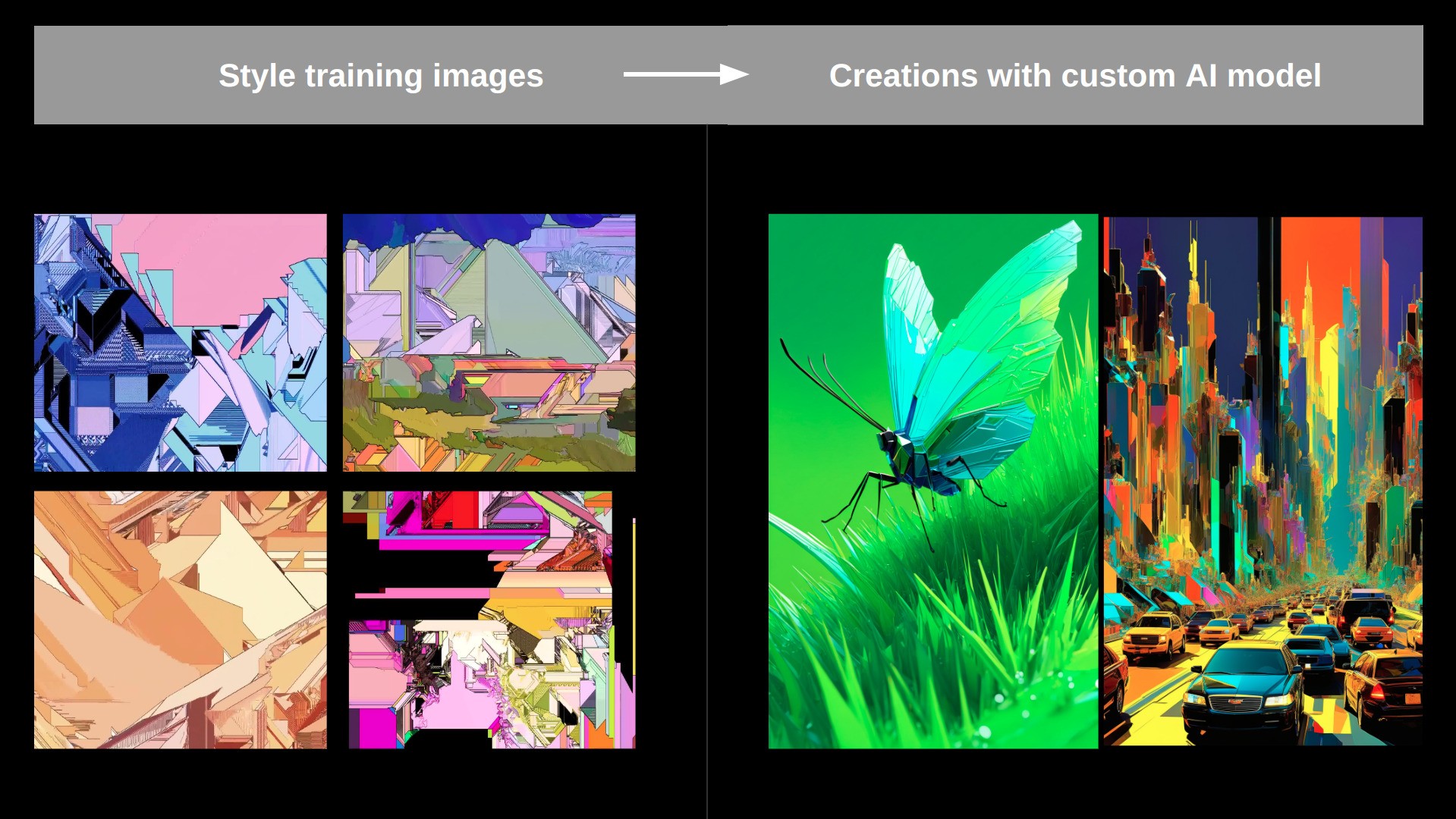

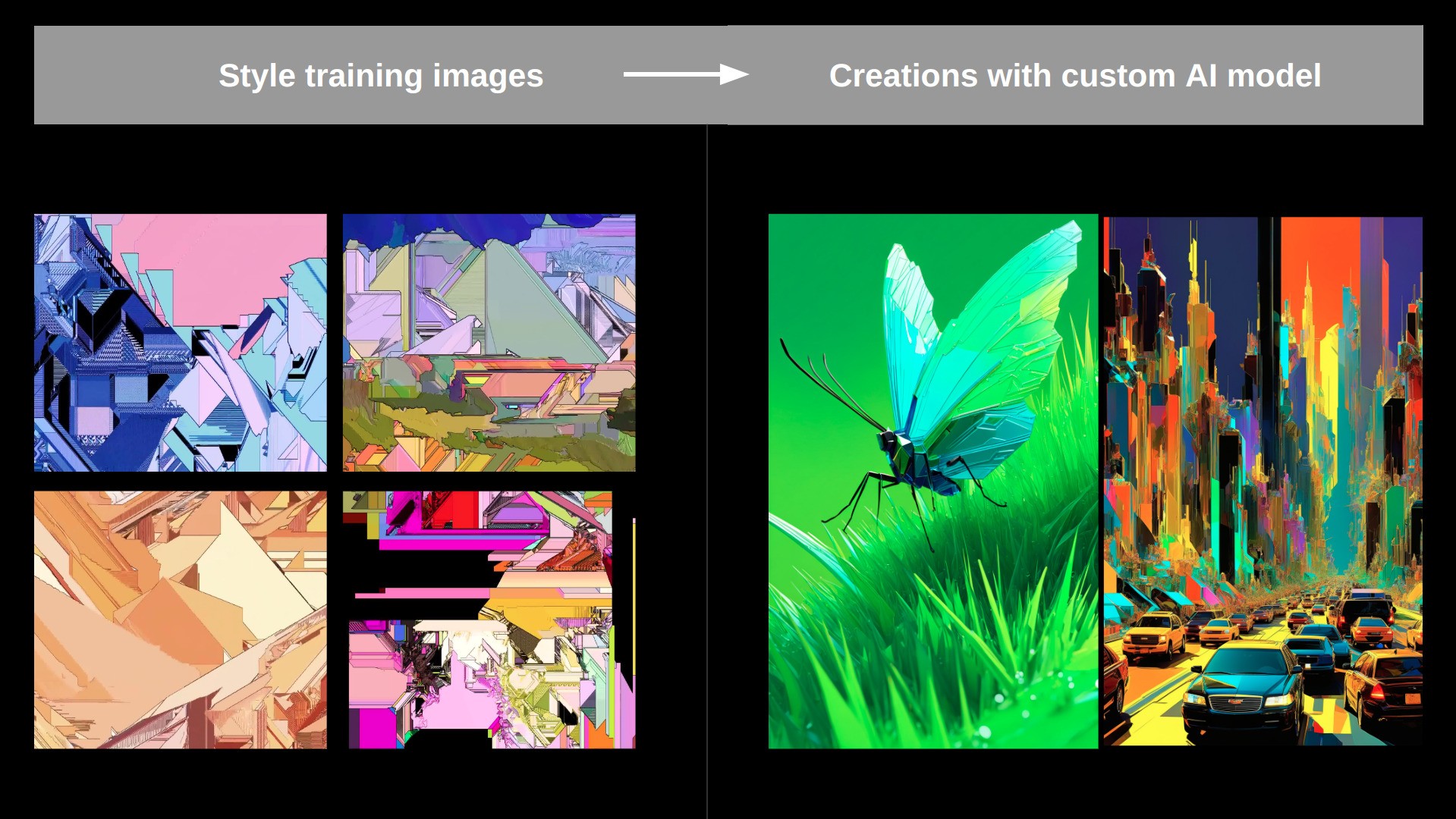

IMG généré avec Lora formé:

L'entraîneur peut être exécuté de 4 manières différentes:

- En tant que service hébergé sur notre site Web

- En tant que service hébergé via la réplique

- En tant que nœud comfyui

- En tant que script Python autonome

Utilisation dans Comfyui:

- Exemple de workflows pour savoir comment gérer le formateur et faire en conférence avec celui-ci peut être trouvé dans

/ComfyUI_workflows - Surtout, ce formateur utilise un appel ChatGpt pour nettoyer les invites générées par automatique et injecter le jeton entraînable, cela ne fonctionnera que si vous avez un fichier .env contenant votre clé Openai dans la racine du référentiel qui contient une seule ligne:

OPENAI_API_KEY=your_key_string tout fonctionnera sans cela, mais les résultats seront meilleurs si vous définissez ceci, en particulier pour les modes de «Face» et «Face» et «Face» et ».

Le formateur prend en charge 3 modes par défaut:

- Style : Utilisé pour apprendre le style esthétique d'une collection d'images.

- Face : utilisé pour apprendre un visage spécifique (peut être humain, caractère, ...).

- Objet : Apprendra un objet ou une chose spécifique présenté dans les images d'entraînement.

Exemple de formation du style:

Installation

Installez toutes les dépendances en utilisant

pip install -r requirements.txt

Ensuite, vous pouvez simplement courir:

python main.py train_configs/training_args.json pour démarrer un travail de formation.

Ajustez les arguments à l'intérieur training_args.json pour configurer un travail de formation personnalisé.

Vous pouvez également exécuter ceci via la réplique à l'aide de COG (~ Docker Image):

- Installez le «rouage» répliqué:

sudo curl -o /usr/local/bin/cog -L "https://github.com/replicate/cog/releases/latest/download/cog_$(uname -s)_$(uname -m)"

sudo chmod +x /usr/local/bin/cog

- Construisez l'image avec

cog build - Exécutez une course d'entraînement avec

sh cog_test_train.sh - Vous pouvez également entrer dans le conteneur avec

cog run /bin/bash

Finetuning complet non

Lorsque vous dirigez cet entraîneur dans le python natif, vous pouvez également effectuer une finetun de Full Unet en utilisant quelque chose comme (ajustez à vos besoins) python main.py train_configs/full_finetuning_example.json

Todo

Insectes:

- L'inversion textuelle pure pour SD15 ne semble pas bien fonctionner ... (mais cela fonctionne incroyablement bien pour SDXL ...) ---> Si quelqu'un peut comprendre celui-ci, je serais éternellement reconnaissant!

- Déterminez pourquoi la formation est 3X plus lent via le nœud Comfyui par rapport à exécuter Main.py en tant que travail python ..?

- Fix Aspect_Ratio Backet dans le DatalOader (voir https://github.com/kohya-ss/sd-scripts)

Améliorations plus importantes:

- intégrer le flux / sd3

- Ajouter une formation multi-concept (plusieurs choses représentées par plusieurs jetons, entraînés dans une seule LORA)

- Ajoutez une régularisation des jetons plus forte (par exemple, la base de Celebbasis)

- Implémentation d'idées de perfusion (Verrouillage des clés avec superclasse): https://research.nvidia.com/labs/par/perfusion/

- Implémentation de l'invite: https://prompt-aligned.github.io/