Este projeto é um tutorial sobre modelos de bebês chineses exclusivos para modelos de código aberto, para iniciantes domésticos e baseados em plataformas Linux. Ele fornece orientações de processo completo para vários modelos de código aberto, incluindo configuração ambiental, implantação local, ajuste fino eficiente e outras habilidades, simplificando a implantação, uso e processo de aplicação de modelos de código aberto, permitindo que mais estudantes e pesquisadores comuns usem melhor modelos de código aberto, ajudando os modelos de código aberto e gratuitos a integrar a vida dos alunos comuns.

O principal conteúdo deste projeto inclui:

O principal conteúdo do projeto são os tutoriais, para que mais estudantes e futuros profissionais possam entender e se familiarizar com os métodos de comer grandes modelos de código aberto! Qualquer pessoa pode propor um problema ou enviar um PR para construir e manter em conjunto esse projeto.

Os alunos que desejam participar profundamente podem entrar em contato conosco e o adicionaremos ao mantenedor do projeto.

Sugestões de aprendizado: as sugestões de aprendizado para este projeto são primeiro aprender a configuração do ambiente, depois aprender a implantação e uso do modelo e, finalmente, aprender o ajuste fino. Como a configuração do ambiente é a base, a implantação e o uso do modelo são a base e o ajuste fino é avançado. Os iniciantes podem escolher QWEN1.5, InternLM2, Minicpm e outros modelos para priorizar o aprendizado.

NOTA: Se os alunos quiserem entender a composição do modelo do grande modelo e escrever tarefas como RAG, agente e avaliar do zero, poderão aprender outro projeto de Datawhale. O Big Model é um tópico quente no campo do aprendizado profundo atualmente, mas a maioria dos grandes tutoriais de modelos existentes é apenas para ensiná -lo a chamar APIs para concluir a aplicação de grandes modelos, e poucas pessoas podem explicar a estrutura do modelo, rag, agente e avaliação do nível de princípio. Portanto, o repositório fornecerá toda a caligrafia e não usará a forma de chamar a API para concluir as tarefas de RAG, agente e avaliação do grande modelo.

NOTA: Considerando que alguns alunos esperam aprender a parte teórica do grande modelo antes de estudar este projeto, se quiserem estudar ainda mais a base teórica do LLM e entender e aplicar melhor o LLM com base na teoria, eles podem se referir ao curso So-Large-Llm de Datawhale.

NOTA: Se algum aluno quiser desenvolver grandes aplicativos de modelo sozinho depois de estudar este curso. Os alunos podem se referir ao curso prático de desenvolvimento de aplicativos de Big Model da Datawhale, que é um grande tutorial de desenvolvimento de aplicativos de modelo para iniciantes. O objetivo é apresentar totalmente o grande processo de desenvolvimento de aplicativos de modelo aos alunos com base no servidor de nuvem do Alibaba e combinado com projetos de assistente de base de conhecimento pessoal.

O que é um grande modelo?

Modelo grande (LLM) refere -se a modelos de processamento de linguagem natural (PNL) treinos treinados com base em algoritmos de aprendizado profundo. Eles são usados principalmente em campos, como compreensão e geração da linguagem natural. Em um sentido amplo, eles também incluem modelos grandes de visão de máquina (CV), modelos grandes multimodais e modelos grandes de computação científica.

A batalha de centenas de modelos está em pleno andamento, e os LLMs de código aberto estão surgindo um após o outro. Atualmente, muitos excelentes LLMs de código aberto surgiram em casa e no exterior, como lhama e alpaca, e internamente, como Chatglm, Baichuan, Internlm (Scholar PUYU), etc. Open Source LLM suporta a implantação local de usuários e a ajuste fina de domínios privados. Todos podem criar seu próprio modelo exclusivo com base no Open Source LLM.

No entanto, se estudantes e usuários comuns desejarem usar esses grandes modelos, eles precisam ter certos recursos técnicos para concluir a implantação e o uso dos modelos. Para LLMs de código aberto que estão surgindo um após o outro, é uma tarefa relativamente desafiadora dominar rapidamente os métodos de aplicação do Open Source LLM.

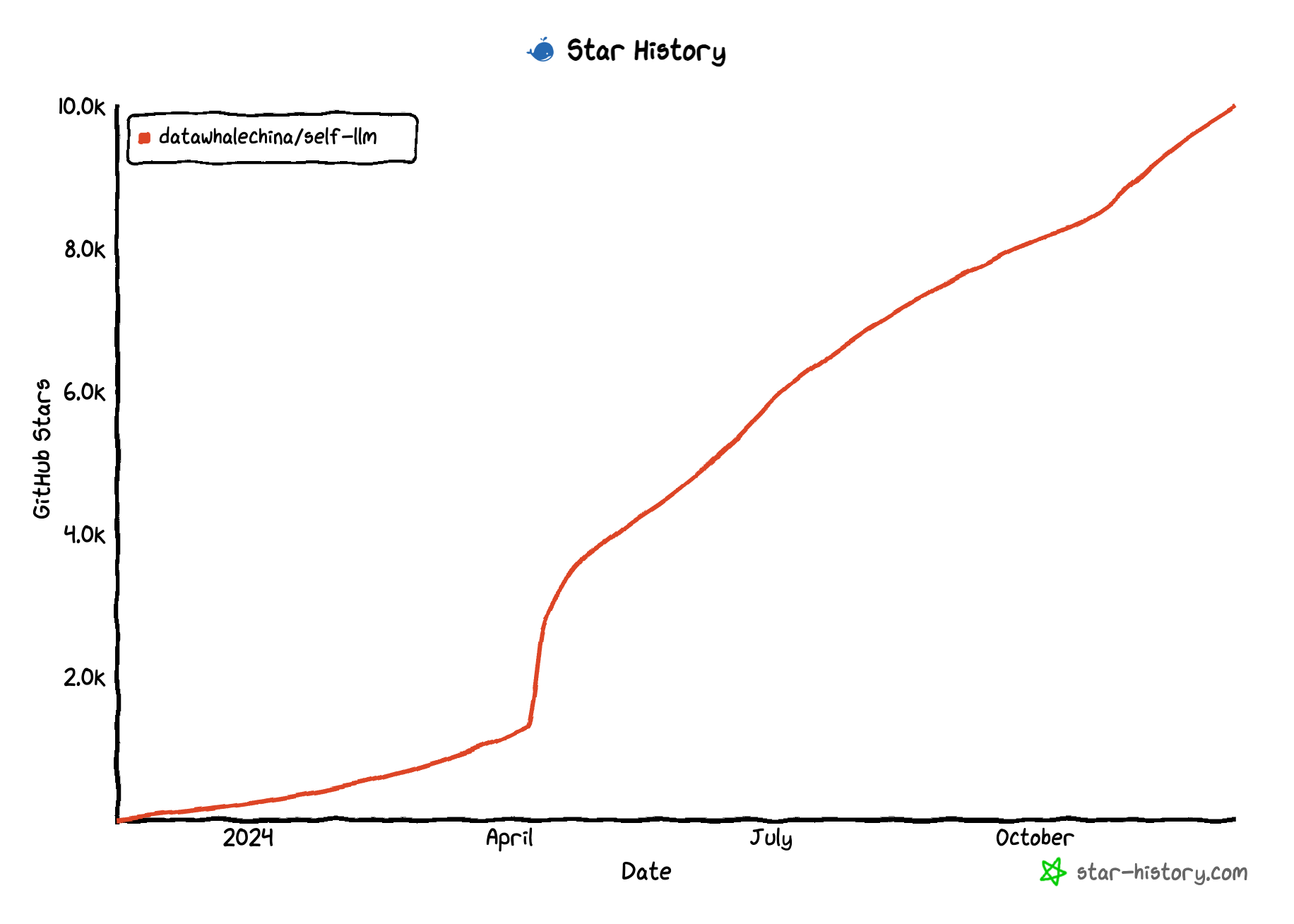

Este projeto pretende primeiro realizar os tutoriais de implantação, uso e ajuste fino do mainstream Open Source LLM em casa e no exterior com base na experiência dos principais contribuintes; Depois de realizar as partes relevantes do Mainstream LLM, esperamos reunir completamente os co-criadores para enriquecer este mundo do Open Source LLM e criar tutoriais cada vez mais abrangentes para o Special LLMS. Faíscas pontilhadas, convergindo para o mar.

Esperamos ser a escada do LLM e do público em geral e abraçar o mundo mais magnífico e vasto com o espírito de código aberto de liberdade e igualdade.

Este projeto é adequado para os seguintes alunos:

Este projeto planeja organizar todo o processo de aplicação de código aberto LLM, incluindo configuração e uso ambiental, implantação e aplicação, ajuste fino etc. Cada peça cobre o mainstream e apresenta LLM de código aberto:

Chat-huanhuan: Chat-Zhen Huan é um modelo de idioma de bate-papo que imita o tom de Zhen Huan usando todas as linhas e frases sobre Zhen Huan no roteiro "The Legend of Zhen Huan" e ajuste fino com base no LLM.

Tianji: Tianji é um cenário social baseado em sentimentos humanos e estilos mundanos, abrangendo todo o processo de engenharia imediata de palavras, produção corporal inteligente, aquisição de dados e modelo de ajuste fino, limpeza e uso de dados de trapos, etc.

QWEN2.5-Coder

QWEN2-VL

Qwen2.5

Apple OpenElm

LLAMA3_1-8B-INSTRUTA

Gemma-2-9b-it

Yuan2.0

Yuan2.0-m32

Deepseek-Coder-V2

Bilibili Index-1.9b

Qwen2

GLM-4

Qwen 1.5

Google - Gemma

Phi-3

Caracterlm-6b

LLAMA3-8B-INSTRUTA

Xverse-7b-bats

Transnormerllm

Modelo de coração azul bluelm vivo

InternLM2

Pesquisa profunda profunda

Minicpm

Qwen-Audio

Qwen

Mil coisas

Baichuan inteligente

Internlm

Atom (llama2)

Chatglm3

pip, conda alteração fonte @ não tem cebola, gengibre, alho

Autodl Open Port @Don't Spicy Ginger and Garlic

Download do modelo

Edição && pr

Nota: as classificações são classificadas por nível de contribuição