このプロジェクトは、オープンソースモデル、国内の初心者向け、Linuxプラットフォームに基づくオープンソースモデル向けの排他的な中国のベビーモデルに関するチュートリアルです。環境構成、ローカル展開、効率的な微調整、その他のスキルなど、さまざまなオープンソースモデルにフルプロセスガイダンスを提供し、オープンソースモデルの展開、使用、およびアプリケーションプロセスを簡素化し、通常の学生や研究者がオープンソースモデルをより適切に使用できるようになり、オープンソースモデルとフリーモデルが普通の学習者の生活をより速く統合できるようにします。

このプロジェクトの主な内容は次のとおりです。

プロジェクトの主な内容はチュートリアルです。そのため、より多くの学生と将来の開業医が、オープンソースの大きなモデルを食べる方法を理解し、慣れることができます。誰でも問題を提案するか、PRを提出して、このプロジェクトを共同で構築および維持することができます。

深く参加したい学生は私たちに連絡することができ、私たちはあなたをプロジェクトメンテナーに追加します。

学習の提案:このプロジェクトの学習提案は、最初に環境構成を学び、次にモデルの展開と使用を学び、最後に微調整を学ぶことです。環境構成は基礎であるため、モデルの展開と使用が基礎となり、微調整が高度になります。初心者は、学習に優先順位を付けるために、QWEN1.5、INTERNLM2、MINICPM、その他のモデルを選択できます。

注:学生が大きなモデルのモデル構成を理解し、RAG、エージェント、評価などのタスクをゼロから書きたい場合、DataWhaleの別のプロジェクトを学ぶことができます。 Big Modelは現在、深い学習の分野でホットなトピックですが、既存の大きなモデルのチュートリアルのほとんどは、APIを呼び出して大きなモデルのアプリケーションを完了する方法を教えることであり、原則レベルからモデル構造、RAG、エージェント、評価を説明できる人はほとんどいません。したがって、リポジトリはすべての手書きを提供し、APIを呼び出す形式を使用して、大きなモデルのRAG、エージェント、および評価タスクを完了しません。

注:一部の学生は、このプロジェクトを研究する前に大きなモデルの理論的部分を学びたいと考えていることを考慮して、LLMの理論的基礎をさらに研究し、理論に基づいてLLMをさらに理解し、適用することを望みます。

注:このコースを勉強した後、学生が自分で大規模なモデルアプリケーションを開発したい場合。学生は、初心者向けの大規模なモデルアプリケーション開発チュートリアルであるDatawhaleの実践的なビッグモデルアプリケーション開発コースを参照できます。 Alibaba Cloud Serverに基づいて、個人の知識ベースのアシスタントプロジェクトと組み合わされた、大きなモデルアプリケーション開発プロセスを学生に完全に提示することを目指しています。

大きなモデルとは何ですか?

大規模モデル(LLM)は、ディープラーニングアルゴリズムに基づいてトレーニングされた自然言語処理(NLP)モデルを狭く指します。それらは主に自然言語の理解や生成などの分野で使用されています。広い意味では、マシンビジョン(CV)の大規模モデル、マルチモーダル大規模モデル、科学的コンピューティング大規模モデルも含まれています。

何百ものモデルの戦いが本格的であり、オープンソースLLMは次々と出現しています。今日、LlamaやAlpacaなどの多くの優れたオープンソースLLMが自宅と海外で出現しており、Chatglm、Baichuan、Internlm(Scholar Puyu)などの国内では、オープンソースLLMは、ユーザーのローカル展開とプライベートドメインの微調整をサポートしています。誰もがオープンソースLLMに基づいて独自のビッグモデルを作成できます。

ただし、普通の学生とユーザーがこれらの大きなモデルを使用したい場合は、モデルの展開と使用を完了するために特定の技術的能力を持つ必要があります。次々と出現しているオープンソースLLMの場合、オープンソースLLMのアプリケーション方法をすばやく習得することは比較的困難なタスクです。

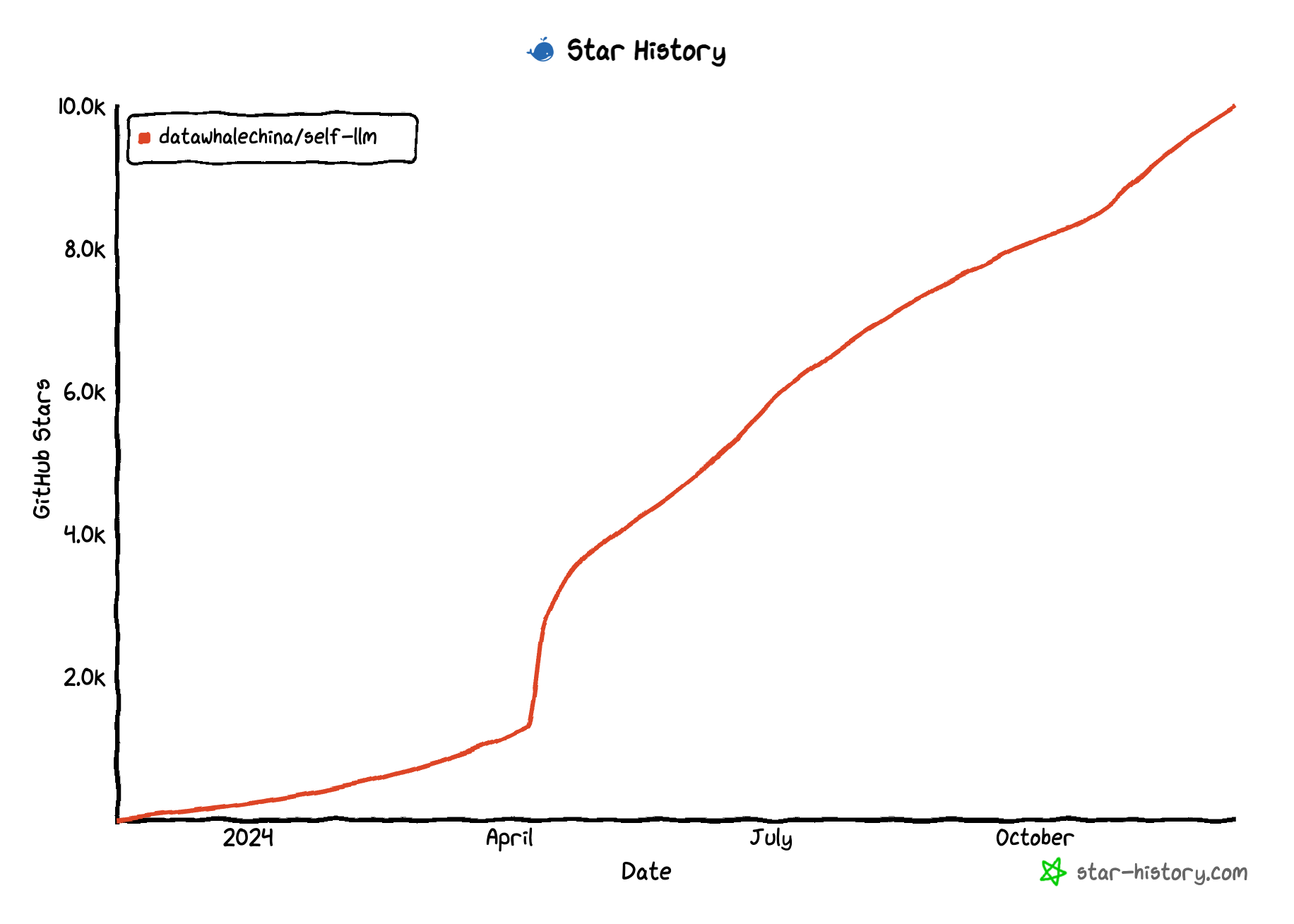

このプロジェクトの目的は、コア貢献者の経験に基づいて、自宅および海外での主流のオープンソースLLMの展開、使用、微調整チュートリアルを最初に実現することを目的としています。メインストリームLLMの関連部分を実現した後、共同作成者を完全に集めて、このオープンソースLLMの世界を豊かにし、特別なLLMの包括的なチュートリアルを作成したいと考えています。海に収束するスパークスが点在します。

私たちは、LLMと一般大衆のはしごになり、自由と平等のオープンソースの精神で、より壮大で広大なLLMの世界を受け入れたいと考えています。

このプロジェクトは、次の学習者に適しています。

このプロジェクトは、環境構成と使用、展開とアプリケーション、微調整などを含む、オープンソースLLMアプリケーションのプロセス全体を整理する予定です。各部品は主流をカバーし、オープンソースLLMを備えています。

Chat-huanhuan:Chat-Zhen Huanは、脚本「The Legend of Zhen Huan」とLLMに基づく微調整のすべてのラインと文を使用して、Zhen Huanのトーンを模倣するチャット言語モデルです。

Tianji:Tianjiは、人間の感情と世俗的なスタイルに基づいた社会的シナリオであり、迅速な単語工学、インテリジェントボディの生産、データ収集、モデルの微調整、RAGデータのクリーニングと使用などのプロセス全体をカバーしています。

QWEN2.5-CODER

QWEN2-VL

QWEN2.5

Apple Openelm

llama3_1-8b-instruct

gemma-2-9b-it

yuan2.0

Yuan2.0-M32

deepseek-coder-v2

Bilibili Index-1.9b

QWEN2

GLM-4

Qwen 1.5

Google-ジェマ

PHI-3

CharpleGLM-6B

llama3-8b-instruct

vesverse-7b-chat

transnormerllm

Bluelm Vivo Blue Heartモデル

internlm2

DeepSeek詳細な検索

Minicpm

qwen-audio

Qwen

1000のこと

Baichuan Intelligent

internlm

アトム(llama2)

chatglm3

ピップ、コンドラチェンジソース @タマネギ、生inger、ニンニクはありません

autodl openポート @スパイシーな生ingerとニンニクをしないでください

モデルダウンロード

Issue && pr

注:ランキングは貢献レベルでソートされます