Um pequeno quadro leve, bem -vindo ao Star, se quiser ~ obrigado. Se você encontrar algum problema, também poderá solicitar um problema e terá certeza de responder.

Atualmente, uma versão do treinamento distribuída é reformada. Você pode treinar diretamente multi-GPUs sem comandos adicionais ou código adicional ! Bem -vindo a https://github.com/920232796/bert_seq2seq_ddp para obter mais informações

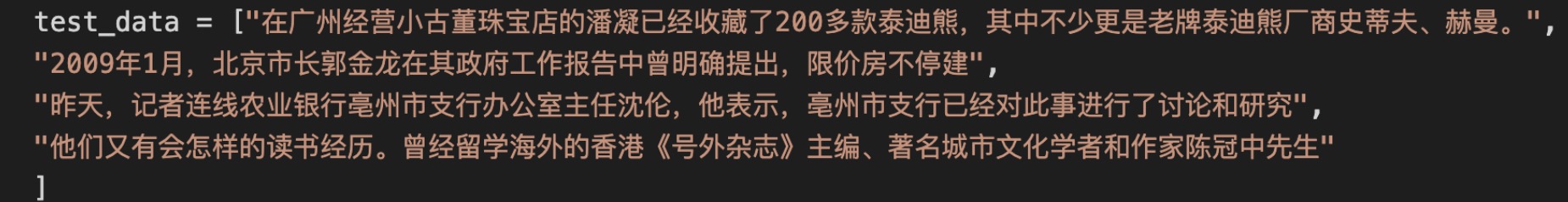

O carregamento de modelos diferentes é alcançado definindo o parâmetro "Model_name" e diferentes tarefas são alcançadas definindo o parâmetro "Model_class". Para detalhes, você pode ver vários exemplos em exemplos.

Alguns dos códigos são referenciados https://github.com/huggingface/transformers/ e https://github.com/bojone/bert4keras muito obrigado! ! !

Bom tempo hoje

, Fui lá para assistir a um filme com meus bebês, foi muito bom! O ambiente não é nada a dizer. O filme é muito requintado e os efeitos sonoros são muito bons. Não sei se esta loja ainda está aberta. Espero que você possa conferir com frequência se tiver tempo.

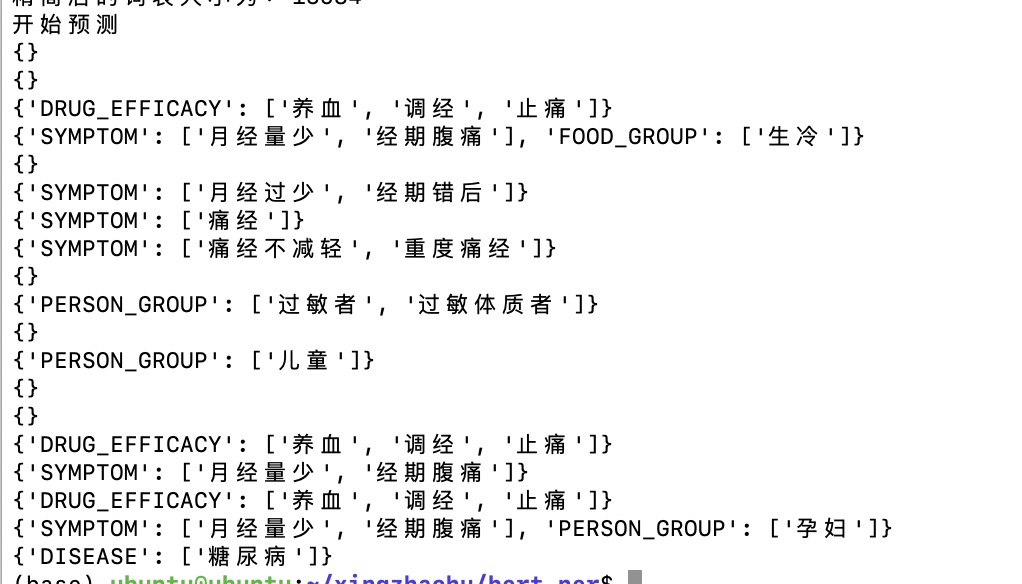

digitar: Saída:

Saída:

Saída:

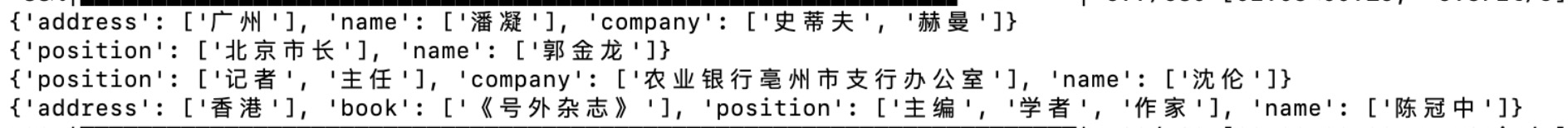

Interações medicamentosas podem ocorrer se usado simultaneamente com outros medicamentos. Consulte seu médico ou farmacêutico para obter detalhes. Leve -o com água fervente, 14 gramas de cada vez, 3 vezes ao dia. Nutre o sangue, regula a menstruação e alivie a dor. É usado para baixo fluxo menstrual, dor abdominal menstrual errada, Jianmin Group Yekai Thai Medicine (Suizhou) Co., Ltd. 1. Evite comer alimentos crus e frios. 2. Pessoas com outras doenças devem levá -lo sob a orientação de um médico. 3. Se você tiver menstruação normal, vá ao hospital para tratamento após uma diminuição repentina na menstruação ou tenha um período de menstruação errado. 4. Para o tratamento da dismenorréia, é aconselhável tomar o remédio 3 a 5 dias antes da menstruação e levá -lo por uma semana. Se houver requisitos de fertilidade, você deve levá -lo sob a orientação de um médico. 5. Aqueles que não aliviam a dismenorreia depois de tomar o remédio ou que têm dismenorreia grave devem ir ao hospital para diagnóstico e tratamento. 6. Se os sintomas não aliviarem depois de tomar o remédio por 2 semanas, você deve ir ao hospital para tratamento. 7. É proibido para aqueles que são alérgicos a este produto e é usado com cautela se você for alérgico ao corpo. 8. É proibido usar quando as características deste produto mudam. 9. Coloque este produto em um local que as crianças não conseguem alcançar. 10. Se você estiver usando outros medicamentos, consulte seu médico ou farmacêutico antes de usar este produto. Este produto é um medicamento sem receita para a menstruação irregular ginecológica. Nutre o sangue, regula a menstruação e alivie a dor. É usado para dor abdominal durante a menstruação. Nutre o sangue, regula a menstruação e alivie a dor. É usado para baixo fluxo menstrual, dor abdominal menstrual errada, 14g*5 sacos de drogas sem receita (classe B), Diretório Nacional de Seguro Médico (Classe B) proibido para mulheres grávidas. Os diabéticos não têm permissão para aceitá -lo.

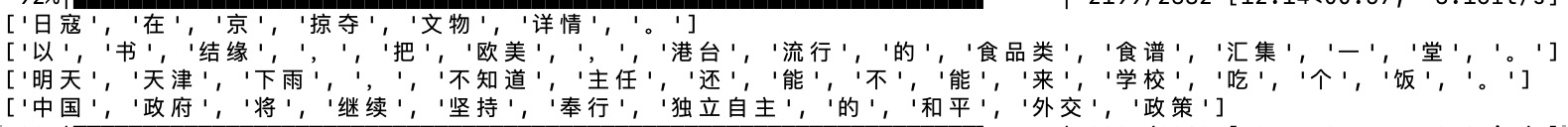

pip install bert-seq2seqpip install tqdmCarregando o modelo BERT, o parâmetro Model_Name Especifica qual Bert usar, atualmente suporta Bert, Roberta e Nezha; Model_class Especifica qual tarefa usar o Bert para fazer, o SEQ2SEQ representa a tarefa de geração, o CLS representa a tarefa de classificação de texto ...

Carregando os parâmetros do modelo BERT, observe que está carregando apenas os parâmetros do codificador, ou seja, os parâmetros do modelo pré-treinado baixado da Internet; Por exemplo, o modelo SEQ2SEQ inclui os parâmetros do modelo BERT + a camada de conexão completa, e essa função carrega apenas a primeira parte dos parâmetros.

Carregue todos os parâmetros do modelo. Depois de treinar por algum tempo e salvar o modelo, você pode carregar os últimos resultados de treinamento de modelo por meio dessa função, continuar treinando ou testando.

Se você quiser ler vários artigos, poderá ir ao meu site ~ http://www.blog.zhxing.online/#/ Pesquise poemas, dísticos, NER ou classificação de texto abstrato para encontrar o artigo correspondente. Obrigado pelo seu apoio.

2021.11.12: Código otimizado, suportando o modelo Roberta-Large.

2021.10.12: O método de decodificação do NER foi otimizado. Havia insetos no método de decodificação anterior de granulação grossa.

2021.08.18: Uma grande quantidade de código foi otimizada. O código da estrutura atualmente parece mais claro e uma grande quantidade de código redundante foi excluída.

2021.08.17: suporta o modelo Nezha da Huawei. É muito simples. Basta alterar o parâmetro model_name. Bem -vindo para testar o efeito.

2021.08.15: Adicionado um exemplo de segmentação de palavras e adicionou código de revanche ao tokenizer.

2021.07.29: Otimizar algum código é mais conciso.

2021.07.20: O modelo Simbert é reproduzido e a saída de frases semelhantes pode ser executada, mas, devido à pequena quantidade de dados, ele ainda precisa ser testado.

2021.03.19: Suporta a extensão do modelo, e não apenas usa o modelo que vem com a estrutura, mas também pode carregar diretamente o modelo no rosto abraçado para treinamento e previsão.

2021.03.12: Adicionado um exemplo de treinamento chinês GPT2, a interpretação dos sonhos de Zhou Gong.

2021.03.11: Adicionado exemplo GPT2, você pode continuar escrevendo o artigo.

2021.03.11: Um método de decodificação de geração aleatória foi adicionado e a geração se tornou mais diversificada.

2021.03.08: A pesquisa de feixe retorna os resultados, tomando um aleatoriamente como saída.

2021.02.25: Adicionado um exemplo de correspondência semântica.

2021.02.06: O método de configuração do dispositivo foi ajustado e agora é mais conveniente.

2021.1.27: A estrutura do código da estrutura foi ajustada e há muitas alterações. Se houver um bug, sinta -se à vontade para emitir.

2021.1.21: Adicionado um novo exemplo, classificação de extração de relacionamento de personagem.

2020.12.02: Algum código foi ajustado e vários arquivos de teste foram adicionados, o que pode carregar facilmente o modelo treinado e testar as tarefas correspondentes.

2020.11.20: Adicionado um exemplo, a extração tripla F1 pode atualmente atingir 0,7. Adicionado código de teste para classificação de texto de resumo de notícias.

2020.11.04: Um exemplo de execução do BET-CRF para executar tarefas de nervos comuns, o efeito é bom.

2020.10.24: Uma grande quantidade de código foi ajustada e um exemplo de resumo automático do conjunto de dados THUCNEWS foi adicionado. Agora, o treinamento deveria ter sido muito eficaz. No passado, os parâmetros de pré-treinamento não podem ser carregados e o efeito pode ser muito ruim.

2020.10.23: Alguma estrutura de código foi ajustada, algumas variáveis em cada exemplo foram escritas como variáveis globais, e o código de busca de feixe foi alterado, que foi mais simplificado. No entanto, as rimas em escrito poemas não são suportadas por enquanto. Compensar isso mais tarde.

2020.09.29: Um novo exemplo de treinamento do concurso Tianchi Medical ner (medicina ner_train.py) é adicionado. Para detalhes, consulte a interface da competição: https://tianchi.aliyun.com/competition/entrance/531824/information

2020.08.16: Adicionado um exemplo de treinamento conjunto de dísticos de poesia (dísticos de poesia_train.py), você pode escrever poesia e letras e dísticos ao mesmo tempo; Além disso, um novo código de teste para poesia é adicionado e você pode testá -lo após o treino do modelo.

2020.08.08: Há muito conteúdo nesta atualização, 1. Adicionado um exemplo de resumo automático (auto_title.py) 2. Adicionado um código para uma lista de vocabulário simplificada. As palavras originais de 3W foram reduzidas para mais de 1W (porque algumas palavras nunca aparecerão) 3. Modificou algum código de busca de feixe, e o efeito foi melhor. 4. O NER de grão fino não pode ser usado por enquanto, e os dados são um pouco problemáticos; portanto, coloque-o na pasta de teste temporariamente. Se você encontrar os dados corretos, poderá usá -los 5. Adicione uma nova pasta de teste. O modelo treinado pode ser testado nele para ver o efeito.

2020.06.22: Complementou um artigo por norma de camada condicional. Parte do código foi explicado. http://www.blog.zhxing.online/#/readblog?blogid=347

2020.06.21: Muito código foi atualizado e um exemplo de extração tripla foi reproduzido (Triple Extração_train.py) ~

2020.06.02: Estou ocupado com a graduação recentemente e ainda há uma competição. Não vou atualizá -lo por enquanto e continuarei atualizando -o no futuro.

2020.04.18: Depois de treinar o modelo BERT+CRF, a taxa de aprendizado da camada CRF não parece ser alta o suficiente e precisa ser melhorada (a taxa de aprendizado da camada CRF agora pode ser definida separadamente, geralmente definida como 0,01).

2020.04.13: Adicionada tarefa NER + perda de camada de CRF, passando por exemplos de treinamento, mas o algoritmo Viterbi ainda não foi adicionado.

2020.04.11: Planeje adicionar uma camada CRF à tarefa NER.

2020.04.07: Adicionado um exemplo de ner.

2020.04.07: Atualizado Pypi e adicionou um modelo para tarefas de anotação de sequência, como o NER.

2020.04.04: O código acima do PYPI foi atualizado. Atualmente, a versão mais recente é 0,0.6. Use a versão mais recente, haverá menos bugs.

2020.04.04: Corrigido alguns bugs e exemplos adicionados de classificação de texto do título de notícias

2020.04.02: O grau de punição por palavras e rimas repetidas na pesquisa de feixes para escrever poemas pode ser melhor.

2020.04.02: Adicionada tarefa de interpretação dos sonhos de Zhou Gong

2020.04.02: Adicionado uma tarefa de dísticos

2020.04.01: Adicionado uma tarefa para escrever poesia

2020.04.01: refatou o código e levou menos tempo para começar a treinar uma nova tarefa.

python setup.py sdist twin upload dist/bert_seq2seq-2.3.5.tar.gz