Un marco pequeño ligero, bienvenido a Star si lo desea ~ gracias. Si encuentra algún problema, también puede preguntar un problema y se asegurará de responder.

Actualmente, se refactora una versión de la capacitación distribuida. ¡Puede capacitar directamente a Multi-GPU sin comandos adicionales o código adicional ! Bienvenido a https://github.com/920232796/bert_seq2seq_ddp para obtener más información

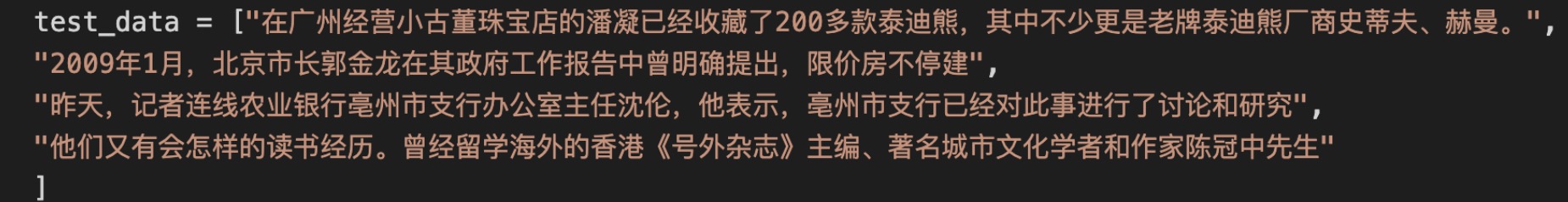

La carga de diferentes modelos se logra estableciendo el parámetro "Model_Name", y se logran diferentes tareas estableciendo el parámetro "Model_class". Para más detalles, puede ver varios ejemplos en ejemplos.

Se hace referencia a algunos de los códigos https://github.com/huggingface/transformers/ y https://github.com/bojone/bert4keras ¡Muchas gracias! ! !

Buen tiempo hoy

, Fui allí para ver una película con mis bebés, ¡fue realmente bueno! El entorno no es nada que decir. La película es muy exquisita y los efectos de sonido son muy buenos. No sé si esta tienda todavía está abierta. Espero que puedas verlo con frecuencia si tienes tiempo.

ingresar: Producción:

Producción:

Producción:

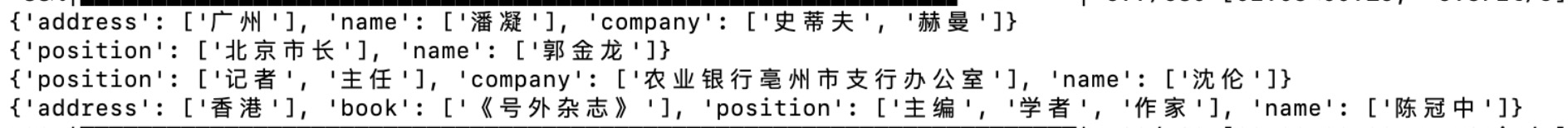

Las interacciones de drogas pueden ocurrir si se usan simultáneamente con otras drogas. Consulte a su médico o farmacéutico para obtener más detalles. Tómelo con agua hirviendo, 14 gramos a la vez, 3 veces al día. Nutrir sangre, regular la menstruación y aliviar el dolor. Se usa para un flujo menstrual bajo, dolor abdominal menstrual incorrecto, Jianmin Group Yekai Thai Medicine (Suizhou) Co., Ltd. 1. Evite comer alimentos crudos y fríos. 2. Las personas con otras enfermedades deben tomarlo bajo la guía de un médico. 3. Si tiene menstruación normal, debe ir al hospital para recibir tratamiento después de una disminución repentina de la menstruación o tener un período de menstruación incorrecto. 4. Para el tratamiento de la dismenorrea, es aconsejable tomar el medicamento de 3 a 5 días antes de la menstruación y tomarla durante una semana. Si hay requisitos de fertilidad, debe tomarlo bajo la guía de un médico. 5. Aquellos que no alivian la dismenorrea después de tomar el medicamento o que tienen dismenorrea severa deben ir al hospital para el diagnóstico y el tratamiento. 6. Si los síntomas no alivian después de tomar el medicamento durante 2 semanas, debe ir al hospital para recibir tratamiento. 7. Está prohibido para aquellos que son alérgicos a este producto, y se usa con precaución si usted es alérgico al cuerpo. 8. Está prohibido usar cuando las características de este producto cambian. 9. Coloque este producto en un lugar al que los niños no puedan alcanzar. 10. Si está utilizando otros medicamentos, consulte a su médico o farmacéutico antes de usar este producto. Este producto es un medicamento de venta libre para la menstruación irregular ginecológica. Nutrir sangre, regular la menstruación y aliviar el dolor. Se usa para el dolor abdominal durante la menstruación. Nutrir sangre, regular la menstruación y aliviar el dolor. Se utiliza para un flujo menstrual bajo, dolor abdominal menstrual incorrecto, 14g*5 bolsas de drogas de venta libre (clase B), Directorio Nacional de Seguros Médicos (Clase B) Prohibido para mujeres embarazadas. Los diabéticos no pueden tomarlo.

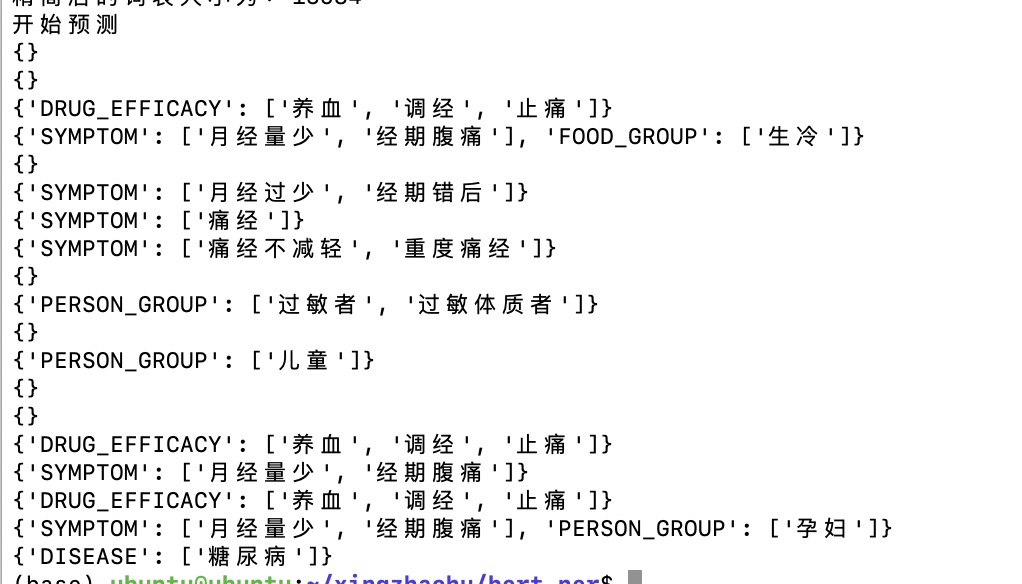

pip install bert-seq2seqpip install tqdmCargando el modelo Bert, el parámetro Model_Name especifica qué Bert usar, actualmente es compatible con Bert, Roberta y Nezha; model_class especifica qué tarea usar Bert para hacer, SEQ2SEQ representa la tarea de generación, CLS representa la tarea de clasificación de texto ...

Cargando los parámetros del modelo BERT, tenga en cuenta que solo está cargando los parámetros del codificador, es decir, los parámetros del modelo previamente capacitado descargado desde Internet; Por ejemplo, el modelo SEQ2SEQ incluye los parámetros del modelo Bert + la capa de conexión completa, y esta función solo carga la primera parte de los parámetros.

Cargue todos los parámetros del modelo. Después de haber entrenado durante algún tiempo y haber guardado el modelo, puede cargar los últimos resultados de entrenamiento del modelo a través de esta función, continuar entrenando o probando.

Si desea leer varios artículos, puede ir a mi sitio web ~ http://www.blog.zhxing.online/#/ Buscar poemas, pareados, ner o clasificación de texto de resumen de noticias para encontrar el artículo correspondiente. Gracias por su apoyo.

2021.11.12: Código optimizado, que admite el modelo Roberta-Large.

2021.10.12: El método de decodificación de NER ha sido optimizado. Hubo errores en el método de decodificación de grano grueso anterior.

2021.08.18: Se ha optimizado una gran cantidad de código. El código de marco se ve actualmente más claro y se ha eliminado una gran cantidad de código redundante.

2021.08.17: Admite el modelo Nezha de Huawei. Es muy simple. Simplemente cambie el parámetro Model_Name. Bienvenido para probar el efecto.

2021.08.15: Se agregó un ejemplo de segmentación de palabras y se agregó el código de revancha al tokenizer.

2021.07.29: La optimización de algún código es más conciso.

2021.07.20: El modelo Simbert se reproduce y se puede realizar la salida de oraciones similares, pero debido a la pequeña cantidad de datos, queda por probar.

2021.03.19: Admite la extensión del modelo, y no solo usa el modelo que viene con el marco, sino que también puede cargar directamente el modelo en la cara de abrazo para el entrenamiento y la predicción.

2021.03.12: Se agregó un ejemplo de entrenamiento chino GPT2, la interpretación de los sueños de Zhou Gong.

2021.03.11: Se agregó un ejemplo de GPT2, puede continuar escribiendo el artículo.

2021.03.11: Se ha agregado un método de decodificación de generación aleatoria, y la generación se ha vuelto más diversa.

2021.03.08: La búsqueda del haz devuelve n resultados, tomando uno al azar como salida.

2021.02.25: Se agregó un ejemplo de coincidencia semántica.

2021.02.06: El método de configuración del dispositivo se ha ajustado y ahora es más conveniente.

2021.1.27: La estructura de código del marco se ha ajustado y hay muchos cambios. Si hay un error, no dude en emitir.

2021.1.21: Se agregó un nuevo ejemplo, clasificación de extracción de relación de caracteres.

2020.12.02: Se ha ajustado algún código y se han agregado varios archivos de prueba, lo que puede cargar fácilmente el modelo capacitado y probar las tareas correspondientes.

2020.11.20: Se agregó un ejemplo, la extracción Triple F1 puede alcanzar actualmente 0.7. Código de prueba agregado para la clasificación de texto de resumen de noticias.

2020.11.04: Un ejemplo de ejecutar BET-CRF para realizar tareas NER ordinarias, el efecto es bueno.

2020.10.24: Se ha ajustado una gran cantidad de código y se ha agregado un ejemplo de resumen automático del conjunto de datos de Tucnews. Ahora, la capacitación debería haber sido muy efectiva. En el pasado, los parámetros previos al entrenamiento pueden no cargarse, y el efecto puede ser muy pobre.

2020.10. Sin embargo, las rimas en la escritura de los poemas no son compatibles con el momento. Compensarlo más tarde.

2020.09.29: Se agrega un nuevo ejemplo de entrenamiento de la competencia de Tianchi Medical Ner (Medical Ner_train.py). Para más detalles, consulte la interfaz de la competencia: https://tiangi.aliyun.com/competition/entrance/531824/information

2020.08.16: Se agregó un ejemplo de entrenamiento conjunto de pareados de poesía (poesía parguetas_train.py), puede escribir poesía y letras y pareadores al mismo tiempo; Además, se agrega un nuevo código de prueba para la poesía, y puede probarlo después de que el modelo esté capacitado.

2020.08.08: Hay mucho contenido en esta actualización, 1. Se agregó un ejemplo de resumen automático (auto_title.py) 2. Se agregó un código para una lista de vocabulario simplificada. Las palabras originales de 3W se redujeron a más de 1W (porque algunas palabras nunca aparecerán) 3. Modificado algún código de búsqueda de haz, y el efecto fue mejor. 4. El NER de grano fino no se puede usar por el momento, y los datos son un poco problemáticos, así que póngalos en la carpeta de prueba temporalmente. Si encuentra los datos correctos, puede usarlos 5. Agregue una nueva carpeta de prueba. El modelo entrenado se puede probar para ver el efecto.

2020.06.22: complementó un artículo por norma de capa condicional. Se explicó parte del código. http://www.blog.zhxing.online/#/readblog?blogid=347

2020.06.21: Se ha actualizado mucho código y se ha reproducido un ejemplo de extracción triple (triple extracción_train.py) ~

2020.06.02: He estado ocupado recientemente con la graduación, y todavía hay una competencia. No lo actualizaré por el momento, y continuaré actualizándolo en el futuro.

2020.04.18: Después de entrenar el modelo Bert+CRF, la tasa de aprendizaje de la capa CRF no parece ser lo suficientemente alta y debe mejorarse (la tasa de aprendizaje de la capa CRF ahora se puede establecer por separado, generalmente establecida en 0.01).

2020.04.13: Tarea NER agregada + pérdida de capa CRF, ejecutándose a través de ejemplos de entrenamiento, pero el algoritmo Viterbi aún no se ha agregado.

2020.04.11: Planifique agregar una capa CRF a la tarea NER.

2020.04.07: Se agregó un ejemplo de NER.

2020.04.07: PYPI actualizado y agregó un modelo para tareas de anotación de secuencia como NER.

2020.04.04: El código anterior se ha actualizado. Actualmente, la última versión es 0.0.6. Utilice la última versión, habrá menos errores.

2020.04.04: Se corrigió algunos errores y se agregaron ejemplos de clasificación de texto del título de noticias

2020.04.02: El grado de castigo para palabras repetidas y rimas en la búsqueda del haz para escribir poemas puede ser mejor.

2020.04.02: Se agregó la tarea de interpretación del sueño de Zhou Gong

2020.04.02: Se agregó una tarea de coplas

2020.04.01: Se agregó una tarea para escribir poesía

2020.04.01: Refactoró el código y tomó menos tiempo comenzar a capacitar una nueva tarea.

Python setup.py Sdist Twin Subga Dist/bert_seq2seq-2.3.5.tar.gz