軽量の小さなフレーム、あなたが好きならスターへようこそ〜ありがとう。問題が発生した場合は、問題を尋ねることもできます。返信することもできます。

現在、分散トレーニングのバージョンがリファクタリングされています。追加のコマンドや追加コードなしでマルチGPUを直接トレーニングできます!詳細については、https://github.com/920232796/bert_seq2seq_ddpへようこそ

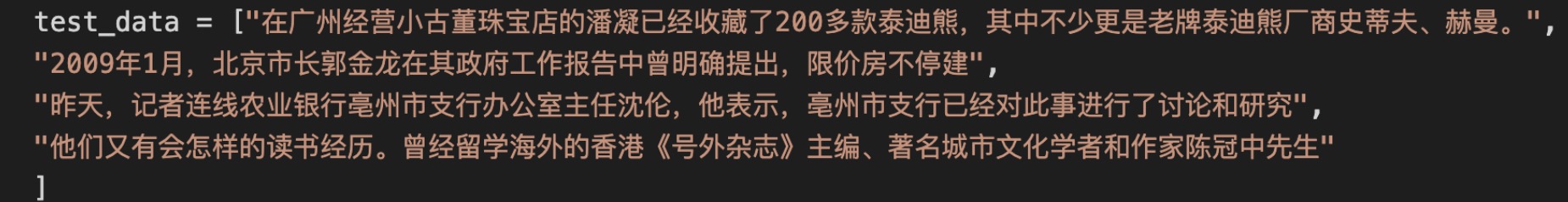

「model_name」パラメーターを設定することで異なるモデルの読み込みが実現され、「model_class」パラメーターを設定することでさまざまなタスクが達成されます。詳細については、例でさまざまな例を見ることができます。

一部のコードは、https://github.com/huggingface/transformers/およびhttps://github.com/bojone/bert4kerasに参照されています。 ! !

今日は天気が良い

、私は赤ちゃんと一緒に映画を見るためにそこに行きました、それは本当に良かったです!環境は何も言うことはありません。映画は非常に絶妙で、効果音はとても良いです。この店がまだ開いているかどうかはわかりません。時間があれば頻繁にチェックできることを願っています。

入力: 出力:

出力:

出力:

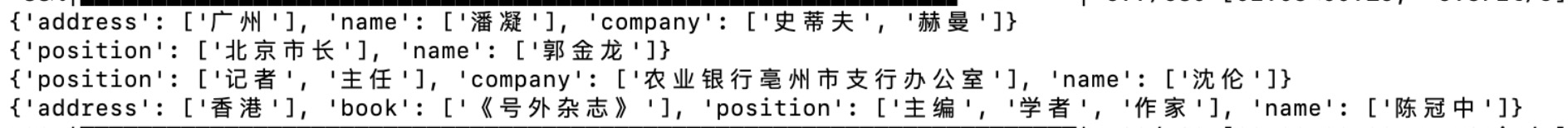

他の薬物と同時に使用すると、薬物相互作用が発生する可能性があります。詳細については、医師または薬剤師に相談してください。沸騰したお湯で1日3回、14グラムで服用してください。血液を養い、月経を調節し、痛みを和らげます。低い月経流、間違った月経腹痛、JianminグループYekai Thai Medicine(Suizhou)Co.、Ltd。1.1。生の食品や冷たい食品を食べないようにしてください。 2。他の疾患を持つ人々は、医師の指導の下でそれを服用すべきです。 3.正常な月経がある場合は、月経が突然減少した後、治療のために病院に行くか、月経期間が間違っています。 4. DysmeLyReaの治療のために、月経の3〜5日前に薬を服用し、1週間服用することをお勧めします。不妊の要件がある場合は、医師の指導の下でそれを取る必要があります。 5.薬を服用した後、または重度の月経困難症を患っている後、不運を緩和しない人は、診断と治療のために病院に行くべきです。 6.薬を2週間服用した後に症状が軽減されない場合は、治療のために病院に行く必要があります。 7.この製品にアレルギーがある人には禁止されており、身体にアレルギーがある場合は慎重に使用されます。 8.この製品の特性が変化するときに使用することは禁止されています。 9。この製品を子供に到達できない場所に置いてください。 10.他の薬物を使用している場合は、この製品を使用する前に医師または薬剤師に相談してください。この製品は、婦人科の不規則な月経のための市販薬です。血液を養い、月経を調節し、痛みを和らげます。月経中の腹痛に使用されます。血液を養い、月経を調節し、痛みを和らげます。低い月経流、間違った月経腹痛、14g*5袋の市販薬(クラスB)、妊婦にとって禁止されている国家医療保険ディレクトリ(クラスB)の14g*5袋に使用されます。糖尿病患者はそれを服用することは許可されていません。

pip install bert-seq2seqpip install tqdmBERTモデルをロードすると、Model_Nameパラメーターは、使用するBERTを指定します。現在、Bert、Roberta、およびNezhaをサポートしています。 Model_Classは、Bertを使用するタスクを指定します。SEQ2SEQは生成タスクを表し、CLSはテキスト分類タスクを表します...

BERTモデルのパラメーターをロードすると、エンコーダーパラメーター、つまりインターネットからダウンロードされた事前に訓練されたモデルのパラメーターのみをロードしていることに注意してください。たとえば、SEQ2SEQモデルには、BERTモデル +完全な接続レイヤーのパラメーターが含まれており、この関数はパラメーターの最初の部分のみをロードします。

すべてのモデルパラメーターをロードします。しばらくトレーニングしてモデルを保存した後、この機能を介して最後のモデルトレーニング結果をロードするか、トレーニングまたはテストを続けることができます。

さまざまな記事を読みたい場合は、私のウェブサイトにアクセスできます〜http://www.blog.zhxing.online/#/詩、カプレット、ner、またはニュースの抽象的なテキスト分類を検索して、対応する記事を見つけることができます。ご支援ありがとうございます。

2021.11.12:Roberta-Largeモデルをサポートする最適化コード。

2021.10.12:NERのデコード方法が最適化されています。以前の粗粒デコード法にはバグがありました。

2021.08.18:大量のコードが最適化されています。現在、フレームワークコードはより明確に見え、大量の冗長コードが削除されています。

2021.08.17:HuaweiのNezhaモデルをサポートしています。とても簡単です。 model_nameパラメーターを変更するだけです。効果をテストするためのようこそ。

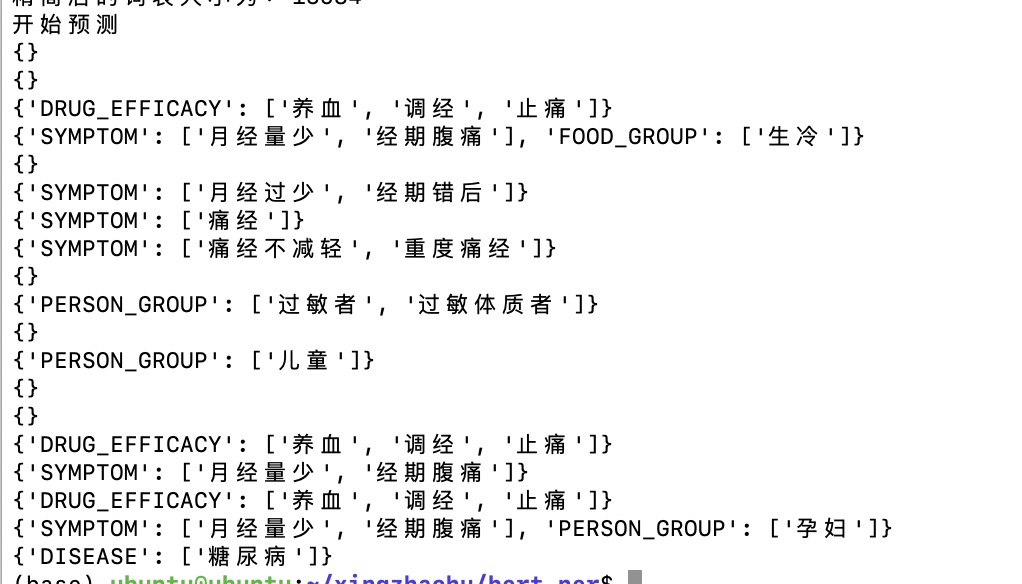

2021.08.15:単語セグメンテーションの例を追加し、トークネイザーに再戦コードを追加しました。

2021.07.29:一部のコードを最適化することはより簡潔です。

2021.07.20:Simbertモデルが再現され、同様の文の出力を実行できますが、データの少量のためにテストする必要があります。

2021.03.19:モデルの拡張をサポートし、フレームワークに付属するモデルを使用するだけでなく、トレーニングと予測のためにハグする顔にモデルを直接ロードすることもできます。

2021.03.12:Zhou Gongの夢の解釈、GPT2中国のトレーニングの例を追加しました。

2021.03.11:GPT2の例を追加して、記事を書き続けることができます。

2021.03.11:ランダム生成デコード方法が追加されており、世代はより多様になっています。

2021.03.08:Beam Searchは結果を返し、1つをランダムに出力として取得します。

2021.02.25:セマンティックマッチングの例を追加しました。

2021.02.06:デバイス設定方法が調整されており、今ではより便利になりました。

2021.1.27:フレームワークのコード構造が調整されており、多くの変更があります。バグがある場合は、お気軽に発行してください。

2021.1.21:新しい例、文字関係抽出分類を追加しました。

2020.12.02:一部のコードが調整されており、いくつかのテストファイルが追加されており、トレーニングされたモデルを簡単にロードして対応するタスクをテストできます。

2020.11.20:例を追加すると、トリプル抽出F1は現在0.7に達する可能性があります。ニュースサマリーテキスト分類のためのテストコードが追加されました。

2020.11.04:通常のNERタスクを実行するためにBET-CRFを実行している例、その効果は良いです。

2020.10.24:大量のコードが調整され、Thucnewsデータセットの自動要約例が追加されました。今、トレーニングは非常に効果的だったはずです。過去には、トレーニング前のパラメーターがロードされない可能性があり、その効果は非常に悪い場合があります。

2020.10.23:一部のコード構造が調整され、各例の一部の変数がグローバル変数として記述され、ビーム検索コードが変更され、より合理化されています。しかし、書く詩の韻は当面は支持されていません。後でそれを補います。

2020.09.29:Tianchi Medical NER競争の新しいトレーニング例(Medical NER_TRAIN.PY)が追加されました。詳細については、競合インターフェイスhttps://tianchi.aliyun.com/competition/entrance/531824/informationを参照してください

2020.08.16:詩のカプレット(詩のcouplets_train.py)の共同トレーニングの例を追加して、詩と歌詞とカプレットを同時に書くことができます。さらに、詩の新しいテストコードが追加されており、モデルがトレーニングされた後にテストできます。

2020.08.08:この更新には多くのコンテンツがあります。1。自動概要の例を追加しました(auto_title.py)2。簡素化された語彙リストのコードを追加しました。元の3Wの単語は1W以上に削減されました(一部の単語が表示されないため)3。いくつかのビーム検索コードを変更し、効果がより良くなりました。 4.きめの細かいnerは当面の間使用することはできず、データには少し問題があるので、一時的にテストフォルダーに入れてください。適切なデータが見つかった場合は、5を使用できます。新しいテストフォルダーを追加します。訓練されたモデルをテストして、効果を確認できます。

2020.06.22:条件付き層規範によって記事を補足しました。コードの一部が説明されました。 http://www.blog.zhxing.online/#/readblog?blogid=347

2020.06.21:多くのコードが更新され、トリプル抽出の例が再現されました(triple抽出_train.py)〜

2020.06.02:私は最近卒業で忙しく、まだ競争があります。当面は更新しません。今後も更新し続けます。

2020.04.18:BERT+CRFモデルをトレーニングした後、CRF層の学習率は十分に高くないようで、改善する必要があります(CRF層学習率は別々に設定でき、通常は0.01に設定できます)。

2020.04.13:トレーニングの例を実行しているNERタスク + CRFレイヤーの損失を追加しましたが、ViterBiアルゴリズムはまだ追加されていません。

2020.04.11:NERタスクにCRFレイヤーを追加する計画。

2020.04.07:NERの例を追加しました。

2020.04.07:PYPIを更新し、NERなどのシーケンス注釈タスクのモデルを追加しました。

2020.04.04:PYPI上記のコードが更新されました。現在、最新バージョンは0.0.6です。最新バージョンを使用してください。バグは少なくなります。

2020.04.04:いくつかのバグとニュースタイトルのテキスト分類の追加例を修正しました

2020.04.02:詩を書くためのビーム検索の繰り返しの言葉と韻に対する罰の程度がより良いかもしれません。

2020.04.02:Zhou Gongの夢の解釈タスクを追加しました

2020.04.02:カプレットのタスクを追加しました

2020.04.01:詩を書くためのタスクを追加しました

2020.04.01:コードをリファクタリングし、新しいタスクのトレーニングを開始するのに時間がかかりませんでした。

python setup.py sdistツインアップロードdist/bert_seq2seq-2.3.5.tar.gz