Meta AI는 캘리포니아 대학교, 버클리 및 뉴욕 대학교의 연구원들과 함께 LLM (Lange Language Models)의 응답 품질을 크게 향상시키는 것을 목표로하는 TPO (Thinking Preverence Optimization)라는 새로운 접근법을 개발했습니다. 최종 답변에만 초점을 맞춘 전통적인 방법과 달리 TPO는 답변을 생성하기 전에 모델이 내부적으로 생각할 수 있도록하여보다 정확하고 일관된 응답을 제공합니다. 이 기술 개선 된 사고 체인 (COT) 추론 방법은 모델의 내부 사고 과정을 최적화하고 간소화하여 이전 COT 방법의 낮은 정확도와 어려움을 극복하고 궁극적으로 더 높은 품질의 답변을 생성합니다 각 벤치 마크 테스트.

최종 답변에만 초점을 둔 기존 모델과 달리 TPO 방법을 사용하면 응답을 생성하기 전에 모델이 내부적으로 생각할 수 있으므로보다 정확하고 일관된 답변을 얻을 수 있습니다.

이 새로운 기술은 개선 된 추론 (COT) 추론 방법을 결합합니다. 훈련 과정 에서이 방법은 모델이 응답하기 전에 "생각"하도록 권장하여보다 체계적인 내부 사고 과정을 구축 할 수 있도록 권장합니다. 이전 직접 침대 프롬프트는 때때로 정확도를 줄이고 명확한 사고 단계가 없기 때문에 훈련 과정이 어렵습니다. TPO는 모델이 사고 과정을 최적화하고 간소화 할 수있게함으로써 이러한 한계를 극복하고 사용자 앞에 중간 사고 단계를 표시하지 않습니다.

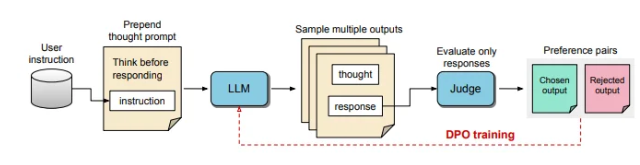

TPO 과정에서 큰 언어 모델은 먼저 여러 사고 과정을 생성하라는 메시지가 표시되며, 이러한 출력은 최종 응답을 형성하기 전에 샘플링 및 평가됩니다. 그런 다음 평가 모델은 출력을 점수하여 최적 및 최악의 응답을 결정합니다. 이러한 출력을 DPO (Direct Preference Optimization)를위한 선택 및 거부로 사용 함으로써이 반복 교육 방법은보다 관련성이 높은 고품질 응답을 생성하는 모델의 능력을 향상시켜 전반적인 결과를 향상시킵니다.

이 방법에서는 훈련 프롬프트가 조정되어 모델이 응답하기 전에 내부적으로 생각하도록 장려합니다. 평가 된 최종 응답은 LLM 기반 평가 모델에 의해 점수가 매겨지며, 이는 암시 적 사고 단계를 고려하지 않고 반응의 효과에 따라 모델이 품질을 향상시킬 수 있습니다. 또한 TPO는 직접 선호도 최적화를 사용하여 암시 적 사고를 포함하는 선호도 및 거부 응답을 생성하고 여러 교육주기를 통해 모델의 내부 프로세스를 추가로 개선합니다.

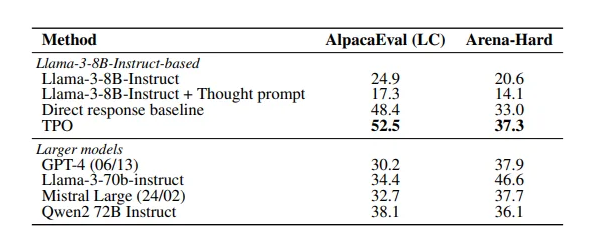

이 연구의 결과는 TPO 방법이 여러 벤치 마크에서 잘 수행되어 다양한 기존 모델을 능가한다는 것을 보여줍니다. 이 접근법은 논리적 및 수학적 작업에 적용될뿐만 아니라 마케팅 및 건강 사령부를 따르는 작업과 같은 창의적인 분야에서 잠재력을 보여줍니다.

종이 : https://arxiv.org/pdf/2410.10630

핵심 사항 :

TPO 기술은 응답을 생성하기 전에 대형 언어 모델의 사고 능력을 향상시켜 응답이 더 정확한지 확인합니다.

개선 된 사고 체인 추론을 통해이 모델은 내부 사고 과정을 최적화하고 간소화하고 응답 품질을 향상시킬 수 있습니다.

TPO는 논리적 및 수학적 작업뿐만 아니라 창의적 및 건강에도 다양한 분야에 적합합니다.

요컨대, TPO 방법은 대형 언어 모델의 성능 향상을위한 새로운 아이디어를 제공합니다. 이 용지 링크는 독자가 기술적 세부 사항과 실험 결과에 대한 통찰력을 얻는 데 편리합니다.