Meta AI hat in Zusammenarbeit mit Forschern der University of California, der Berkeley und der New York University einen neuen Ansatz entwickelt, der als Thinking Preference Optimization (TPO) bezeichnet wird, der darauf abzielt, die Reaktionsqualität von Großsprachenmodellen (LLM) erheblich zu verbessern. Im Gegensatz zu herkömmlichen Methoden, die sich nur auf die endgültige Antwort konzentrieren, ermöglicht TPO das Modell intern, bevor er die Antwort generiert, was zu einer genaueren und kohärenten Reaktion führt. Diese Methode für technologiebelme Denkkette (COT) überwindet die Mängel der geringen Genauigkeit und Schwierigkeit des Trainings der vorherigen COT-Methode durch Optimierung und Straffung des internen Denkprozesses des Modells und erzeugt letztendlich höhere Antworten und in vielerlei Hinsicht Jeder Benchmark -Test.

Im Gegensatz zu herkömmlichen Modellen, die sich nur auf die endgültige Antwort konzentrieren, ermöglicht die TPO -Methode das Modell intern, bevor er eine Antwort generiert, was zu genaueren und kohärenten Antworten führt.

Diese neue Technologie kombiniert eine verbesserte Argumentationsmethode (COT). Während des Schulungsprozesses ermutigt die Methode das Modell, vor der Reaktion "zu denken", und hilft damit, einen systematischeren internen Denkprozess aufzubauen. Frühere direkte COT -Aufforderungen verringern manchmal die Genauigkeit, und der Schulungsprozess ist aufgrund des Mangels an klaren Denkschritten schwierig. TPO überwindet diese Einschränkungen, indem er dem Modell seinen Denkprozess optimieren und optimieren lässt, und zeigt keine intermediierten Denkschritte vor dem Benutzer an.

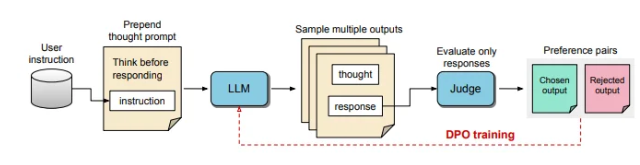

Im Prozess von TPO werden erstmals große Sprachmodelle aufgefordert, mehrere Denkprozesse zu generieren, und dann werden diese Ausgänge abgetastet und bewertet, bevor die endgültige Antwort gebildet wird. Ein Bewertungsmodell bewertet dann die Ausgabe, um die optimalen und schlimmsten Antworten zu bestimmen. Durch die Verwendung dieser Ausgänge als Auswahl und Ablehnung für die DIPO (Direct Preference Optimization) verbessert diese iterative Trainingsmethode die Fähigkeit des Modells, relevantere und qualitativ hochwertige Antworten zu erzeugen, wodurch die Gesamtergebnisse verbessert werden.

Bei dieser Methode werden die Schulungsaufforderungen angepasst, wodurch das Modell vor der Beantwortung des Modells intern nachdenkt. Die bewertete endgültige Reaktion wird durch ein LLM-basierter Bewertungsmodell bewertet, mit dem das Modell die Qualität, die ausschließlich auf der Wirksamkeit der Reaktion basiert, verbessert, ohne implizite Denkschritte zu berücksichtigen. Darüber hinaus verwendet TPO eine direkte Präferenzoptimierung, um Präferenz- und Ablehnungsantworten zu erstellen, die implizites Denken enthalten, und den internen Prozess des Modells durch mehrere Trainingszyklen weiter verfeinert.

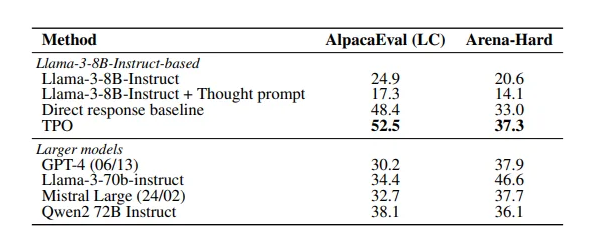

Die Ergebnisse der Studie zeigen, dass die TPO -Methode in mehreren Benchmarks gut abschneidet und eine Vielzahl vorhandener Modelle übertrifft. Dieser Ansatz gilt nicht nur für logische und mathematische Aufgaben, sondern zeigt auch Potenzial in kreativen Bereichen wie Marketing- und Gesundheitsbefehlsaufgaben.

Papier: https://arxiv.org/pdf/2410.10630

Schlüsselpunkte:

Die TPO -Technologie verbessert die Denkfähigkeit großer Sprachmodelle, bevor Reaktionen generiert werden, und stellt sicher, dass die Antworten genauer sind.

Durch ein verbessertes Denken der Kettenkette kann das Modell seinen internen Denkprozess optimieren, optimieren und die Reaktionsqualität verbessern.

TPO ist für eine Vielzahl von Feldern geeignet, nicht nur für logische und mathematische Aufgaben, sondern auch für kreative und Gesundheit.

Kurz gesagt, die TPO -Methode bietet eine neue Idee für die Leistungsverbesserung großer Sprachmodelle. Die Papierlinks sind für die Leser bequem, um Einblicke in ihre technischen Details und experimentellen Ergebnisse zu erhalten.