メタAIは、カリフォルニア大学、バークレー校、ニューヨーク大学の研究者と協力して、大規模な言語モデル(LLM)の応答品質を大幅に向上させることを目的としたThinking Preference Optimization(TPO)と呼ばれる新しいアプローチを開発しました。最終回答のみに焦点を当てた従来の方法とは異なり、TPOは、回答を生成する前にモデルを内部的に考えることができ、より正確で一貫した応答をもたらします。このテクノロジー改革された思考チェーン(COT)推論法は、モデルの内部思考プロセスを最適化して合理化することで、以前のCOTメソッドの低精度と困難の欠点を克服し、最終的には高品質の答えを生み出します各ベンチマークテスト。

最終回答のみに焦点を当てた従来のモデルとは異なり、TPOメソッドは、モデルが応答を生成する前に内部的に考えることを可能にし、より正確で一貫した答えをもたらします。

この新しいテクノロジーは、改善されたチェーン(COT)推論方法を組み合わせています。トレーニングプロセス中に、この方法は、モデルが応答する前に「考える」ことを奨励し、より体系的な内部思考プロセスを構築するのに役立ちます。以前の直接COTプロンプトは、正確さを減らすことがあり、明確な思考の手順がないため、トレーニングプロセスが困難です。 TPOは、モデルが思考プロセスを最適化および合理化できるようにすることにより、これらの制限を克服し、ユーザーの前で中間思考の手順を表示しません。

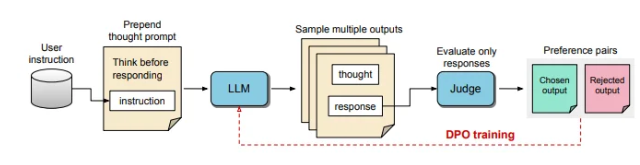

TPOのプロセスでは、最初に大規模な言語モデルが複数の思考プロセスを生成するように求められ、次にこれらの出力がサンプリングおよび評価されてから最終応答を形成します。評価モデルは、出力を採点し、最適な応答と最悪の応答を決定します。これらの出力を直接選好最適化(DPO)の選択と拒否として使用することにより、この反復トレーニング方法は、より関連性の高い質の高い応答を生成するモデルの能力を高め、それによって全体的な結果を改善します。

この方法では、トレーニングプロンプトが調整され、応答する前にモデルが内部的に考えるようにモデルを奨励します。評価された最終応答は、LLMベースの評価モデルによって採点されます。これにより、暗黙の思考ステップを考慮せずに、応答の有効性のみに基づいてモデルが品質を改善できます。さらに、TPOは直接選好の最適化を使用して、暗黙の思考を含む優先順位と拒絶反応を作成し、複数のトレーニングサイクルを通じてモデルの内部プロセスをさらに洗練します。

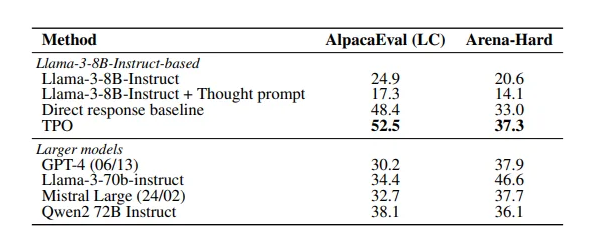

この研究の結果は、TPOメソッドが複数のベンチマークでうまく機能し、さまざまな既存のモデルを上回っていることを示しています。このアプローチは、論理的および数学的なタスクに適用されるだけでなく、マーケティングや健康コマンド中のタスクなどの創造的な分野での可能性も示しています。

論文:https://arxiv.org/pdf/2410.10630

キーポイント:

TPOテクノロジーは、応答を生成する前に大規模な言語モデルの思考能力を改善し、応答がより正確であることを保証します。

改善された思考チェーンの推論により、モデルは内部思考プロセスを最適化および合理化し、応答の質を向上させることができます。

TPOは、論理的および数学的なタスクだけでなく、創造性と健康にも、さまざまな分野に適しています。

要するに、TPOメソッドは、大規模な言語モデルのパフォーマンス改善に関する新しいアイデアを提供します。 紙のリンクは、読者が技術的な詳細と実験結果について洞察を得るのに便利です。