합성을위한 GUI 래퍼. 토글가 가능한 스위치를 통해 CPU 전용 합성을 허용합니다. 휴대용 EXE 파일을 사용할 수 있습니다 (CPU에서만 실행됨).

또한 스트림 요소에서 TTS 기부 경보를 연주합니다.

| 메인 UI | 스트림 요소 통합 |

|---|---|

사용자 친화적 인 GUI와 함께 머신 러닝 기반 텍스트 대 음성 프로그램. 대상 고객에는 오픈 소스 TTS 프로그램을 찾는 Twitch Stremer 또는 콘텐츠 제작자가 포함됩니다. 이 소프트웨어의 목적은 휴대용 EXE에서 TTS 합성에 액세스 가능한 오프라인 (코딩 경험 없음, GPU/Colab)을 만드는 것입니다.

휴대용 실행 파일은 릴리스 페이지 또는 바로 여기에서 찾을 수 있습니다. 미리 가입 한 타코트론 2 와 웨이브 글로우 모델을 아래에서 다운로드하십시오.

경고 : 휴대용 실행 파일은 CPU에서 실행되며 GPU에서 실행하는 것과 비교하여 10 배 속도 속도가납니다.

Pytorch 1.0

python gui.py

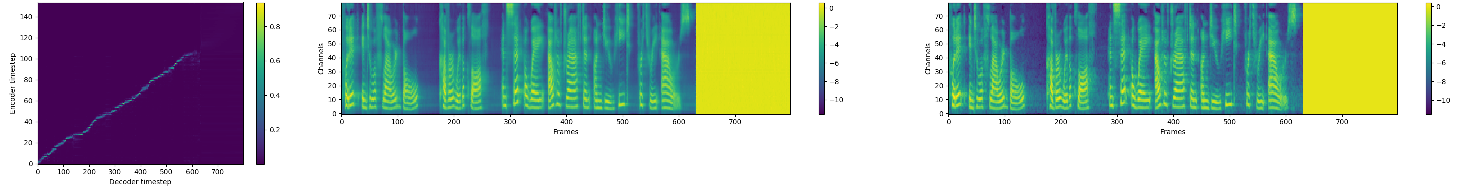

MEL 스펙트럼 예측에서 조절 마수에 의한 천연 TTS 합성의 Pytorch 구현.

이 구현에는 분산 및 자동 혼합 정밀 지원이 포함되며 LJSpeech 데이터 세트를 사용합니다.

분산 및 자동 혼합 정밀지지는 NVIDIA의 정점 및 앰프에 의존합니다.

게시 된 Tacotron 2 및 WaveGlow 모델을 사용하여 오디오 샘플을 보려면 웹 사이트를 방문하십시오.

git clone https://github.com/NVIDIA/tacotron2.gitcd tacotron2git submodule init; git submodule updatesed -i -- 's,DUMMY,ljs_dataset_folder/wavs,g' filelists/*.txthparams.py 에서 load_mel_from_disk=True 설정하고 Mel-Spectrogram 경로를 업데이트하십시오pip install -r requirements.txt python train.py --output_directory=outdir --log_directory=logdirtensorboard --logdir=outdir/logdir 미리 훈련 된 모델을 사용하는 교육은 기본적으로 더 빠른 수렴으로 이어질 수 있으며, 데이터 세트 종속 텍스트 임베딩 레이어는 무시됩니다.

python train.py --output_directory=outdir --log_directory=logdir -c tacotron2_statedict.pt --warm_start python -m multiproc train.py --output_directory=outdir --log_directory=logdir --hparams=distributed_run=True,fp16_run=True jupyter notebook --ip=127.0.0.1 --port=31337NB NB 오디오 합성에 대한 Mel-spectrogram을 수행 할 때, Tacotron 2와 Mel Decoder가 동일한 Mel-spectrogram 표현에 대해 훈련되었는지 확인하십시오.

음성 합성을위한 실시간 흐름 기반 생성 네트워크보다 더 빠른 WaveGlow

NV-Wavenet은 실시간 Wavenet보다 빠릅니다.

이 구현은 다음 저장소의 코드를 사용합니다. Keith Ito, Prem Seetharaman은 코드에 설명 된대로 코드를 사용합니다.

우리는 Ryuchi Yamamoto의 Tacotron Pytorch 구현에서 영감을 받았습니다.

우리는 Tacotron 2 Paper Authors, 특히 Jonathan Shen, Yuxuan Wang 및 Zongheng Yang에게 감사합니다.