Envoltura de GUI para sintetizar. Permite la síntesis de solo CPU a través de un interruptor toglable. El archivo EXE portátil está disponible (que se ejecuta solo en CPU).

También reproduce alertas de donaciones de TTS de los elementos de transmisión.

| PRINCIPAL UI | Integración de elementos de flujo |

|---|---|

Un programa de texto a voz de texto a voz con una GUI amigable para el usuario. El público objetivo incluye streamers o creadores de contenido que buscan un programa TTS de código abierto. El objetivo de este software es hacer que la síntesis de TTS sea accesible fuera de línea (sin experiencia de codificación, GPU/Colab) en un EXE portátil.

Se puede encontrar un ejecutable portátil en la página de versiones, o directamente aquí. Descargue un modelo de Tacotron 2 y Glow de Wavlow antes de abajo.

ADVERTENCIA: El ejecutable portátil se ejecuta en CPU, lo que conduce a una desaceleración de velocidad> 10x en comparación con la ejecución en GPU.

Pytorch 1.0

python gui.py

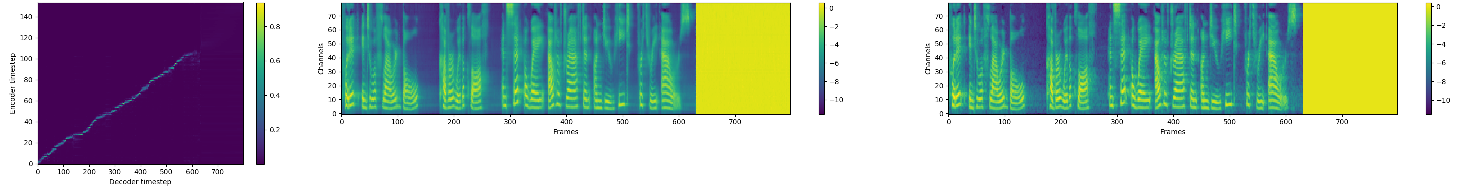

Implementación de Pytorch de la síntesis de TTS natural mediante el acondicionamiento del wavenet en las predicciones del espectrograma MEL.

Esta implementación incluye soporte de precisión mixto distribuido y automático y utiliza el conjunto de datos LJSPEECH.

El soporte de precisión mixto distribuido y automático se basa en el APEX y AMP de NVIDIA.

Visite nuestro sitio web para ver muestras de audio utilizando nuestros modelos Tacotron 2 y Wavlow publicados.

git clone https://github.com/NVIDIA/tacotron2.gitcd tacotron2git submodule init; git submodule updatesed -i -- 's,DUMMY,ljs_dataset_folder/wavs,g' filelists/*.txtload_mel_from_disk=True en hparams.py y actualice las rutas de espectrograma MELpip install -r requirements.txt python train.py --output_directory=outdir --log_directory=logdirtensorboard --logdir=outdir/logdir La capacitación que usa un modelo previamente capacitado puede conducir a una convergencia más rápida de forma predeterminada, se ignoran las capas de incrustación de texto dependientes del conjunto de datos

python train.py --output_directory=outdir --log_directory=logdir -c tacotron2_statedict.pt --warm_start python -m multiproc train.py --output_directory=outdir --log_directory=logdir --hparams=distributed_run=True,fp16_run=True jupyter notebook --ip=127.0.0.1 --port=31337NB Al realizar el espectrograma MEL a la síntesis de audio, asegúrese de que el tacotrón 2 y el decodificador MEL estuvieran entrenados en la misma representación del espectrograma MEL.

Giro de onda más rápido que la red generativa basada en el flujo en tiempo real para la síntesis del habla

NV Wavenet más rápido que el wavenet en tiempo real.

Esta implementación utiliza código de los siguientes reposadores: Keith Ito, Prem Seetharaman como se describe en nuestro código.

Estamos inspirados en la implementación de Tacotron Pytorch de Ryuchi Yamamoto.

Estamos agradecidos con los autores de papel de Tacotron 2, especialmente Jonathan Shen, Yuxuan Wang y Zongheng Yang.