GUI -Wrapper für Synthese. Ermöglicht die CPU-Synthese nur über einen schaltbaren Schalter. Die portable EXE -Datei ist verfügbar (die nur auf CPU ausgeführt wird).

Spielt auch TTS -Spenden von Stream -Elementen.

| Haupt Benutzeroberfläche | Stream -Elemente -Integration |

|---|---|

Ein maschinelles Lernen basierter Text zu Sprachprogramm mit einer benutzerfreundlichen GUI. Zu den Zielgruppen gehören Twitch -Streamer oder Inhaltsersteller, die nach einem Open -Source -TTS -Programm suchen. Ziel dieser Software ist es, die TTS -Synthese in einem tragbaren Exe (keine Codierungserfahrung, GPU/Colab) zugänglich zu machen.

Eine tragbare ausführbare Datei finden Sie auf der Seite "Releases" oder direkt hier. Laden Sie ein vorgepresstes Tacotron 2- und WaveGlow -Modell von unten herunter.

WARNUNG: Die tragbare ausführbare Datei läuft auf der CPU, was zu einer 10 -fachen Geschwindigkeitsverschwendung im Vergleich zum Ausführen von GPU führt.

Pytorch 1.0

python gui.py

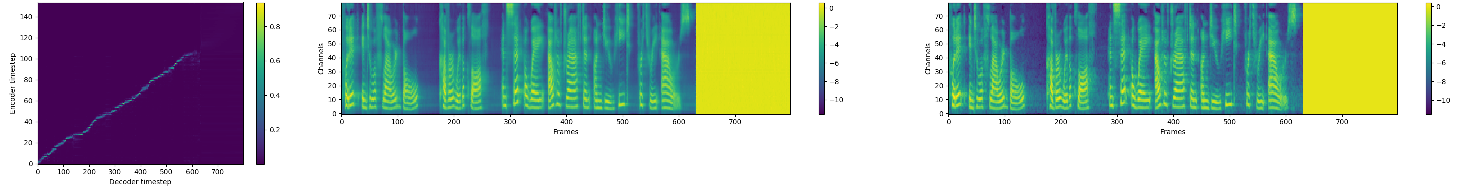

Pytorch -Implementierung der natürlichen TTS -Synthese durch Konditionierung von Wellenzahlen auf Mel -Spektrogram -Vorhersagen.

Diese Implementierung umfasst verteilte und automatische Unterstützung mit gemischter Präzision und verwendet den LJSpeech -Datensatz.

Die verteilte und automatische Unterstützung gemischter Präzision beruht auf Nvidia's Apex und AMP.

Besuchen Sie unsere Website für Audio -Beispiele mit unseren veröffentlichten Modellen Tacotron 2 und WaveGlow.

git clone https://github.com/NVIDIA/tacotron2.gitcd tacotron2git submodule init; git submodule updatesed -i -- 's,DUMMY,ljs_dataset_folder/wavs,g' filelists/*.txtload_mel_from_disk=True in hparams.py ein und aktualisieren Sie die Melspektrogrammpfadepip install -r requirements.txt python train.py --output_directory=outdir --log_directory=logdirtensorboard --logdir=outdir/logdir Das Training unter Verwendung eines vorgeborenen Modells kann standardmäßig zu einer schnelleren Konvergenz führen. Der Datensatz-abhängige Texteinbettungsschichten wird ignoriert

python train.py --output_directory=outdir --log_directory=logdir -c tacotron2_statedict.pt --warm_start python -m multiproc train.py --output_directory=outdir --log_directory=logdir --hparams=distributed_run=True,fp16_run=True jupyter notebook --ip=127.0.0.1 --port=31337NB bei der Durchführung von Melspektrogrammen zur Audio-Synthese stellen Sie sicher, dass Tacotron 2 und der MEL-Decoder auf derselben Melspektrogram-Darstellung trainiert wurden.

Wellenlow schneller als in Echtzeit flow-basierte generative Netzwerk für die Sprachsynthese

NV-Wavenet schneller als Echtzeit-Wellenet.

Diese Implementierung verwendet Code aus den folgenden Repos: Keith Ito, Prem Seetharaman, wie in unserem Code beschrieben.

Wir lassen uns von Ryuchi Yamamotos Tacotron Pytorch -Implementierung inspirieren.

Wir sind den Tacotron 2 -Papierautoren dankbar, insbesondere Jonathan Shen, Yuxuan Wang und Zongheng Yang.