合成するためのGUIラッパー。トググレージスイッチを介してCPUのみの合成を許可します。ポータブルEXEファイルが利用可能です(CPUでのみ実行されます)。

また、ストリーム要素からのTTS寄付アラートもプレイします。

| メインUI | ストリーム要素統合 |

|---|---|

ユーザーフレンドリーなGUIを使用した機械学習ベースのテキストから音声プログラム。ターゲットオーディエンスには、オープンソースTTSプログラムを探しているTwitchストリーマーまたはコンテンツクリエイターが含まれます。このソフトウェアの目的は、TTS合成をオフラインにアクセスできるようにすることです(コーディングエクスペリエンスなし、GPU/Colab)ポータブルExeです。

ポータブル実行可能ファイルは、リリースページ、または直接ここにあります。以下から、前処理されたタコトロン2と波動モデルをダウンロードしてください。

警告:ポータブル実行可能ファイルはCPUで実行され、GPUで実行するのと比較して10倍以上の速度の減速につながります。

Pytorch 1.0

python gui.py

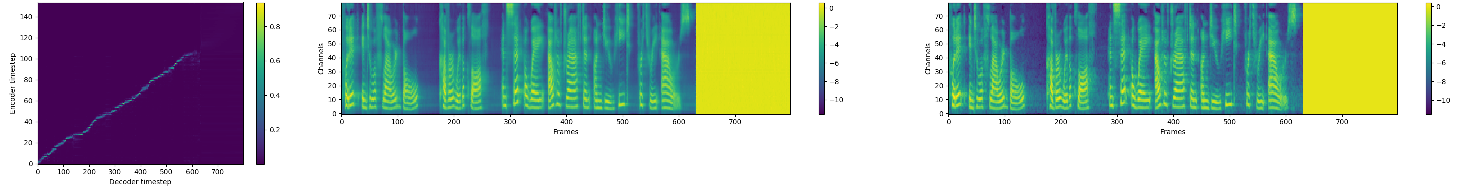

MELスペクトログラム予測にWavenetを条件付けすることによる天然TTS合成のPytorch実装。

この実装には、分散型および自動混合精度サポートが含まれ、ljspeechデータセットを使用します。

分散および自動混合精密サポートは、Nvidiaの頂点とアンプに依存しています。

公開されているTacotron 2とWaveGlowモデルを使用して、オーディオサンプルについては、当社のWebサイトにアクセスしてください。

git clone https://github.com/NVIDIA/tacotron2.gitcd tacotron2git submodule init; git submodule updatesed -i -- 's,DUMMY,ljs_dataset_folder/wavs,g' filelists/*.txthparams.pyでload_mel_from_disk=Trueを設定し、melspectrogramパスを更新しますpip install -r requirements.txt python train.py --output_directory=outdir --log_directory=logdirtensorboard --logdir=outdir/logdir 事前に訓練されたモデルを使用したトレーニングは、デフォルトでより速い収束につながる可能性があり、データセット依存テキストの埋め込み層は無視されます

python train.py --output_directory=outdir --log_directory=logdir -c tacotron2_statedict.pt --warm_start python -m multiproc train.py --output_directory=outdir --log_directory=logdir --hparams=distributed_run=True,fp16_run=True jupyter notebook --ip=127.0.0.1 --port=31337NBメルスペクトルグラムをオーディオ合成に実行するとき、タコトロン2とMELデコーダーが同じMELスペクトル表現でトレーニングされていることを確認してください。

音声合成のためのリアルタイムフローベースの生成ネットワークよりも速い波動

nv-wavenetリアルタイムwavenetよりも速い。

この実装では、次のレポのコードを使用します。KeithIto、Prem Seetharamanは、コードに記載されています。

私たちは、ヤマモトのタコトロンピトルチの実装に触発されています。

タコトロン2の紙の著者、特にジョナサン・シェン、Yuxuan Wang、Zongheng Yangに感謝しています。