中文版本

TNN : Tencent Youtu Lab의 공개 소스 오픈 소스. 또한 크로스 플랫폼, 고성능, 모델 압축 및 코드 조정과 같은 많은 뛰어난 장점이 있습니다. TNN 프레임 워크는 원래 RapidNet 및 NCNN 프레임 워크를 기반으로 모바일 장치의 지원 및 성능 최적화를 더욱 강화합니다. 동시에, 그것은 업계의 주류 오픈 소스 프레임 워크의 고성능 및 우수한 확장 성 특성을 말하고 X86 및 NV GPU에 대한 지원을 확장합니다. 휴대 전화에서 TNN은 Mobile QQ, Weishi 및 Pitu와 같은 많은 응용 프로그램에서 사용되었습니다. Tencent Cloud AI의 기본 가속 프레임 워크로서 TNN은 많은 비즈니스 구현에 대한 가속 지원을 제공했습니다. 모든 사람들은 TNN 추론 프레임 워크의 추가 개선을 촉진하기 위해 협업 구성에 참여할 수 있습니다.

| 얼굴 탐지 (Blazeface) | 얼굴 정렬 (Tencent Youtu Lab에서) | 헤어 세분화 (Tencent Guangying Lab에서) |

|---|---|---|

모델 링크 : tflite tnn | 모델 링크 : TNN | 모델 링크 : TNN |

| 포즈 추정 (Tencent Guangliu에서) | 포즈 추정 (Blazepose) | 중국 OCR |

|---|---|---|

모델 링크 : TNN | 모델 링크 : tflite tnn | 모델 링크 : ONNX TNN |

| 물체 감지 (YOLOV5S) | 객체 감지 (Mobilenetv2-SSD) | 독해력 |

|---|---|---|

모델 링크 : ONNX TNN |  모델 링크 : Tensorflow TNN | 모델 링크 : ONNX TNN |

중국 OCR 데모는 Chinesocr_Lite 프로젝트의 TNN 구현입니다. 가볍고 기울어지고 회전하며 수직 텍스트 인식을 지원합니다.

각 데모에 대한 지원은 다음 표에 나와 있습니다. ✅를 클릭하고 각 데모의 입구 코드를 찾을 수 있습니다.

| 데모 | 팔 | Opencl | 금속 | 화웨이 NPU | Apple NPU | x86 | 쿠다 |

|---|---|---|---|---|---|---|---|

| 얼굴 탐지 (Blazeface) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| 물체 감지 (YOLOV5S) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| 얼굴 정렬 | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| 헤어 세분화 | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| 포즈 추정 (Tencent Guangliu에서) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| 포즈 추정 (blazepose) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| 중국 OCR | ✅ | ✅ | ✅ | ✅ | ✅ | ||

| 독해력 | ✅ | ✅ |

TNN을 사용하는 것은 매우 간단합니다. 훈련 된 모델이있는 경우 3 단계를 통해 대상 플랫폼에 모델을 배포 할 수 있습니다.

훈련 된 모델을 TNN 모델로 변환하십시오. Tensorflow, Pytorch 또는 Caffe를 사용하든이 단계를 완료하는 데 도움이되는 풍부한 도구를 제공합니다. 전환을 쉽게 완료 할 수 있습니다. 자세한 실습 자습서는 TNN 모델을 만드는 방법을 찾을 수 있습니다.

모델 변환을 마치면 두 번째 단계는 대상 플랫폼의 TNN 엔진을 컴파일하는 것입니다. 하드웨어 지원에 따라 ARM/OpenCL/NPU/X86/CUDA와 같은 다양한 가속 솔루션 중에서 선택할 수 있습니다. 이러한 플랫폼의 경우 TNN은 편리한 1 클릭 스크립트를 컴파일 할 수 있습니다. 자세한 단계는 TNN을 컴파일하는 방법을 참조하십시오.

마지막 단계는 컴파일 된 TNN 엔진을 추론하는 것입니다. 응용 프로그램 내에서 TNN에 프로그램 호출을 할 수 있습니다. 우리는 당신이 완성하는 데 도움이되는 참조로 풍부하고 상세한 데모를 제공합니다.

현재 TNN은 다양한 주요 비즈니스에서 시작되었으며 다음 특성은 널리 평가되었습니다.

계산 최적화

낮은 정밀 계산 가속도

메모리 최적화

TNN에서 주류 모델의 성능 : 벤치 마크 데이터

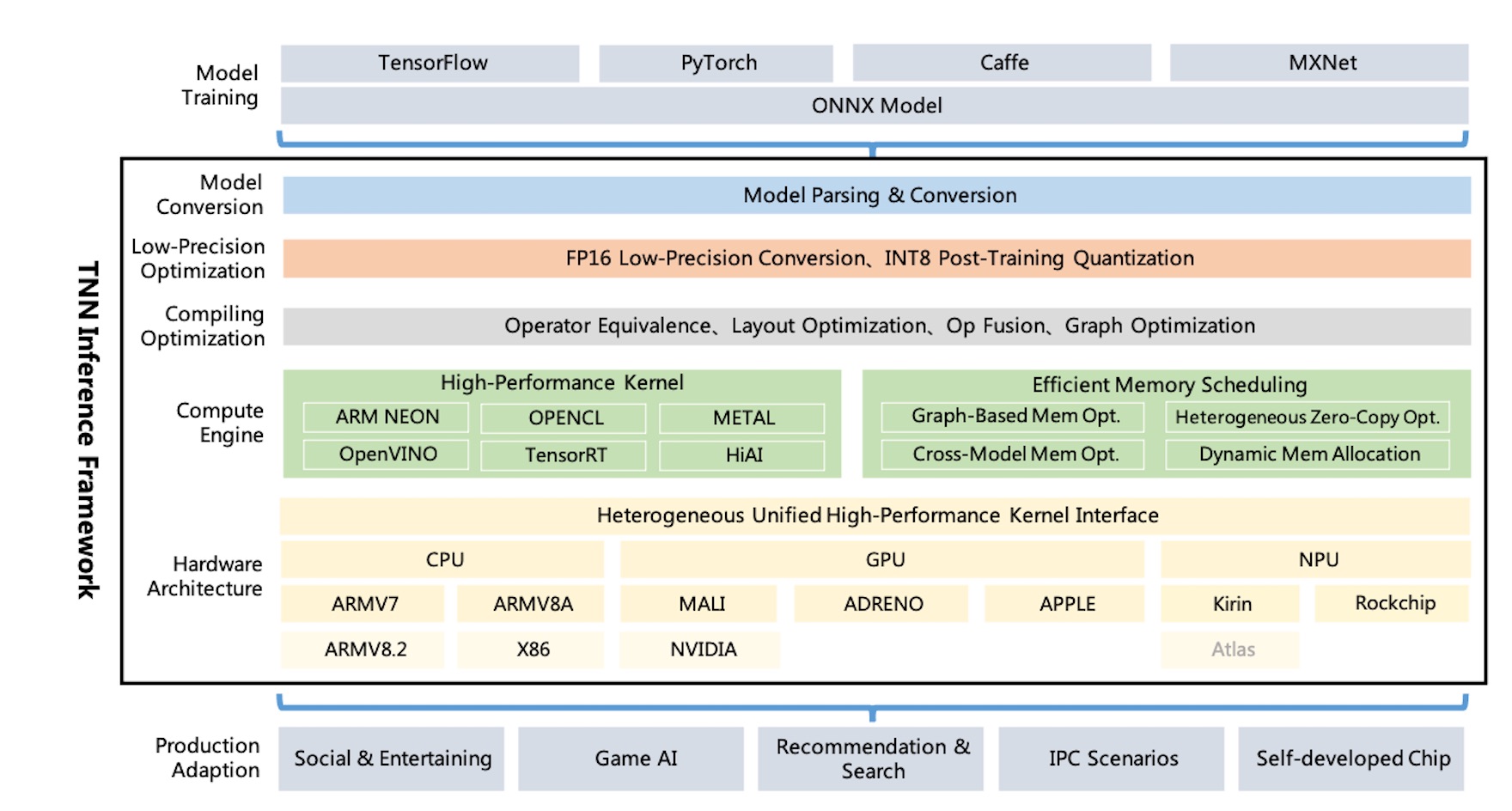

TNN 아키텍처 다이어그램 :

TNN은 Onnx를 통해 Tensorflow, Pytorch, MXNet, Caffe 및 기타 교육 프레임 워크를 지원하여 ONNX 오픈 소스 소사이어티의 지속적인 개선을 활용합니다. 현재 TNN은 대부분의 주류 CNN, NLP 운영자로 구성된 100 개 이상의 ONNX 운영자를 지원합니다.

TNN은 주류 운영 체제 (Android, iOS, Embedded Linux, Windows, Linux)에서 실행되며 ARM CPU, X86 GPU, NPU 하드웨어 플랫폼과 호환됩니다.

TNN은 모델 분석, 그래프 구성, 그래프 최적화, 저수준 하드웨어 적응 및 고성능 커널과 같은 구성 요소를 추상화하고 분리하는 모듈 식 설계를 통해 구성됩니다. "Factory Mode"를 사용하여 더 많은 하드웨어 및 가속 솔루션을 지원하는 비용을 최소화하려는 장치를 등록하고 빌드합니다.

모바일 동적 라이브러리의 크기는 약 400KB에 불과하며 기본 이미지 변환 작업을 제공하며 가벼우 며 편리합니다. TNN은 플랫폼 전체의 통합 모델과 인터페이스를 사용하며 하나의 단일 매개 변수 만 구성하여 쉽게 전환 할 수 있습니다.

TNN은 다음 프로젝트를 참조했습니다.

모든 사람들은 업계에서 최고의 추론 프레임 워크를 구축하기 위해 참여할 수 있습니다.

기술 토론 QQ 그룹 : 704900079 답변 : TNN

QR 코드를 스캔하여 TNN 토론 그룹에 가입하십시오 :