中文版本

TNN: Kerangka inferensi jaringan saraf yang berkinerja tinggi dan berkinerja tinggi bersumber dari laboratorium tencent youtu. Ini juga memiliki banyak keunggulan luar biasa seperti lintas platform, kinerja tinggi, kompresi model, dan penjahit kode. Kerangka kerja TNN semakin memperkuat dukungan dan optimalisasi kinerja perangkat seluler berdasarkan kerangka kerja RapidNet dan NCNN yang asli. Pada saat yang sama, ini mengacu pada kinerja tinggi dan karakteristik skalabilitas yang baik dari kerangka kerja open source arus utama industri, dan memperluas dukungan untuk X86 dan NV GPU. Di ponsel, TNN telah digunakan oleh banyak aplikasi seperti Mobile QQ, Weishi, dan Pitu. Sebagai kerangka kerja akselerasi dasar untuk Tencent Cloud AI, TNN telah memberikan dukungan akselerasi untuk implementasi banyak bisnis. Setiap orang dipersilakan untuk berpartisipasi dalam konstruksi kolaboratif untuk mempromosikan peningkatan lebih lanjut dari kerangka kerja inferensi TNN.

| Deteksi Wajah (Blazeface) | Wajah Penyelarasan (dari Tencent Youtu Lab) | Segmentasi rambut (dari Tencent Guangying Lab) |

|---|---|---|

Tautan Model: TFLITE TNN | Tautan Model: TNN | Tautan Model: TNN |

| Estimasi pose (dari Tencent Guangliu) | Estimasi pose (Blazepose) | OCR Cina |

|---|---|---|

Tautan Model: TNN | Tautan Model: TFLITE TNN | Tautan Model: Onnx TNN |

| Deteksi Objek (YOLOV5S) | Deteksi Objek (MobileNetV2-SSD) | Pemahaman membaca |

|---|---|---|

Tautan Model: Onnx TNN |  Tautan Model: TensorFlow TNN | Tautan Model: Onnx TNN |

Demo OCR Cina adalah implementasi TNN dari Proyek Chinaocr_lite. Ini ringan dan mendukung pengenalan teks miring, diputar dan vertikal.

Dukungan untuk setiap demo ditampilkan di tabel berikut. Anda dapat mengklik ✅ dan menemukan kode masuk untuk setiap demo.

| demo | LENGAN | OpenCl | Logam | Huawei NPU | Apple NPU | X86 | Cuda |

|---|---|---|---|---|---|---|---|

| Deteksi Wajah (Blazeface) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| Deteksi Objek (YOLOV5S) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| Wajah Penyelarasan | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| Segmentasi rambut | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| Estimasi pose (dari Tencent Guangliu) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| Estimasi Pose (Blazepose) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| OCR Cina | ✅ | ✅ | ✅ | ✅ | ✅ | ||

| Pemahaman membaca | ✅ | ✅ |

Sangat mudah untuk menggunakan TNN. Jika Anda memiliki model terlatih, model dapat digunakan pada platform target melalui tiga langkah.

Konversi model terlatih menjadi model TNN. Kami menyediakan banyak alat untuk membantu Anda menyelesaikan langkah ini, apakah Anda menggunakan TensorFlow, Pytorch, atau Caffe, Anda dapat dengan mudah menyelesaikan konversi. Tutorial langsung yang terperinci dapat ditemukan di sini cara membuat model TNN.

Setelah Anda selesai mengonversi model, langkah kedua adalah mengkompilasi mesin TNN dari platform target. Anda dapat memilih di antara solusi akselerasi yang berbeda seperti ARM/OPENCL/METAL/NPU/X86/CUDA sesuai dengan dukungan perangkat keras. Untuk platform ini, TNN menyediakan skrip satu klik yang nyaman untuk dikompilasi. Untuk langkah -langkah terperinci, silakan merujuk cara mengkompilasi tnn.

Langkah terakhir adalah menggunakan mesin TNN yang dikompilasi untuk inferensi. Anda dapat melakukan panggilan program ke TNN di dalam aplikasi Anda. Kami memberikan demo yang kaya dan terperinci sebagai referensi untuk membantu Anda menyelesaikannya.

Saat ini, TNN telah diluncurkan di berbagai bisnis besar, dan karakteristik berikut telah dipuji secara luas.

Optimalisasi Komputasi

Percepatan komputasi presisi rendah

Optimasi memori

Kinerja model utama pada TNN: data benchmark

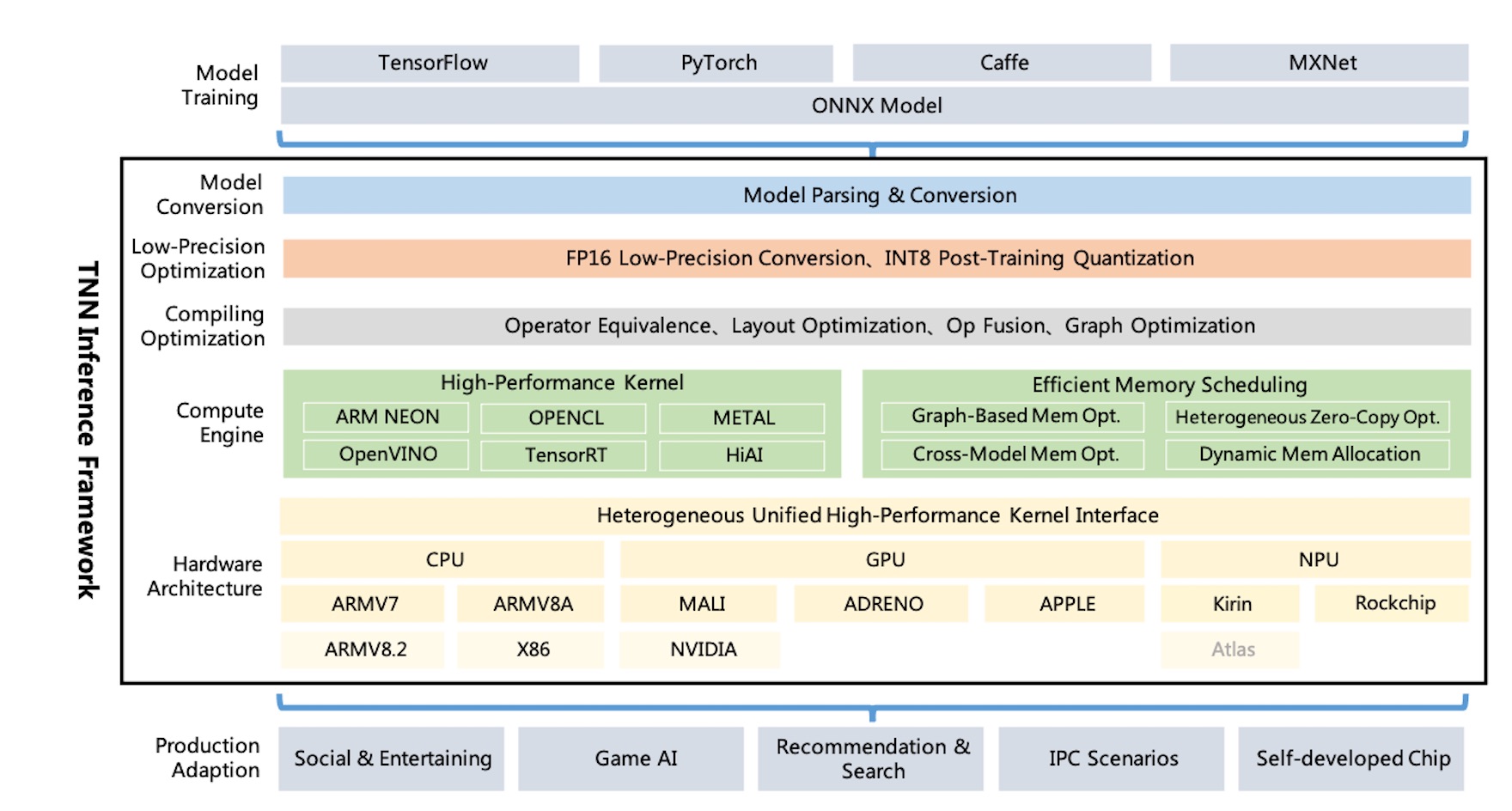

Diagram Arsitektur TNN :

TNN mendukung TensorFlow, Pytorch, Mxnet, Caffe, dan kerangka kerja pelatihan lainnya melalui ONNX, memanfaatkan peningkatan berkelanjutan dari masyarakat open-source Onnx. Saat ini, TNN mendukung 100+ operator ONNX, yang terdiri dari sebagian besar operator CNN, NLP utama yang dibutuhkan.

TNN berjalan pada sistem operasi utama (Android, iOS, Linux tertanam, Windows, Linux), dan kompatibel dengan CPU ARM, X86 GPU, platform perangkat keras NPU.

TNN dibangun melalui desain modular, yang abstrak dan mengisolasi komponen seperti analisis model, konstruksi grafik, optimasi grafik, adaptasi perangkat keras tingkat rendah, dan kernel berkinerja tinggi. Ini menggunakan "mode pabrik" untuk mendaftarkan dan membangun perangkat, yang mencoba meminimalkan biaya lebih banyak solusi perangkat keras dan akselerasi.

Ukuran pustaka dinamis seluler hanya sekitar 400kb, dan menyediakan operasi konversi gambar dasar, yang ringan dan nyaman. TNN menggunakan model dan antarmuka terpadu di seluruh platform dan dapat beralih dengan mudah dengan mengkonfigurasi hanya satu parameter tunggal.

TNN merujuk proyek -proyek berikut :

Setiap orang dipersilakan untuk berpartisipasi untuk membangun kerangka kerja inferensi terbaik di industri ini.

Diskusi Teknis QQ Group: 704900079 Jawaban: TNN

Pindai kode QR untuk bergabung dengan grup diskusi TNN :