中文版本

TNN: إطار عمل عالي الأداء وخفيف الوزن الشبكة الفاتح مفتوح من قبل Tencent YouTu Lab. كما أن لديها العديد من المزايا المعلقة مثل المنصات المتقاطعة والأداء العالي وضغط النماذج وخياطة الكود. يعزز إطار عمل TNN دعم الأجهزة المحمولة وأداء الأداء على أساس إطارات RapidNet و NCNN الأصلية. في الوقت نفسه ، فإنه يشير إلى خصائص الأداء العالي والتوسيع الجيد لأطر المصدر المفتوح في الصناعة ، وتوسيع دعم وحدات معالجة الرسومات X86 و NV. على الهاتف المحمول ، تم استخدام TNN من قبل العديد من التطبيقات مثل Mobile QQ و Weishi و Pitu. كإطار تسارع أساسي لـ Tencent Cloud AI ، قدمت TNN دعم تسريع لتنفيذ العديد من الشركات. الجميع مرحب بهم للمشاركة في البناء التعاوني لتعزيز التحسين الإضافي لإطار الاستدلال TNN.

| اكتشاف الوجه (Blazeface) | مواءمة الوجه (من Tencent Youtu Lab) | تجزئة الشعر (من مختبر Tencent Guangying) |

|---|---|---|

رابط النموذج: tflite tnn | رابط النموذج: TNN | رابط النموذج: TNN |

| تشكل التقدير (من Tencent Guangliu) | تشكل التقدير (Blazepose) | الصينية المعرفة التعريفي |

|---|---|---|

رابط النموذج: TNN | رابط النموذج: tflite tnn | رابط النموذج: ONNX TNN |

| اكتشاف الكائنات (YOLOV5S) | الكشف عن الكائن (Mobilenetv2-SSD) | القراءة الفهم |

|---|---|---|

رابط النموذج: ONNX TNN |  رابط النموذج: TensorFlow TNN | رابط النموذج: ONNX TNN |

العرض الصيني التعريفي التعريفي هو تنفيذ TNN لمشروع الصينيين. إنه خفيف الوزن ويدعم التعرف على النص المائل والدوران والرأسي.

يظهر دعم كل عرض تجريبي في الجدول التالي. يمكنك النقر فوق ✅ والعثور على رمز الدخول لكل عرض تجريبي.

| العرض التوضيحي | ذراع | opencl | معدن | Huawei NPU | Apple NPU | x86 | كودا |

|---|---|---|---|---|---|---|---|

| اكتشاف الوجه (Blazeface) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| اكتشاف الكائنات (YOLOV5S) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| مواءمة الوجه | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| تجزئة الشعر | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| تشكل التقدير (من Tencent Guangliu) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| التقدير الوضع (Blazepose) | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ |

| الصينية المعرفة التعريفي | ✅ | ✅ | ✅ | ✅ | ✅ | ||

| القراءة الفهم | ✅ | ✅ |

من السهل جدًا استخدام TNN. إذا كان لديك نموذج مدرب ، فيمكن نشر النموذج على النظام الأساسي المستهدف من خلال ثلاث خطوات.

تحويل النموذج المدرب إلى نموذج TNN. نحن نقدم ثروة من الأدوات لمساعدتك على إكمال هذه الخطوة ، سواء كنت تستخدم Tensorflow أو Pytorch أو Caffe ، يمكنك بسهولة إكمال التحويل. يمكن العثور على دروس تدريبية مفصلة على كيفية إنشاء نموذج TNN.

عندما تنتهي من تحويل النموذج ، فإن الخطوة الثانية هي تجميع محرك TNN للمنصة المستهدفة. يمكنك الاختيار من بين حلول التسارع المختلفة مثل ARM/OPENCL/METAL/NPU/X86/CUDA وفقًا لدعم الأجهزة. بالنسبة لهذه المنصات ، توفر TNN نصوصًا مريحة بنقرة واحدة لتجميعها. لخطوات مفصلة ، يرجى الرجوع إلى كيفية تجميع TNN.

الخطوة الأخيرة هي استخدام محرك TNN المترجم للاستدلال. يمكنك إجراء مكالمات البرنامج إلى TNN داخل تطبيقك. نحن نقدم عرضًا تجريبيًا غنيًا ومفصلًا كمرجع لمساعدتك في إكمال.

في الوقت الحاضر ، تم إطلاق TNN في العديد من الشركات الكبرى ، وتمت الإشادة على خصائصها التالية على نطاق واسع.

تحسين الحساب

تسريع حساب منخفض الدقة

تحسين الذاكرة

أداء النماذج السائدة على TNN: البيانات القياسية

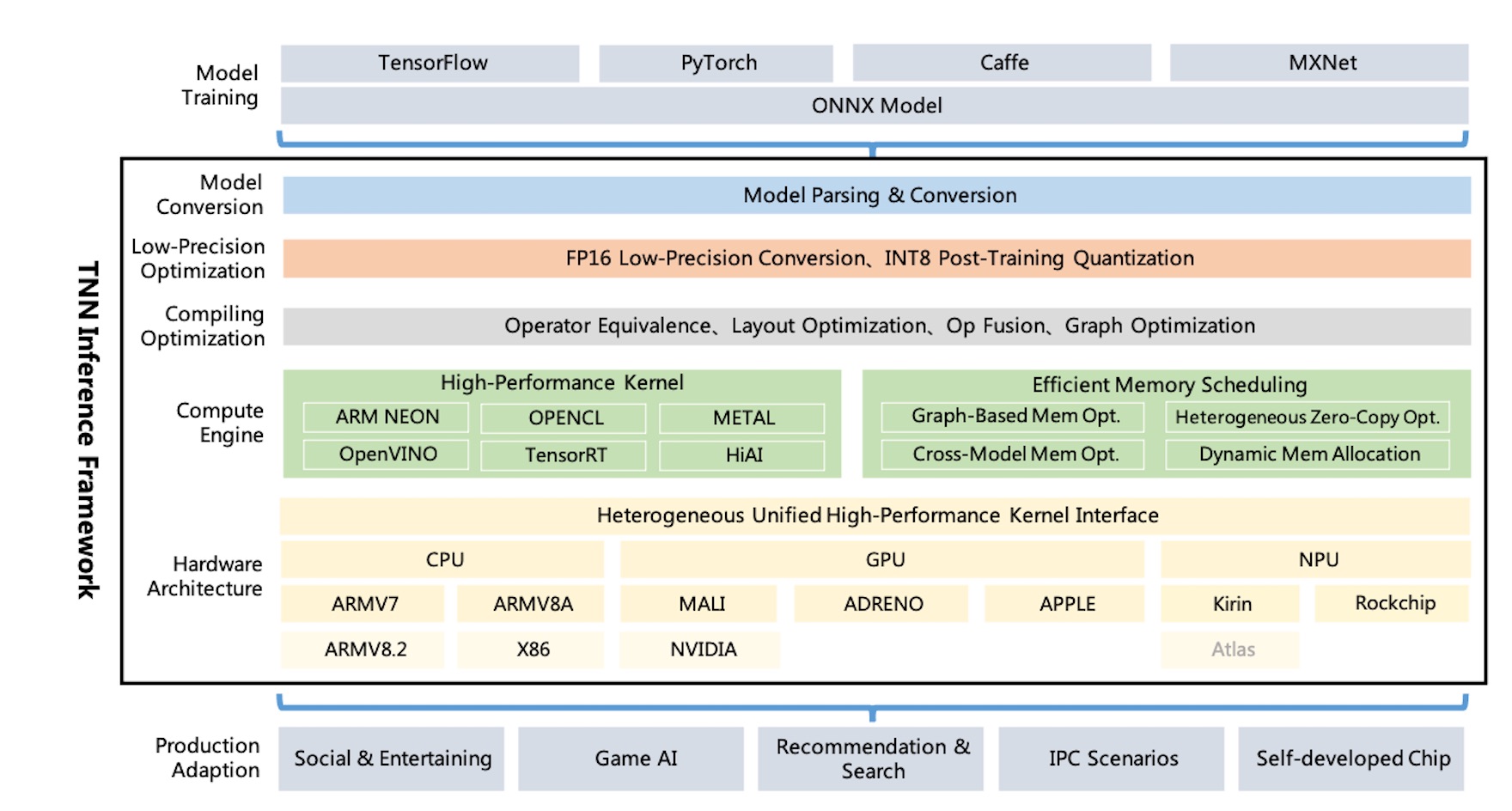

مخطط العمارة tnn :

يدعم TNN TensorFlow و Pytorch و MXNET و CAFFE وأطر التدريب الأخرى من خلال ONNX ، واستفاد من التحسين المستمر لجمعية ONNX مفتوحة المصدر. حاليًا ، يدعم TNN أكثر من 100 مشغلي ONNX ، الذين يتكونون من معظم مشغلات CNN ، NLP الرئيسية اللازمة.

يعمل TNN على أنظمة التشغيل السائدة (Android ، iOS ، Linux ، Windows ، Linux) ، وهو متوافق مع CPU ARM و X86 GPU و NPU Hardware.

يتم إنشاء TNN من خلال التصميم المعياري ، والذي يقوم بتجريد وعزل مكونات مثل تحليل النماذج ، وبناء الرسم البياني ، وتحسين الرسم البياني ، والتكيف مع الأجهزة منخفضة المستوى ، ونواة عالية الأداء. يستخدم "وضع المصنع" لتسجيل الأجهزة وبناءها ، والتي تحاول تقليل تكلفة دعم المزيد من حلول الأجهزة والتسارع.

يبلغ حجم المكتبة الديناميكية المتنقلة حوالي 400 كيلو بايت فقط ، ويوفر عمليات تحويل الصور الأساسية ، والتي تكون خفيفة الوزن ومريحة. يستخدم TNN نماذج وواجهات موحدة عبر الأنظمة الأساسية ويمكنها التبديل بسهولة عن طريق تكوين معلمة واحدة فقط.

أشار TNN إلى المشاريع التالية :

الجميع مدعوون للمشاركة في بناء أفضل إطار استدلال في الصناعة.

المناقشة الفنية مجموعة QQ: 704900079 الإجابة: TNN

مسح رمز الاستجابة السريعة للانضمام إلى مجموعة مناقشة TNN :