이 저장소는 "LLMS (Lange Language Models)"기사에서 영감을 얻었으며 Stanford Sentiment TreeBank (SST-2) 데이터 세트와 LORA (대형 언어 모델의 낮은 순위 적응) 미세 조정을 사용하여 텍스트 분류 모델을 훈련하기위한 코드가 포함되어 있습니다. Lora는 언어 모델을보다 적응력 있고 효율적으로 만들 수있는 방법입니다. Lora는 각 작업마다 전체 모델을 다시 훈련하는 대신 사전 훈련 된 모델을 동결하고 각 모델 레이어에 작은 훈련 가능한 행렬을 추가합니다. 이 행렬은 모델이 모든 매개 변수를 변경하지 않고 다른 작업에 적응하는 데 도움이됩니다.

이 저장소에서 코드를 사용하기 전에 필요한 라이브러리를 설치해야합니다. 다음 명령을 실행하여이를 수행 할 수 있습니다.

! pip install datasets

! pip install transformers

! pip install peft

! pip install evaluate이 명령은 데이터 세트, 변압기, LORA 및 평가 측정 항목으로 작업하는 데 필요한 Python 라이브러리를 설치합니다.

이 저장소에서 코드를 사용하는 방법은 다음과 같습니다.

SST-2 데이터 세트로드 :

코드는 Hugging Face datasets 라이브러리를 사용하여 SST-2 데이터 세트를로드합니다. SST-2는 감정 레이블로 주석이 달린 영화 리뷰의 문장으로 구성됩니다. SST-2 데이터 세트에 대한 자세한 내용은 여기를 참조하십시오.

LORA 모델 아키텍처 정의 :

이 코드는 LORA 기술을 사용하여 텍스트 분류를 위해 미리 훈련 된 언어 모델을 미세 조정합니다. LORA는 중량 차이의 낮은 순위 특성을 활용하여 모델을 작업에 효율적으로 조정합니다. LORA의 구현은 코드에서 찾을 수 있습니다.

데이터 세트 토큰 화 :

데이터 세트는 모델의 토큰 화기를 사용하여 토큰 화되었으며 [PAD] 와 같은 특수 토큰이 아직 존재하지 않으면 추가됩니다.

LORA 모델 교육 :

이 코드는 훈련 하이퍼 파라미터를 정의하고 제공된 데이터 세트를 사용하여 LORA 적응 모델을 훈련시킵니다. 학습 속도, 배치 크기 및 에포크 수와 같은 교육 논쟁은 training_args 변수에서 조정할 수 있습니다.

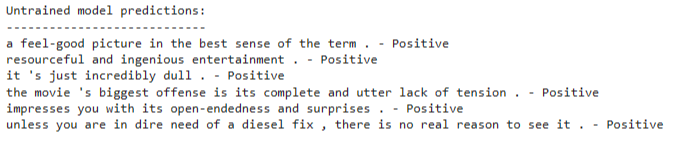

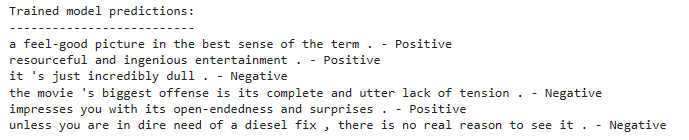

훈련 된 LORA 모델로 추론하십시오 .

훈련 후, 훈련 된 LORA 적응 모델을 사용하여 새로운 텍스트 입력에 대한 추론을 할 수 있습니다. 코드는 모델을로드하고 예제 문장 목록을 예측하는 방법을 보여줍니다.

이 코드는 미리 훈련 된 언어 모델 아키텍처를 기반으로 텍스트 분류 모델을 사용합니다. LORA 미세 조정은이 미리 훈련 된 모델을 효율적으로 조정하기 위해 적용됩니다. LORA 기술은 적응 성능을 향상시키기 위해 중량 차이의 낮은 순위 구조를 활용합니다.

LORA 기술에 대한 자세한 정보는 LORA 용지를 참조하십시오.

로라 적응 모델을 훈련 시키려면 다음을 수행하십시오.

설치 섹션에 언급 된대로 필요한 라이브러리를 설치하십시오.

교육 데이터 세트를 정의하거나 제공된 SST-2 데이터 세트를 사용하십시오.

코드에서 모델 아키텍처 및 하이퍼 파라미터를 구성하십시오.

교육 코드를 실행하면 데이터 세트의 LORA 기술을 사용하여 모델이 미세 조정됩니다.

훈련 후, 훈련 된 LORA 적응 모델을 사용하여 새로운 텍스트 입력에 대한 추론을 할 수 있습니다. 이것을하기 위해 :

코드에 표시된대로 훈련 된 LORA 적응 모델을로드하십시오.

모델의 토큰 화기를 사용하여 입력 텍스트를 토큰 화하십시오.

토큰 화 된 입력을 감정 분류를 위해 모델에 전달하십시오.

이 모델은 입력 텍스트에 긍정적인지 부정적인 감정이 있는지 예측합니다.