Este repositorio está inspirado en el artículo "Modelos de lenguaje grande (LLMS)" y contiene código para capacitar a un modelo de clasificación de texto utilizando el conjunto de datos de Stanford Sentiment Treebank (SST-2) y Lora (adaptación de bajo rango de modelos de idiomas grandes). Lora es una forma de hacer que el modelo de idioma sea más adaptable y eficiente. En lugar de entrenar todo el modelo nuevamente para cada tarea, Lora congela el modelo previamente capacitado y agrega matrices capacitables más pequeñas a cada capa de modelo. Estas matrices ayudan al modelo a adaptarse a diferentes tareas sin cambiar todos los parámetros.

Antes de usar el código en este repositorio, debe instalar las bibliotecas requeridas. Puede hacer esto ejecutando los siguientes comandos:

! pip install datasets

! pip install transformers

! pip install peft

! pip install evaluateEstos comandos instalarán las bibliotecas de Python necesarias para trabajar con conjuntos de datos, transformadores, Lora y métricas de evaluación.

Aquí le mostramos cómo usar el código en este repositorio:

Cargue el conjunto de datos SST-2 :

El código carga el conjunto de datos SST-2 utilizando la biblioteca datasets abrazos de abrazos. SST-2 consiste en oraciones de reseñas de películas, anotadas con etiquetas de sentimientos. Puede encontrar más información sobre el conjunto de datos SST-2 aquí.

Defina la arquitectura del modelo Lora :

El código utiliza la técnica Lora para ajustar un modelo de lenguaje previamente capacitado para la clasificación de texto. Lora adapta eficientemente el modelo a la tarea aprovechando la propiedad de las diferencias de peso de bajo rango. La implementación de Lora se puede encontrar en el código.

Tokenize el conjunto de datos :

El conjunto de datos se tokeniza usando el tokenizador del modelo, y se agregan tokens especiales como [PAD] si aún no existen.

Entrena el modelo Lora :

El código define hiperparámetros de capacitación y entrena el modelo adaptado a Lora utilizando el conjunto de datos proporcionado. Argumentos de capacitación como la tasa de aprendizaje, el tamaño del lote y el número de épocas se pueden ajustar en la variable training_args .

Inferir con el modelo Lora entrenado :

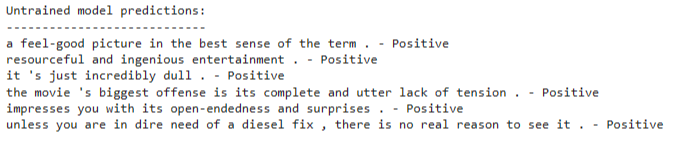

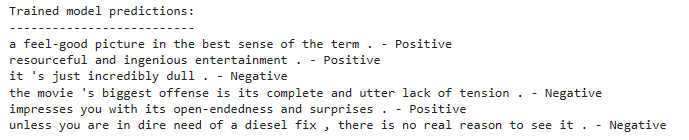

Después del entrenamiento, puede usar el modelo capacitado adaptado a Lora para inferencia en nuevas entradas de texto. El código demuestra cómo cargar el modelo y hacer predicciones en una lista de oraciones de ejemplo.

El código utiliza un modelo de clasificación de texto basado en una arquitectura de modelo de lenguaje previamente capacitado. El ajuste fino de Lora se aplica para adaptar este modelo previamente capacitado de manera eficiente. La técnica LORA aprovecha la estructura de bajo rango de las diferencias de peso para mejorar el rendimiento de la adaptación.

Para obtener información detallada sobre la técnica Lora, puede consultar el documento de Lora.

Para entrenar el modelo adaptado a Lora, siga estos pasos:

Instale las bibliotecas requeridas como se menciona en la sección de instalación.

Defina su conjunto de datos de capacitación o use el conjunto de datos SST-2 proporcionado.

Configure la arquitectura del modelo y los hiperparámetros en el código.

Ejecute el código de entrenamiento y el modelo se ajustará utilizando la técnica Lora en su conjunto de datos.

Después del entrenamiento, puede usar el modelo capacitado adaptado a Lora para inferencia en nuevas entradas de texto. Para hacer esto:

Cargue el modelo entrenado adaptado a Lora como se demuestra en el código.

Tokenice su texto de entrada utilizando el tokenizador del modelo.

Pase la entrada tokenizada al modelo para la clasificación de sentimientos.

El modelo predecirá si el texto de entrada tiene un sentimiento positivo o negativo.