Dieses Repository ist durch den Artikel "Feinabstimmung große Sprachmodelle (LLMs)) inspiriert und enthält Code für das Training eines Textklassifizierungsmodells unter Verwendung des Datensatzes Sentiment Treebank (SST-2) Stanford Sentiment Treebank (SST-2) und LORA (Low-Rang-Anpassung von großer Sprachmodellen) Feinabstimmung. Lora ist eine Möglichkeit, das Sprachmodell anpassungsfähiger und effizienter zu gestalten. Anstatt das gesamte Modell für jede Aufgabe erneut zu trainieren, friert LORA das vorgebreitete Modell ein und fügt jeder Modellschicht kleinere trainierbare Matrizen hinzu. Diese Matrizen helfen, das Modell an verschiedene Aufgaben anzupassen, ohne alle Parameter zu ändern.

Bevor Sie den Code in diesem Repository verwenden, müssen Sie die erforderlichen Bibliotheken installieren. Sie können dies tun, indem Sie die folgenden Befehle ausführen:

! pip install datasets

! pip install transformers

! pip install peft

! pip install evaluateDiese Befehle installieren die erforderlichen Python -Bibliotheken für die Arbeit mit Datensätzen, Transformatoren, LORA und Evaluierungsmetriken.

Hier erfahren Sie, wie Sie den Code in diesem Repository verwenden:

Laden Sie den SST-2-Datensatz :

Der Code lädt den SST-2-Datensatz mit der Umarmungs-Face datasets -Bibliothek. SST-2 besteht aus Sätzen von Filmkritiken, die mit Stimmungslabels kommentiert werden. Weitere Informationen zum SST-2-Datensatz finden Sie hier.

Definieren Sie die LORA -Modellarchitektur :

Der Code verwendet die LORA-Technik, um ein vorgebildetes Sprachmodell für die Textklassifizierung zu optimieren. Lora passt das Modell effizient an die Aufgabe an, indem die Niedrig-Rang-Eigenschaft von Gewichtsunterschieden nutzt. Die Implementierung von LORA finden Sie im Code.

Tokenize den Datensatz :

Der Datensatz wird mit dem Tokenizer des Modells tokenisiert, und spezielle Token wie [PAD] werden hinzugefügt, wenn sie noch nicht existieren.

Trainieren Sie das Lora -Modell :

Der Code definiert Schulungshyperparameter und trainiert das LORA-adaptierte Modell mit dem bereitgestellten Datensatz. Trainingsargumente wie die Lernrate, die Chargengröße und die Anzahl der Epochen können in der Variablen training_args angepasst werden.

Schließen mit dem ausgebildeten LORA -Modell :

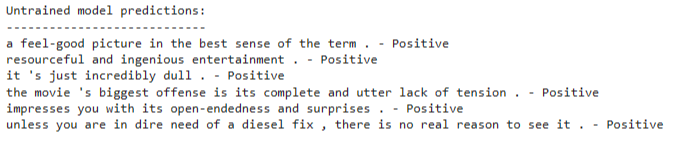

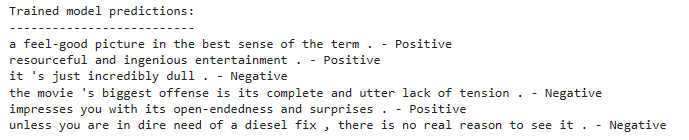

Nach dem Training können Sie das ausgebildete LORA-angepasste Modell für die Folgerung neuer Texteingaben verwenden. Der Code zeigt, wie das Modell geladen und Vorhersagen auf einer Liste von Beispielsätzen getroffen wird.

Der Code verwendet ein Textklassifizierungsmodell, das auf einer vorgebildeten Sprachmodellarchitektur basiert. Die Feinabstimmung von Lora wird angewendet, um dieses vorgebrachte Modell effizient anzupassen. Die LORA-Technik nutzt die niedrige Struktur von Gewichtsunterschieden, um die Anpassungsleistung zu verbessern.

Ausführliche Informationen zur LORA -Technik finden Sie im Lora -Papier.

Befolgen Sie die folgenden Schritte, um das LORA-adaptierte Modell zu trainieren:

Installieren Sie die erforderlichen Bibliotheken wie im Abschnitt Installation erwähnt.

Definieren Sie Ihren Trainingsdatensatz oder verwenden Sie den bereitgestellten SST-2-Datensatz.

Konfigurieren Sie die Modellarchitektur und die Hyperparameter im Code.

Führen Sie den Trainingscode aus, und das Modell wird mit der LORA-Technik in Ihrem Datensatz fein abgestimmt.

Nach dem Training können Sie das ausgebildete LORA-angepasste Modell für die Folgerung neuer Texteingaben verwenden. Um dies zu tun:

Laden Sie das ausgebildete LORA-angepasste Modell, wie im Code gezeigt.

Tokenisieren Sie Ihren Eingabetxt mit dem Tokenizer des Modells.

Übergeben Sie die tokenisierte Eingabe an das Modell zur Klassifizierung der Stimmung.

Das Modell wird vorausgesagt, ob der Eingabtext eine positive oder negative Stimmung hat.