プロジェクトの動機/コースの紹介/コースリソース/教科書カタログ/ノート/フォルダーの説明/オーガナイザー/貢献者

「Hand-on Learning Deep Learning」は、 Li Mu氏(米国カーネギーメロン大学のコンピューターサイエンス博士AWSの上級主任科学者)が教えた一連のディープラーニングビデオです。このプロジェクトは、冬休みの学習中に詳細なマークダウンノートと関連するJupyterコードを収集します。誰かにバラを与えると、あなたの手に香りが残されます。すべてのマークダウンノートをオープンします。私たちは自分で学びながら、誰もが教師のムー・ムーの「携帯学習の深い学習」を学び、習得することも役立つことを願っています。

このプロジェクトの機能:

- マークダウンノートは、元のコースビデオに1つずつ対応しています。これは、クラスを聴きながら誰もが理解するのに役立ちます。

- Jupyterコードには、全員がより速く練習を始めるのを助けるための詳細な中国の注釈があります。

合計73のコースビデオがあり、1つのビデオの平均期間は30分以内です。この研究は、冬休みから40日以内に完了することができると予想されます。

このプロジェクトで使用されているバッジは、インターネットからのものです。画像の著作権を侵害している場合は、削除するにはお問い合わせください。ありがとう。

通常、深い学習に言及するとき、深い学習は機械学習のほんの一部であることを忘れてしまい、機械学習とは無関係に別のモジュールであると考えています。これは、深い学習がリリースされる前に、より長い歴史を持つ規律としての機械学習が現実の世界で狭い範囲のアプリケーションを持っていたためです。音声認識、コンピュータービジョン、自然言語処理などの分野では、機械学習は、必要なドメインの知識が大量にあり、現実が非常に複雑であるため、これらのドメインの問題を解決するためのソリューションのほんの一部に過ぎないことがよくあります。しかし、過去数年間で、深い学習の出現と応用は世界に驚きをもたらし、コンピュータービジョン、自然言語処理、自動音声認識、強化学習、統計的モデリングの急速な発展を促進し、徐々にトレンドをリードし、世界の人工知能革命の波を引き起こしました。

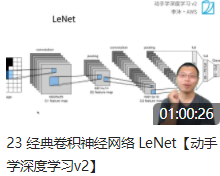

コース「携帯層の深い学習」には、線形ニューラルネットワーク、多層知覚マシンなど、機械学習に関する基本的な知識が少ないだけではありません。現在、最先端のアプリケーションで使用されているさまざまなディープラーニングモデルもあります。レネット、ResNet、LSTM、BERT ...同時に、各章の説明にはコード、教科書なども装備されています。

さらに、このコースには対応するコード実装があります。各章には対応するJupyterメモ帳があり、モデルの完全なPythonコードを提供し、すべてのリソースをオンラインで無料で入手できます。

「Hand-on Deep Learning」(中国語版)と英語版の深い学習に飛び込みます0.17.1ドキュメント教科書カタログと章のリンクは次のとおりです。

| 章 | 中国語版 | 英語版 |

|---|---|---|

| 1 | 序文 | 導入 |

| 2 | 準備知識 | 予備 |

| 3 | 線形ニューラルネットワーク | 線形ニューラルネットワーク |

| 4 | マルチレイヤーセンシングマシン | 多層パーセプロン |

| 5 | ディープラーニングコンピューティング | ディープラーニング計算 |

| 6 | 畳み込みニューラルネットワーク | 畳み込みニューラルネットワーク |

| 7 | 現代の畳み込みニューラルネットワーク | 現代の畳み込みニューラルネットワーク |

| 8 | 再発性ニューラルネットワーク | 再発性ニューラルネットワーク |

| 9 | 最新の再発ニューラルネットワーク | 最新の再発ニューラルネットワーク |

| 10 | 注意メカニズム | 注意メカニズム |

| 11 | 最適化アルゴリズム | 最適化アルゴリズム |

| 12 | 計算パフォーマンス | 計算パフォーマンス |

| 13 | コンピュータービジョン | コンピュータービジョン |

| 14 | 自然言語処理:トレーニング前 | 自然言語処理:事前トレーニング |

| 15 | 自然言語処理:アプリケーション | 自然言語処理アプリケーション |

| 16 | 推奨システム | 推奨システム |

| 17 | 敵対的なネットワークを生成します | 生成的敵対ネットワーク |

| 18 | 付録:深い学習における数学の基本 | 付録:深い学習のための数学 |

| 19 | 付録:ディープラーニングツール | 付録:深い学習のためのツール |

| ビデオ | メモ | 配布資料 | コード | 貢献者 |

|---|---|---|---|---|

| 00-preview | 配布資料 |  | |

| 01コーススケジュール | 配布資料 |  | |

| 02深い学習への紹介 | 配布資料 |   | |

| 03インストール | 配布資料 |   | |

| 04-DATA操作とデータ前処理 | 配布資料 | jupyterコード |   |

| 05線形代数 | 配布資料 |   | |

| 06マトリックス計算 | 配布資料 |  | |

| 07-Chengduルールと自動派生 | 配布資料 | jupyterコード |   |

| 08線形回帰 +基本最適化アルゴリズム | 講義ノート1 2 | jupyterコード |  |

| 09ソフトマックス回帰 | 講義ノート1 2 | jupyterコード |   |

| 10マルチ層センシングマシン | 講義ノート1 2 | jupyterコード |   |

| 11モデルの選択 +過剰フィッティングとアンダーフィッティング | 講義ノート1 2 |   | |

| 12体重不況 | 配布資料 | jupyterコード |   |

| 13発見方法 | 配布資料 | jupyterコード |  |

| 14数値安定性 | 講義ノート1 2 |  | |

| 住宅価格の15実格子の予測 | 配布資料 | jupyterコード |   |

| 16-Pytorch Neural Networkの基本 | 配布資料 | jupyterコード |   |

| 17-使用してGPUを購入します | 配布資料 | jupyterコード |   |

| 予測住宅価格競争の18サマリー | 配布資料 |   | |

| 19コノボリューション層 | 講義ノート1 2 | jupyterコード |  |

| 20フィルとストライド | 配布資料 | jupyterコード |  |

| 21-Multi-入力および出力チャネル | 配布資料 | jupyterコード |   |

| 22プーリング層 | 配布資料 | jupyterコード |   |

| 23-lenet | 配布資料 | jupyterコード |   |

| 24-Alexnet | 配布資料 | jupyterコード |  |

| ブロックを使用した25ネットワークVGG | 配布資料 | jupyterコード |  |

| 26-nin | 配布資料 | jupyterコード |  |

| 27-GOOGLENET | 配布資料 | jupyterコード |   |

| 28バッチ正規化 | 配布資料 | jupyterコード |   |

| 29抵抗性ネットワークResNet | 配布資料 |   | |

| 30パート2競争を終了します | 配布資料 |  | |

| 31-CPUおよびGPU | 配布資料 |   | |

| 32深い学習ハードウェア | 配布資料 |  | |

| 33シングルマシン並行して複数のカード | 配布資料 |   | |

| 34-Multi-GPUトレーニングの実装 | 配布資料 | jupyterコード |   |

| 35分散トレーニング | 配布資料 |   | |

| 36-dataの増強 | 配布資料 | jupyterコード |   |

| 37-Fine調整 | 配布資料 | jupyterコード |   |

| 38-第2競争の葉分類の結果 | 配布資料 |  | |

| 39-Practical Kaggle Competition-1 | 配布資料 |   | |

| 40-Practical Kaggle Competition-2 | 配布資料 | jupyterコード |   |

| 41-オブジェクトの検出とデータセット | 配布資料 |   | |

| [42-Anchorフレーム] | 配布資料 |   | |

| 43葉分類競争の技術的要約 | 配布資料 |  | |

| 44-オブジェクト検出アルゴリズム | 講義ノート123 |  | |

| 45-SSD実装 | 配布資料 | jupyterコード |   |

| 46セマンなセグメンテーションとデータセット | 配布資料 | jupyterコード |   |

| 47移動畳み込み | 講義ノート1 2 |   | |

| 48-fcn | 配布資料 | jupyterコード |  |

| 49スタイルの移行 | 配布資料 | jupyterコード |  |

| 50コース競争 | 配布資料 |  | |

| 51-シーケンスモデル | 配布資料 |   | |

| 52テキスト前処理 | 配布資料 | jupyterコード |   |

| 53言語モデル | 配布資料 |   | |

| 54-Recurrent Neural Network | 配布資料 |   | |

| 55-RNN実装 | 配布資料 | jupyterコード |  |

| 56-gru | 配布資料 | jupyterコード |  |

| 57-LSTM | 配布資料 |   | |

| 58深い再発性ニューラルネットワーク | 配布資料 | jupyterコード |   |

| [59双方向の再発性ニューラルネットワーク] | 配布資料 |   | |

| 60マシン翻訳データセット | 配布資料 | jupyterコード |   |

| 61-Encoder-Decoderアーキテクチャ | 配布資料 |  | |

| 62-シーケンスからシーケンス学習 | 配布資料 | jupyterコード |   |

| 63バンチ検索 | 配布資料 |  | |

| 64-注意メカニズム | 配布資料 | jupyterコード |   |

| 65-注意スコア | 配布資料 |   | |

| [注意を使用して66-seq] | 配布資料 |   | |

| 67自己攻撃 | 配布資料 | jupyterコード |   |

| 68トランスフォーマー | 配布資料 | jupyterコード |  |

| 69-バートプリトレーニング | 配布資料 |   | |

| 70-バートの細かい調整 | 配布資料 |   | |

| [ターゲット検出競争の71サマリー] | 配布資料 |   | |

| 72-最適化アルゴリズム | 配布資料 |  | |

| 73コースの要約と高度な学習 | 配布資料 |  |

このプロジェクトを編成してくれた次の学生に感謝します

このプロジェクトへのサポートと貢献について、次の学生に感謝します