Classification sur CIFAR-10/100 et ImageNet avec Pytorch.

./utils/logger.py ) git clone --recursive https://github.com/bearpaw/pytorch-classification.git

Veuillez consulter les recettes de formation pour former les modèles.

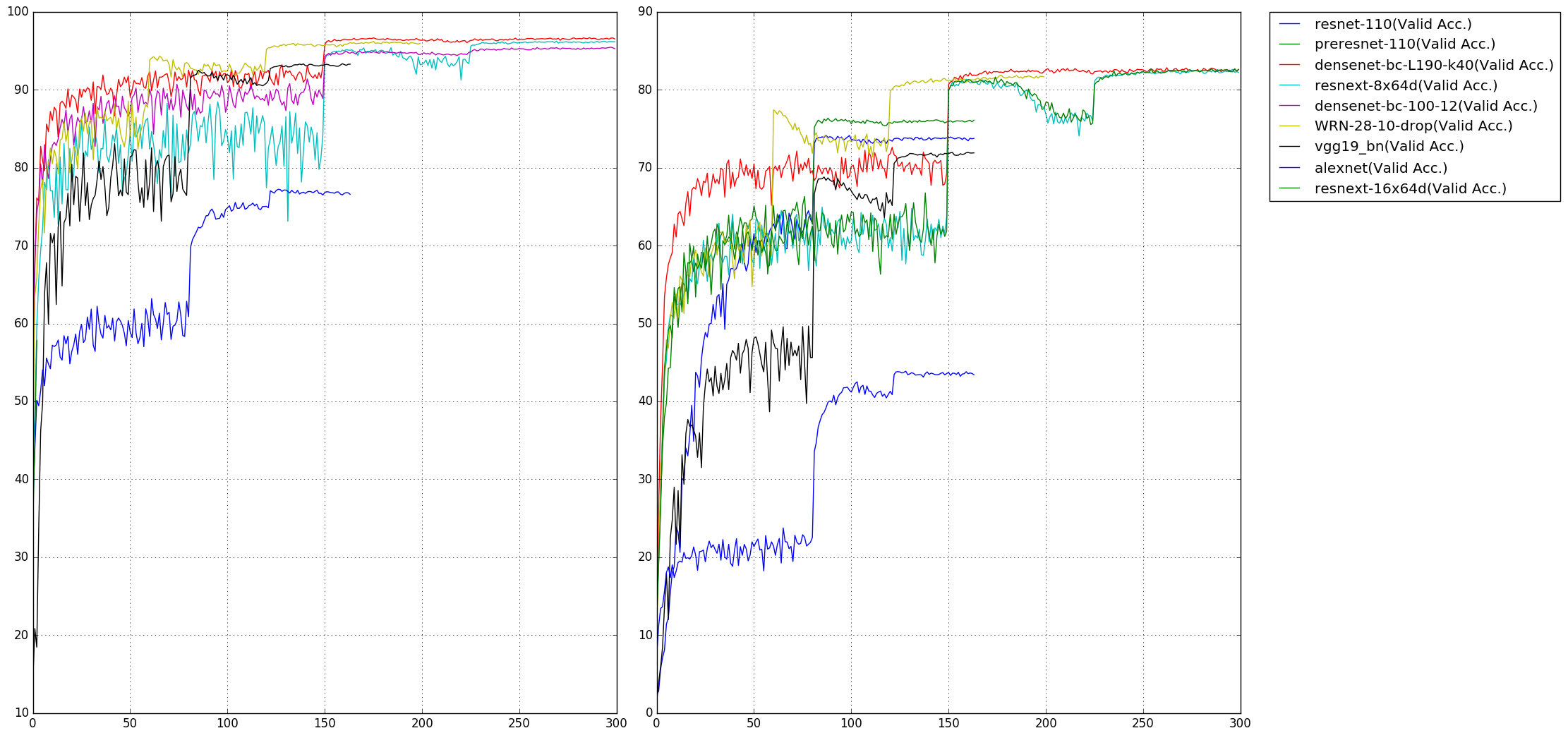

Le taux d'erreur TOP1 sur les repères CIFAR-10/100 est signalé. Vous pouvez obtenir des résultats différents lors de la formation de vos modèles avec différentes graines aléatoires. Notez que le nombre de paramètres est calculé sur l'ensemble de données CIFAR-10.

| Modèle | Paramètres (m) | CIFAR-10 (%) | CIFAR-100 (%) |

|---|---|---|---|

| Alexnet | 2.47 | 22.78 | 56.13 |

| VGG19_BN | 20.04 | 6.66 | 28.05 |

| Resnet-110 | 1.70 | 6.11 | 28.86 |

| Préresnet-110 | 1.70 | 4.94 | 23,65 |

| WRN-28-10 (baisse de 0,3) | 36.48 | 3.79 | 18.14 |

| Resnext-29, 8x64 | 34.43 | 3.69 | 17.38 |

| Resnext-29, 16x64 | 68.16 | 3.53 | 17h30 |

| Denset-bc (l = 100, k = 12) | 0,77 | 4.54 | 22.88 |

| Densenet-bc (l = 190, k = 40) | 25,62 | 3.32 | 17.17 |

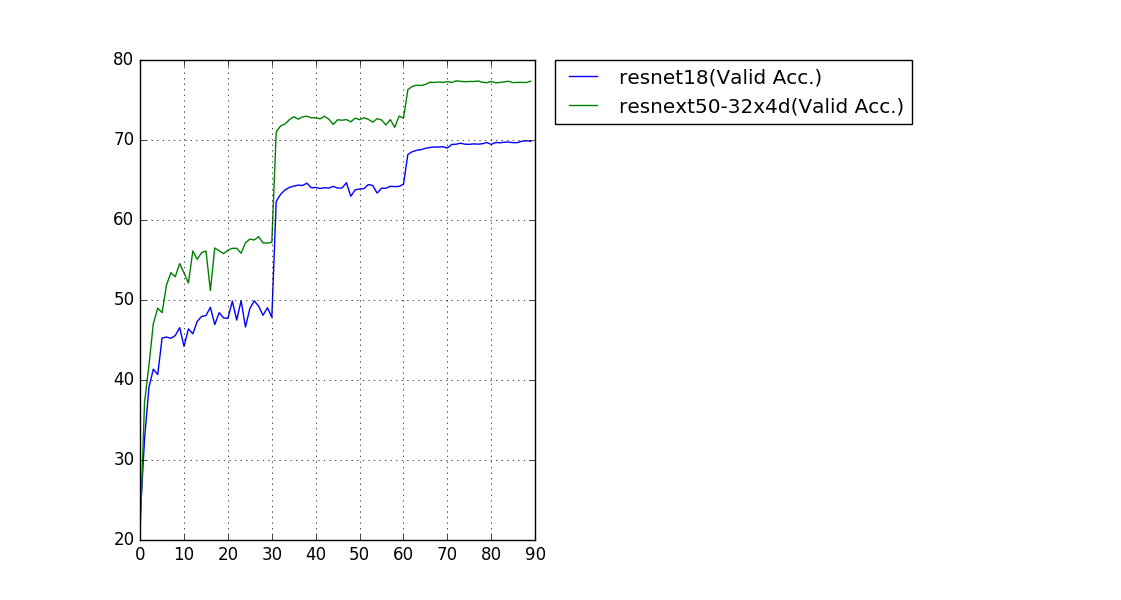

Le taux d'erreur de validation à une seule culture (224x224) est signalé.

| Modèle | Paramètres (m) | Erreur du top-1 (%) | Erreur du top 5 (%) |

|---|---|---|---|

| RESNET-18 | 11.69 | 30.09 | 10.78 |

| RESNEXT-50 (32x4d) | 25.03 | 22.6 | 6.29 |

Nos modèles qualifiés et nos journaux de formation sont téléchargeables sur OneDrive.

Étant donné que la taille des images dans l'ensemble de données CIFAR est 32x32 , les structures de réseau populaires pour ImageNet ont besoin de modifications pour adapter cette taille d'entrée. Les modèles modifiés se trouvent dans les models.cifar de package.cifar:

torchvision.models (Alexnet, VGG, Resnet, denseNet, Inception_V3, Squeezenet) N'hésitez pas à créer une demande de traction si vous trouvez des bogues ou si vous souhaitez contribuer (par exemple, plus d'ensembles de données et plus de structures de réseau).