Klassifizierung auf CIFAR-10/100 und ImageNet mit Pytorch.

./utils/logger.py ) git clone --recursive https://github.com/bearpaw/pytorch-classification.git

Bitte beachten Sie die Trainingsrezepte, um die Modelle zu trainieren.

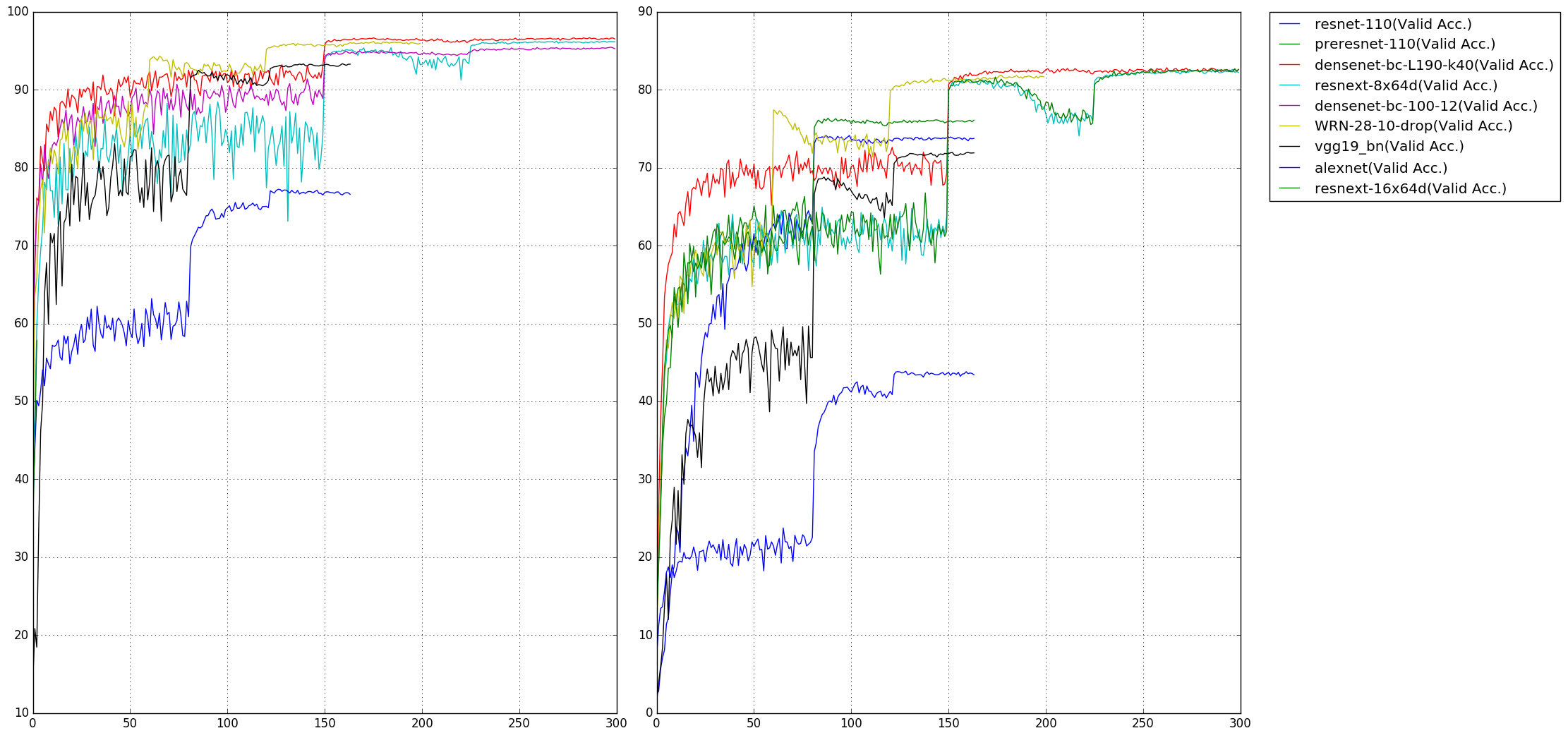

Die TOP1-Fehlerrate für die CIFAR-10/100-Benchmarks wird gemeldet. Sie können unterschiedliche Ergebnisse erzielen, wenn Sie Ihre Modelle mit unterschiedlichem Zufallssamen trainieren. Beachten Sie, dass die Anzahl der Parameter im CIFAR-10-Datensatz berechnet wird.

| Modell | Parameter (m) | CIFAR-10 (%) | CIFAR-100 (%) |

|---|---|---|---|

| Alexnet | 2.47 | 22.78 | 56.13 |

| VGG19_BN | 20.04 | 6.66 | 28.05 |

| Resnet-110 | 1.70 | 6.11 | 28.86 |

| Vorrank-110 | 1.70 | 4.94 | 23.65 |

| WRN-28-10 (Drop 0,3) | 36.48 | 3.79 | 18.14 |

| Resnext-29, 8x64 | 34.43 | 3.69 | 17.38 |

| Resnext-29, 16x64 | 68.16 | 3.53 | 17.30 |

| Densenet-BC (L = 100, k = 12) | 0,77 | 4.54 | 22.88 |

| Densenet-BC (L = 190, K = 40) | 25.62 | 3.32 | 17.17 |

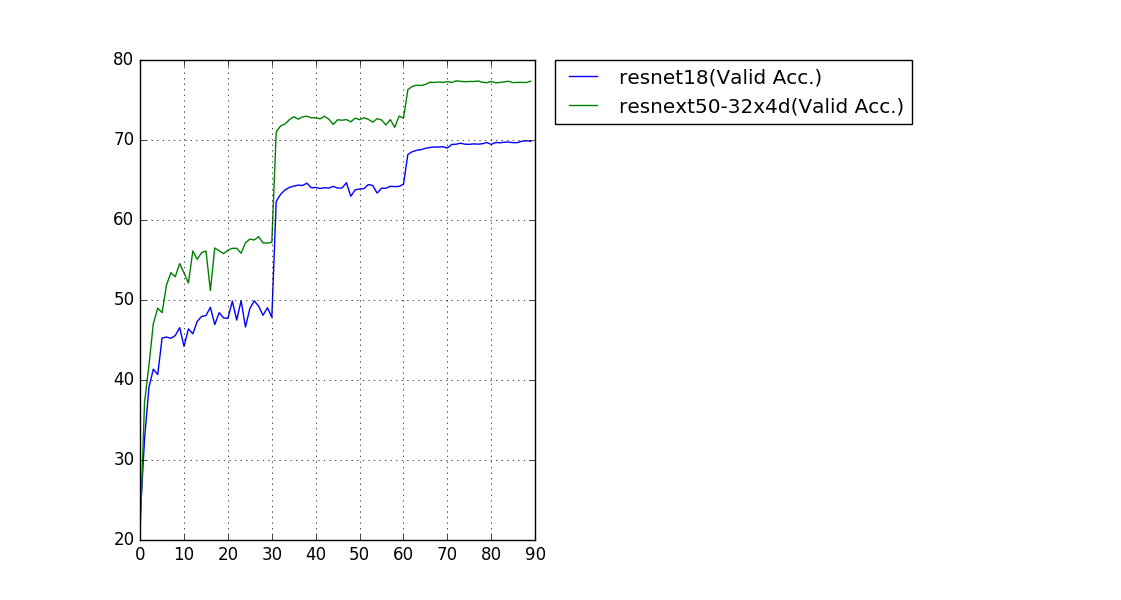

Einen Ernte (224x224) Die Validierungsfehlerrate wird angegeben.

| Modell | Parameter (m) | Top-1-Fehler (%) | Top-5-Fehler (%) |

|---|---|---|---|

| Resnet-18 | 11.69 | 30.09 | 10.78 |

| Resnext-50 (32x4d) | 25.03 | 22.6 | 6.29 |

Unsere geschulten Modelle und Trainingsprotokolle können bei OneDrive heruntergeladen werden.

Da die Größe der Bilder im CIFAR -Datensatz 32x32 beträgt, benötigen beliebte Netzwerkstrukturen für ImageNet einige Modifikationen, um diese Eingangsgröße anzupassen. Die modifizierten Modelle befinden sich in den models.cifar :

torchvision.models (Alexnet, VGG, Resnet, Densenet, Inception_v3, Squeezenet) Erstellen Sie eine Pull -Anfrage, wenn Sie Fehler finden oder einen Beitrag leisten möchten (z. B. mehr Datensätze und mehr Netzwerkstrukturen).