pytorch classification

1.0.0

تصنيف على CIFAR-10/100 و ImageNet مع Pytorch.

./utils/logger.py ) git clone --recursive https://github.com/bearpaw/pytorch-classification.git

يرجى الاطلاع على وصفات التدريب حول كيفية تدريب النماذج.

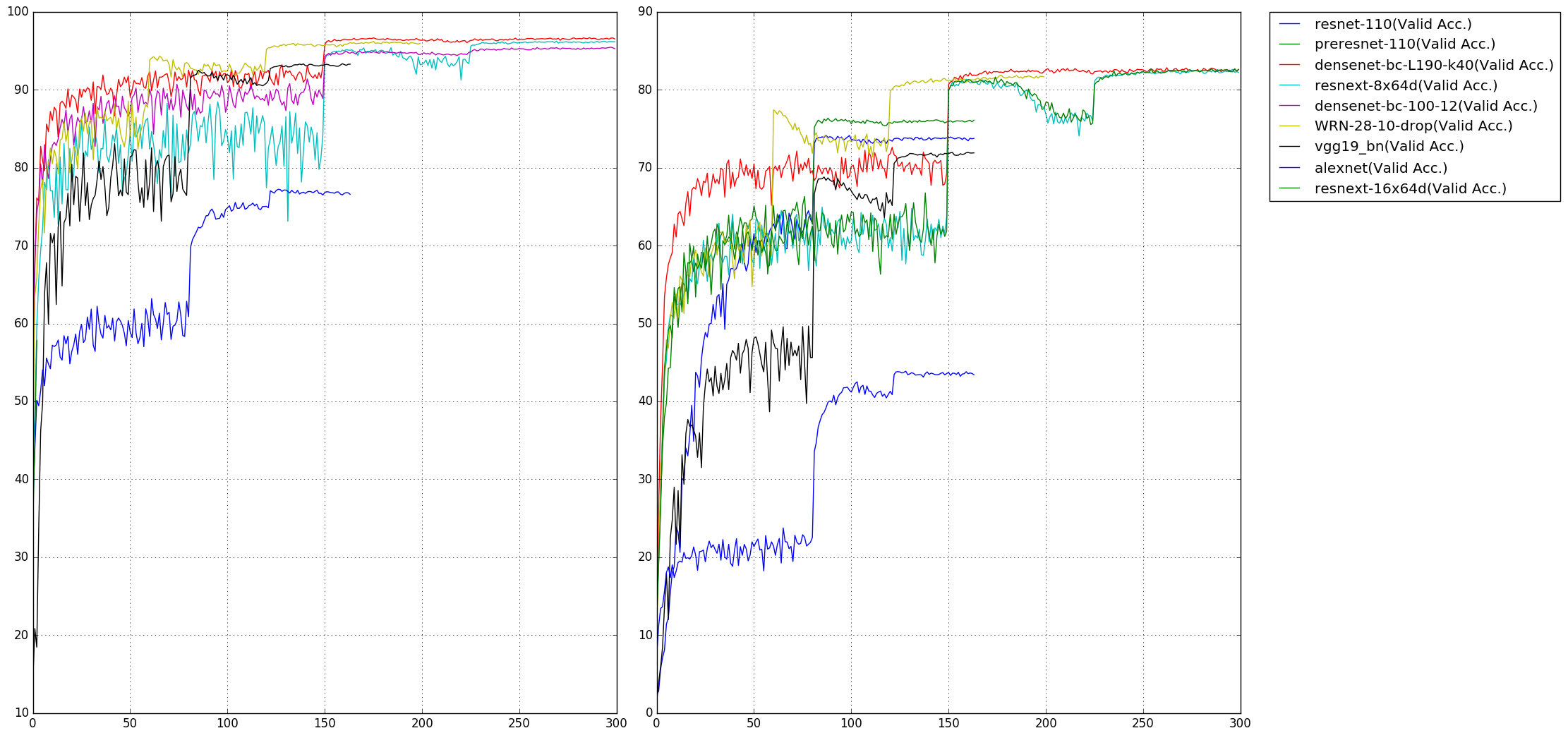

تم الإبلاغ عن معدل الخطأ TOP1 على المعايير CIFAR-10/100. قد تحصل على نتائج مختلفة عند تدريب النماذج الخاصة بك مع بذرة عشوائية مختلفة. لاحظ أنه يتم حساب عدد المعلمات على مجموعة بيانات CIFAR-10.

| نموذج | params (M) | CIFAR-10 (٪) | CIFAR-100 (٪) |

|---|---|---|---|

| اليكسنيت | 2.47 | 22.78 | 56.13 |

| VGG19_BN | 20.04 | 6.66 | 28.05 |

| RESNET-110 | 1.70 | 6.11 | 28.86 |

| Preresnet-110 | 1.70 | 4.94 | 23.65 |

| WRN-28-10 (انخفاض 0.3) | 36.48 | 3.79 | 18.14 |

| Resnext-29 ، 8x64 | 34.43 | 3.69 | 17.38 |

| Resnext-29 ، 16x64 | 68.16 | 3.53 | 17.30 |

| Densenet-BC (L = 100 ، K = 12) | 0.77 | 4.54 | 22.88 |

| Densenet-BC (L = 190 ، K = 40) | 25.62 | 3.32 | 17.17 |

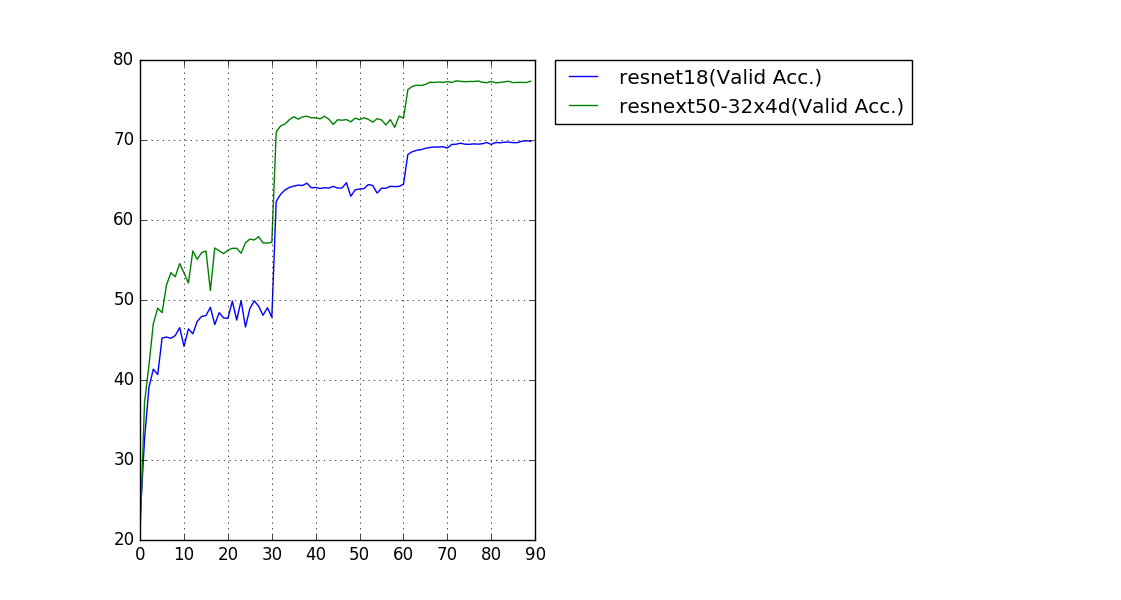

تم الإبلاغ عن معدل خطأ التحقق من CROP (224 × 224).

| نموذج | params (M) | خطأ في المرتبة الأولى (٪) | خطأ أعلى 5 (٪) |

|---|---|---|---|

| RESNET-18 | 11.69 | 30.09 | 10.78 |

| RESNEXT-50 (32x4D) | 25.03 | 22.6 | 6.29 |

يمكن تنزيل الطرز المدربة وسجلات التدريب في OneDrive.

نظرًا لأن حجم الصور في مجموعة بيانات CIFAR هو 32x32 ، فإن هياكل الشبكة الشائعة لـ ImageNet تحتاج إلى بعض التعديلات لتكييف حجم الإدخال هذا. النماذج المعدلة موجودة في حزمة models.cifar :

torchvision.models (Alexnet ، VGG ، Resnet ، Densenet ، Inception_V3 ، Squeezenet) لا تتردد في إنشاء طلب سحب إذا وجدت أي أخطاء أو تريد المساهمة (على سبيل المثال ، المزيد من مجموعات البيانات والمزيد من هياكل الشبكة).