Clasificación en CIFAR-10/100 e Imagenet con Pytorch.

./utils/logger.py ) git clone --recursive https://github.com/bearpaw/pytorch-classification.git

Consulte las recetas de capacitación sobre cómo entrenar los modelos.

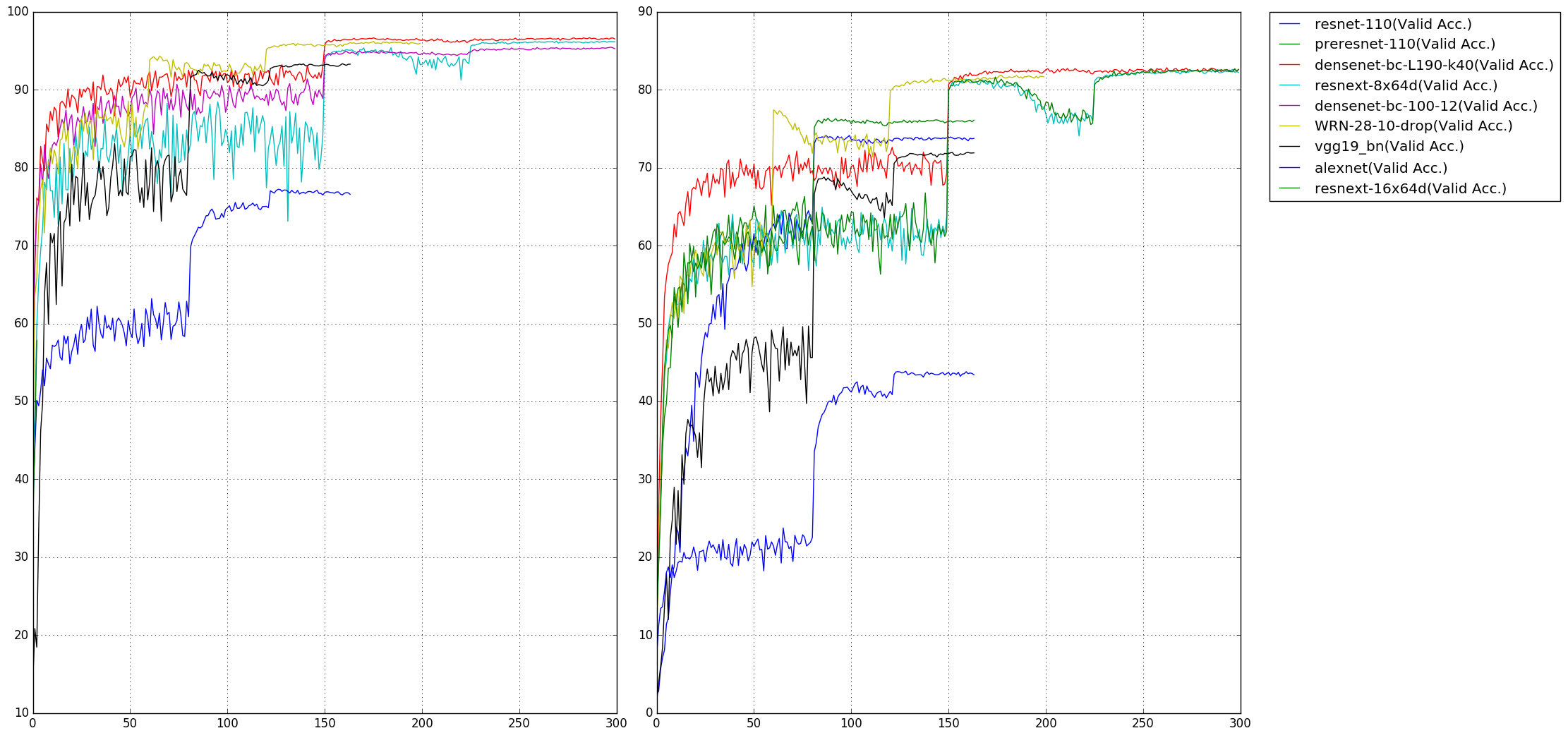

Se informan la tasa de error TOP1 en los puntos de referencia CIFAR-10/100. Puede obtener diferentes resultados al entrenar a sus modelos con diferentes semillas aleatorias. Tenga en cuenta que el número de parámetros se calcula en el conjunto de datos CIFAR-10.

| Modelo | Parámetros (m) | CIFAR-10 (%) | CIFAR-100 (%) |

|---|---|---|---|

| alexnet | 2.47 | 22.78 | 56.13 |

| VGG19_BN | 20.04 | 6.66 | 28.05 |

| Resnet-110 | 1.70 | 6.11 | 28.86 |

| Preresnet-110 | 1.70 | 4.94 | 23.65 |

| WRN-28-10 (caída 0.3) | 36.48 | 3.79 | 18.14 |

| Resnext-29, 8x64 | 34.43 | 3.69 | 17.38 |

| Resnext-29, 16x64 | 68.16 | 3.53 | 17.30 |

| Densenet-bc (l = 100, k = 12) | 0.77 | 4.54 | 22.88 |

| Densenet-BC (l = 190, k = 40) | 25.62 | 3.32 | 17.17 |

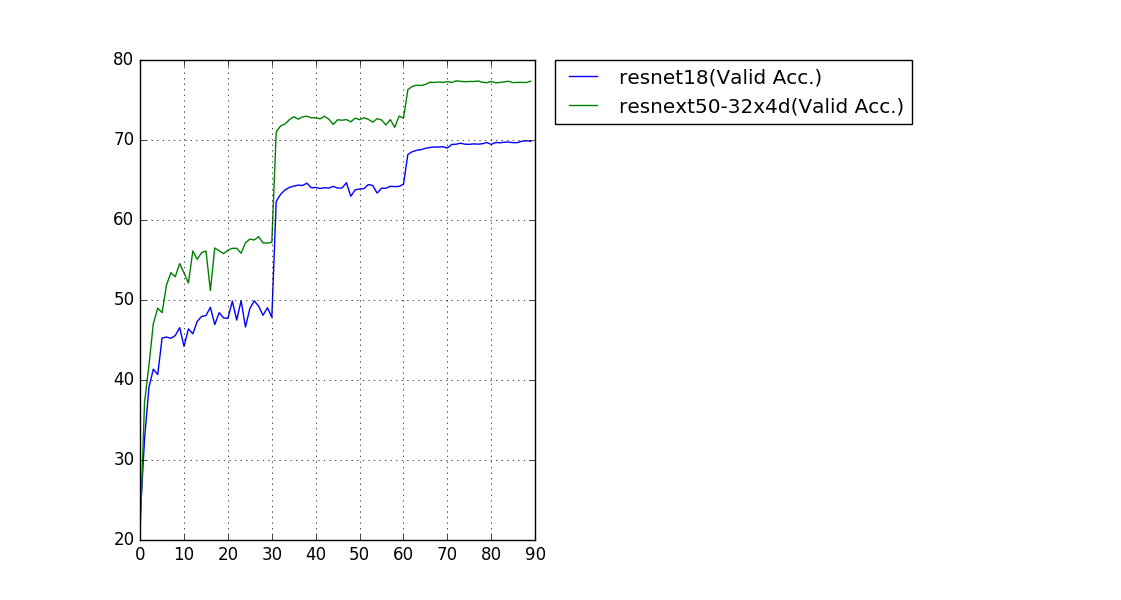

Se informa la tasa de error de validación de un solo cultivo (224x224).

| Modelo | Parámetros (m) | Error de Top-1 (%) | Error de los 5 mejores (%) |

|---|---|---|---|

| Resnet-18 | 11.69 | 30.09 | 10.78 |

| Resnext-50 (32x4d) | 25.03 | 22.6 | 6.29 |

Nuestros modelos capacitados y registros de capacitación se pueden descargar en OneDrive.

Dado que el tamaño de las imágenes en el conjunto de datos CIFAR es de 32x32 , las estructuras de red populares para Imagenet necesitan algunas modificaciones para adaptar este tamaño de entrada. Los modelos modificados se encuentran en los models.cifar de paquete. Cifar:

torchvision.models (Alexnet, VGG, Resnet, Densenet, Inception_V3, Squeezenet) No dude en crear una solicitud de extracción si encuentra algún error o desea contribuir (por ejemplo, más conjuntos de datos y más estructuras de red).