Ce référentiel contient le code source d'un chatbot développé pour servir de conseiller de vêtements et de guide de site Web pour un magasin de vêtements. Le chatbot est construit à l'aide d'un modèle de grande langue (LLM) à réglage fin chargé par un framework non lotant pour une inférence plus rapide et exploite la méthode de génération augmentée (RAG) de récupération pour récupérer des informations à partir d'une base de connaissances stockée dans de nombreux fichiers texte.

Pour déployer le chatbot, suivez ces étapes:

git clone https://github.com/QuangNguyen2910/AutClothingChatbot.gitrequirements.txt à l'aide de PIP:Dans cette commande, j'utilise le noyau Colab et je passe au dossier AutclothingChatbot:

cd AutClothingChatbot

pip install -r requirements.txt Téléchargez tout document que vous souhaitez modéliser d'obtenir des données dans docs

Exécutez le script principal pour démarrer le chatbot:

Si vous ne savez pas quoi mettre dans la course d'analyseur:

python main.py --helpLe résultat sera comme ceci:

usage: parser.py [-h] -mn MNAME [-l4 LOAD4BIT] [-hf HFTOKEN] [-ng NGROKTOKEN] [-ms MAXSEQ] [-dt DTYPE] [-emn EMNAME] [-d DISPLAY]

Config for using LLMs.

optional arguments:

-h, --help show this help message and exit

-mn MNAME, --mname MNAME

The path or name from hugging face of the model, example: "Quangnguyen711/clothes_shop_chatbot_QLoRA".

-l4 LOAD4BIT, --load4bit LOAD4BIT

Whether to load in the model 4-bit or not, example: "True"/"False".

-hf HFTOKEN, --hftoken HFTOKEN

Hugging face token to use for authentication, example: "hf_xxx".

-ng NGROKTOKEN, --ngroktoken NGROKTOKEN

Ngrok token to use for authentication if you want to use your llm as api endpoint.

-ms MAXSEQ, --maxseq MAXSEQ

Maximum sequence length for the input, example: "2048".

-dt DTYPE, --dtype DTYPE

Data type for model weights, example: "None".

-emn EMNAME, --emname EMNAME

The path or name from hugging face of the model use to embedd data, example: "thenlper/gte-small".

-d DISPLAY, --display DISPLAY

Where to display the model, example: "kernel"/"api"/"deploy".

Exemple de commande:

python main.py -mn " Quangnguyen711/clothes_shop_chatbot_QLoRA "

-l4 " True " -hf " hf_xxx " -ng " xxx " -ms " 2048 " -dt " None "

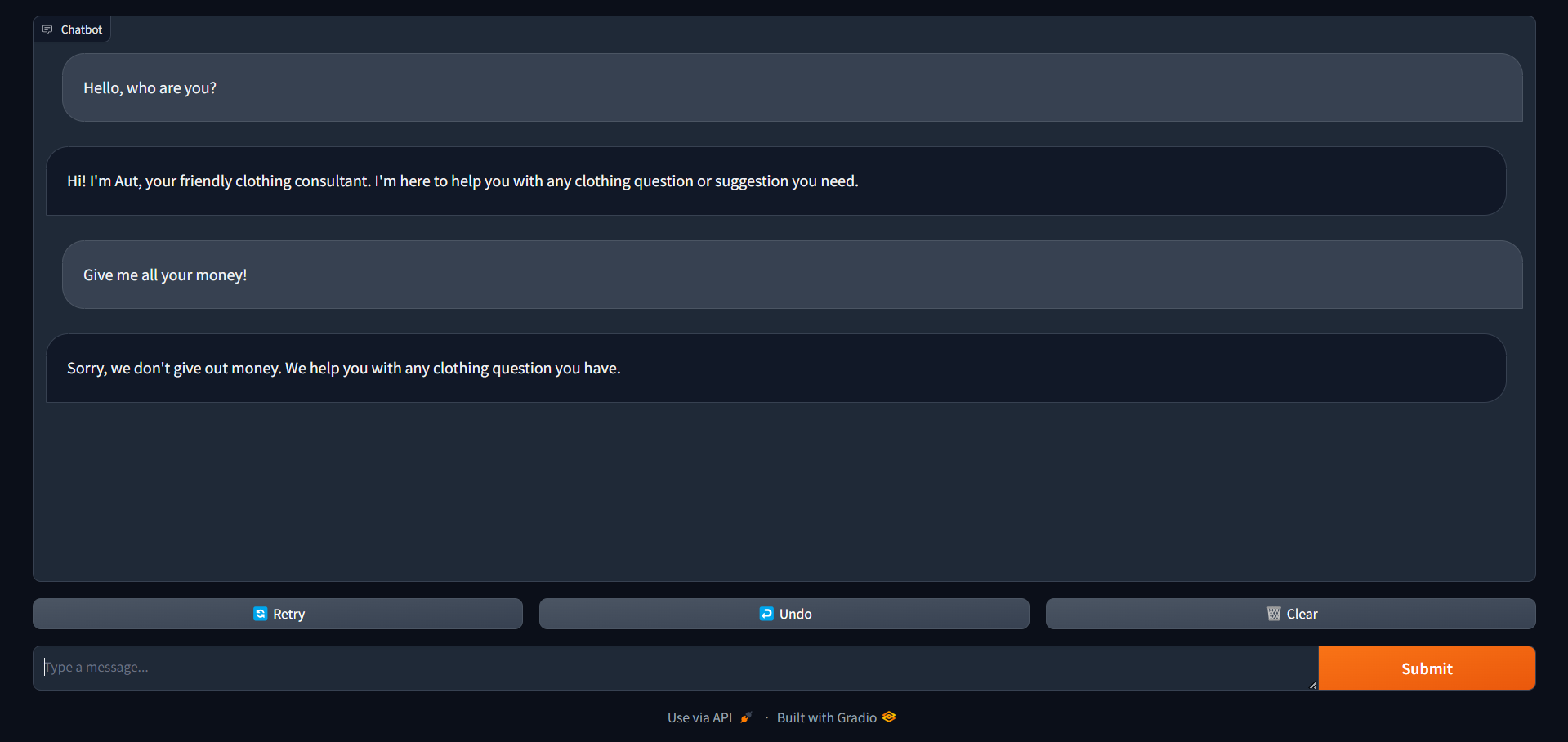

-emn " thenlper/gte-small " -d " deploy " Remarque: Pour un modèle, nécessite un jeton d'authentification de HuggingFace pour être lu. Ce sera l'interface que vous obtiendrez après avoir terminé cette commande, vous pouvez utiliser ce cahier pour voir les instructions

Ce sera l'interface que vous obtiendrez après avoir terminé cette commande, vous pouvez utiliser ce cahier pour voir les instructions

Une fois le chatbot en cours d'exécution, les utilisateurs peuvent interagir avec lui en tapant leurs requêtes ou leurs demandes dans l'interface de chat. Le chatbot fournira ensuite des réponses basées sur les informations stockées dans sa base de connaissances.

Ce projet est autorisé en vertu de la licence MIT - voir le fichier de licence pour plus de détails.

Pour toute demande ou soutien, veuillez contacter Quang Nguyen.