Dieses Repository enthält den Quellcode für einen Chatbot, der entwickelt wurde, um als Bekleidungsberater und Website -Leitfaden für einen Bekleidungsgeschäft zu dienen. Der Chatbot wird mit einem fein abgestimmten Großsprachenmodell (LLM) erstellt, das von Unloth Framework für eine schnellere Inferenz geladen wird, und nutzt die Methode der Abruf Augmented Generation (RAG), um Informationen von einer in vielen Textdateien gespeicherten Wissensbasis abzurufen.

Befolgen Sie die folgenden Schritte, um den Chatbot bereitzustellen:

git clone https://github.com/QuangNguyen2910/AutClothingChatbot.gitrequirements.txt aufgeführt sind.txt mit PIP:In diesem Befehl benutze ich Colab Kernel und wechsele zum Autclothingchatbot -Ordner:

cd AutClothingChatbot

pip install -r requirements.txt Laden Sie jedes Dokument hoch, das Sie modellieren möchten, um Daten in docs zu erhalten

Führen Sie das Hauptskript aus, um den Chatbot zu starten:

Wenn Sie nicht wissen, was Sie in den Parser -Lauf einbringen sollen:

python main.py --helpDas Ergebnis wird so sein:

usage: parser.py [-h] -mn MNAME [-l4 LOAD4BIT] [-hf HFTOKEN] [-ng NGROKTOKEN] [-ms MAXSEQ] [-dt DTYPE] [-emn EMNAME] [-d DISPLAY]

Config for using LLMs.

optional arguments:

-h, --help show this help message and exit

-mn MNAME, --mname MNAME

The path or name from hugging face of the model, example: "Quangnguyen711/clothes_shop_chatbot_QLoRA".

-l4 LOAD4BIT, --load4bit LOAD4BIT

Whether to load in the model 4-bit or not, example: "True"/"False".

-hf HFTOKEN, --hftoken HFTOKEN

Hugging face token to use for authentication, example: "hf_xxx".

-ng NGROKTOKEN, --ngroktoken NGROKTOKEN

Ngrok token to use for authentication if you want to use your llm as api endpoint.

-ms MAXSEQ, --maxseq MAXSEQ

Maximum sequence length for the input, example: "2048".

-dt DTYPE, --dtype DTYPE

Data type for model weights, example: "None".

-emn EMNAME, --emname EMNAME

The path or name from hugging face of the model use to embedd data, example: "thenlper/gte-small".

-d DISPLAY, --display DISPLAY

Where to display the model, example: "kernel"/"api"/"deploy".

Beispielbefehl:

python main.py -mn " Quangnguyen711/clothes_shop_chatbot_QLoRA "

-l4 " True " -hf " hf_xxx " -ng " xxx " -ms " 2048 " -dt " None "

-emn " thenlper/gte-small " -d " deploy " HINWEIS: Für ein Modell benötigen ein Authentifizierungs -Token von SuggingFace, um zu lesen. Dies ist die Schnittstelle, die Sie nach Beendigung dieses Befehls erhalten.

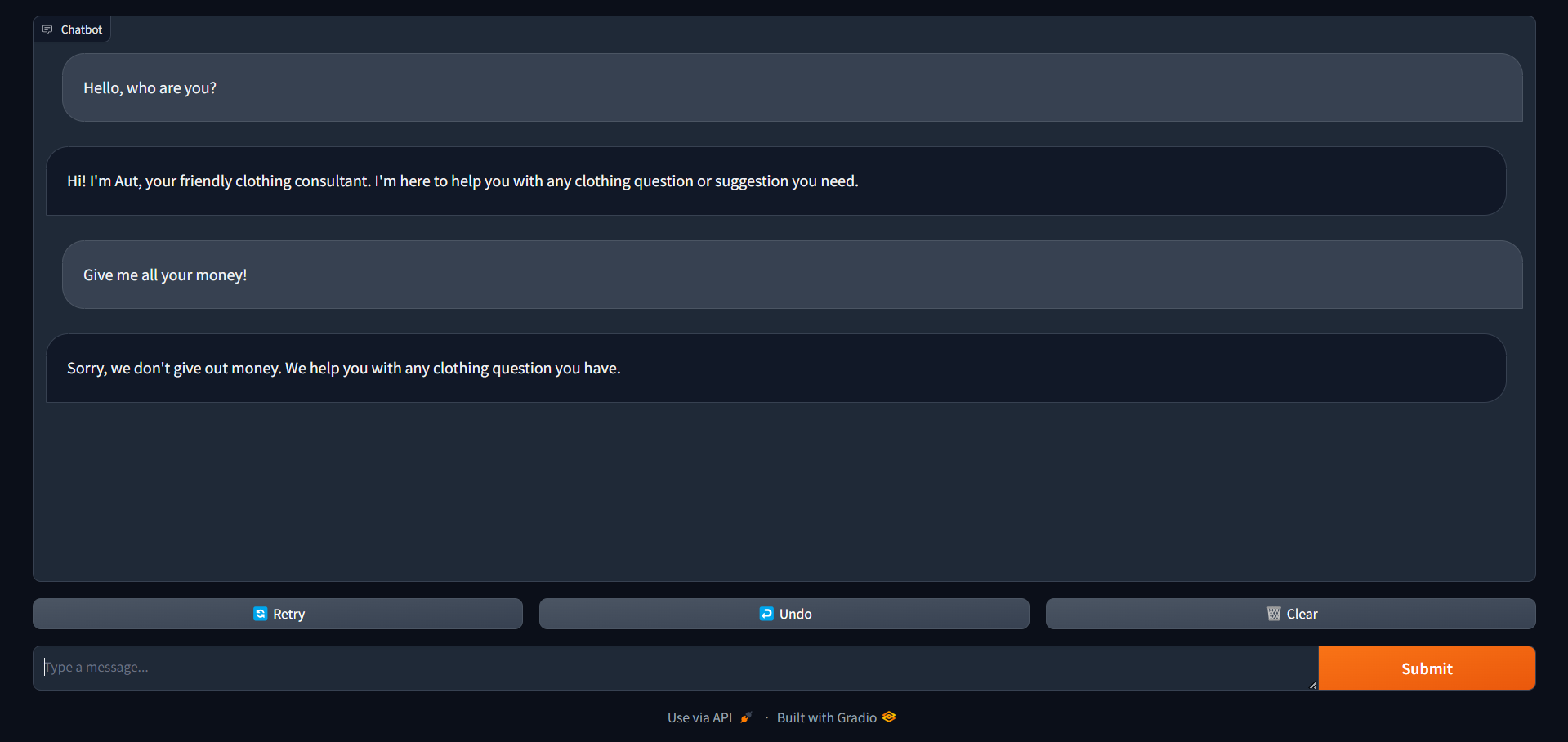

Dies ist die Schnittstelle, die Sie nach Beendigung dieses Befehls erhalten.

Sobald der Chatbot ausgeführt wird, können Benutzer damit interagieren, indem sie ihre Abfragen oder Anforderungen in die Chat -Oberfläche eingeben. Der Chatbot liefert dann Antworten auf der Grundlage der in seiner Wissensbasis gespeicherten Informationen.

Dieses Projekt ist unter der MIT -Lizenz lizenziert - Einzelheiten finden Sie in der Lizenzdatei.

Für Anfragen oder Unterstützung wenden Sie sich bitte an Quang Nguyen.