| page_type | langues | produits | urlfragment | nom | description | ||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

échantillon |

|

| rédacteur | Assistant d'écriture créative - Travailler avec des agents à l'aide de Prands (implémentation Python) | Utilisation d'agent Azure Openai avec Python, intégrant Bing Search API et Azure AI Search, pour créer des articles basés sur des sujets utilisateur et des instructions. |

Ouvrez une fenêtre de terminal.

Connectez-vous à votre compte Azure. Vous devrez vous connecter à la fois au développeur Azure CLI et à Azure CLI:

je. Tout d'abord avec le développeur Azure CLI

azd auth loginii Puis connectez-vous avec Azure CLI

az login --use-device-codeProvision des ressources et déploiez le code:

azd up Vous serez invité à sélectionner certains détails sur vos ressources déployées, y compris l'emplacement. Pour rappel, nous recommandons le Canada East comme région de ce projet. Une fois le déploiement terminé, vous devriez pouvoir faire défiler dans votre terminal et voir l'URL à laquelle l'application a été déployée. Il devrait ressembler à cette Ingress Updated. Access your app at https://env-name.codespacesname.eastus2.azurecontainerapps.io/ . Accédez au lien pour essayer l'application immédiatement!

Une fois les étapes ci-dessus terminées, vous pouvez tester l'échantillon.

Une option connexe est les conteneurs de développement du code vs, qui ouvrira le projet dans votre code local vs à l'aide de l'extension des conteneurs Dev:

Démarrer Docker Desktop (l'installez-le s'il n'est pas déjà installé)

Ouvrez le projet:

Dans la fenêtre de code vs qui s'ouvre, une fois que les fichiers du projet s'affichent (cela peut prendre plusieurs minutes), ouvrez une fenêtre de terminal.

Installer les packages requis:

cd src/api

pip install -r requirements.txtUne fois que vous avez terminé ces étapes, passez au déploiement.

Remarque pour les utilisateurs de Windows: si vous n'utilisez pas de conteneur pour exécuter cet échantillon, nos crochets sont actuellement tous des scripts shell. Pour provisionner correctement cet échantillon pendant que nous travaillons sur les mises à jour, nous vous recommandons d'utiliser Git Bash.

Créez un nouveau dossier et passez-le dans le terminal, puis exécutez cette commande pour télécharger le code du projet:

azd init -t agent-openai-python-promptyNotez que cette commande initialisera un référentiel GIT, vous n'avez donc pas besoin de cloner ce référentiel.

Installer les packages requis:

cd src/api

pip install -r requirements.txtUne fois que vous avez ouvert le projet dans des codespaces, des conteneurs de développement ou localement, vous pouvez le déployer sur Azure.

Connectez-vous à votre compte Azure. Vous devrez vous connecter à la fois au développeur Azure CLI et à Azure CLI:

je. Tout d'abord avec le développeur Azure CLI

azd auth loginii Puis connectez-vous avec Azure CLI

az login --use-device-code Si vous avez des problèmes avec cette commande, vous pouvez également essayer azd auth login --use-device-code .

Cela créera un dossier sous .azure/ Dans votre projet pour stocker la configuration de ce déploiement. Vous pouvez avoir plusieurs environnements AZD si vous le souhaitez.

Provision des ressources et déploiez le code:

azd up Ce projet utilise gpt-35-turbo-0613 , gpt-4-1106-Preview et gpt-4o-2024-05-13 qui peuvent ne pas être disponibles dans toutes les régions Azure. Vérifiez la disponibilité de la région à jour et sélectionnez une région pendant le déploiement en conséquence. Nous vous recommandons d'utiliser le Canada East pour ce projet.

Après avoir exécuté AZD, on peut vous poser la question suivante lors de Github Setup :

Do you want to configure a GitHub action to automatically deploy this repo to Azure when you push code changes ?

(Y/n) Y Vous devez répondre avec N , car ce n'est pas une étape nécessaire et prend un certain temps à configurer.

Cet exemple de référentiel contient un dossier d'agents qui comprend des sous-dossiers pour chaque agent. Chaque dossier d'agent contient un fichier de promotion dans lequel le promotion de l'agent est défini et un fichier python avec le code utilisé pour l'exécuter. L'exploration de ces fichiers vous aidera à comprendre ce que fait chaque agent. Le dossier de l'agent contient également un fichier orchestrator.py qui peut être utilisé pour exécuter l'ensemble du flux et créer un article. Lorsque vous avez azd up un catalogue de produits a été téléchargé dans le magasin de vecteur Azure AI et le nom d'index contoso-products a été créé.

Pour tester l'échantillon:

Exécutez l'exemple d'application Web localement à l'aide d'un serveur FastAPI.

Accédez d'abord au dossier SRC / API

cd ./src/apiExécutez le serveur Web Fastapi

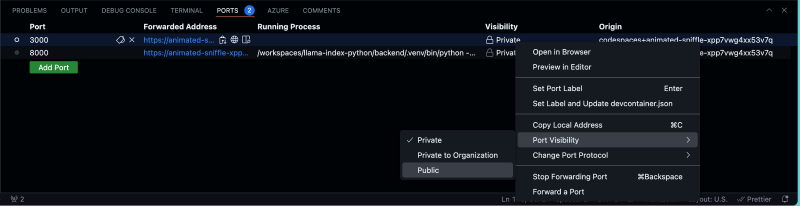

fastapi dev main.py Remarque importante : Si vous exécutez des codes, vous devrez modifier la visibilité des ports 8000 et 5173 de l'API en public dans l'onglet PORTS de votre terminal de code VS. L'onglet Ports devrait ressembler à ceci:

Si vous ouvrez le lien du serveur dans un navigateur, vous verrez une erreur d'URL non trouvée, c'est parce que nous n'avons pas créé de route URL domestique dans FastAPI. Nous avons plutôt créé une route /get_article qui est utilisée pour transmettre le contexte et les instructions directement dans le fichier get_article.py qui exécute le flux de travail de l'agent.

(Facultatif) Nous avons créé une interface Web que nous exécuterons ensuite, mais vous pouvez tester l'API fonctionne comme prévu en exécutant ceci dans le navigateur:

http://127.0.0.1:8080/get_article?context=Write an article about camping in alaska&instructions=find specifics about what type of gear they would need and explain in detail

Une fois le serveur Fastapi en cours d'exécution, vous pouvez désormais exécuter l'application Web. Pour ce faire, ouvrez une nouvelle fenêtre de terminal et accédez au dossier Web à l'aide de cette commande:

cd ./src/webInstallez d'abord les packages de nœuds:

npm installEnsuite, exécutez l'application Web avec un serveur Web de développement local:

npm run devCela lancera l'application, où vous pouvez utiliser un exemple de contexte et d'instructions pour commencer. Sur la page «Creative Team», vous pouvez examiner la sortie de chaque agent en cliquant dessus. L'application devrait ressembler à ceci:

Modifiez les instructions et le contexte pour créer un article de votre choix.

À des fins de débogage, vous pouvez tester en Python en utilisant la logique de l'orchestrateur

Pour exécuter l'échantillon en utilisant uniquement la logique d'orchestrateur, utilisez la commande suivante:

cd ./src/api

python -m orchestrator

Pour activer le serveur de traçage promulaire:

export LOCAL_TRACING=true

Puis démarrez l'orchestrateur:

cd ./src/api

python -m orchestrator

Une fois que vous pouvez voir que l'article a été généré, un dossier .runs devrait apparaître dans le ./src/api . Sélectionnez ce dossier et cliquez sur le fichier .tracy . Cela vous montre toutes les fonctions Python qui ont été appelées afin de générer l'article. Explorez chaque section et voyez quelles informations utiles vous pouvez trouver.

Contoso Creative Writer utilise des évaluateurs pour évaluer la qualité de la réponse des applications. Les 4 mesures que les évaluateurs de ce projet évaluent sont la cohérence, la maîtrise, la pertinence et la mise à la terre. Un script evaluate.py personnalisé a été écrit pour exécuter toutes les évaulations pour vous.

cd ./src/api

python -m evaluate.evaluatesrc/api/evaluate/eval_inputs.jsonl .Ce modèle est configuré pour exécuter CI / CD lorsque vous appuyez sur les modifications de votre dépôt. Lorsque CI / CD est configuré, les évaluations seront dans les actions GitHub, puis déploient automatiquement votre application sur Push to Main.

Pour configurer CI / CD avec des actions GitHub sur votre référentiel, exécutez la commande suivante:

azd pipeline config Ce modèle utilise gpt-35-turbo-0613 , gpt-4-1106-Preview et gpt-4o-2024-05-13 qui peuvent ne pas être disponibles dans toutes les régions Azure. Vérifiez la disponibilité de la région à jour et sélectionnez une région pendant le déploiement en conséquence

Vous pouvez estimer le coût de l'architecture de ce projet avec la calculatrice de tarification d'Azure

Note

Lors de la mise en œuvre de ce modèle, veuillez spécifier si le modèle utilise une identité gérée ou un coffre-fort clé

Ce modèle a géré l'identité ou le coffre-fort clé intégré pour éliminer la nécessité pour les développeurs de gérer ces informations d'identification. Les applications peuvent utiliser des identités gérées pour obtenir des jetons Microsoft Entra sans avoir à gérer des informations d'identification. De plus, nous avons ajouté un outil d'action GitHub qui scanne les fichiers d'infrastructure en tant que code et génère un rapport contenant tous les problèmes détectés. Pour garantir les meilleures pratiques dans votre dépôt, nous recommandons à toute personne créant des solutions en fonction de nos modèles, assurez-vous que le paramètre de balayage secret GitHub est activé dans vos reposs.

Ce projet a adopté le code de conduite open source Microsoft.

Ressources:

Pour plus d'informations, consultez le code de conduite FAQ ou contactez [email protected] avec toute question ou commentaire supplémentaire.

Ce projet suit ci-dessous les lignes directrices et les meilleures pratiques responsables de l'IA, veuillez les consulter avant d'utiliser ce projet: