DriveNm: Conducir con G raph v

Autonomous Driving Challenge 2024 conducción con clasificación de lenguaje .

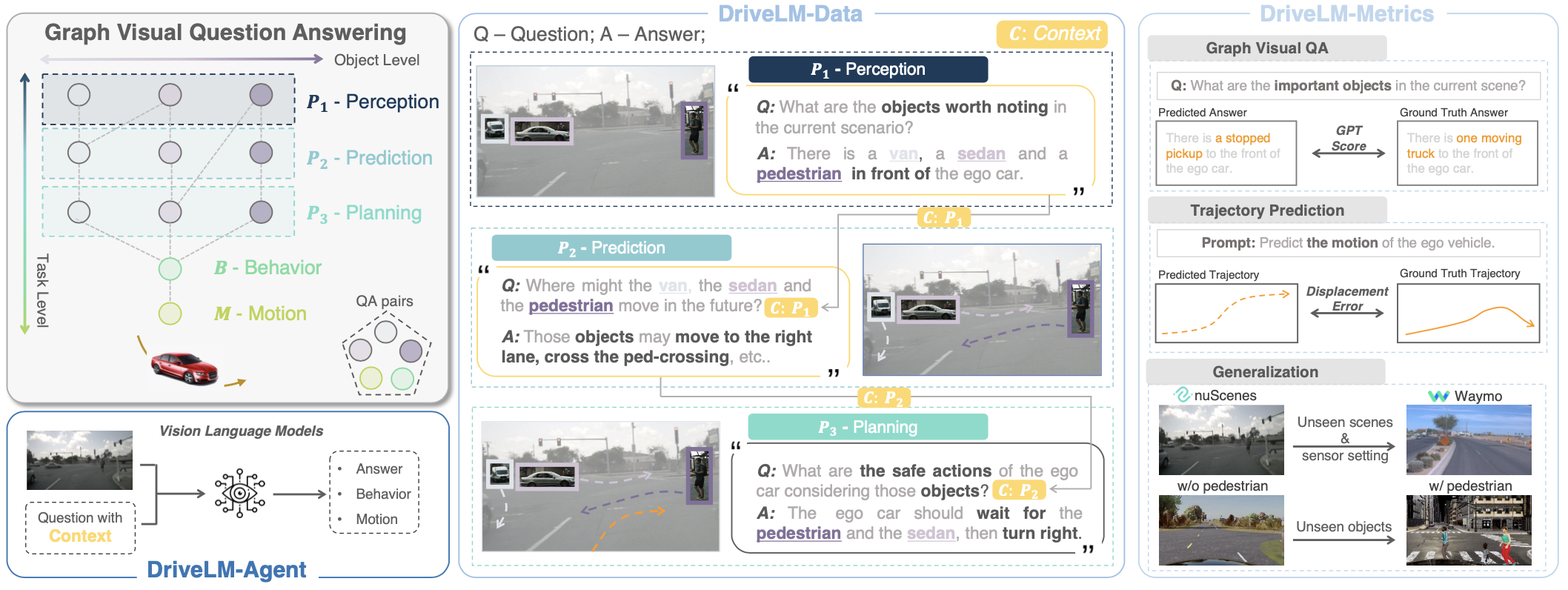

Instanciamos los conjuntos de datos ( DriveRM-Data ) construidos sobre Nuscenes y Carla, y proponemos un enfoque de referencia basado en VLM ( agente DriveNMM ) para realizar conjuntamente VQA gráfico y conducción de extremo a extremo.

? DriveNM sirve como una pista principal en el CVPR 2024 Autonomous Driving Challenge . ¡Todo lo que necesita para el desafío está aquí, incluida la línea de base, los datos de prueba y el formato de envío y la tubería de evaluación!

[2025/01/08] ¡Liberación de bancos de transmisión! Análisis en profundidad en lo que realmente son las secuencias de la evaluación comparativa. Echa un vistazo a Arxiv.[2024/07/16] REAPERA DE LA RAAM con la tabla de clasificación oficial![2024/07/01] ¡DriveNM fue aceptado para ECCV 2024! ¡Felicidades al equipo![2024/06/01] El desafío terminó! Ver la tabla de clasificación final.[2024/03/25] El servidor de prueba de desafío está en línea y se lanzan las preguntas de prueba. ¡CHEKC It Out![2024/02/29] Lanzamiento de repositorio de desafío. Línea de base, formato de datos y envío, tubería de evaluación. ¡Mira![2023/08/25] Demo de Drivemm-Nuscenes lanzado.[2023/12/22] DrVivelm-Nuscenes Full v1.0 y papel lanzado. Para comenzar con DriveM:

(De vuelta a la cima)

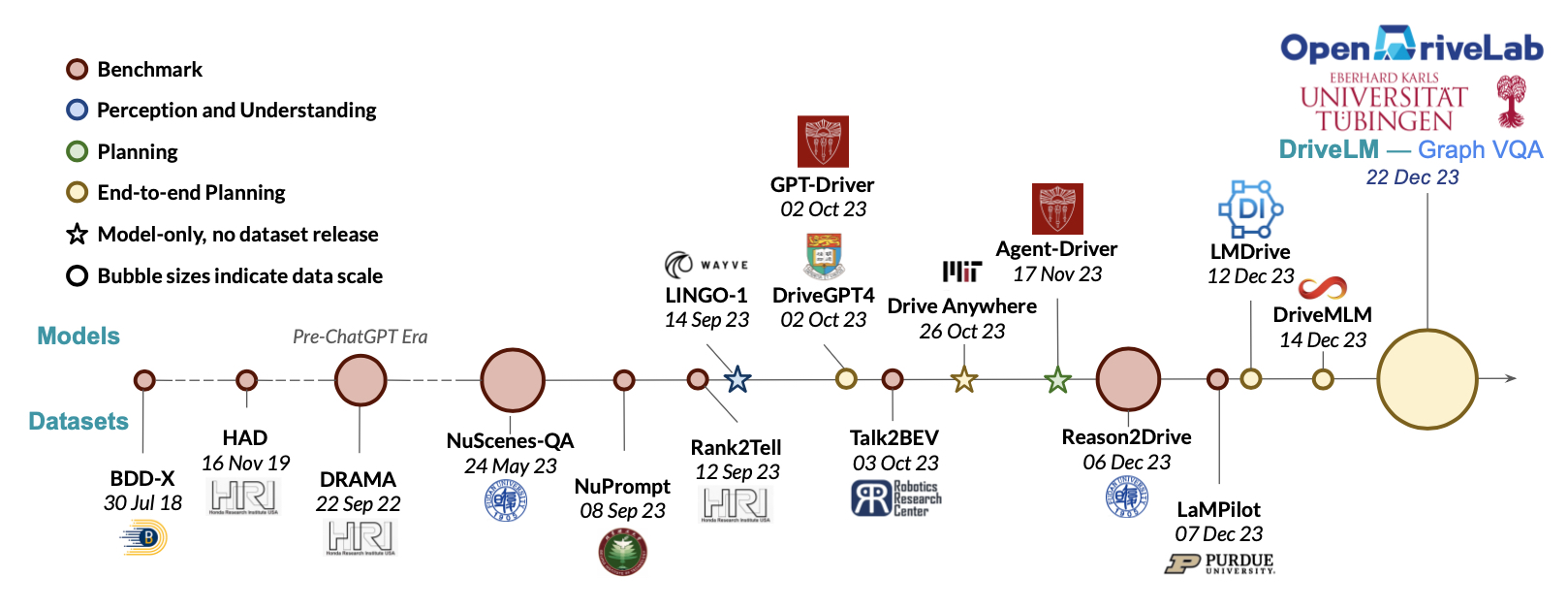

- El advenimiento de los modelos multimodales de estilo GPT en aplicaciones del mundo real motiva el estudio del papel del lenguaje en la conducción.

- La fecha a continuación refleja la fecha de envío de ARXIV.

- Si hay algún trabajo faltante, ¡comuníquese con nosotros!

DriveNM intenta abordar algunos de los desafíos que enfrentan la comunidad.

(De vuelta a la cima)

(De vuelta a la cima)

Facilitamos la Perception, Prediction, Planning, Behavior, Motion con la lógica de razonamiento escrita por humanos como una conexión entre ellos. Proponemos la tarea de GVQA en los datos DriveNM.

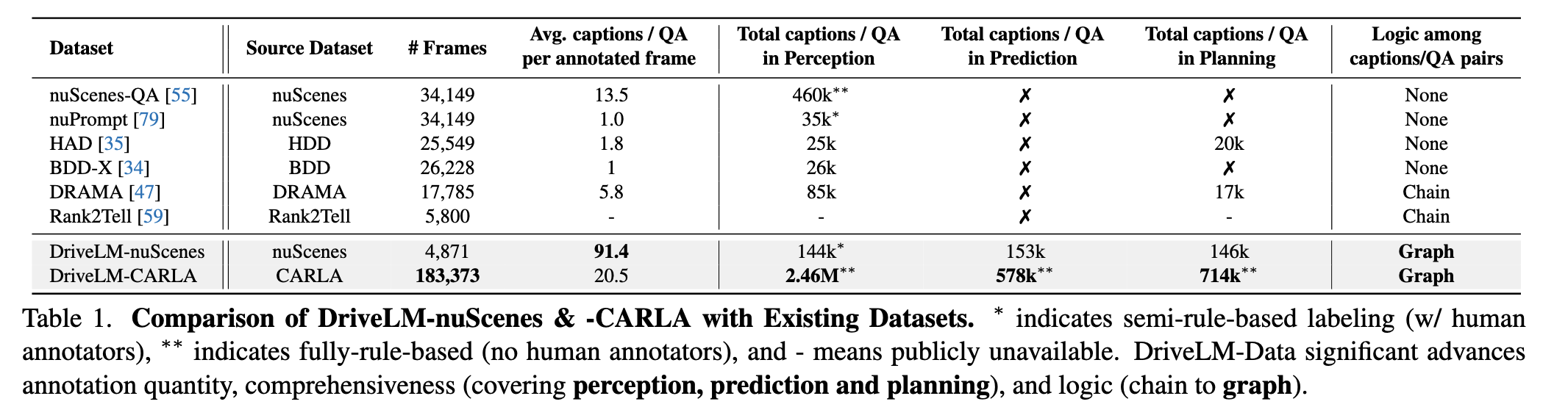

Drivelm-Data es el primer conjunto de datos que conduce el lenguaje que facilita la pila completa de tareas de conducción con dependencias lógicas estructuradas en gráficos.

Enlaces a detalles sobre la tarea GVQA, las características del conjunto de datos y la anotación.

(De vuelta a la cima)

Todos los activos y código en este repositorio están bajo la licencia Apache 2.0 a menos que se especifique lo contrario. Los datos del idioma están bajo CC BY-NC-SA 4.0. Otros conjuntos de datos (incluidos Nuscenes) heredan sus propias licencias de distribución. Considere citar nuestro documento y proyecto si ayudan a su investigación.

@article { sima2023drivelm ,

title = { DriveLM: Driving with Graph Visual Question Answering } ,

author = { Sima, Chonghao and Renz, Katrin and Chitta, Kashyap and Chen, Li and Zhang, Hanxue and Xie, Chengen and Luo, Ping and Geiger, Andreas and Li, Hongyang } ,

journal = { arXiv preprint arXiv:2312.14150 } ,

year = { 2023 }

} @misc { contributors2023drivelmrepo ,

title = { DriveLM: Driving with Graph Visual Question Answering } ,

author = { DriveLM contributors } ,

howpublished = { url{https://github.com/OpenDriveLab/DriveLM} } ,

year = { 2023 }

}(De vuelta a la cima)

Opendrivelab

Grupo de visión autónoma

(De vuelta a la cima)