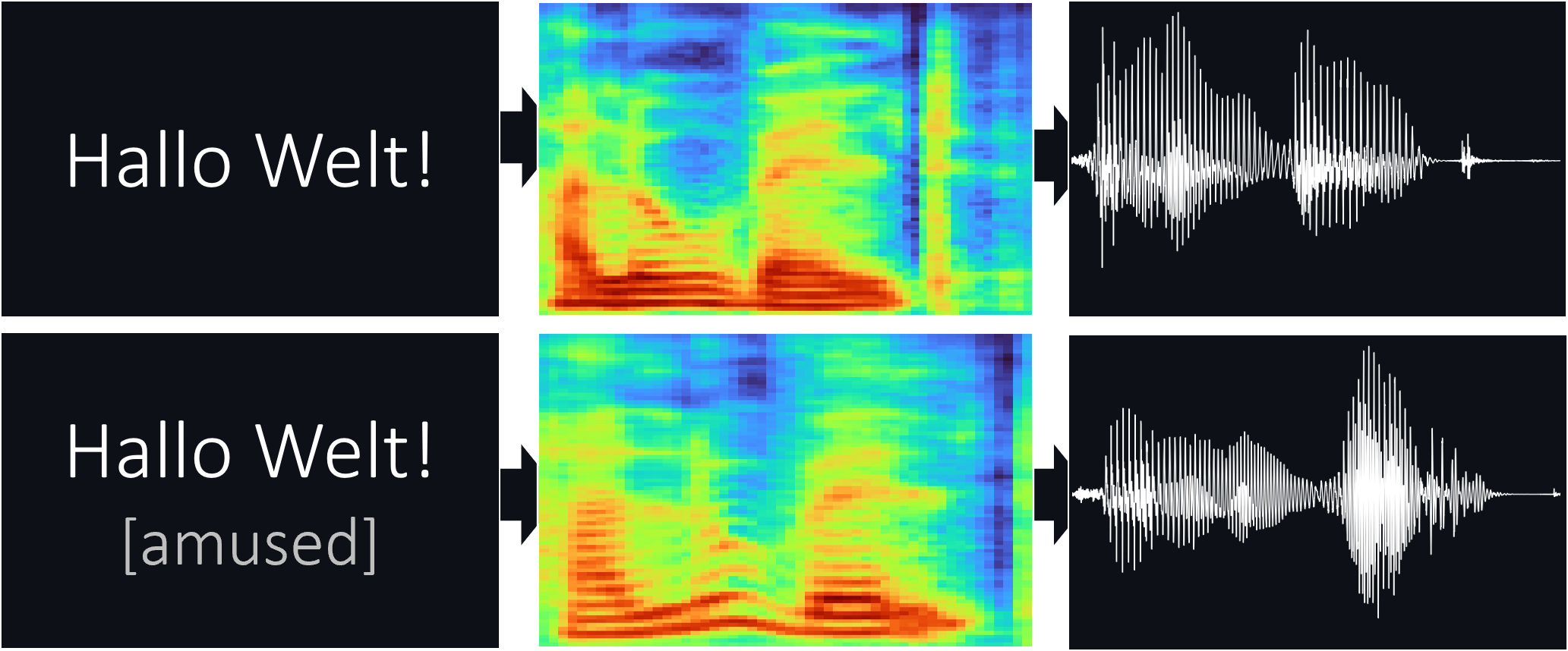

Fastpitch (Arxiv) trainierte auf Thorsten Müllers Thorsten-2022.10 und Thorsten-21.06-emotionale Datensätze.

Sie können hier einige Audio -Samples anhören.

Erforderliche Pakete: torch torchaudio pyyaml phonemizer

Hier finden Sie hier, um phonemizer und das espeak-ng Backend zu installieren.

~ Für das Training: librosa matplotlib tensorboard

~ Für die Demo -App: fastapi "uvicorn[standard]"

Laden Sie die vorgezogenen Gewichte für den FastPitch -Modelllink herunter.

Laden Sie die Hifi-Gan-Vocoder-Gewichte (Link) herunter. Stecken Sie sie entweder in ein pretrained/hifigan-thor-v1 oder bearbeiten Sie die folgenden Zeilen in configs/basic.yaml .

# vocoder

vocoder_state_path : pretrained/hifigan-thor-v1/hifigan-thor.pth

vocoder_config_path : pretrained/hifigan-thor-v1/config.json Der FastPitch von models.fastpitch ist ein Wrapper, der Text-zu-Mel-Inferenz vereinfacht. Das FastPitch2Wave -Modell enthält den Hifi-Gan-Vocoder für direkte Inferenz für direkte Text-zu-Sprache.

from models . fastpitch import FastPitch

model = FastPitch ( 'pretrained/fastpitch_de.pth' )

model = model . cuda ()

mel_spec = model . ttmel ( "Hallo Welt!" ) from models . fastpitch import FastPitch2Wave

model = FastPitch2Wave ( 'pretrained/fastpitch_de.pth' )

model = model . cuda ()

wave = model . tts ( "Hallo Welt!" )

wave_list = model . tts ([ "null" , "eins" , "zwei" , "drei" , "vier" , "fünf" ])Die Web -App verwendet die Fastapi -Bibliothek. Um die App auszuführen, benötigen Sie die folgenden Pakete:

Fastapi: Für die Backend -API | Uvicorn: zum Servieren der App

Installieren mit: pip install fastapi "uvicorn[standard]"

Führen Sie mit: python app.py aus

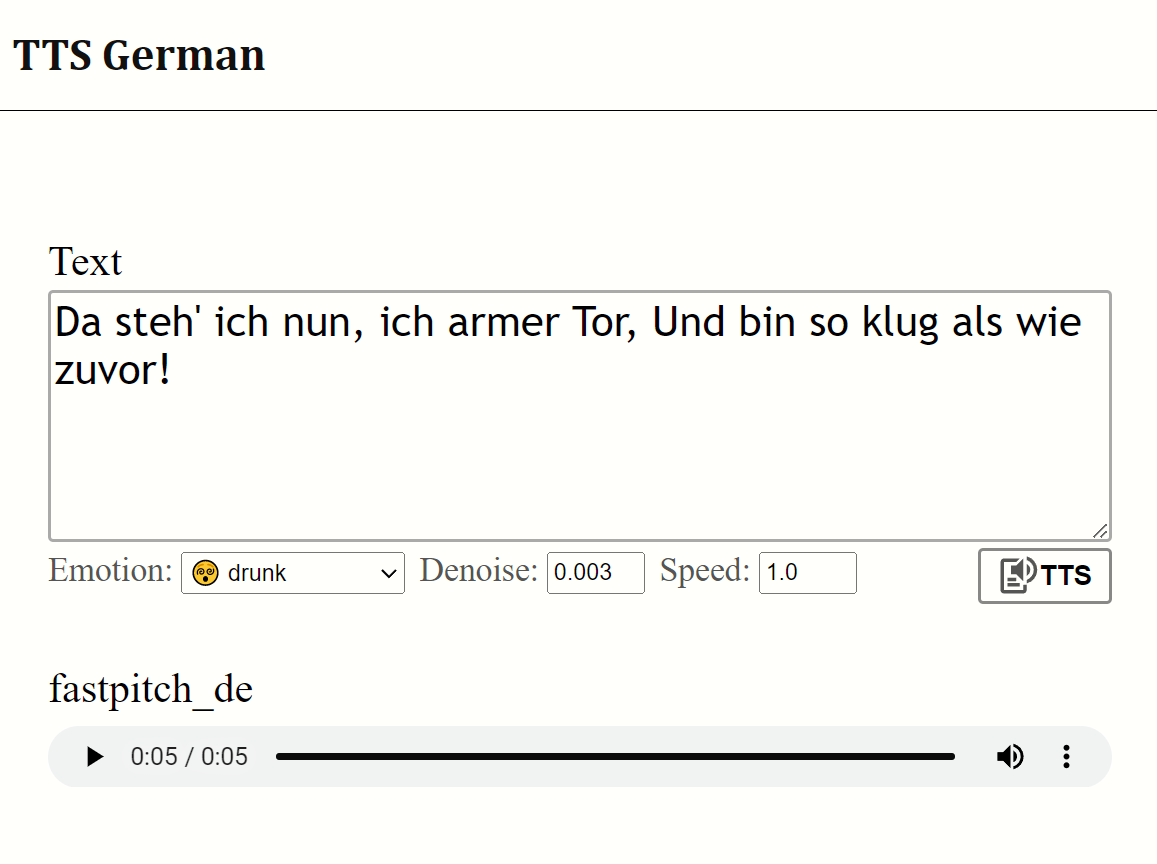

Vorschau:

Vielen Dank an Thorsten Müller für die hochwertigen Datensätze.

Die Fastpitch -Dateien stammen aus den DeepLearning -Examples von Nvidia