تم تدريب Fastpitch (Arxiv) على Thorsten Müller's Thorsten-2022.10 و Thorsten-21.06-مجموعات بيانات.

يمكنك الاستماع إلى بعض عينات الصوت هنا.

الحزم المطلوبة: torch torchaudio pyyaml phonemizer

يرجى الرجوع إلى هنا لتثبيت phonemizer و espeak-ng الخلفية.

~ للتدريب: librosa matplotlib tensorboard

~ للتطبيق التجريبي: fastapi "uvicorn[standard]"

قم بتنزيل الأوزان المسبقة لرابط نموذج FastPitch.

قم بتنزيل أوزان Vocoder HIFI-GAN (الرابط). إما أن تضعهم في pretrained/hifigan-thor-v1 أو تحرير الأسطر التالية في configs/basic.yaml .

# vocoder

vocoder_state_path : pretrained/hifigan-thor-v1/hifigan-thor.pth

vocoder_config_path : pretrained/hifigan-thor-v1/config.json FastPitch من models.fastpitch عبارة عن غلاف يبسط استنتاجًا من النص إلى MEL. يتضمن نموذج FastPitch2Wave Vocoder HIFI من أجل الاستدلال المباشر من النص إلى كلام.

from models . fastpitch import FastPitch

model = FastPitch ( 'pretrained/fastpitch_de.pth' )

model = model . cuda ()

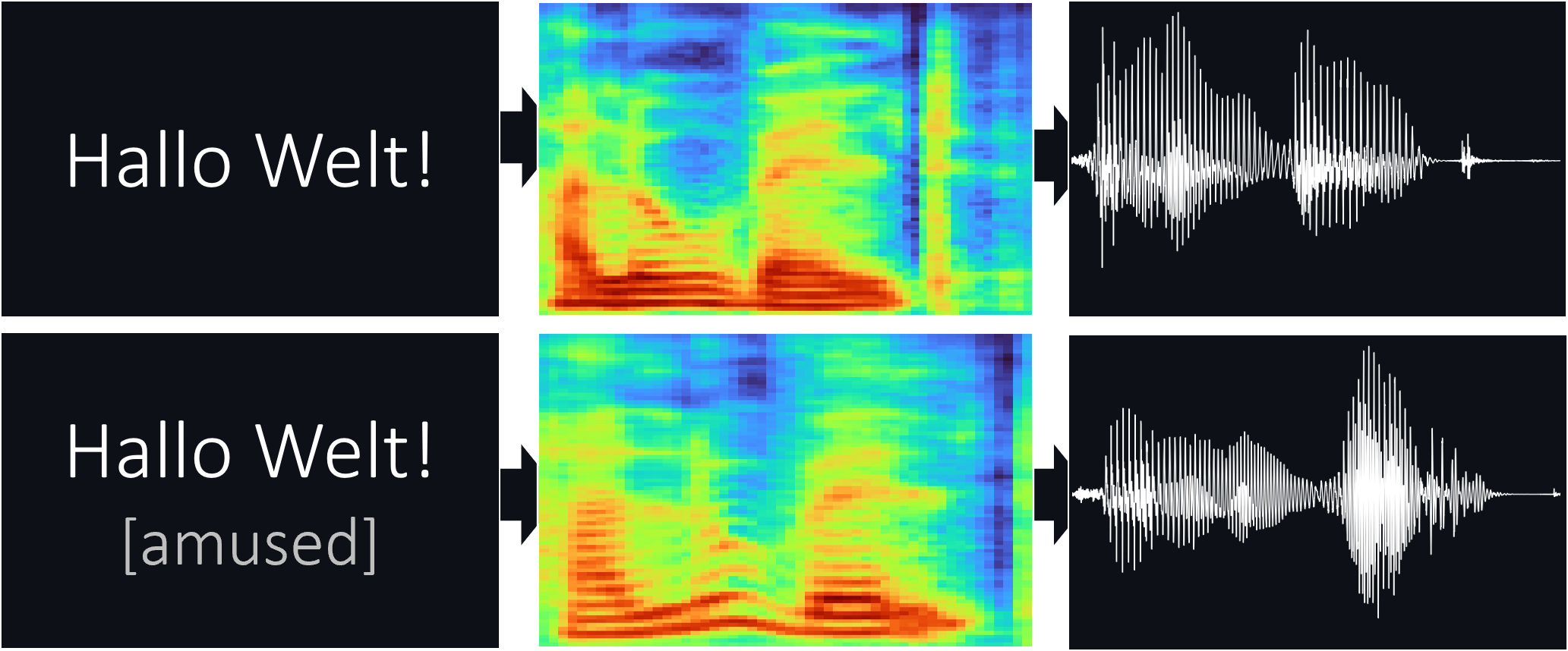

mel_spec = model . ttmel ( "Hallo Welt!" ) from models . fastpitch import FastPitch2Wave

model = FastPitch2Wave ( 'pretrained/fastpitch_de.pth' )

model = model . cuda ()

wave = model . tts ( "Hallo Welt!" )

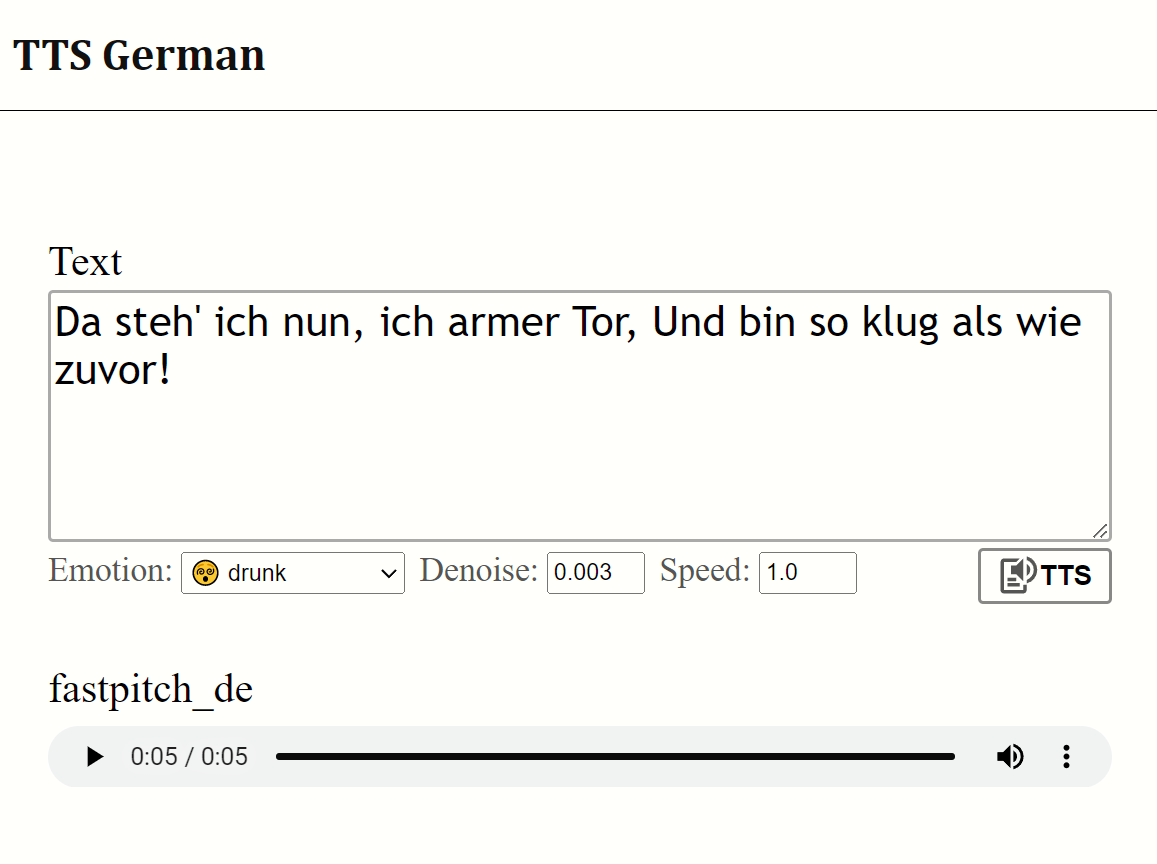

wave_list = model . tts ([ "null" , "eins" , "zwei" , "drei" , "vier" , "fünf" ])يستخدم تطبيق الويب مكتبة Fastapi. لتشغيل التطبيق ، تحتاج إلى الحزم التالية:

Fastapi: لخلفية API | Uvicorn: لخدمة التطبيق

تثبيت مع: pip install fastapi "uvicorn[standard]"

تشغيل مع: python app.py

معاينة:

بفضل Thorsten Müller لمجموعات البيانات عالية الجودة.

تنبع ملفات fastpitch من أمثلة Nvidia's DeepLearningex