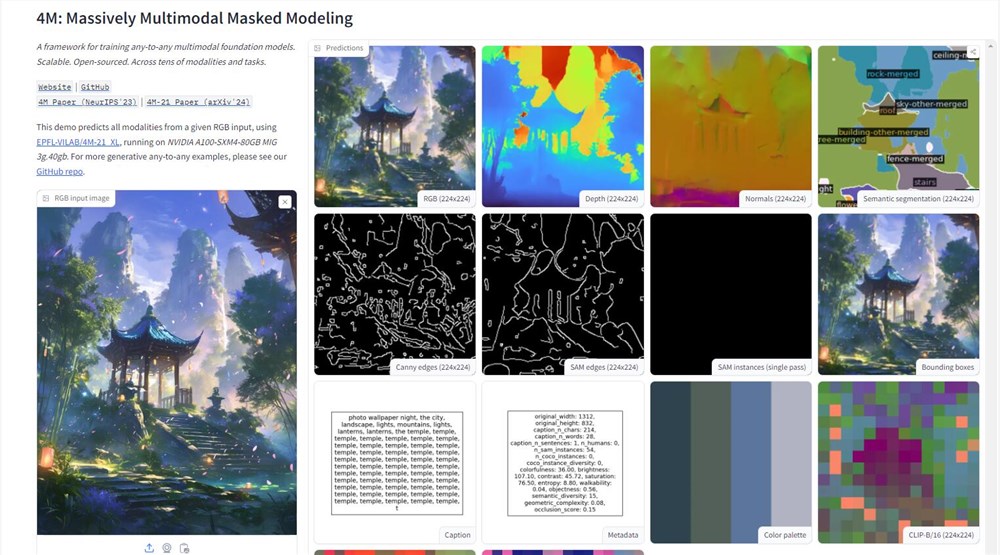

蘋果公司在人工智能領域邁出了重要一步,他們在Hugging Face平台上公開了4M模型的演示。這一多模態AI模型能夠處理文本、圖像和3D場景等多種數據類型,展現出強大的信息處理能力。通過上傳一張圖片,用戶可以輕鬆獲取圖片的深度圖、線稿等詳細信息,這標誌著蘋果在AI技術應用上的重大突破。

4M模型的技術核心在於其"大規模多模態屏蔽建模"訓練方法。這種方法允許模型同時處理多種視覺模態,將圖像、語義和幾何信息轉化為統一的tokens,從而實現不同模態間的無縫對接。這種設計不僅提高了模型的通用性,也為未來的多模態AI應用開闢了新的可能性。

蘋果此舉打破了其在研發領域一貫的保密傳統,主動在開源AI平台上展示技術實力。通過開放4M模型,蘋果不僅展示了其AI技術的先進性,還向開發者社區拋出了橄欖枝,希望圍繞4M構建一個繁榮的生態系統。這預示著蘋果生態系統中可能會出現更多智能化的應用,如更智能的Siri和更高效的Final Cut Pro。

然而,4M模型的推出也帶來了數據實踐和AI倫理方面的挑戰。作為一個數據密集型的AI模型,如何在推動技術進步的同時保護用戶隱私,將是蘋果需要認真考慮的問題。蘋果一直以用戶隱私保護者自居,面對這一挑戰,他們需要在技術創新和用戶信任之間找到平衡點。

在訓練方法上,4M採用了一種創新的隨機選擇標記的方式:將部分標記作為輸入,另一部分作為目標,從而實現訓練目標的可擴展性。這種設計使得4M能夠將圖片和文本都視為數字標記,大大提升了模型的靈活性和適應性。

4M模型的訓練數據來源於全球最大的開源數據集之一CC12M。雖然該數據集數據豐富,但標註信息並不完善。為了解決這個問題,研究人員採用了弱監督偽標籤的方法,利用CLIP、MaskRCNN等技術對數據集進行全面預測,再將預測結果轉化為tokens,為4M的多模態兼容打下了堅實基礎。

經過廣泛的實驗和測試,4M已經證明了自己能夠直接執行多模態任務,無需進行大量的特定任務預訓練或微調。這就像是給了AI一個多模態的瑞士軍刀,讓它能夠靈活應對各種挑戰。 4M的推出不僅展示了蘋果在AI領域的技術實力,也為未來AI應用的發展指明了方向。

演示地址:https://huggingface.co/spaces/EPFL-VILAB/4M