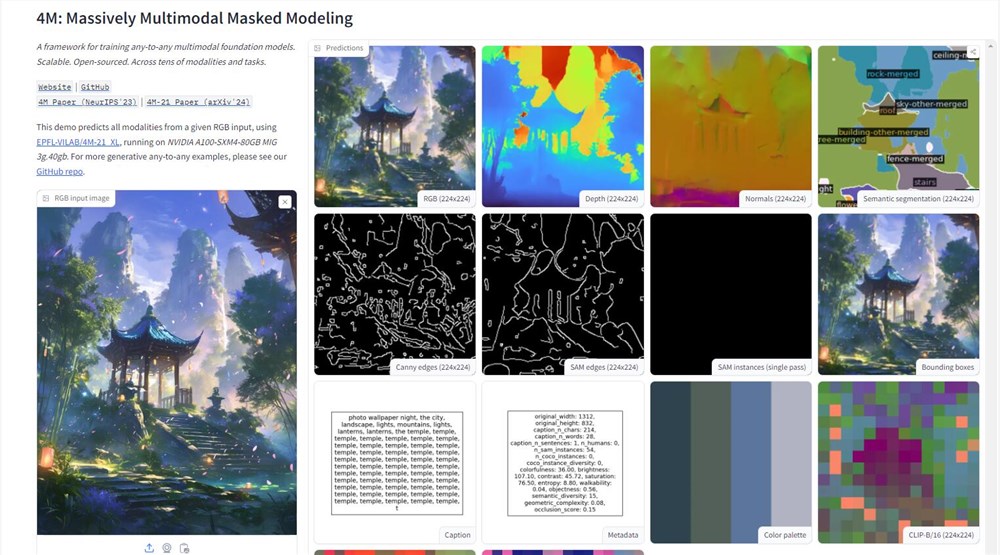

Apple은 인공 지능 분야에서 중요한 단계를 밟았으며 Hugging Face 플랫폼에서 4M 모델의 데모를 공개했습니다. 이 멀티 모달 AI 모델은 텍스트, 이미지 및 3D 장면과 같은 다양한 데이터 유형을 처리하여 강력한 정보 처리 기능을 보여줍니다. 사진을 업로드하면 사용자는 그림의 깊이 맵, 라인 도면 등과 같은 자세한 정보를 쉽게 얻을 수 있으며, 이는 Apple의 AI 기술 응용 프로그램에서 주요 획기적인 획기적인 것으로 나타납니다.

4M 모델의 기술 핵심은 "대규모 멀티 모달 차폐 모델링"교육 방법에 있습니다. 이 방법을 사용하면 모델이 여러 시각적 방식을 동시에 처리하여 이미지, 시맨틱 및 기하학적 정보를 통합 토큰으로 변환하여 다른 양식 간의 원활한 연결을 달성 할 수 있습니다. 이 설계는 모델의 다양성을 향상시킬뿐만 아니라 미래의 멀티 모달 AI 애플리케이션을위한 새로운 가능성을 열어줍니다.

Apple의 움직임은 R & D 분야에서 일관된 기밀 유지 전통을 깨뜨 렸으며 오픈 소스 AI 플랫폼에서 기술 강점을 적극적으로 입증했습니다. Apple은 4M 모델을 개설함으로써 AI 기술의 고급 특성을 보여줄뿐만 아니라 개발자 커뮤니티로 올리브 브랜치를 확장하여 약 4m 정도의 번영하는 생태계를 구축하기를 희망했습니다. 이것은 Smarter Siri 및보다 효율적인 Final Cut Pro와 같은 Apple 생태계에서보다 지능적인 응용의 가능성을 예고합니다.

그러나 4M 모델의 출시는 데이터 실무 및 AI 윤리에 도전을 가져 왔습니다. 데이터 집약적 인 AI 모델로서 기술 진보를 촉진하면서 사용자 개인 정보를 보호하는 방법은 Apple이 심각하게 고려해야 할 문제가 될 것입니다. 애플은 항상 사용자 개인 정보 보호자로 간주되어 기술 혁신과 사용자 신뢰 사이의 균형을 찾아야한다.

훈련 방법 측면에서, 4M은 혁신적인 무작위로 선택된 마킹 방법을 채택합니다 : 마킹에 입력으로, 다른 부분을 대상으로 사용하여 훈련 목표의 확장 성을 달성합니다. 이 디자인을 통해 4M은 그림과 텍스트를 모두 디지털 마커로 취급하여 모델의 유연성과 적응성을 크게 향상시킬 수 있습니다.

4M 모델의 교육 데이터는 세계 최대의 오픈 소스 데이터 세트 중 하나 인 CC12M에서 제공됩니다. 이 데이터 세트는 데이터가 풍부하지만 라벨링 정보는 완벽하지 않습니다. 이 문제를 해결하기 위해 연구원들은 약하게 감독 된 의사 라벨 방법, 중고 클립, MaskRCNN 및 기타 기술을 채택하여 데이터 세트의 포괄적 인 예측을 만들어 4M의 다중 모드 호환성에 대한 견고한 기초를 세웠습니다.

광범위한 실험 및 테스트 후 4M은 특정 작업의 많은 사전 훈련 또는 미세 조정이 필요없이 멀티 모달 작업을 직접 수행 할 수있는 것으로 입증되었습니다. AI에게 다양한 도전을 유연하게 다룰 수있는 멀티 모달 스위스 군용 나이프를 제공하는 것과 같습니다. 4M의 출시는 AI 분야에서 Apple의 기술적 강점을 보여줄뿐만 아니라 AI 애플리케이션의 향후 개발 방향을 지적합니다.

데모 주소 : https://huggingface.co/spaces/epfl-vilab/4m