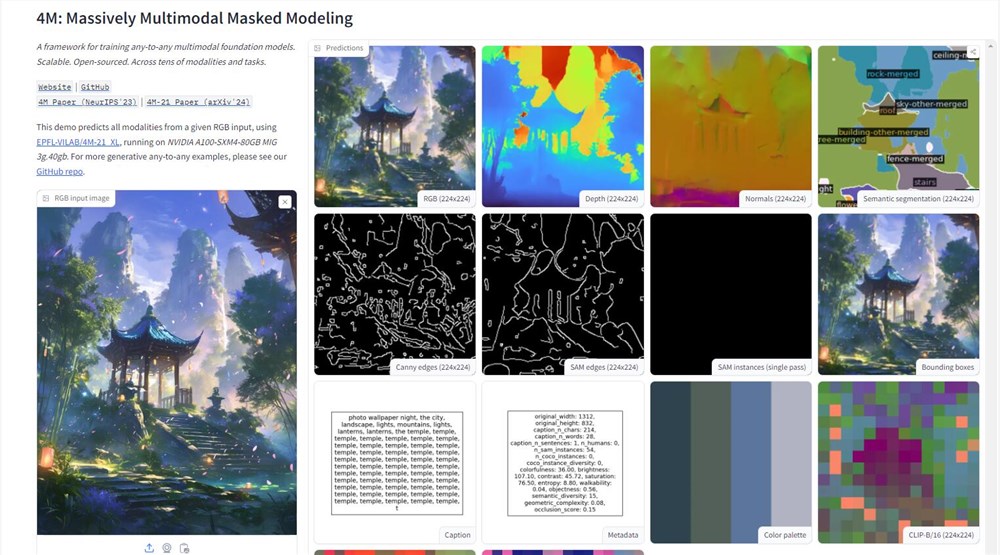

Apple ha dado un paso importante en el campo de la inteligencia artificial, y han revelado una demostración del modelo 4M en la plataforma de abrazadera. Este modelo de IA multimodal puede procesar una variedad de tipos de datos, como texto, imágenes y escenas 3D, demostrando potentes capacidades de procesamiento de información. Al cargar una imagen, los usuarios pueden obtener fácilmente información detallada, como mapas de profundidad, dibujos de línea, etc. de la imagen, que marca un gran avance en la aplicación de tecnología AI de Apple.

El núcleo técnico del modelo 4M se encuentra en su método de entrenamiento de "modelado multimodal de modelado a gran escala". Este método permite que el modelo procese múltiples modalidades visuales simultáneamente, convirtiendo la imagen, la información semántica y geométrica en tokens unificados, logrando así una conexión perfecta entre diferentes modalidades. Este diseño no solo mejora la versatilidad del modelo, sino que también abre nuevas posibilidades para futuras aplicaciones multimodales de IA.

El movimiento de Apple rompió su tradición constante de confidencialidad en el campo de I + D y demostró activamente su fuerza tecnológica en la plataforma de IA de código abierto. Al abrir el modelo 4M, Apple no solo demuestra la naturaleza avanzada de su tecnología AI, sino que también ha extendido una rama de olivo a la comunidad de desarrolladores, con la esperanza de construir un ecosistema próspero alrededor de 4 m. Esto anuncia la posibilidad de aplicaciones más inteligentes en el ecosistema de Apple, como el Smarter Siri y el Final Cut Pro más eficiente.

Sin embargo, el lanzamiento del modelo 4M también trajo desafíos en la práctica de datos y la ética de IA. Como modelo de IA intensivo en datos, cómo proteger la privacidad del usuario al tiempo que promueve el progreso tecnológico será un problema que Apple debe considerar seriamente. Apple siempre se ha considerado un protector de privacidad del usuario.

En términos de métodos de capacitación, 4M adopta un método innovador de marcado seleccionado al azar: tomar parte de la marca como entrada y la otra parte como objetivo, logrando así la escalabilidad del objetivo de entrenamiento. Este diseño permite a 4M tratar tanto las imágenes como el texto como marcadores digitales, mejorando en gran medida la flexibilidad y la adaptabilidad del modelo.

Los datos de capacitación del modelo 4M provienen de CC12M, uno de los conjuntos de datos de código abierto más grandes del mundo. Aunque este conjunto de datos es rico en datos, la información de etiquetado no es perfecta. Para resolver este problema, los investigadores adoptaron un método pseudo-etiquetado débilmente supervisado, el clip utilizado, MaskRCNN y otras tecnologías para hacer predicciones integrales del conjunto de datos, y luego convertir los resultados de la predicción en tokens, colocando una base sólida para la compatibilidad multimodal de 4M.

Después de una extensa experimentación y pruebas, 4M ha demostrado poder realizar tareas multimodales directamente sin la necesidad de una gran cantidad de pre-entrenamiento o ajuste de tareas específicas. Es como darle a AI una navaja multimodal del ejército suizo que le permite lidiar de manera flexible con varios desafíos. El lanzamiento de 4M no solo demuestra la fuerza técnica de Apple en el campo de la IA, sino que también señala la dirección para el desarrollo futuro de aplicaciones de IA.

Dirección de demostración: https://huggingface.co/spaces/epfl-vilab/4m