阿里通義實驗室最近推出的FunAudioLLM項目,標誌著音頻生成技術進入了一個全新的時代。這個開源項目通過其兩大核心模型SenseVoice和CosyVoice,重新定義了人機語音交互的可能性。 FunAudioLLM不僅展示了阿里在人工智能領域的深厚積累,更為未來智能語音技術的發展指明了方向。

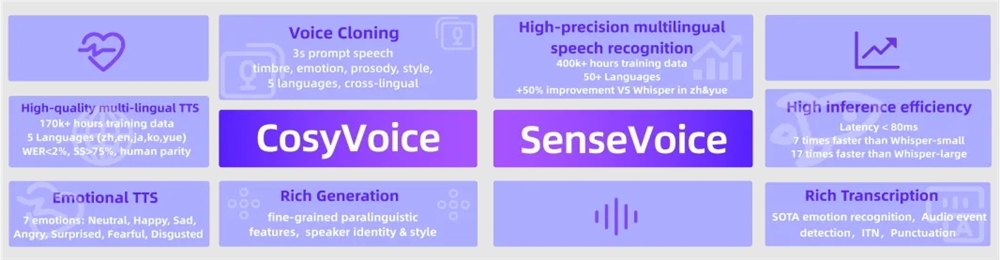

CosyVoice作為項目的語音生成引擎,其技術突破令人矚目。經過15萬小時的多語言數據訓練,該模型不僅實現了中英日粵韓五種語言的流暢生成,更在音色模擬和情感控制方面達到了新的高度。其獨特的零樣本語音生成能力,使得模型能夠快速適應新的說話人聲音,為個性化語音服務提供了無限可能。特別是在跨語言聲音合成方面,CosyVoice展現出了驚人的適應性,為全球化的語音交互應用鋪平了道路。

SenseVoice則代表了語音識別技術的新標杆。經過40萬小時的多語言數據訓練,其識別精度在超過50種語言上都顯著超越了現有的Whisper模型。在中文和粵語識別上,準確率提升超過50%,這為中文市場的智能語音應用帶來了革命性的突破。更值得一提的是,SenseVoice集成了情感識別和音頻事件檢測功能,使得機器不僅能夠聽懂語言,更能理解說話人的情緒和場景信息。

FunAudioLLM的應用場景極其廣泛,從多語言實時翻譯到情感語音對話,從互動播客到智能有聲讀物,每一個領域都蘊含著巨大的商業價值。通過將SenseVoice的精準識別、LLMs的強大理解能力和CosyVoice的自然生成相結合,該項目實現了真正的端到端語音交互體驗。這種無縫的語音到語音翻譯能力,將徹底改變跨語言交流的方式,為全球化商業和文化交流帶來新的可能。

在技術實現上,CosyVoice採用了先進的語音量化編碼技術,確保了生成語音的自然度和流暢性。 SenseVoice則通過多任務學習框架,將自動語音識別、語言識別、情感識別和音頻事件檢測等功能整合到一個統一的模型中,大大提升了系統的效率和準確性。這種技術架構不僅降低了計算成本,更為後續的模型優化和功能擴展提供了良好的基礎。

阿里通義實驗室的開放態度也值得稱讚。項目團隊不僅在ModelScope和Huggingface上發布了完整的模型和代碼,還在GitHub上提供了詳細的訓練、推理和微調指南。這種開源精神將大大促進語音技術領域的研究和應用發展,為整個行業帶來積極的影響。

項目地址:https://github.com/FunAudioLLM