阿里通义实验室最近推出的FunAudioLLM项目,标志着音频生成技术进入了一个全新的时代。这个开源项目通过其两大核心模型SenseVoice和CosyVoice,重新定义了人机语音交互的可能性。FunAudioLLM不仅展示了阿里在人工智能领域的深厚积累,更为未来智能语音技术的发展指明了方向。

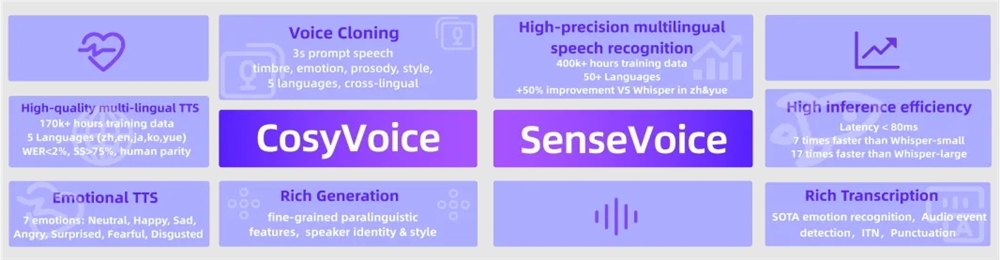

CosyVoice作为项目的语音生成引擎,其技术突破令人瞩目。经过15万小时的多语言数据训练,该模型不仅实现了中英日粤韩五种语言的流畅生成,更在音色模拟和情感控制方面达到了新的高度。其独特的零样本语音生成能力,使得模型能够快速适应新的说话人声音,为个性化语音服务提供了无限可能。特别是在跨语言声音合成方面,CosyVoice展现出了惊人的适应性,为全球化的语音交互应用铺平了道路。

SenseVoice则代表了语音识别技术的新标杆。经过40万小时的多语言数据训练,其识别精度在超过50种语言上都显著超越了现有的Whisper模型。在中文和粤语识别上,准确率提升超过50%,这为中文市场的智能语音应用带来了革命性的突破。更值得一提的是,SenseVoice集成了情感识别和音频事件检测功能,使得机器不仅能够听懂语言,更能理解说话人的情绪和场景信息。

FunAudioLLM的应用场景极其广泛,从多语言实时翻译到情感语音对话,从互动播客到智能有声读物,每一个领域都蕴含着巨大的商业价值。通过将SenseVoice的精准识别、LLMs的强大理解能力和CosyVoice的自然生成相结合,该项目实现了真正的端到端语音交互体验。这种无缝的语音到语音翻译能力,将彻底改变跨语言交流的方式,为全球化商业和文化交流带来新的可能。

在技术实现上,CosyVoice采用了先进的语音量化编码技术,确保了生成语音的自然度和流畅性。SenseVoice则通过多任务学习框架,将自动语音识别、语言识别、情感识别和音频事件检测等功能整合到一个统一的模型中,大大提升了系统的效率和准确性。这种技术架构不仅降低了计算成本,更为后续的模型优化和功能扩展提供了良好的基础。

阿里通义实验室的开放态度也值得称赞。项目团队不仅在ModelScope和Huggingface上发布了完整的模型和代码,还在GitHub上提供了详细的训练、推理和微调指南。这种开源精神将大大促进语音技术领域的研究和应用发展,为整个行业带来积极的影响。

项目地址:https://github.com/FunAudioLLM