騰訊雲近日宣布其DeepSeek-R1大模型已正式登陸騰訊雲HAI平台,並支持“一鍵部署”功能,開發者只需三分鐘即可完成模型接入和調用。此舉大幅簡化了AI應用開發流程,解決了傳統模型部署中繁瑣的硬件配置、驅動安裝、網絡連接等一系列問題。騰訊雲HAI平台旨在為開發者提供高效便捷的AI開發環境,降低AI應用開發的技術門檻,助力開發者快速構建和部署AI應用。

近日,深圳市騰訊計算機系統有限公司正式宣布,其DeepSeek-R1大模型已成功登陸騰訊雲HAI 平台。此次發布的最大亮點是支持“一鍵部署”,開發者僅需三分鐘即可完成模型的接入調用,極大簡化了AI 應用開發的流程。

騰訊雲HAI 的推出,旨在為開發者提供一個高效、便捷的環境,消除傳統部署模型所需的繁瑣步驟。開發者通常需要進行硬件配置、驅動安裝、網絡連接、存儲配置、環境設置、框架安裝、模型下載等多項操作,而通過HAI 平台,開發者只需進行兩步即可輕鬆調用DeepSeek-R1模型。

具體操作步驟包括:

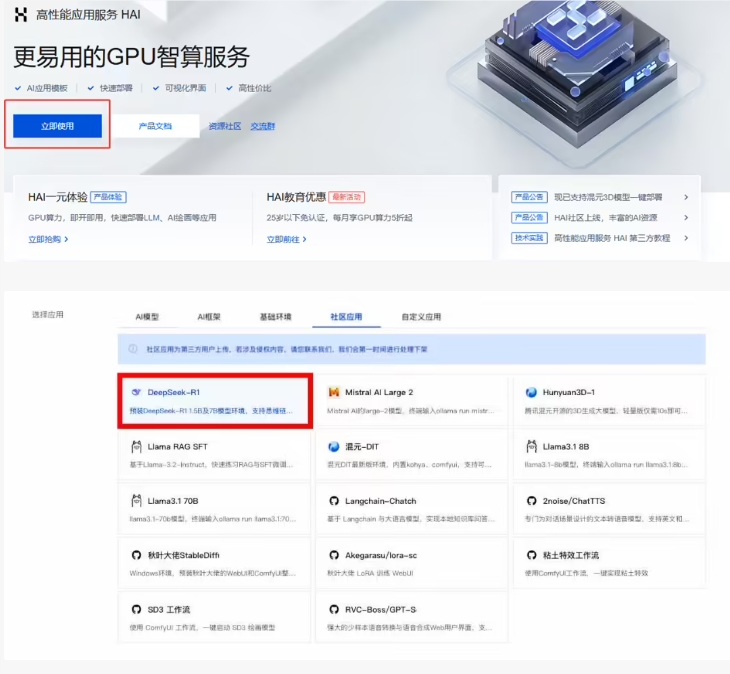

1. 創建DeepSeek-R1應用:開發者登錄騰訊雲HAI,點擊“立即使用” 以新建DeepSeek-R1應用。首次使用的開發者需按照指引完成相關授權。

2. 開始使用DeepSeek-R1:應用創建完成後,開發者可通過站內信獲取密碼,選擇可視化界面(ChatbotUI)或命令行(JupyterLab)進行調用。對於可視化界面,用戶可以在HAI 控制台選擇“算力連接” 後進入ChatbotUI 界面,按照頁面指引操作。而通過命令行方式,則需在HAI 控制台選擇“算力連接”->“JupyterLab”,新建一個Terminal,輸入“ollama run deepseek-r1” 命令即可加載默認的1.5B 模型。

此外,如果用戶對1.5B 模型的性能不滿意,可以通過命令行指令自由切換至7B、8B 或14B 等規格的模型,滿足不同的應用需求。這一靈活性無疑為開發者提供了更大的便利。

DeepSeek-R1的發布標誌著騰訊雲在AI 領域的又一突破,極大地降低了開發者在AI 模型使用過程中的技術門檻。隨著此類技術的不斷發展,AI 應用將越來越普及,開發者也能更加專注於創新和應用的實現。

DeepSeek-R1的便捷部署和靈活的模型選擇,將推動AI應用的快速發展,為開發者創造更多可能性。 騰訊雲HAI平台的推出,無疑是AI領域的一大進步。