tensorflow.delphi (tf.delphi)為Tensorflow和Keras提供了Delphi(Pascal)標準結合。它的目的是在Delphi中實現完整的Tensorflow API,該API允許Pascal開發人員使用Pascal Delphi開發,訓練和部署機器學習模型(將來移植到免費Pascal)。

主分支基於TensorFlow v2.11。無需Python引擎或安裝。

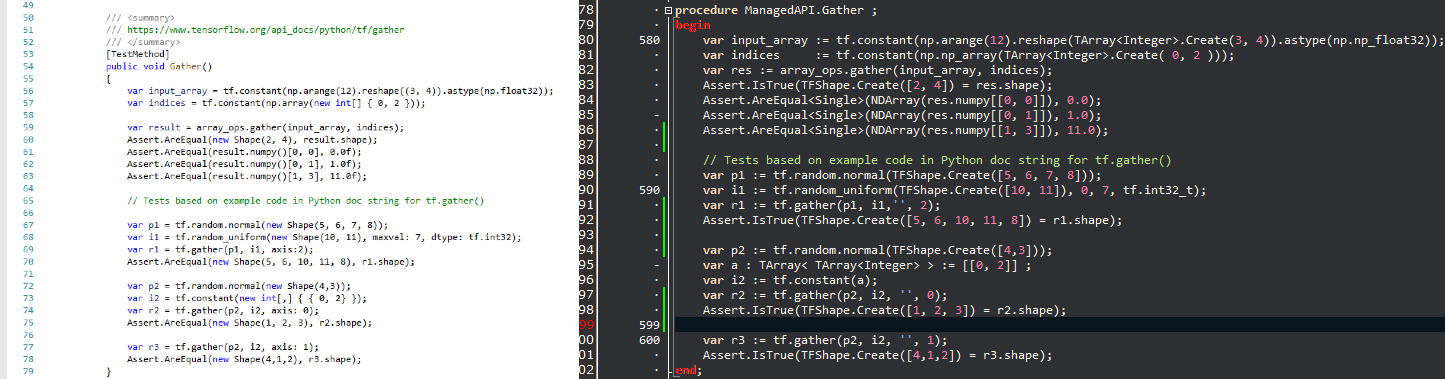

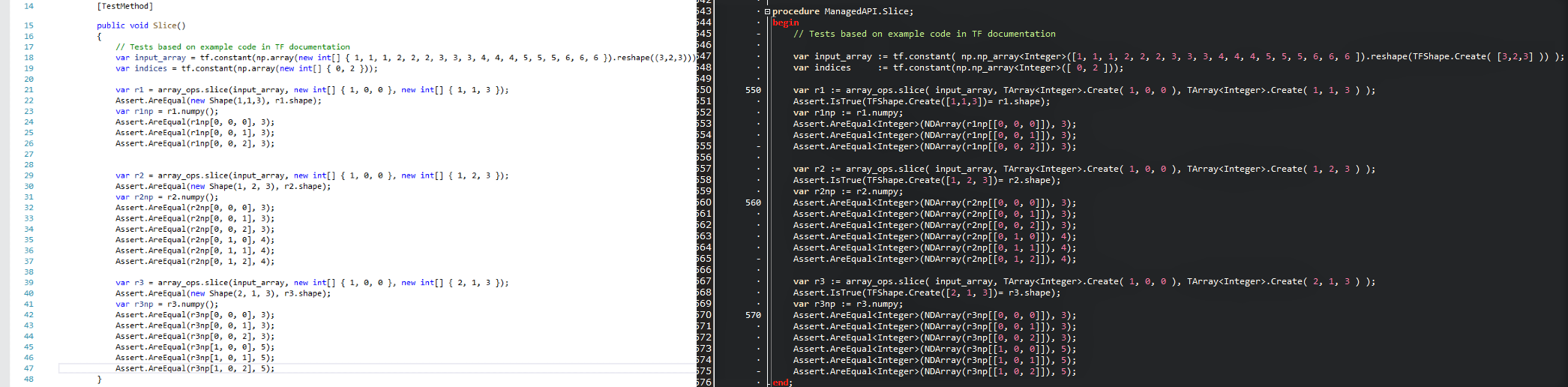

目的是將流行的數據科學技術帶入Delphi世界,並為.delphi/Pascal開發人員提供強大的機器學習工具,而無需重新發明輪子。由於將API保持盡可能相似,因此您可以立即使用Delphi中的任何現有的TensorFlow代碼,零學習曲線。看看比較圖片,看看如何舒適地使用TensorFlow/Python腳本轉換為帶有Tensorflow.delphi的Delphi程序。

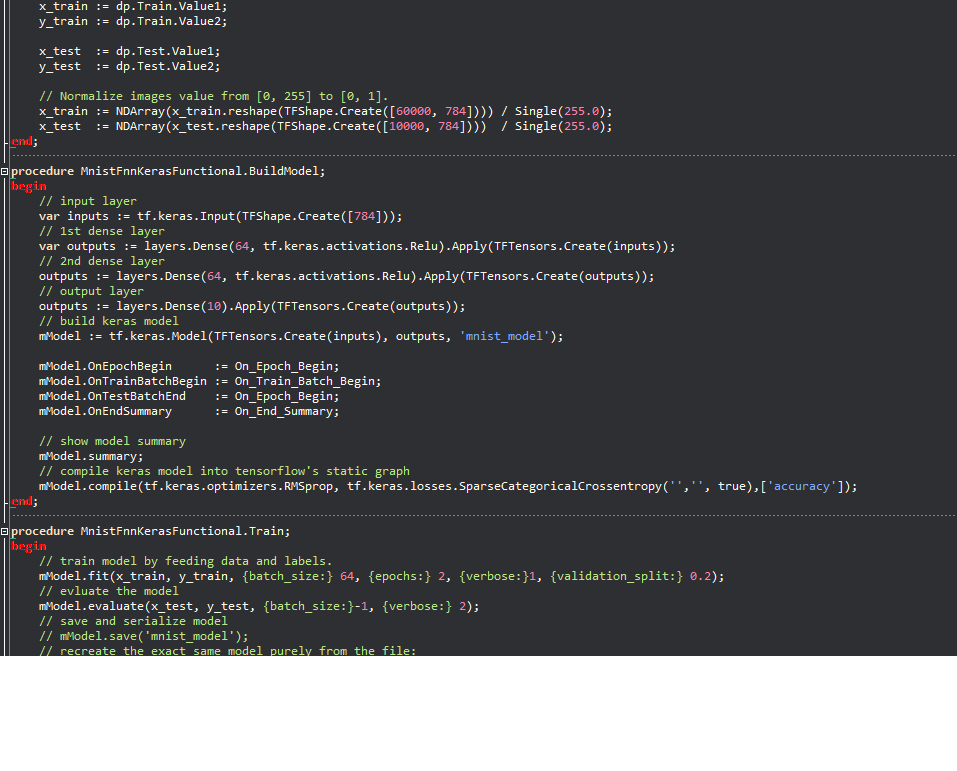

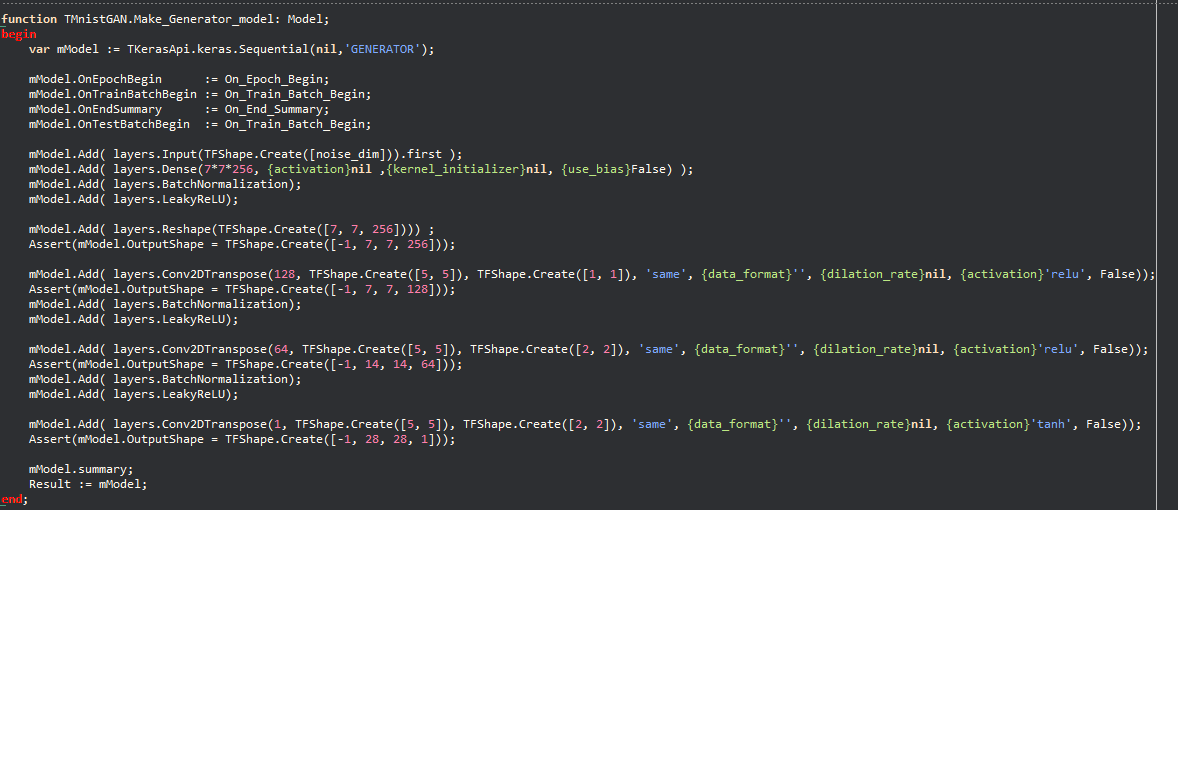

keras示例:

理念允許用Python編寫的大量機器學習代碼迅速遷移到Delphi,使Delphi/Pascal開發人員能夠使用尖端的機器學習模型,並訪問大量的TensorFlow資源,而沒有該項目,這將是不可能的。

tensorflow.delphi還實現了TensorFlow的高級API,所有魔術都會發生。該計算圖構建層仍在主動開發中。一旦完全實施,您就可以在Delphi-Pascal建立新的機器學習模型。

作為參考代碼,我使用了

tesorflow.net

Tensorflow Python

Graph模式下的線性回歸:

function LinearRegression.Run (mmo1: TMemo): Boolean;

begin

tf.compat.v1.disable_eager_execution;

PrepareData;

// tf Graph Input

var X : TTensor := tf.placeholder(tf.float32_t);

var Y : TTensor := tf.placeholder(tf.float32_t);

// Set model weights

// We can set a fixed init value in order to debug

// var rnd1 = rng.randn<float>();

// var rnd2 = rng.randn<float>();

var W := tf.Variable(Single(- 0.06 ), ' weight ' );

var b := tf.Variable(Single(- 0.73 ), ' bias ' );

// Construct a linear model

var pred : TTensor := tf.add(tf.multiply(X, W), b);

// var pred1 := (X * W) + b; OK

// Mean squared error

var cost := TTensor(tf.reduce_sum(tf. pow (pred - Y, 2.0 ))) / ( 2.0 * n_samples) ;

// Gradient descent

// Note, minimize() knows to modify W and b because Variable objects are trainable=True by default

var optimizer := tf.train.GradientDescentOptimizer(learning_rate).minimize(cost);

// Initialize the variables (i.e. assign their default value)

var init := tf.global_variables_initializer;

// Start training

var sess := tf.Session;

// Run the initializer

sess.run(init);

// Fit all training data

var epoch: Integer ;

for epoch := 0 to training_epochs - 1 do

begin

for var zItem in TUtils.zip<Single>(train_X, train_Y) do

begin

var v_x : Single := zItem.Value1 ;

var v_y : Single := zItem.Value2 ;

sess.run(optimizer, [ Tuple<TValue,TValue>.Create(X, v_x), Tuple<TValue,TValue>.Create(Y, v_y) ]);

end ;

// Display logs per epoch step

if ((epoch + 1 ) mod display_step) = 0 then

begin

var fc : Single := NDArray(sess.run(cost, [ Tuple<TValue,TValue>.Create(X, train_X), Tuple<TValue,TValue>.Create(Y, train_Y) ]));

var fW : Single := NDArray(sess.run( TResourceVariable(W) ));

var fb : Single := NDArray(sess.run( TResourceVariable(b) ));

mmo1.Lines.Add( Format( ' Epoch: %d cost=%.9f + "W=%.9f b=%.9f" ' ,[epoch + 1 ,fc, fW,fb]) );

end ;

end ;

mmo1.Lines.Add( ' Optimization Finished! ' );

var training_cost : Single := NDArray(sess.run(cost, [ Tuple<TValue,TValue>.Create(X, train_X), Tuple<TValue,TValue>.Create(Y, train_Y) ]));

var fW : Single := NDArray(sess.run( TResourceVariable(W) ));

var fb : Single := NDArray(sess.run( TResourceVariable(b) ));

mmo1.Lines.Add( ' ' );

mmo1.Lines.Add(Format( ' Training cost=%.9f W=%.9f b=%.9f ' ,[training_cost, fW, fb]));

// Testing example

var test_X : NDArray := np.np_array( TArray<Single>.Create( 6.83 , 4.668 , 8.9 , 7.91 , 5.7 , 8.7 , 3.1 , 2.1 ) );

var test_Y : NDArray := np.np_array( TArray<Single>.Create( 1.84 , 2.273 , 3.2 , 2.831 , 2.92 , 3.24 , 1.35 , 1.03 ) );

mmo1.Lines.Add( ' Testing... (Mean square loss Comparison) ' );

var t_cost := TTensor(tf.reduce_sum(tf. pow (pred - Y, 2.0 ))) / ( 2.0 * test_X.shape[ 0 ]) ;

var testing_cost : Single := NDArray(sess.run(t_cost, [ Tuple<TValue,TValue>.Create(X, test_X), Tuple<TValue,TValue>.Create(Y, test_Y) ]));

mmo1.Lines.Add( ' ' );

mmo1.Lines.Add( Format( ' Testing cost=%.9f ' ,[testing_cost]) );

var diff := Abs( training_cost - testing_cost);

mmo1.Lines.Add( Format( ' Absolute mean square loss difference: %.9f ' ,[diff]) );

mmo1.Lines.Add( ' ' );

Result := diff < 0.01 ;

end ;與支持內聯變量(10.3及更高)的所有Delphi版本兼容。

要編譯您需要一些外部庫:

是否想為機器學習領域中最熱門的項目之一做出貢獻?想知道張量如何神奇地創建計算圖嗎?無論如何,我們都感謝所有貢獻。對於專家來說,新手的任務是,如果每個人都只處理一項小任務,那麼貢獻的總和將是巨大的。

你可以:

在Twitter上關注我們