Tensorflow.delphi (tf.delphi) fornece uma ligação padrão Delphi (Pascal) para Tensorflow e Keras. Ele visa implementar a API completa do TensorFlow em Delphi, que permite que os desenvolvedores da Pascal desenvolvam, treinem e implavem modelos de aprendizado de máquina com o Pascal Delphi (porta para libertar Pascal no futuro).

O Master Branch é baseado no Tensorflow v2.11. Não é necessário motor ou instalação python .

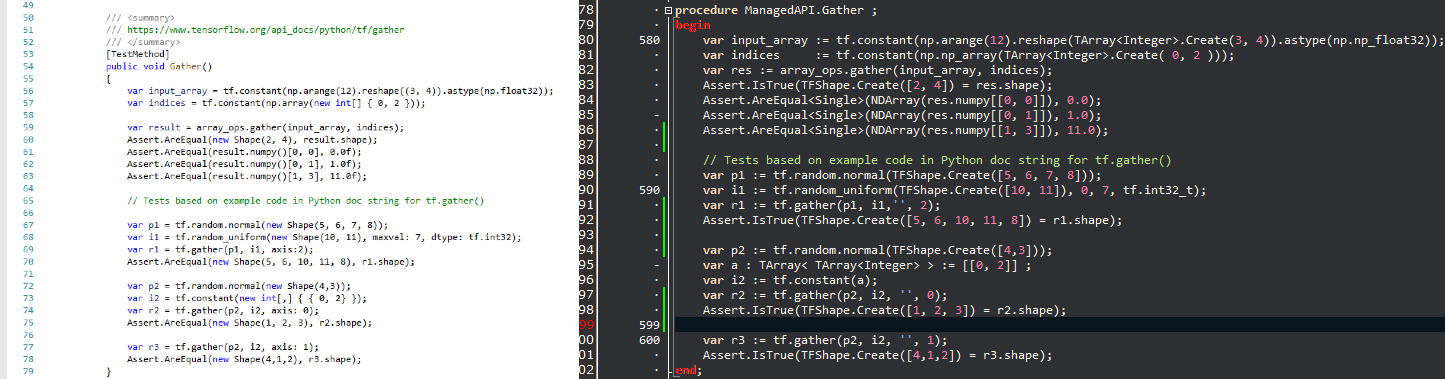

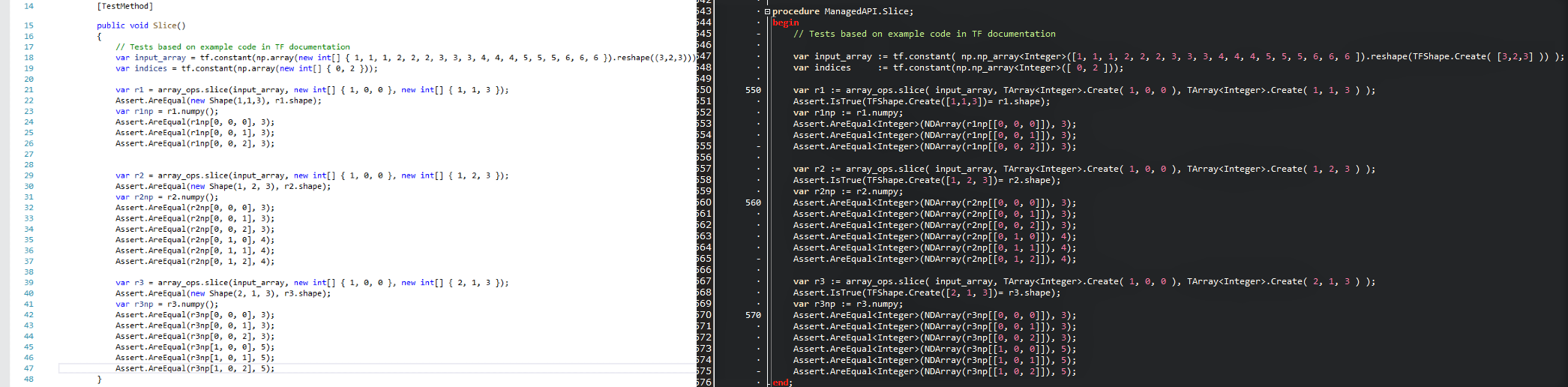

A intenção é trazer a tecnologia popular de ciência de dados para o mundo Delphi e fornecer aos desenvolvedores .Delphi/Pascal um poderoso conjunto de ferramentas de aprendizado de máquina sem reinventar a roda. Como as APIs são mantidas o mais semelhante possível, você pode adaptar imediatamente qualquer código de tensorflow existente em Delphi com uma curva de aprendizado zero. Dê uma olhada em uma foto de comparação e veja como um script de tensorflow/python se traduz em um programa Delphi com tensorflow.delphi.

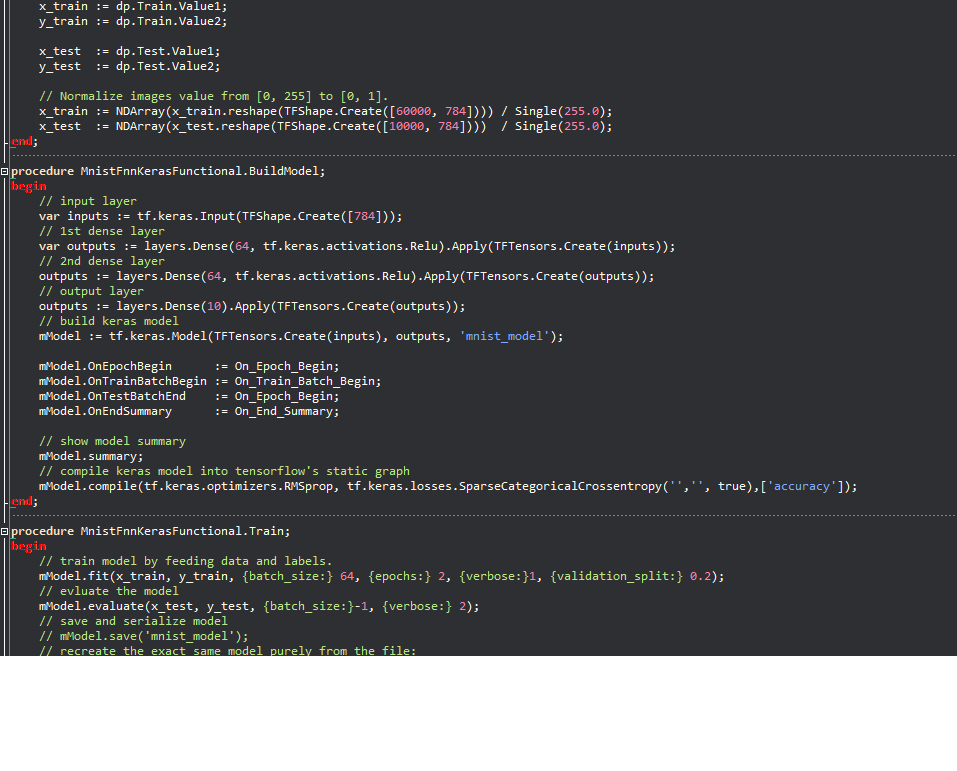

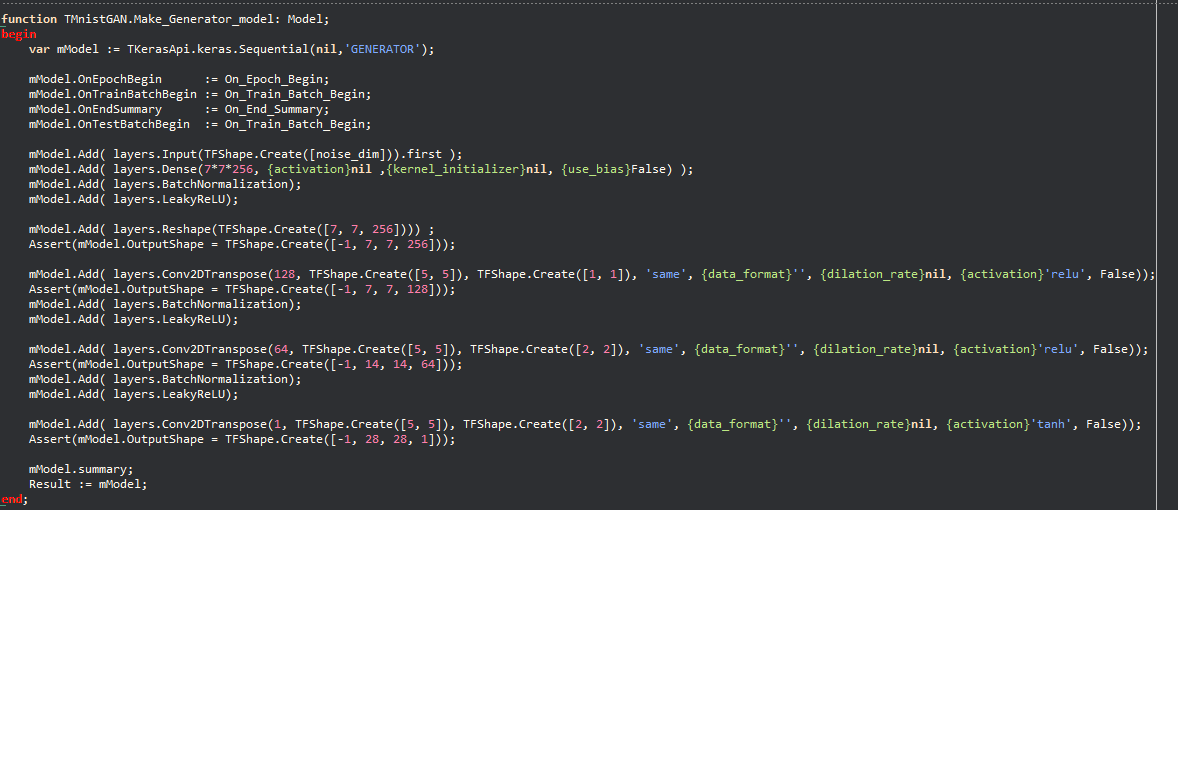

Exemplos de Keras:

A filosofia permite que um grande número de código de aprendizado de máquina escrito em Python seja rapidamente migrado para a Delphi, permitindo que os desenvolvedores Delphi/Pascal usem modelos de aprendizado de máquina de ponta e acessem um grande número de recursos de tensorflow que não seriam possíveis sem este projeto.

O Tensorflow.delphi também implementa a API de alto nível do TensorFlow, onde toda a mágica acontece. Esta camada de construção de gráficos de computação ainda está em desenvolvimento ativo. Uma vez implementado completamente, você pode criar novos modelos de aprendizado de máquina no Delphi-Pascal.

Como um código de referência que usei

Tesorflow.net

Tensorflow Python

Regressão linear no modo Graph :

function LinearRegression.Run (mmo1: TMemo): Boolean;

begin

tf.compat.v1.disable_eager_execution;

PrepareData;

// tf Graph Input

var X : TTensor := tf.placeholder(tf.float32_t);

var Y : TTensor := tf.placeholder(tf.float32_t);

// Set model weights

// We can set a fixed init value in order to debug

// var rnd1 = rng.randn<float>();

// var rnd2 = rng.randn<float>();

var W := tf.Variable(Single(- 0.06 ), ' weight ' );

var b := tf.Variable(Single(- 0.73 ), ' bias ' );

// Construct a linear model

var pred : TTensor := tf.add(tf.multiply(X, W), b);

// var pred1 := (X * W) + b; OK

// Mean squared error

var cost := TTensor(tf.reduce_sum(tf. pow (pred - Y, 2.0 ))) / ( 2.0 * n_samples) ;

// Gradient descent

// Note, minimize() knows to modify W and b because Variable objects are trainable=True by default

var optimizer := tf.train.GradientDescentOptimizer(learning_rate).minimize(cost);

// Initialize the variables (i.e. assign their default value)

var init := tf.global_variables_initializer;

// Start training

var sess := tf.Session;

// Run the initializer

sess.run(init);

// Fit all training data

var epoch: Integer ;

for epoch := 0 to training_epochs - 1 do

begin

for var zItem in TUtils.zip<Single>(train_X, train_Y) do

begin

var v_x : Single := zItem.Value1 ;

var v_y : Single := zItem.Value2 ;

sess.run(optimizer, [ Tuple<TValue,TValue>.Create(X, v_x), Tuple<TValue,TValue>.Create(Y, v_y) ]);

end ;

// Display logs per epoch step

if ((epoch + 1 ) mod display_step) = 0 then

begin

var fc : Single := NDArray(sess.run(cost, [ Tuple<TValue,TValue>.Create(X, train_X), Tuple<TValue,TValue>.Create(Y, train_Y) ]));

var fW : Single := NDArray(sess.run( TResourceVariable(W) ));

var fb : Single := NDArray(sess.run( TResourceVariable(b) ));

mmo1.Lines.Add( Format( ' Epoch: %d cost=%.9f + "W=%.9f b=%.9f" ' ,[epoch + 1 ,fc, fW,fb]) );

end ;

end ;

mmo1.Lines.Add( ' Optimization Finished! ' );

var training_cost : Single := NDArray(sess.run(cost, [ Tuple<TValue,TValue>.Create(X, train_X), Tuple<TValue,TValue>.Create(Y, train_Y) ]));

var fW : Single := NDArray(sess.run( TResourceVariable(W) ));

var fb : Single := NDArray(sess.run( TResourceVariable(b) ));

mmo1.Lines.Add( ' ' );

mmo1.Lines.Add(Format( ' Training cost=%.9f W=%.9f b=%.9f ' ,[training_cost, fW, fb]));

// Testing example

var test_X : NDArray := np.np_array( TArray<Single>.Create( 6.83 , 4.668 , 8.9 , 7.91 , 5.7 , 8.7 , 3.1 , 2.1 ) );

var test_Y : NDArray := np.np_array( TArray<Single>.Create( 1.84 , 2.273 , 3.2 , 2.831 , 2.92 , 3.24 , 1.35 , 1.03 ) );

mmo1.Lines.Add( ' Testing... (Mean square loss Comparison) ' );

var t_cost := TTensor(tf.reduce_sum(tf. pow (pred - Y, 2.0 ))) / ( 2.0 * test_X.shape[ 0 ]) ;

var testing_cost : Single := NDArray(sess.run(t_cost, [ Tuple<TValue,TValue>.Create(X, test_X), Tuple<TValue,TValue>.Create(Y, test_Y) ]));

mmo1.Lines.Add( ' ' );

mmo1.Lines.Add( Format( ' Testing cost=%.9f ' ,[testing_cost]) );

var diff := Abs( training_cost - testing_cost);

mmo1.Lines.Add( Format( ' Absolute mean square loss difference: %.9f ' ,[diff]) );

mmo1.Lines.Add( ' ' );

Result := diff < 0.01 ;

end ;Compatível com todas as versões Delphi que suportam variável embutida (10.3 e superior).

Para compilar, você precisa de algumas bibliotecas externas:

Está com vontade de contribuir para um dos projetos mais quentes no campo de aprendizado de máquina? Quer saber como o TensorFlow cria magicamente o gráfico computacional? Agradecemos todas as contribuições, por mais pequenas que sejam. Existem tarefas para iniciantes para especialistas, se todos abordarem apenas uma pequena tarefa, a soma das contribuições será enorme.

Você pode:

Siga -nos no Twitter