Tensorflow.delphi (tf.delphi)は、TensorflowとKerasのDelphi(Pascal)標準的な結合を提供します。 Pascal DevelopersがPascal Delphiを使用して機械学習モデルを開発、訓練、展開できるようにするDelphiに完全なTensorflow APIを実装することを目的としています(将来、Pascalを無料で移植)。

マスターブランチは、Tensorflow v2.11に基づいています。 Pythonエンジンやインストールは必要ありません。

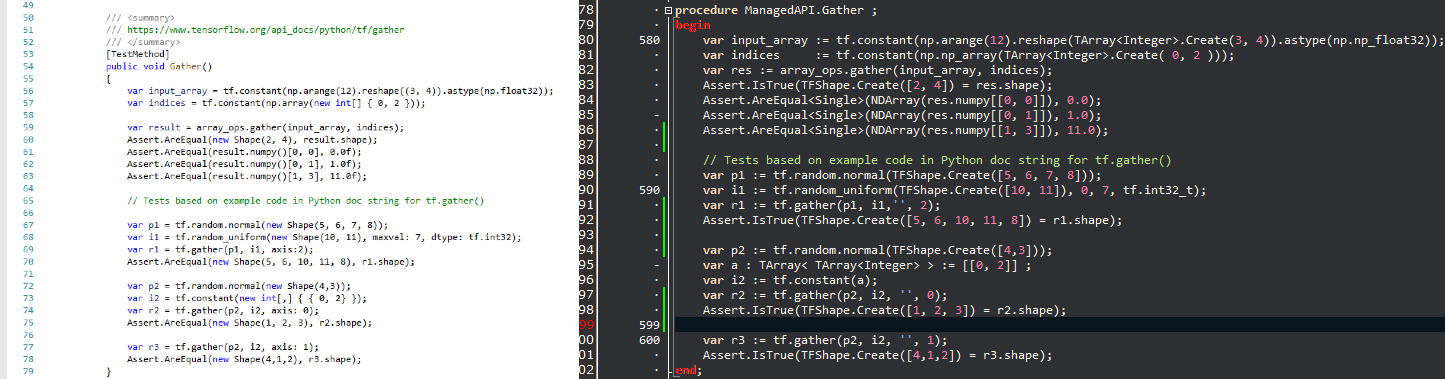

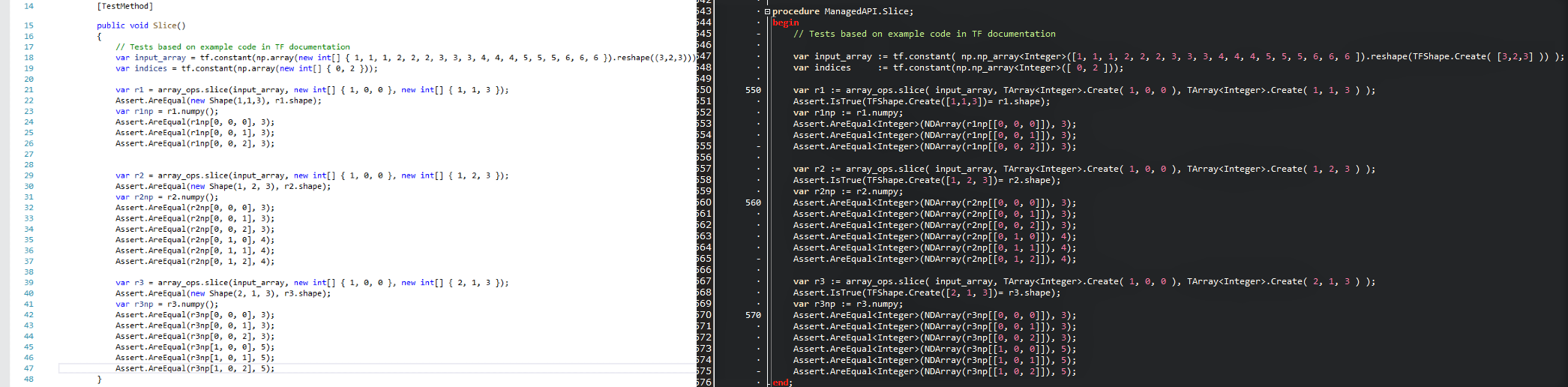

目的は、人気のあるデータサイエンステクノロジーをDelphiの世界に持ち込み、Delphi/Pascal開発者にホイールを再発明することなく強力な機械学習ツールセットを提供することです。 APIは可能な限り類似しているため、Delphiの既存のTensorflowコードをゼロ学習曲線ですぐに適応させることができます。比較の写真を見て、Tensorflow/PythonスクリプトがTensorflow.delphiを使用したDelphiプログラムにどれだけ快適に翻訳されているかを確認してください。

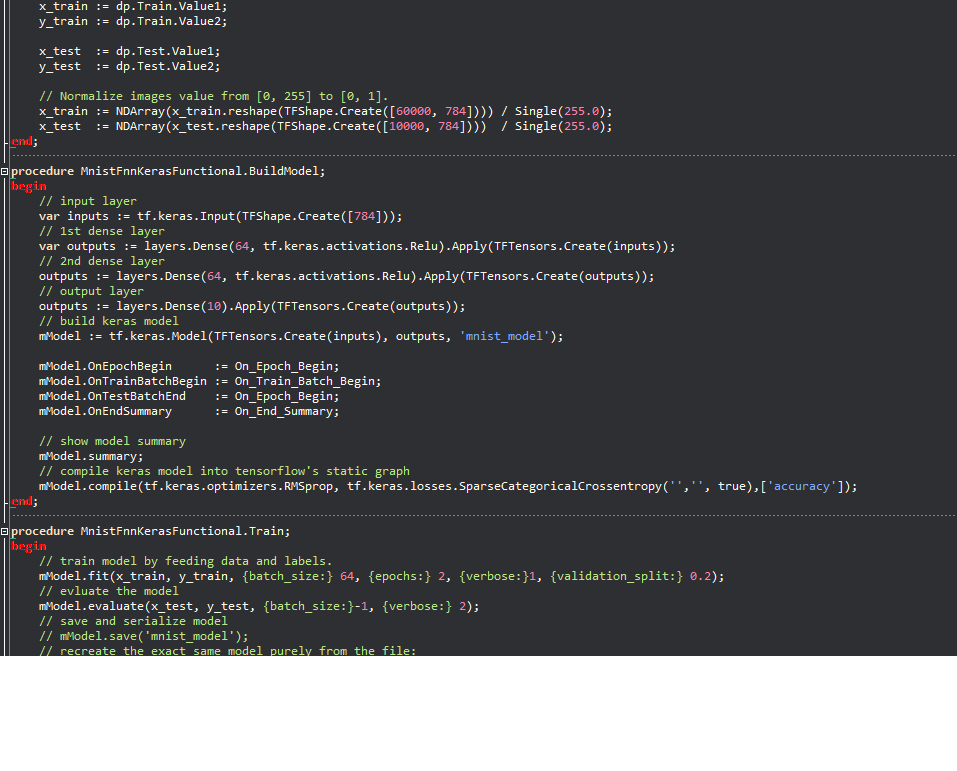

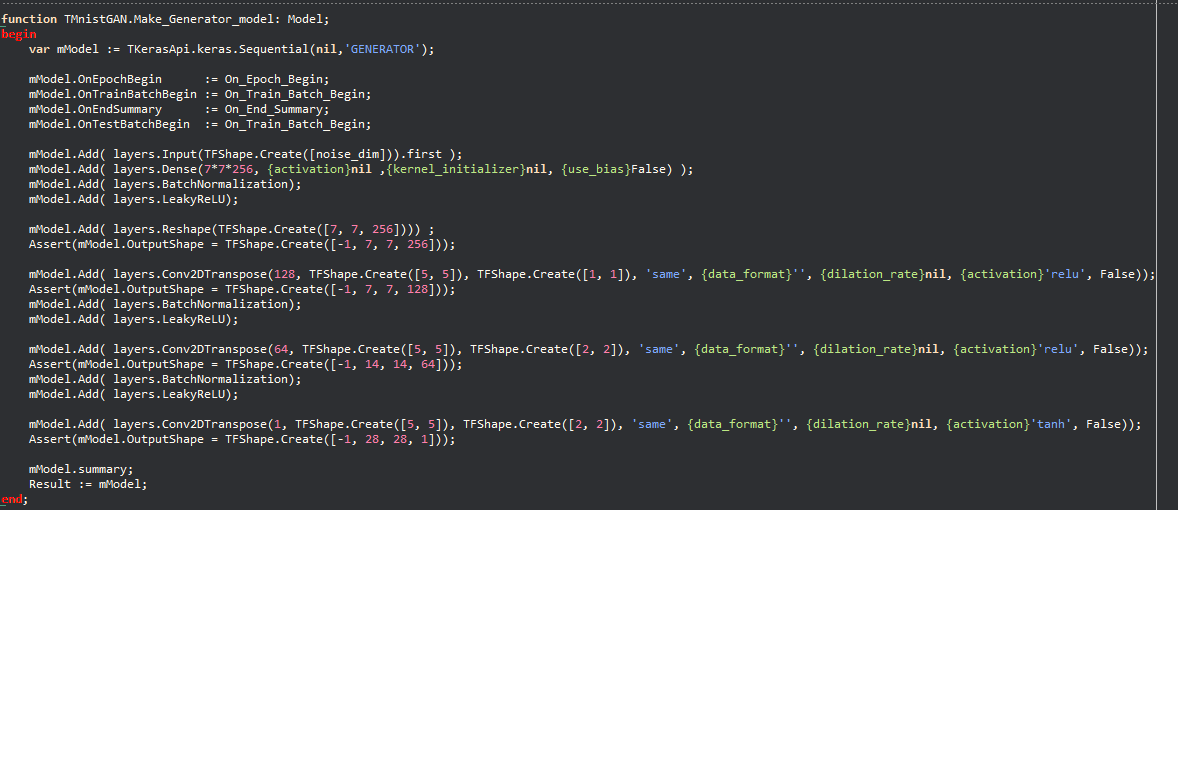

ケラスの例:

哲学により、Pythonで書かれた多数の機械学習コードをDelphiに迅速に移行することができ、Delphi/Pascal開発者は最先端の機械学習モデルを使用し、このプロジェクトなしでは不可能な膨大な数のTensorflowリソースにアクセスできます。

Tensorflow.delphiは、すべての魔法が発生する場所でTensorflowの高レベルAPIを実装しています。この計算グラフの構築層は、まだアクティブな開発中です。完全に実装されたら、Delphi-Pascalで新しい機械学習モデルを構築できます。

私が使用した参照コードとして

tesorflow.net

Tensorflow Python

Graphモードでの線形回帰:

function LinearRegression.Run (mmo1: TMemo): Boolean;

begin

tf.compat.v1.disable_eager_execution;

PrepareData;

// tf Graph Input

var X : TTensor := tf.placeholder(tf.float32_t);

var Y : TTensor := tf.placeholder(tf.float32_t);

// Set model weights

// We can set a fixed init value in order to debug

// var rnd1 = rng.randn<float>();

// var rnd2 = rng.randn<float>();

var W := tf.Variable(Single(- 0.06 ), ' weight ' );

var b := tf.Variable(Single(- 0.73 ), ' bias ' );

// Construct a linear model

var pred : TTensor := tf.add(tf.multiply(X, W), b);

// var pred1 := (X * W) + b; OK

// Mean squared error

var cost := TTensor(tf.reduce_sum(tf. pow (pred - Y, 2.0 ))) / ( 2.0 * n_samples) ;

// Gradient descent

// Note, minimize() knows to modify W and b because Variable objects are trainable=True by default

var optimizer := tf.train.GradientDescentOptimizer(learning_rate).minimize(cost);

// Initialize the variables (i.e. assign their default value)

var init := tf.global_variables_initializer;

// Start training

var sess := tf.Session;

// Run the initializer

sess.run(init);

// Fit all training data

var epoch: Integer ;

for epoch := 0 to training_epochs - 1 do

begin

for var zItem in TUtils.zip<Single>(train_X, train_Y) do

begin

var v_x : Single := zItem.Value1 ;

var v_y : Single := zItem.Value2 ;

sess.run(optimizer, [ Tuple<TValue,TValue>.Create(X, v_x), Tuple<TValue,TValue>.Create(Y, v_y) ]);

end ;

// Display logs per epoch step

if ((epoch + 1 ) mod display_step) = 0 then

begin

var fc : Single := NDArray(sess.run(cost, [ Tuple<TValue,TValue>.Create(X, train_X), Tuple<TValue,TValue>.Create(Y, train_Y) ]));

var fW : Single := NDArray(sess.run( TResourceVariable(W) ));

var fb : Single := NDArray(sess.run( TResourceVariable(b) ));

mmo1.Lines.Add( Format( ' Epoch: %d cost=%.9f + "W=%.9f b=%.9f" ' ,[epoch + 1 ,fc, fW,fb]) );

end ;

end ;

mmo1.Lines.Add( ' Optimization Finished! ' );

var training_cost : Single := NDArray(sess.run(cost, [ Tuple<TValue,TValue>.Create(X, train_X), Tuple<TValue,TValue>.Create(Y, train_Y) ]));

var fW : Single := NDArray(sess.run( TResourceVariable(W) ));

var fb : Single := NDArray(sess.run( TResourceVariable(b) ));

mmo1.Lines.Add( ' ' );

mmo1.Lines.Add(Format( ' Training cost=%.9f W=%.9f b=%.9f ' ,[training_cost, fW, fb]));

// Testing example

var test_X : NDArray := np.np_array( TArray<Single>.Create( 6.83 , 4.668 , 8.9 , 7.91 , 5.7 , 8.7 , 3.1 , 2.1 ) );

var test_Y : NDArray := np.np_array( TArray<Single>.Create( 1.84 , 2.273 , 3.2 , 2.831 , 2.92 , 3.24 , 1.35 , 1.03 ) );

mmo1.Lines.Add( ' Testing... (Mean square loss Comparison) ' );

var t_cost := TTensor(tf.reduce_sum(tf. pow (pred - Y, 2.0 ))) / ( 2.0 * test_X.shape[ 0 ]) ;

var testing_cost : Single := NDArray(sess.run(t_cost, [ Tuple<TValue,TValue>.Create(X, test_X), Tuple<TValue,TValue>.Create(Y, test_Y) ]));

mmo1.Lines.Add( ' ' );

mmo1.Lines.Add( Format( ' Testing cost=%.9f ' ,[testing_cost]) );

var diff := Abs( training_cost - testing_cost);

mmo1.Lines.Add( Format( ' Absolute mean square loss difference: %.9f ' ,[diff]) );

mmo1.Lines.Add( ' ' );

Result := diff < 0.01 ;

end ;インライン変数(10.3以降)をサポートするすべてのDelphiバージョンと互換性があります。

コンパイルするには、いくつかの外部ライブラリが必要です。

機械学習分野で最もホットなプロジェクトの1つに貢献したいと思いますか? Tensorflowが魔法のように計算グラフをどのように作成するかを知りたいですか?どんなに小さな貢献に感謝しています。誰もが小さなタスクに取り組む場合、専門家にとって初心者向けのタスクがあります。貢献の合計は巨大になります。

あなたはできる:

Twitterでフォローしてください