nn dependability kit

1.0.0

NN依賴性kit是一種開源研究工具,可幫助工程神經網絡,以實現安全至關重要的領域。

C.-H。 Cheng,C.-H。黃和G.Nührenberg。 NN依賴性KIT:用於安全至關重要自主駕駛系統的工程神經網絡。 https://arxiv.org/abs/1811.06746

GNU AFFERO通用公共許可證(AGPL)版本3

請參閱nn_depentability_kit_manual.pdf

示例作為jupyter筆記本,以允許對概念的分步理解。

有四個包裹在NNDETABINABY下,即

pytorch + numpy + matplotlib + jupyter

[測試案例生成] Google優化研究工具

[驗證 /靜態分析]紙漿(基於Python的MILP連接器到CBC和其他求解器)

[運行時驗證] DD(使用Python實施的二進制決策圖)

使用要求.txt安裝依賴項來運行大多數筆記本電腦(不包括張量)。

# init submodule for saliency

cd nndependability/metrics/saliency-source/

git submodule init

git submodule update

cd ..

ln -s saliency-source/saliency saliency

cd ../../

cd models/SSD-Tensorflow/

git submodule init

git submodule update

# prepare weights

cd checkpoints/

unzip ssd_300_vgg.ckpt.zip

cd ../

# install custom changes to module SSD-Tensorflow that allows using saliency

git apply ../ssd_tensorflow_diff.diff

cd ../../

為了對神經網絡進行正式驗證,有兩個通常的問題。

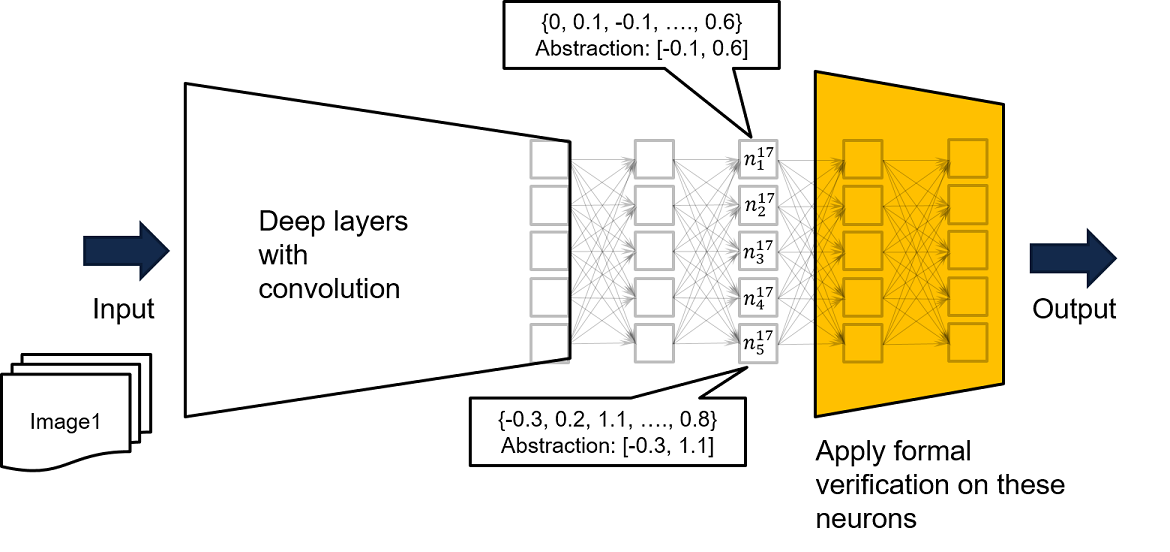

在NN依賴性套件中,我們建議用戶繼續進行以下步驟。

由於完整網絡的輸入只能導致黃色網絡輸入的某些值,如果無法在黃色網絡上證明安全屬性,我們的進一步建議是用培訓數據為完整的網絡提供供應完整的網絡,以便基於訪問量的輸入來得出更嚴格的過度透視。可以在Neuron n^17_ {1}中找到一個示例,其中通過所有可用的培訓數據運行網絡,我們知道訓練數據使得n^17_ {1}的輸出由[-0.1,0.6]綁定。因此,我們可以將記錄的綁定用作黃色網絡的輸入約束來執行正式驗證。

驗證的正確性是基於一個假設,即無法將神經元值放在創建的間隔之外,這是假定保證的證明。可以在運行時輕鬆監視該假設。