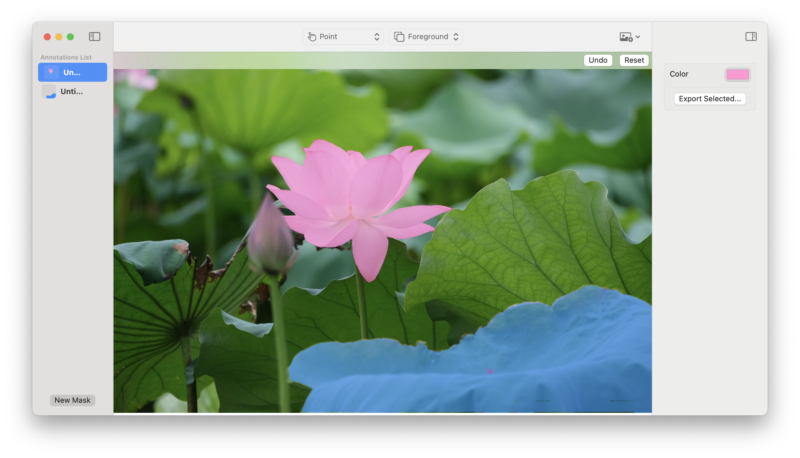

这是 SAM 2 Core ML 模型的 Swift 演示应用程序。

SAM 2(对图像和视频中的任何内容进行分割)是 FAIR 的基础模型集合,旨在解决图像和视频中的快速视觉分割问题。有关详细信息,请参阅 SAM 2 论文。

在这里下载编译版本!

如果您更喜欢自己编译或想要使用更大的模型,只需下载存储库,使用 Xcode 编译并运行即可。该应用程序附带该模型的小型版本,但您可以将其替换为支持的模型之一:

SAM 2.1 微型

SAM 2.1 小号

SAM 2.1 基础

SAM 2.1 大号

对于较旧的型号,请查看 HuggingFace 上的 Apple 组织。

该演示支持图像,视频支持稍后推出。

您可以选择一个或多个前景点来选择图像中的对象。每个附加点都被解释为前一个掩模的改进。

使用背景点指示要从当前蒙版中删除的区域。

您可以使用一个框来选择包含您感兴趣的对象的大致区域。

如果您想使用微调模型,可以使用 SAM 2 存储库的此分支对其进行转换。请让我们知道您用它做什么!

欢迎提供反馈、问题和 PR!请随时与我们联系。

要引用 SAM 2 论文、模型或软件,请使用以下内容:

@article{ravi2024sam2,

title={SAM 2: Segment Anything in Images and Videos},

author={Ravi, Nikhila and Gabeur, Valentin and Hu, Yuan-Ting and Hu, Ronghang and Ryali, Chaitanya and Ma, Tengyu and Khedr, Haitham and R{"a}dle, Roman and Rolland, Chloe and Gustafson, Laura and Mintun, Eric and Pan, Junting and Alwala, Kalyan Vasudev and Carion, Nicolas and Wu, Chao-Yuan and Girshick, Ross and Doll{'a}r, Piotr and Feichtenhofer, Christoph},

journal={arXiv preprint arXiv:2408.00714},

url={https://arxiv.org/abs/2408.00714},

year={2024}

}