Dies ist eine Swift-Demo-App für SAM 2 Core ML-Modelle.

SAM 2 (Segment Anything in Images and Videos) ist eine Sammlung von Basismodellen von FAIR, die darauf abzielen, eine schnelle visuelle Segmentierung in Bildern und Videos zu lösen. Weitere Informationen finden Sie im SAM 2-Papier.

Laden Sie die kompilierte Version hier herunter!.

Wenn Sie es lieber selbst kompilieren oder ein größeres Modell verwenden möchten, laden Sie einfach das Repo herunter, kompilieren Sie es mit Xcode und führen Sie es aus. Die App wird mit der Small-Version des Modells geliefert, Sie können sie jedoch durch eines der unterstützten Modelle ersetzen:

SAM 2.1 Winzig

SAM 2.1 Klein

SAM 2.1 Basis

SAM 2.1 Groß

Für die älteren Modelle schauen Sie sich bitte die Apple-Organisation auf HuggingFace an.

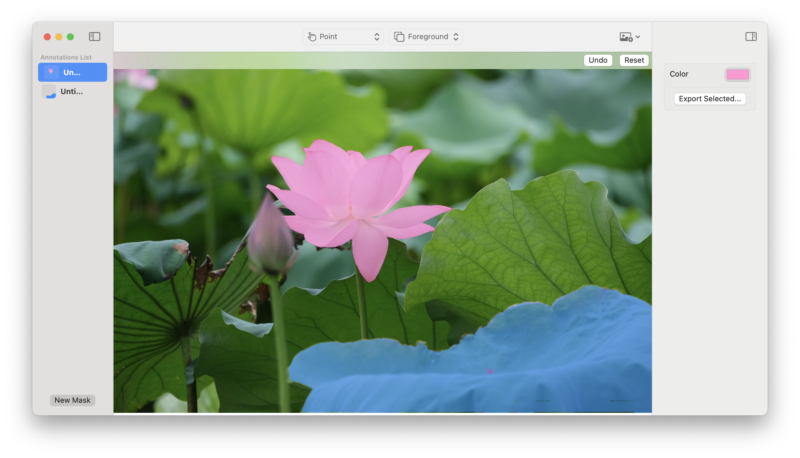

Diese Demo unterstützt Bilder, Videounterstützung folgt später.

Sie können einen oder mehrere Vordergrundpunkte auswählen, um Objekte im Bild auszuwählen. Jeder zusätzliche Punkt wird als Verfeinerung der vorherigen Maske interpretiert.

Verwenden Sie einen Hintergrundpunkt , um einen Bereich anzugeben, der aus der aktuellen Maske entfernt werden soll.

Mithilfe eines Felds können Sie einen ungefähren Bereich auswählen, der das Objekt enthält, an dem Sie interessiert sind.

Wenn Sie ein fein abgestimmtes Modell verwenden möchten, können Sie es mit diesem Fork des SAM 2-Repos konvertieren. Bitte teilen Sie uns mit, wofür Sie es verwenden!

Feedback, Probleme und PRs sind willkommen! Nehmen Sie gerne Kontakt mit uns auf.

Um das Papier, Modell oder die Software zu SAM 2 zu zitieren, verwenden Sie bitte Folgendes:

@article{ravi2024sam2,

title={SAM 2: Segment Anything in Images and Videos},

author={Ravi, Nikhila and Gabeur, Valentin and Hu, Yuan-Ting and Hu, Ronghang and Ryali, Chaitanya and Ma, Tengyu and Khedr, Haitham and R{"a}dle, Roman and Rolland, Chloe and Gustafson, Laura and Mintun, Eric and Pan, Junting and Alwala, Kalyan Vasudev and Carion, Nicolas and Wu, Chao-Yuan and Girshick, Ross and Doll{'a}r, Piotr and Feichtenhofer, Christoph},

journal={arXiv preprint arXiv:2408.00714},

url={https://arxiv.org/abs/2408.00714},

year={2024}

}