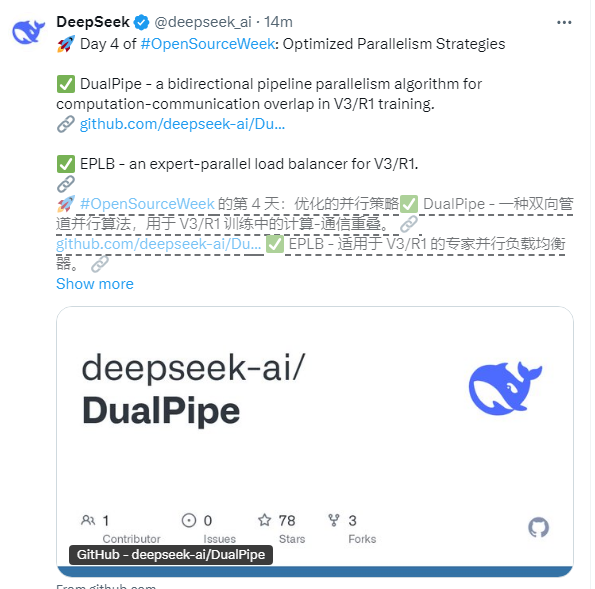

Сегодня, DeepSeek, ведущая компания в области искусственного интеллекта в Китае, официально объявила о четвертом дне своего плана с открытым исходным кодом - оптимизированных стратегий параллелизма. Основные технологии, выпущенные на этот раз, включают двухсторонний параллельный алгоритм трубопровода DualPipe, экспертный балансировщик параллельной нагрузки и глубокую оптимизацию механизма перекрытия вычислительной коммуникации. Эти технологические обновления непосредственно нацелены на ключевые проблемы в крупномасштабной обучении модели языка, предоставляя новое решение для эффективной работы кластеров на уровне супер Ванки.

DualPipe является одной из ядра этого технологического обновления, разработанного специально для архитектуры V3/R1. Благодаря инновационному двустороннему потоку данных, DualPipe достигает высокого перекрытия между вычислениями и связи. По сравнению с традиционными односторонними трубопроводами эта технология значительно улучшает пропускную способность вычислительной пропускной способности, особенно подходящую для модельного обучения с масштабами от 100 до 100 миллиардов параметров. Согласно базе кода GitHub, DualPipe выполняет формирующие вычисления синхронно синхронно вычисления на стадии обратной эксплуатации посредством интеллектуального механизма планирования, который увеличивает использование оборудования примерно на 30%.

Технология EPLB направлена на проблему «горячих экспертов» в модельном обучении гибридного эксперта (MOE) и впервые реализует параллельно динамическую балансировку нагрузки экспертов. Традиционные методы часто приводят к перегрузке некоторых расчетных карт из -за неравномерного распределения экспертных задач. Благодаря мониторингу в реальном времени и адаптивном распределении, EPLB увеличивает общий уровень использования кластера уровня WANKA до более чем 92%, эффективно избегая простых ресурсов.

Кроме того, DeepSeek также создал пространственно-временную модель эффективности трехмерного параллелизма (параллелизм данных/трубопровод/тензор) впервые на основе инструмента анализа перекрытия коммуникации архитектуры V3/R1. Благодаря аналитическим наборам данных с открытым исходным кодом разработчики могут точно определить конфликтующие узлы между вычислениями и связи, обеспечивая ориентир для настройки для обучения модели гиперспекты. Согласно тестам, эта оптимизация сокращает сквозное время обучения примерно на 15%.

Этот технологический выпуск привлек у себя активное внимание в отрасли. Эксперты отметили, что комбинированная инновация DualPipe и EPLB напрямую реагирует на две основные проблемы текущего крупномасштабного обучения: во-первых, с экспоненциальным ростом масштаба моделей, узкое место масштабируемости традиционных параллельных стратегий становится все более заметным; Во -вторых, популярность гибридных экспертных моделей сделала динамическую балансировку нагрузки основной потребности. Технический директор производителя облачных вычислений прокомментировал: «Эти инструменты значительно сократят порог аппаратного обеспечения для модельной подготовки сотен миллиардов долларов и, как ожидается, снизит стоимость обучения на 20-30%.

Технический директор Deepseek подчеркнул в техническом документе, что стратегия с открытым исходным кодом была проверена при внутренней подготовке нескольких 100 миллиардов моделей параметров и будет продолжать итерацию и оптимизировалась в будущем. В настоящее время эти три технологии являются открытым исходным кодом на GitHub, поддерживая разработчиков для настройки и применения их в различных аппаратных средах.

По мере того, как глобальная конкурс искусственного интеллекта выходит на стадию «масштабирования победы», DeepSeek открыл источник ключевых технологий в течение четырех дней подряд, не только демонстрирует техническую силу китайских компаний по искусственному ИИ, но также предоставляет отрасли инфраструктуру многократного использования. Эта технологическая инновация, обусловленная «открытым сотрудничеством», может изменить промышленную экосистему крупной модели.